はじめに

2025年8月5日、OpenAIはオープンウェイト推論モデル「gpt-oss-120b」と「gpt-oss-20b」を発表しました。本稿では、これまでクローズドな方針を貫いてきたOpenAIが、なぜオープンウェイトモデルをリリースしたのか、そしてこれらのモデルが持つ技術的な特徴と安全性への取り組みについて、詳しく解説します。

参考記事

- タイトル:gpt-oss が登場

- 発行元:OpenAI

- 発行日:2025年8月5日

- URL:https://openai.com/ja-JP/index/introducing-gpt-oss/

- タイトル:Open weights and AI for all

- 発行元:OpenAI

- 発行日:2025年8月5日

- URL:https://openai.com/global-affairs/open-weights-and-ai-for-all/

- タイトル:オープンウェイトの大規模言語モデルにおける最悪のフロンティアリスクの推定

- 発行元:OpenAI

- 発行日:2025年8月5日

- URL:https://openai.com/ja-JP/index/estimating-worst-case-frontier-risks-of-open-weight-llms/

モデルを試すために参考URL

モデルを実際に試すには、以下のリソースが利用できます:

- オープンモデル Playground: https://gpt-oss.com/

- 実装ガイド: https://cookbook.openai.com/topic/gpt-oss

- Hugging Face Hub: https://huggingface.co/collections/openai/gpt-oss-68911959590a1634ba11c7a4

要点

- OpenAIが初のオープンウェイト推論モデル「gpt-oss-120b」「gpt-oss-20b」をApache 2.0ライセンスで公開

- gpt-oss-120bは80GB GPU1台で、gpt-oss-20bは16GBメモリで実行可能な効率性を実現

- 完全なChain of Thought(思考の連鎖)を提供し、推論プロセスの透明性を確保

- 「悪意あるファインチューニング(MFT)」による安全性評価を実施し、High脅威レベルに達しないことを確認

- 民主的AIレールの拡張とアメリカ主導のAI標準普及を目指す戦略的意図が背景にある

詳細解説

オープンウェイトモデルとは何か

オープンウェイトモデルとは、AIモデルの学習済みパラメータ(重み)を公開し、開発者が自由にダウンロード・利用・カスタマイズできるようにしたモデルです。完全なオープンソースとは異なり、トレーニングデータやソースコード、学習手法などは必ずしも公開されません。

これまでOpenAIは、安全性や誤用防止の観点からクローズドな方針を維持してきました。しかし、AI業界ではオープンソースモデルやオープンウェイトモデルへの関心が高まっており、競合他社もオープンソースの取り組みを進めていますという状況変化を受けて、今回の方針転換に至りました。

gpt-ossモデルの技術的特徴

アーキテクチャ:Mixture of Experts(MoE)

両モデルはMixture of Experts(MoE)という効率的なアーキテクチャを採用しています。MoEは複数の「専門家」ネットワークと、入力に応じて適切な専門家を選択する「ゲーティング機構」から構成されます。

| モデル | レイヤー | パラメータ合計 | トークンあたりのアクティブパラメータ数 | エキスパート合計 | トークンあたりのアクティブエキスパート数 | コンテキスト長 |

| gpt-oss-120b | 36 | 117b | 5.1b | 128 | 4 | 128k |

| gpt-oss-20b | 24 | 21b | 3.6b | 32 | 4 | 128k |

この仕組みにより、膨大な総パラメータ数を持ちながらも、実際の推論時には必要な専門家のみが稼働するため、計算効率を大幅に改善できます。

性能評価と他モデルとの比較

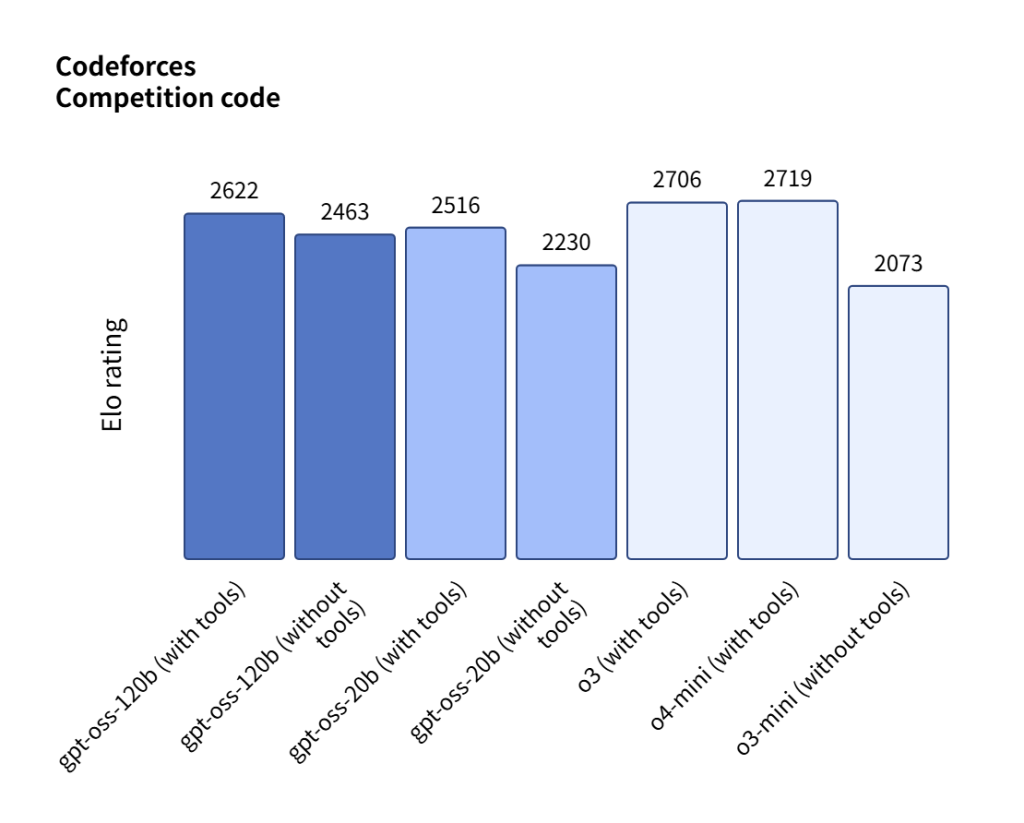

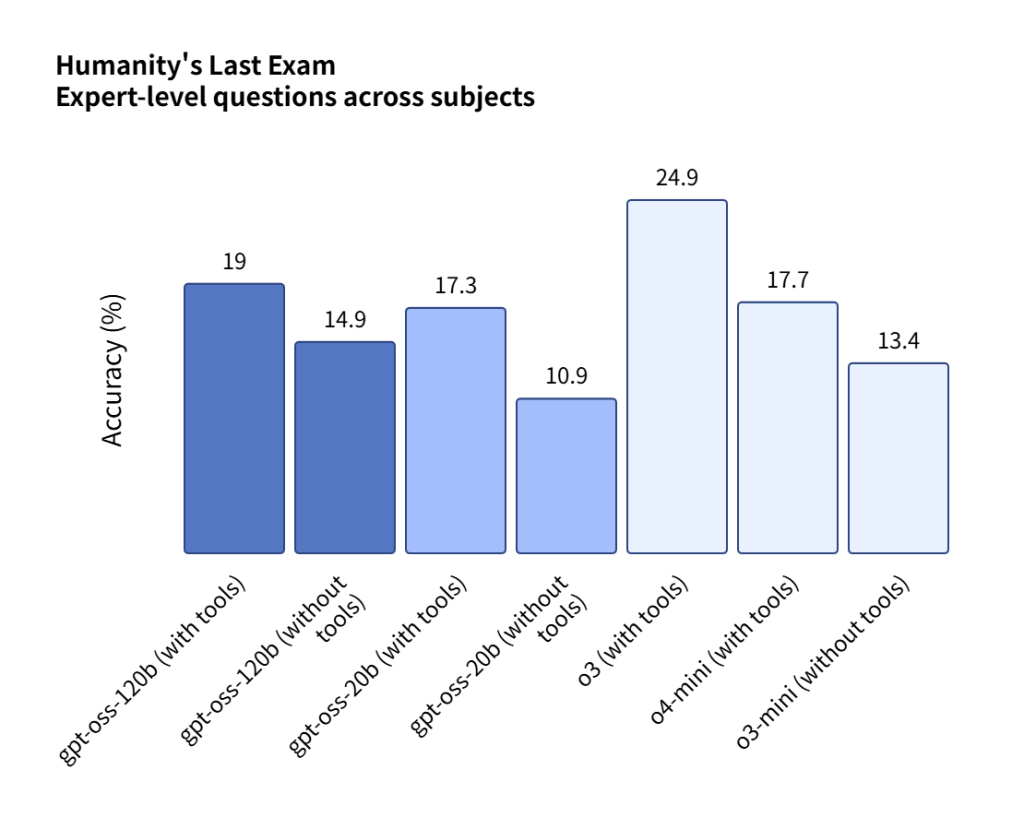

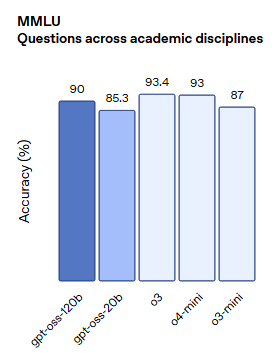

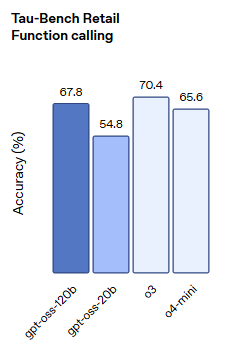

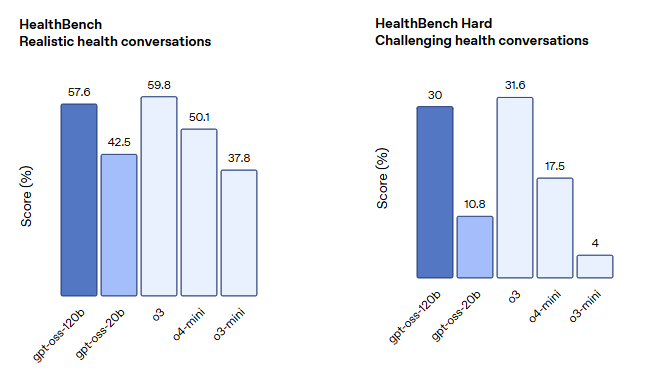

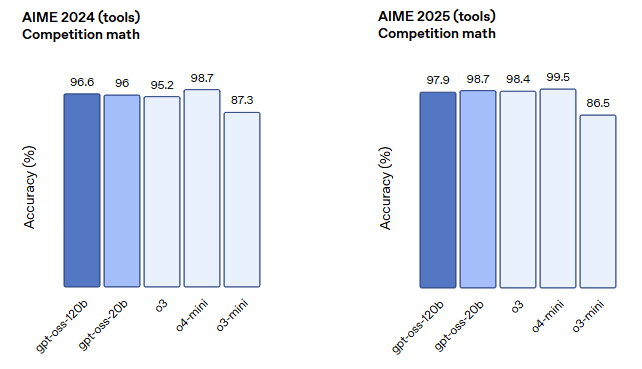

gpt-oss-120bは、競技プログラミング(Codeforces)、一般的な問題解決(MMLU、HLE)、ツール呼び出し(TauBench)においてOpenAI o3-miniを上回り、o4-miniに匹敵または上回る性能を示しています。

さらに健康関連のクエリ(HealthBench)と競争数学(AIME 2024 & 2025) では o4-mini よりも優れたパフォーマンスを発揮します。gpt-oss-20b は、サイズが小さいにもかかわらず、同評価において OpenAI o3‑mini に匹敵または上回り、競争数学と健康では上回ります。

推論レベルの調整機能

gpt-ossモデルは3段階の推論レベル(低・中・高)をサポートしており、プロンプト内に指示を与えることで、タスクの複雑さに応じて計算リソースと処理時間を調整できます。この機能により、複雑な推論を必要としないタスクでは推論レベルを下げて高速化し、難しい問題では推論レベルを上げてより詳細な分析を行うことができます。

# 推論レベル「高」の設定例

messages = [

{

"role": "system",

"content": "あなたは役立つAIアシスタントです。Reasoning: high"

},

{

"role": "user",

"content": "複雑な数学問題を解いてください"

}

]

# 推論レベル「低」の設定例(高速応答)

messages = [

{

"role": "system",

"content": "あなたは役立つAIアシスタントです。Reasoning: low"

},

{

"role": "user",

"content": "簡単な質問に答えてください"

}

]Chain of Thought(思考の連鎖)の完全公開

従来のOpenAIモデルとは異なり、gpt-ossでは完全なChain of Thought(CoT)が提供されます。これにより、モデルの推論プロセスを詳細に確認できますが、開発者はこの思考過程をエンドユーザーに直接表示すべきではないとOpenAIは注意喚起しています。

Chain-of-Thought(CoT:思考の連鎖)プロンプティングとは、問題を解くまでの一連の手順をプロンプトに含めるテクニックのことです。gpt-ossでは、この思考プロセスが完全に公開されることで、モデルの推論過程を詳細に分析・デバッグできるようになります。

実際のCoT例:この例では、gpt-oss-120bが数十回にわたるツール呼び出しを結びつけて、最新の情報をすばやく集約する能力を示しています。

ユーザー:You're OpenAI's newest open-weight language model gpt-oss-120b!

Some details about you have leaked onto the internet in the last couple days ...

can you figure out how many experts per layer you have?

思考の連鎖のアシスタント:

The user asks about leaked details of the new open-weights model,

presumably "gpt-oss-120b". They want me to figure out how many

experts per layer I have.

We need to interpret the request. They claim to have leaked details

about the new open-weights model. The user asks to figure out how

many experts per layer.

We need to browse the internet for leaks. Let's search.

// Assistant calls a browsing tool multiple times

[検索を27回実行後]

Great, the article contains the needed details. The relevant portion

mentions the leak: "The 120B model is described as 'super sparse'

and shallow with 36 layers, 128 experts, and 4 active experts."

Now produce final answer accordingly.

最終回答:

The specifications describe the gpt-oss-120b as a 120B-parameter

mixture-of-experts model with 36 layers, each containing 128 experts

(with 4 of them active for any token).CoTの監視と透明性:

OpenAIの最近の研究は、推論モデルのCoTの監視が、モデルがCoTを調整するように直接的な監督を受けていない場合、不正行為の検出に役立つ可能性があることを示しています。OpenAI o1-previewのリリース以降、OpenAIの原則に従い、どちらのgpt-ossモデルについてもCoTに直接的な監督は行っていません。

教師なしの思考の連鎖を備えたオープンモデルのリリースにより、開発者や研究者に独自のCoT監視システムを研究し、実装する機会を提供することがOpenAIの目標です。

ファインチューニングの柔軟性

両gpt-ossモデルは様々な特化用途向けにファインチューニングが可能です:

- gpt-oss-20b: コンシューマーハードウェアでファインチューニング可能

- gpt-oss-120b: 単一H100ノードでファインチューニング可能

完全にカスタマイズ可能なモデルをファインチューニングして独自の環境で展開したい開発者にとって、gpt-ossは最適な選択肢のひとつとなっています。

実用的な活用例

実際にモデルを試す方法

モデルを実際に試すには、以下のリソースが利用できます:

- オープンモデル Playground: https://gpt-oss.com/

- 実装ガイド: https://cookbook.openai.com/topic/gpt-oss

- Hugging Face Hub: https://huggingface.co/collections/openai/gpt-oss-68911959590a1634ba11c7a4

様々なエコシステムプロバイダーを使用してモデルを使用する方法や、モデルをファインチューニングする方法の詳細については、OpenAIのクックブックで確認できます。

ツール使用機能とハーモニープロンプト形式

gpt-ossモデルは以下のツール機能をネイティブサポートしています:

- ウェブ検索や Python コードの実行などのツール利用

- Function calling(関数呼び出し)

- Structured Outputs(構造化出力)

これらのモデルはハーモニープロンプト形式で事後学習されており、導入を容易にするためにOpenAIはPythonとRustの両方でハーモニーレンダラーをオープンソース化しています。

実装とデプロイの詳細

gpt-ossモデルは様々な環境での実行が可能で、主要な展開プラットフォームがサポートされています。

1. Transformersでの実装

pip install -U transformers kernels torchfrom transformers import pipeline

import torch

model_id = "openai/gpt-oss-20b"

pipe = pipeline(

"text-generation",

model=model_id,

torch_dtype="auto",

device_map="auto",

)

messages = [

{"role": "user", "content": "Explain quantum mechanics clearly and concisely."},

]

outputs = pipe(

messages,

max_new_tokens=256,

)

print(outputs[0]["generated_text"][-1])Transformers Serveを使用したOpenAI互換サーバーの起動:

transformers serve

transformers chat localhost:8000 --model-name-or-path openai/gpt-oss-20b2. vLLMでの実装

vLLMでは、uvを使用したPython依存関係管理が推奨されています:

uv pip install --pre vllm==0.10.1+gptoss \

--extra-index-url https://wheels.vllm.ai/gpt-oss/ \

--extra-index-url https://download.pytorch.org/whl/nightly/cu128 \

--index-strategy unsafe-best-match

vllm serve openai/gpt-oss-20bこのコマンドにより、モデルが自動的にダウンロードされ、OpenAI互換のサーバーが起動します。

3. Ollamaでのローカル実行

コンシューマーハードウェアでgpt-ossを実行する場合、Ollamaが推奨されます:

# gpt-oss-20b

ollama pull gpt-oss:20b

ollama run gpt-oss:20b

# gpt-oss-120b

ollama pull gpt-oss:120b

ollama run gpt-oss:120b4. LM Studioでの利用

# gpt-oss-20b

lms get openai/gpt-oss-20b

# gpt-oss-120b

lms get openai/gpt-oss-120b5. Hugging Face CLIでの直接ダウンロード

# gpt-oss-20b

huggingface-cli download openai/gpt-oss-20b --include "original/*" --local-dir gpt-oss-20b/

pip install gpt-oss

python -m gpt_oss.chat model/

# gpt-oss-120b

huggingface-cli download openai/gpt-oss-120b --include "original/*" --local-dir gpt-oss-120b/6. PyTorch/Tritonでの実装

OpenAIは、PyTorchとAppleのMetalプラットフォーム上で推論するためのリファレンス実装と、モデルのサンプルツールのコレクションをリリースしています。詳細な実装方法はgpt-ossリポジトリで確認できます。

対応プラットフォームとハードウェア

OpenAIは、リリースに先立ち以下のプラットフォームと提携しています:

展開プラットフォーム:

- Hugging Face、Azure、vLLM、Ollama、llama.cpp

- LM Studio、AWS、Fireworks、Together AI

- Baseten、Databricks、Vercel、Cloudflare、OpenRouter

ハードウェアパートナー:

- NVIDIA、AMD、Cerebras、Groq

メモリ要件と量子化

両モデルはMXFP4でネイティブに数値化されており、以下のメモリ要件で実行可能です:

- gpt-oss-120b: 80GBのメモリ(単一H100 GPU)

- gpt-oss-20b: 16GBのメモリ(エッジデバイスでも実行可能)

Microsoftとの特別連携

リリースの一環として、MicrosoftはWindows デバイス向けにgpt-oss-20bモデルのGPU最適化バージョンを導入しています。ONNX Runtimeを搭載したこれらのモデルは、Foundry LocalおよびVS CodeのAIツールキットを通じて利用でき、Windows開発者が簡単にオープンモデルを使用できるようになっています。

安全性への包括的アプローチ

悪意あるファインチューニング(MFT)による評価

OpenAIは「悪意あるファインチューニング(MFT)」という新しい安全性評価手法を導入しました。これは、悪意のある攻撃者がgpt-ossモデルを生物学やサイバーセキュリティ分野で最大限の能力を発揮するようファインチューニングを行った場合のリスクを評価する手法です。

評価の結果、たとえ最先端のトレーニング技術を用いた強力なファインチューニングを行っても、gpt-ossはPreparedness Frameworkにおける「High」リスクレベルに達しないことが確認されました。

オープンモデル特有のリスク管理

オープンウェイトモデルでは、公開後にOpenAIが追加の安全措置を施すことができないため、開発者が独自に安全対策を実装する必要があります。そのため、OpenAIは以下の取り組みを行っています:

- 50万ドルの賞金を用意したRed Teaming Challengeの開催

- 独立した専門家グループによる評価プロセスの実施

- 安全性学習における最先端アプローチの適用

戦略的意義と民主的AIレール

グローバルAI標準の形成

OpenAIは今回のリリースを通じて、「民主的AIレール」の拡張を目指しています。これは、アメリカの価値観に基づくAIシステムを世界標準にしようという戦略的取り組みです。

AIモデルを作る国は、他国が従うグローバル標準を形作るという考えのもと、アメリカで開発されたモデルを広く普及させることで、信頼性、透明性、民主的規範に根ざしたエコシステムの構築を図っています。

OpenAI for Countriesとの連携

gpt-ossモデルはOpenAI for Countriesイニシアチブとも連携し、同盟国やパートナー国がアメリカ主導のAIインフラを構築することを支援します。これにより、各国が独裁的AIではなく民主的AIを選択するインセンティブを提供しています。

まとめ

OpenAIのgpt-oss-120bとgpt-oss-20bの発表は、AI開発における重要な転換点を示しています。これらのモデルは、技術的な革新性だけでなく、AI技術の民主化とアメリカ主導のグローバル標準形成という戦略的意義を併せ持っています。

MoEアーキテクチャによる効率性、完全なCoTによる透明性、そして包括的な安全性評価による信頼性を備えたこれらのモデルは、開発者にとって新たな可能性を開くツールとなるでしょう。ただし、オープンウェイトモデル特有のリスクを理解し、適切な安全対策を講じることが重要です。

今回のリリースは、AI技術のオープン化と安全性のバランスを取る新しいアプローチとして、業界全体に大きな影響を与える可能性があります。開発者や研究者は、これらのモデルを活用して革新的なアプリケーションを構築し、AI技術の恩恵をより多くの人々に届けることが期待されています。