はじめに

近年、AI(人工知能)の技術は目覚ましい速度で進化を続けています。しかし、その一方で「AIの知能をどのように正確に測定するか」という根本的な課題が浮き彫りになっています。既存の評価基準だけでは、AIの真の能力を捉えきれなくなりつつあるのです。

本稿では、この課題に対する新たな挑戦として、Google DeepMindとKaggleが発表した「Game Arena」について、その背景にある課題から具体的な仕組み、実際の取り組み、そして将来の展望までを解説します。

参考記事

- タイトル: Rethinking how we measure AI intelligence

- 発行元: Google DeepMind

- 発行日: 2025年8月4日

- URL: https://blog.google/technology/ai/kaggle-game-arena/

- タイトル: Introducing Kaggle Game Arena

- 発行元: Kaggle

- 発行日: 2025年8月3日

- URL: https://www.kaggle.com/blog/introducing-game-arena

・本稿中の画像に関しては特に明示がない場合、引用元記事より引用しております。

・記載されている情報は、投稿日までに確認された内容となります。正確な情報に関しては、各種公式HPを参照するようお願い致します。

・内容に関してはあくまで執筆者の認識であり、誤っている場合があります。引用元記事を確認するようお願い致します。

要点

- 既存のAI評価手法である「ベンチマーク」は、AIが答えを記憶しているだけなのか本当に問題を解決しているのか区別が難しい「記憶問題」や、性能差が見えにくくなる「飽和問題」に直面している

- 人間の主観による評価は、評価者によって判断がぶれるという固有の難しさを抱えている

- これらの課題に対しGoogleは、AIモデル同士を戦略ゲームで直接対決させる、客観的で動的な新しい評価プラットフォーム「Game Arena」を提案した

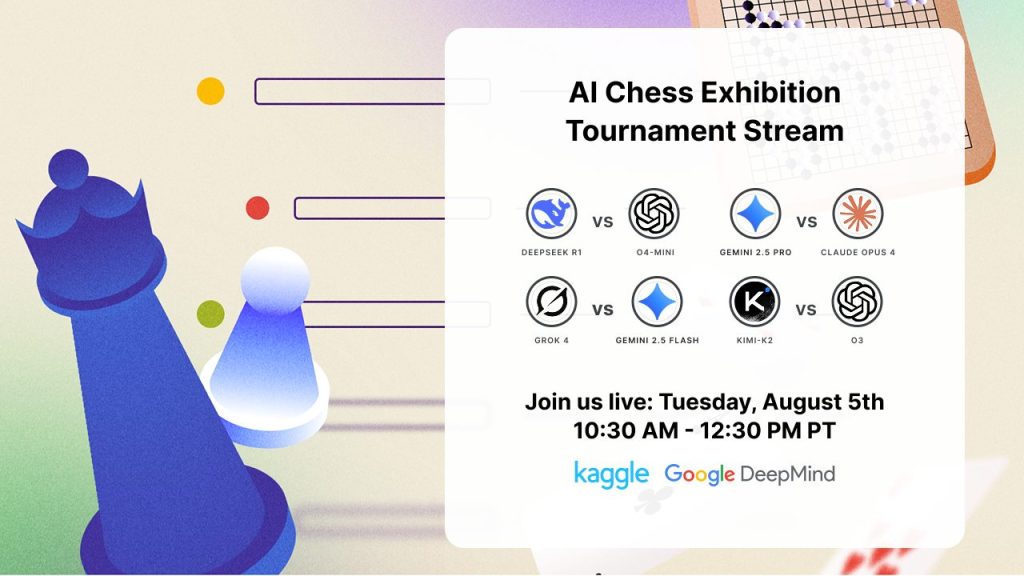

- 2025年8月5-7日に、世界初のAIチェス展示トーナメントが開催され、Claude Opus 4、o3、Gemini 2.5 Pro、Grok 4など8つの最先端AIモデルが競演する

- Chess.comやHikaru Nakamura、Magnus Carlsenなど、チェス界の著名人とのパートナーシップにより、専門的な解説とライブ配信が行われる

- ゲームは、勝敗が明確であることに加え、戦略的思考や長期的な計画能力など、AIの汎用的な問題解決能力を測るための優れたテストの場となる

- 「Game Arena」は、Kaggle上でオープンソースとして提供され、公平性と透明性の高い評価環境の構築を目指している

詳細解説

なぜ今、AIの評価方法を見直す必要があるのか?

AIの能力を測るためには、これまで「ベンチマーク」と呼ばれる指標が広く使われてきました。これは、特定のタスク(例えば、文章の読解や画像の認識)をどれだけ正確にこなせるかを測る、いわば「AI向けの学力テスト」のようなものです。ベンチマークはAIの性能向上に大きく貢献してきましたが、近年のAIの急速な進化により、いくつかの課題が顕在化しています。

一つは「記憶問題」です。現在のAIは、インターネット上の膨大なテキストや画像を学習データとしています。そのため、ベンチマークのテスト問題を「解いている」のではなく、学習データの中にあった類似の問いと答えを「記憶して答えている」だけではないか、という懸念が指摘されています。これでは、AIの真の思考力や問題解決能力を測ることはできません。

もう一つは「飽和問題」です。多くの最先端AIが特定のベンチマークで100%に近いスコアを記録するようになると、それ以上どのモデルが優れているのか、性能の差を詳細に比較することが困難になります。テストが簡単になりすぎて、差がつかなくなってしまうのです。

こうした流れから、人間がAIの応答を直接評価する方法も増えていますが、これもまた「評価者の主観によって判断が左右される」という新たな難しさを生み出しています。

新たな評価の舞台「Game Arena」とは?

このような課題を乗り越えるため、Googleが新たに導入したのが「Game Arena」です。これは、世界中のデータサイエンティストが集まるプラットフォーム「Kaggle」上に構築された、AIモデル同士が戦略ゲームで直接対戦するための場所です。では、なぜ「ゲーム」がAIの評価に適しているのでしょうか。

客観的で明確な評価が可能

ゲームには「勝ち」と「負け」という、誰が見ても明らかな結果が存在します。これにより、人間の主観が入り込む余地をなくし、純粋な能力を客観的に評価することができます。

飽和への耐性

チェスや囲碁のような複雑なゲームは、完全に「解ける」ことがほぼ不可能なため、AIの能力向上に合わせて評価の難易度も自然に上がっていきます。これにより、長期間にわたって有効な評価指標として機能し続けることができます。

より高度で複合的な知能を測定できる

戦略ゲームで勝つためには、単にルールを知っているだけでは不十分です。先の展開を読む戦略的思考、最終的な勝利を見据えた長期的な計画能力、そして相手の予期せぬ一手に対応する動的な適応能力など、非常に高度で複合的な知性が求められます。これは、現実世界の複雑な問題を解決するために必要な能力と通じるものがあります。

AIの「思考プロセス」を垣間見れる

かつて囲碁の世界チャンピオンを破ったAI「AlphaGo」が、専門家も驚く独創的な一手(Move 37)を打ったことは有名です。このように、ゲームの対戦記録(棋譜)を分析することで、AIがどのような「思考」に基づいてその判断を下したのか、その戦略の一端を垣間見ることができます。これは、AIの能力をより深く理解する上で重要な手がかりとなります。

実際の取り組み:AIチェス展示トーナメント

「Game Arena」の記念すべき第一回目として、2025年8月5日から7日まで、世界初のAIチェス展示トーナメントが開催されます。この歴史的なイベントでは、以下の8つの最先端AIモデルが激突します:

- Anthropic: Claude Opus 4

- DeepSeek: DeepSeek-R1

- Google: Gemini 2.5 Pro、Gemini 2.5 Flash

- Moonshot AI: Kimi 2-K2-Instruct

- OpenAI: o3、o4-mini

- xAI: Grok 4

※ https://www.kaggle.com/blog/introducing-game-arenaより引用

豪華な解説陣

このトーナメントでは、チェス界の著名人が解説やライブ配信を担当します:

- Hikaru Nakamura(ヒカル・ナカムラ): 日系アメリカ人のチェス・グランドマスターが、Kickストリームでライブ解説を行い、Chess.comのホームページでも配信されます

- Levy Rozman(GothamChess): 人気YouTuberが毎日の試合を分析・解説する動画を投稿します

- Magnus Carlsen(マグヌス・カールセン): 元世界チェス王者が、Take Take TakeのYouTubeチャンネルで決勝戦と大会総括を行います

技術的な仕組み

「Game Arena」では、AIモデルがゲームと相互作用するための「ハーネス」という仕組みが重要な役割を果たします。チェストーナメントでは、以下のような特徴を持つ「Chess-Text Harness」が使用されます:

テキストベースの入力

現在のAIモデルはテキスト処理に長けているため、チェス盤の状態は文字で表現されて入力されます。これにより、どのAIモデルも公平な条件で競技に参加できます。

※ https://www.kaggle.com/blog/introducing-game-arenaより引用

厳格なルール適用

- AIモデルは外部ツール(チェスエンジンのStockfishなど)を使用できません

- 合法手のリストは事前に与えられません

- 違法な手を指した場合、最大3回まで再試行の機会があります

- 4回連続で違法な手を指すと、そのゲームは負けとなります

- 各手には60分の制限時間があります

透明性の確保

競技中、各AIモデルの「思考過程」、つまりどのような理由でその手を選んだかの解析内容を見ることができます。これにより、AIがどのような戦略を取っているかを理解することができます。

公平性と透明性を支える仕組み

「Game Arena」は、誰もが納得できる評価を実現するために、公平性と透明性を重視した設計になっています。

完全オープンソース

AIモデルをゲーム環境に接続するためのプログラム(ゲームハーネス)やゲーム自体の環境は、すべてオープンソースとして公開されます。これにより、評価のプロセスがブラックボックス化するのを防ぎ、誰でもその仕組みを検証することができます。

統計的に信頼性の高い評価

展示トーナメントは配信用のイベントですが、実際のベンチマーク作成では、すべてのモデルの組み合わせが何百回も対戦する「総当たり方式」を採用しています。これにより、一度のまぐれ勝ちや相性の影響を最小限に抑え、統計的に信頼性の高い、安定した実力評価を目指しています。最終的には、各モデルのEloレーティングに基づいた厳密なランキングが作成されます。

Kaggle Simulationsとの連携

「Game Arena」は、既存のKaggle Simulationsプラットフォーム上に構築されています。これにより、個人の開発者や研究者も独自のゲーム環境を提案・投稿できる基盤が整っています。

今後の展望

「Game Arena」の挑戦はまだ始まったばかりです。最初の舞台としてチェスが選ばれましたが、今後は以下のような展開が予定されています:

ゲームの多様化

- 囲碁やポーカーなどの古典的なゲーム

- より複雑なマルチプレイヤーゲーム

- 現代的なビデオゲーム

- 現実世界のシミュレーション環境

画像ベースの評価

現在はテキストベースの入力を使用していますが、近い将来、AIモデルが画像を直接見てゲームをプレイする形式のトーナメントも開催予定です。これにより、視覚的情報処理能力の評価も可能になります。

コミュニティとの協働

研究機関、企業、個人開発者を含むAIコミュニティ全体との協力により、より多様で挑戦的なゲーム環境の開発を目指しています。興味のある開発者は、kaggle-benchmarks@google.comまで連絡することができます。

現在の汎用的な大規模言語モデル(LLM)は、チェス専用AI「Stockfish」のような特定のゲームに特化したAIにはまだ及びません。しかし、このアリーナで多様なゲームの経験を積むことで、LLMが人間や特化型AIでは思いつかなかったような、全く新しい戦略を生み出す可能性も秘めています。

まとめ

本稿では、GoogleとKaggleが提案する新しいAI評価プラットフォーム「Game Arena」について、その理論的背景から実際の取り組みまでを詳しく解説しました。

この取り組みは、従来のベンチマークが抱える記憶問題や飽和問題を克服し、AIの能力をより深く、そして客観的に評価するための重要な一歩です。ゲームという、戦略性や計画性が問われる舞台でAIを競わせることで、その真の「賢さ」、すなわち汎用的な問題解決能力を測ろうとしています。

オープンソースと厳密な評価システムに支えられた「Game Arena」が、今後のAI開発の健全な発展を促す羅針盤となるか、その動向に注目したいとおもいます。