はじめに

近年、多くの企業が生産性向上を期待して生成AIツールを導入しています。しかし、多額の投資にもかかわらず、現場での利用が思うように進まないという悩みを抱える企業は少なくありません。その原因は、単なるスキル不足やトレーニングの問題だけではないようです。

本稿では、世界的な経営学誌であるHarvard Business Reviewに掲載された記事「Research: The Hidden Penalty of Using AI at Work」を基に、AI利用を阻む見えざる壁である「能力ペナルティ(Competence Penalty)」という現象について、その実態と企業が取るべき対策を解説します。

参考記事

- タイトル: Research: The Hidden Penalty of Using AI at Work

- 著者: Oguz A. Acar, Phyliss Jia Gai, Yanping Tu and Jiayi Hou

- 発行元: Harvard Business Review

- 発行日: 2025年8月1日

- URL: https://hbr.org/2025/08/research-the-hidden-penalty-of-using-ai-at-work

要点

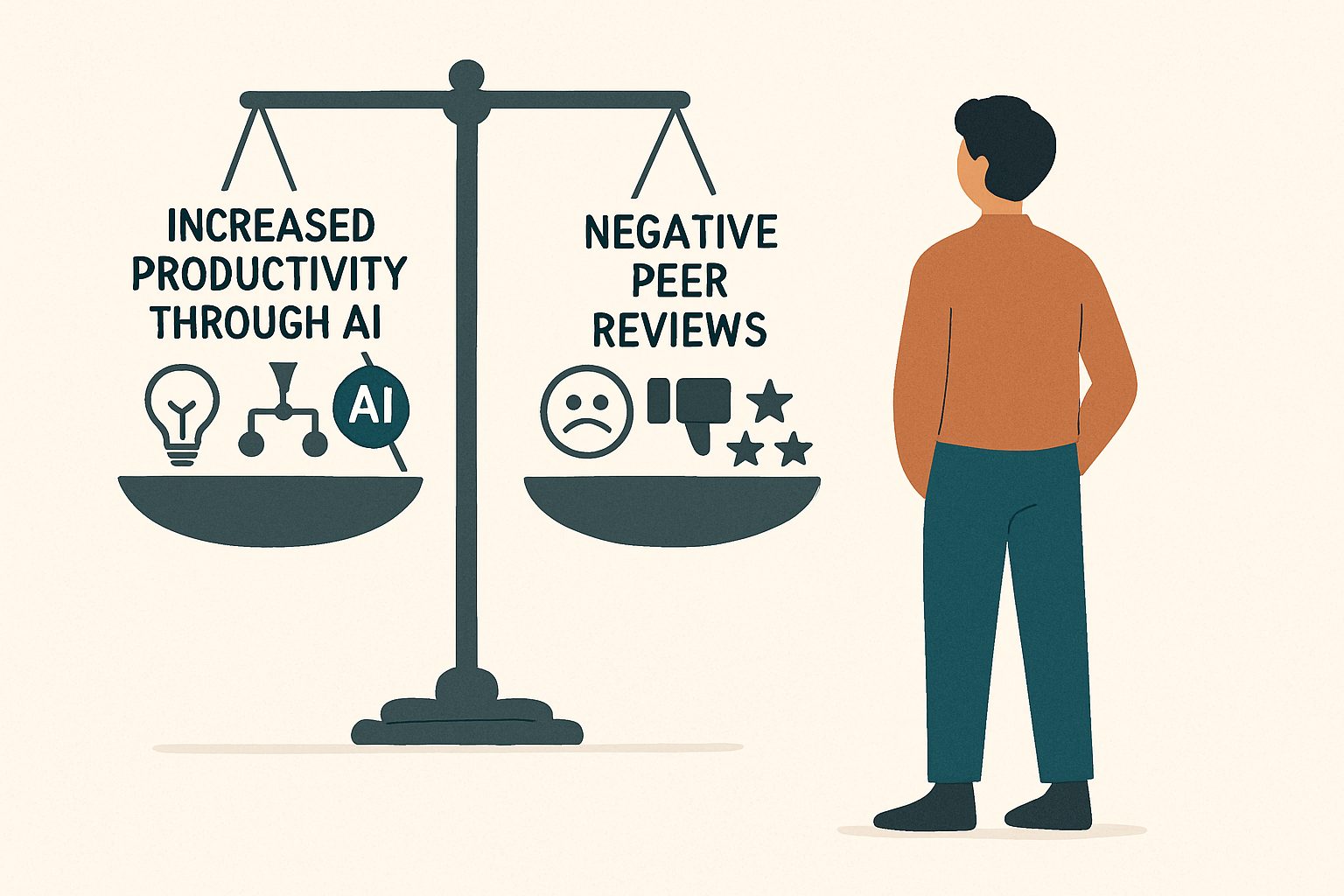

- AIを利用して作成した成果物は、たとえ品質が同じでも、作成者の能力が低く評価される「能力ペナルティ」というバイアスが存在する。

- このペナルティは、特に女性や年配の従業員といった、もともとステレオタイプの目にさらされやすい層に対してより強く働く傾向がある。

- 従業員は、このペナルティを恐れてAIの利用を避けるため、企業のAI投資対効果の低下、シャドーITのリスク、職場内の不平等拡大につながる。

- 対策として、ペナルティが起きやすい環境の特定、ロールモデルによる利用促進、成果そのものを評価する制度への転換が有効である。

詳細解説

AI導入のジレンマ:なぜ高価なツールは使われないのか?

本稿が基にする記事では、ある大手テクノロジー企業の事例が紹介されています。その企業は最先端のAIコーディングアシスタントを導入しましたが、1年経ってもエンジニアの利用率はわずか41%。さらに詳しく見ると、女性エンジニアでは31%、40歳以上のエンジニアでは39%と、特定の層で利用率が著しく低いことが明らかになりました。

これは決して珍しい話ではありません。多くの企業がAIツールへのアクセス環境を整え、トレーニングを実施しても、利用が低迷しています。この背景には、技術的な問題だけでなく、人間関係や評価に根差した社会的な力学が働いているのです。

「能力ペナルティ」という隠れた壁

研究チームは、なぜ従業員がAIの利用をためらうのかを解明するため、1,026人のエンジニアを対象とした実験を行いました。参加者には、あるPythonのコードを評価してもらいます。その際、コードは全く同じものであるにもかかわらず、一方のグループには「エンジニアがAIの支援を受けて書いたもの」、もう一方には「エンジニアが自力で書いたもの」と説明しました。

結果は衝撃的なものでした。

- 能力への不当な評価: AIの支援を受けたと説明された場合、コード自体の品質評価は変わらなかったにもかかわらず、作成したエンジニアの能力(Competence)に対する評価が平均で9%も低くなりました。人々は、AIを使うことを「本人の能力不足を補うもの」と無意識に捉えてしまうのです。

- ジェンダーバイアスの増幅: このペナルティは、女性エンジニアに対して特に厳しく、評価の低下幅は男性の6%に対し、女性は13%と2倍以上に達しました。同じようにAIを使っても、女性であるというだけで、より強く能力を疑問視されるという不公平な実態が明らかになりました。

- 誰がペナルティを科すのか: 最も厳しい評価を下したのは、自身はAIを利用していないエンジニアたちでした。特に、AIを使っていない男性評価者が、AIを使った女性エンジニアに対して最も厳しい評価を下す傾向が見られました。

従業員、特に女性やキャリアの長い従業員は、こうした「AIを使うと能力が低いと思われるのではないか」という評判リスクを敏感に察知しています。その結果、自身のキャリアを守るための自己防衛として、生産性向上に繋がるはずのAIツールの利用を避けてしまうのです。

能力ペナルティがもたらす3つの深刻なコスト

この見えざるペナルティは、企業に無視できない3つのコストをもたらします。

- 生産性の損失と投資対効果の悪化

多額の投資をして導入したAIツールが活用されなければ、期待された生産性の向上は実現しません。記事の試算によれば、この利用率の低さは、企業の年間利益の2.5%から最大14%に相当する損失に繋がる可能性があると指摘されています。 - シャドーITのリスク増大

従業員が公式に承認されたAIツールの利用を恐れる一方で、AIを全く使わなくなるわけではありません。代わりに、会社の管理外にある非承認のAIツール(シャドーIT)を個人的に利用する可能性があります。これは、データ漏洩やコンプライアンス違反といった深刻なセキュリティリスクを組織にもたらします。 - 職場における不平等の拡大

AIは、個人のスキル差を埋め、誰もが活躍できる公平な環境を作るツールだと期待されがちです。しかし、能力ペナルティの存在は、その逆の現象を引き起こします。元々「技術に弱い」といったステレオタイプで見られがちな女性や年配の従業員がAIを使うと、その偏見がむしろ強化されてしまうのです。これは心理学で「社会的アイデンティティの脅威」と呼ばれる現象で、AIが意図せずして既存の職場内の不平等を助長する結果に繋がります。

ペナルティを乗り越えるための3つの処方箋

では、企業はどうすればこの「能力ペナルティ」という壁を乗り越え、誰もが安心してAIを活用できる環境を築けるのでしょうか。記事では、以下の3つの具体的なアプローチを提案しています。

- 組織内の「ペナルティ・ホットスポット」を特定する

まずは、自社の中で特に能力ペナルティが発生しやすい部署やチームを特定することから始めます。例えば、女性や年配の従業員が少なく、AIを導入していない男性管理職が多いチームは、リスクが高い「ホットスポット」と言えます。昇進までの期間や評価結果をデータで分析し、AI利用の有無がキャリアに不利益を与えていないかを確認することが重要です。 - 影響力のある懐疑論者を味方につける

ペナルティを科すのは主にAI非利用者です。この状況を打破するには、職場で尊敬されている人物がAIを積極的に利用する姿を見せることが極めて効果的です。特に、ペナルティを受けやすいとされる層のシニア社員(例えば、シニアの女性エンジニア)がロールモデルとなることで、若手は安心してAIを試せるようになります。

Pinterest社が全社的に開催した「Makeathon(ハッカソン)」のように、役職や職種に関係なく誰もがAIを使ったアイデアを試せるイベントも、心理的安全性を高め、AI利用を促進する良い事例です。 - 評価制度を再設計する:「何を」達成したかを問う

最も根本的な解決策は、評価の仕組みそのものを変えることです。「AIを使ったかどうか」というプロセスではなく、「それによってどのような成果が生まれたか」という結果を客観的に評価するようにシフトします。- AI利用ラベルの廃止: 成果物の評価時に「AI使用」といったラベル付けを義務付けるのをやめ、評価者がバイアスを持つ機会を減らします。

- 客観的指標の導入: 主観的な能力評価ではなく、開発サイクルタイム、エラー率、正確性といった客観的な指標で成果を測ります。

- AI利用を「ボーナス」に変える: さらに進んで、MicrosoftやShopifyのように、AIの習熟度や活用をパフォーマンス評価の正式な項目に含め、AIを使いこなせる人材を積極的に評価することで、ペナルティをボーナスへと転換する動きも始まっています。

まとめ

本稿では、Harvard Business Reviewの記事を基に、職場でAIの利用を妨げる「能力ペナルティ」という社会的な壁について解説しました。AI導入の成否は、単に優れたツールを導入するだけでは決まりません。従業員が「AIを使うと無能だと思われるかもしれない」という不安を感じることなく、安心して新しい技術を試せる心理的安全性と、成果を公正に評価する文化を育むことが不可欠です。

AIトランスフォーメーションを真に成功させる企業とは、最高のツールを持つ企業ではなく、すべての従業員がその能力を最大限に発揮できる環境を築いた企業となるでしょう。技術的なインフラ整備と同時に、こうした「社会的インフラ」の構築に目を向けることが、これからのリーダーに求められています。