はじめに

Googleが2026年1月15日、Gemma 3をベースとした新しいオープン翻訳モデルコレクション「TranslateGemma」を発表しました。4B、12B、27Bの3つのパラメータサイズで提供され、55言語に対応しています。本稿では、この発表内容をもとに、TranslateGemmaの技術的特徴と性能、実用上の可能性について解説します。

参考記事

- タイトル: TranslateGemma: A new suite of open translation models

- 著者: David Vilar (Staff Research Scientist)、Kat Black (Product Manager)

- 発行元: Google Blog

- 発行日: 2026年1月15日

- URL: https://blog.google/innovation-and-ai/technology/developers-tools/translategemma/

要点

- TranslateGemmaは、Gemma 3をベースにした4B、12B、27Bの3サイズのオープン翻訳モデルである

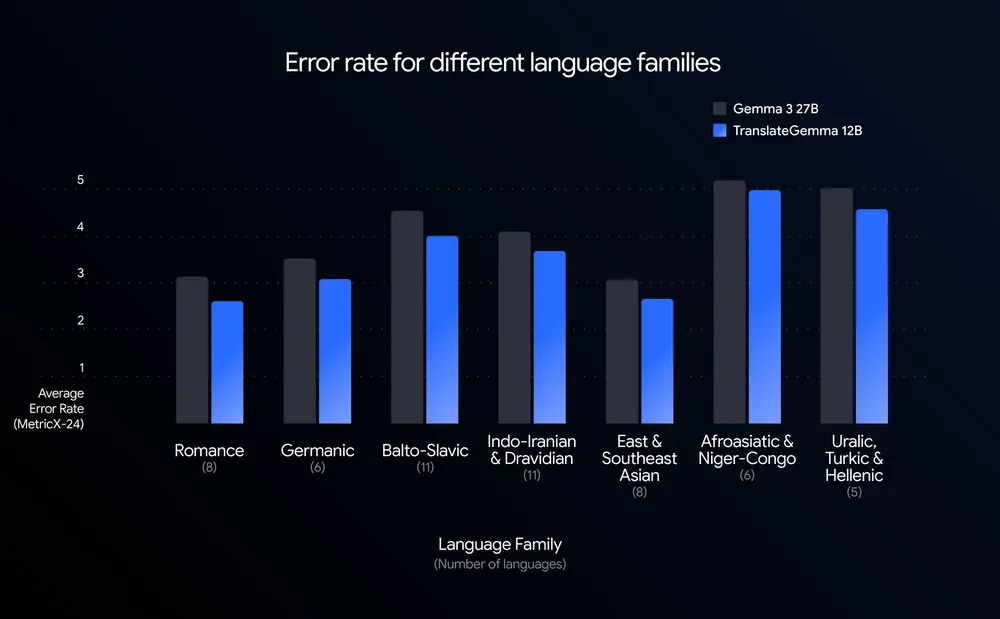

- 12BモデルがMetricXを用いたWMT24++ベンチマークで、Gemma 3 27Bベースラインを上回る性能を記録した

- Geminiモデルからの知識蒸留による2段階のファインチューニング(教師あり学習と強化学習)を実施している

- 55言語で厳密に訓練・評価され、約500の追加言語ペアでもトレーニングが行われている

- モバイルからクラウド環境まで、多様なデプロイメント環境に対応している

詳細解説

サイズを上回る効率性

Googleによれば、12BパラメータのTranslateGemmaモデルは、WMT24++ベンチマークにおいてMetricXで測定した結果、27BパラメータのGemma 3ベースラインを上回る性能を達成したとのことです。開発者は、ベースラインモデルの半分以下のパラメータ数で高精度な翻訳品質を実現できることになり、より高いスループットと低いレイテンシーを精度を犠牲にすることなく達成できます。

同様に、4Bモデルも12Bベースラインに匹敵する性能を示しており、モバイル推論向けの強力なモデルとして位置づけられています。

WMT24++は、機械翻訳システムの性能を評価する国際的なベンチマークの2024年版で、MetricXは翻訳品質を評価する自動評価指標の一つです。このベンチマークでは、55言語をカバーし、高リソース言語、中リソース言語、低リソース言語を含む多様な言語ファミリーを対象としています。TranslateGemmaは、すべての言語でベースラインのGemmaモデルと比較してエラー率を大幅に削減し、より高い効率性で品質向上を実現したとされています。

Geminiからの知識蒸留

この性能は、Geminiモデルの「直感」をオープンアーキテクチャに蒸留する専門的な2段階ファインチューニングプロセスによって実現されています。

第1段階の教師あり学習(SFT)では、人間による翻訳テキストと、最先端のGeminiモデルによって生成された高品質な合成翻訳を組み合わせた多様な並列データセットを用いて、ベースとなるGemma 3モデルをファインチューニングしました。これにより、低リソース言語においても広範な言語カバレッジと高い忠実性を達成しています。

第2段階では、強化学習(RL)を実施し、翻訳品質をさらに洗練させました。MetricX-QEやAutoMQMなどの高度な評価指標を含む報酬モデルのアンサンブルを使用し、より文脈的に正確で自然な響きの翻訳を生成するようモデルを導いています。

知識蒸留は、大規模な教師モデルの知識を小規模な生徒モデルに転移させる技術で、モデルサイズを削減しながら性能を維持する手法として広く用いられています。TranslateGemmaでは、Geminiの翻訳能力をより小規模で実用的なモデルに移行させることに成功したと考えられます。

前例のない言語カバレッジ

Googleは、スペイン語、フランス語、中国語、ヒンディー語などの主要言語に加え、多くの低リソース言語を含む55言語ペアでTranslateGemmaを厳密に訓練・評価したと発表しています。

さらに、約500の追加言語ペアでもトレーニングを実施し、TranslateGemmaを研究者が特定の言語ペアや低リソース言語の品質向上のために独自の最先端モデルをファインチューニングする堅固な基盤として設計しています。この拡張セットについては、まだ確定した評価指標はありませんが、コミュニティの探索とさらなる研究を促すため、完全なリストが技術レポートに含まれています。

低リソース言語とは、訓練データや言語資源が限られている言語のことで、一般的な機械翻訳モデルでは性能が低くなりがちです。TranslateGemmaが低リソース言語でも高品質な翻訳を実現している点は、言語的多様性の保持という観点から重要な進展と言えます。

マルチモーダル機能の保持

TranslateGemmaモデルは、Gemma 3の強力なマルチモーダル機能を保持しています。Vistra画像翻訳ベンチマークでのテストによると、テキスト翻訳の改善が画像内のテキストを翻訳する能力にもプラスの影響を与えており、TranslateGemmaのトレーニングプロセス中に特定のマルチモーダルファインチューニングを行わなくても、この効果が得られたとのことです。

マルチモーダル機能とは、テキストだけでなく画像などの複数の情報形態を処理できる能力を指します。画像内の文字を翻訳する機能は、標識やメニュー、文書などの実世界での翻訳ニーズに対応する上で実用的と考えられます。

多様な環境での実行

TranslateGemmaは、3つのサイズでオープン翻訳モデルの新たな基準を設定しており、各サイズは異なるデプロイメント環境向けに設計されています。

- 4Bモデル: モバイルおよびエッジデプロイメント向けに最適化

- 12Bモデル: 一般的なノートパソコンで円滑に動作するよう設計され、研究グレードのパワーをローカル開発環境にもたらす

- 27Bモデル: 最大限の忠実性を追求し、クラウド上の単一のH100 GPUまたはTPUで実行可能

エッジデプロイメントとは、クラウドサーバーではなくユーザーのデバイス上で直接モデルを実行する方式で、レイテンシーの削減やプライバシーの向上といったメリットがあります。4Bモデルがモバイル環境で動作することで、インターネット接続がない状況でも翻訳機能を利用できる可能性が広がります。

アクセス方法

TranslateGemmaは、以下の複数のプラットフォームで利用可能です。

- Kaggleでのダウンロード: https://www.kaggle.com/models/google/translategemma/

- Hugging Faceでのダウンロード: https://huggingface.co/collections/google/translategemma

- Gemma Cookbookでの探索(Colab上でサンプルコードを実行可能): https://colab.research.google.com/github/google-gemini/gemma-cookbook/blob/main/Research/[TranslateGemma]Example.ipynb

- Vertex AIでのデプロイ: Google Cloudの機械学習プラットフォームで直接利用可能

これらの多様なアクセス手段により、研究者や開発者は自身の環境や用途に応じてTranslateGemmaを試すことができます。

詳細な技術レポート

詳細な技術レポートに関しては、以下から確認できます。

・技術レポート: https://arxiv.org/pdf/2601.09012

まとめ

TranslateGemmaは、効率性と性能を両立させたオープン翻訳モデルとして、モバイルからクラウドまで幅広い環境での利用を可能にしています。Geminiからの知識蒸留による高度な訓練手法と、55言語以上をカバーする言語対応の広さが特徴です。研究者や開発者にとって、言語の壁を越えたコミュニケーション実現のための強力なツールになると考えられます。