はじめに

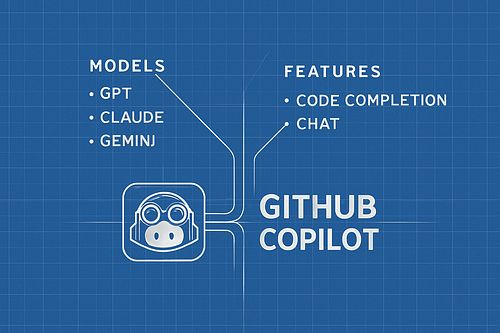

本稿では、多くの開発者が利用するAIコーディング支援ツール「GitHub Copilot」が、どのようなAIモデルによって動いているのか、その裏側を詳しく解説します。GitHub社が公式ブログで公開した記事「Under the hood: Exploring the AI models powering GitHub Copilot」を基に、初期のモデルから現在のマルチモデル構成に至るまでの進化、そして開発者が自身のタスクに最適なモデルを選択する方法について、分かりやすくお伝えします。

参考記事

- タイトル: Under the hood: Exploring the AI models powering GitHub Copilot

- 発行元: GitHub Blog

- 発行日: 2025年8月29日

- URL: https://github.blog/ai-and-ml/github-copilot/under-the-hood-exploring-the-ai-models-powering-github-copilot/

要点

- GitHub Copilotは、初期の単一モデル(Codex)から、複数のAIモデルを使い分けるマルチモデルアーキテクチャへと進化した。

- 現在のデフォルトモデルはOpenAIのGPT-4.1であり、従来比で約40%の応答速度向上とコンテキストウィンドウの大幅な拡張を実現している。

- 30以上のプログラミング言語をサポートし、開発者はコード補完、チャット、エージェントモードといった機能やタスクの目的に応じて、OpenAI、Anthropic、Googleが提供する複数の最新AIモデルから最適なものを選択できる。

- 単なるコード補完に留まらず、issueの整理やプルリクエストの生成といった複雑なタスクを自律的にこなすエージェント的ワークフローが強化されている。

- モデルの選択肢を提供することで、開発者は速度、精度、創造性といった自身の優先順位に合わせてツールを調整でき、開発者体験(DevEx)の向上が図られている。

詳細解説

Copilotの進化:単一モデルからマルチモデルへ

2021年にGitHub Copilotが初めて登場した際、その動力源はOpenAIが開発した「Codex」という単一のAIモデルでした。CodexはGPT-3を基盤としており、コードの理解と生成に優れ、AIが開発者のパートナーとなり得る可能性を示しました。

当時はまだChatGPTも登場しておらず、AIが現在のように注目される前の時代でした。しかし、AI技術は急速に進歩しています。GitHubは、この変化に対応し、開発者により良い体験を提供するため、Copilotを単一のモデルに依存する構成から、複数のAIモデルをタスクに応じて使い分ける「マルチモデルアーキテクチャ」へと移行させました。

この移行の最も大きな理由は、開発者に「選択の自由」を与えることです。AIモデルにはそれぞれ得意なこと、不得意なことがあります。あるモデルは高速な応答が得意かもしれませんが、別のモデルはより複雑で深い論理的思考を必要とするタスクに優れているかもしれません。マルチモデル構成により、開発者は目の前の作業に最も適したツールを選べるようになりました。

Copilotを支える主要なAIモデルたち

現在のGitHub Copilotでは、主に以下の企業のAIモデルが利用可能になっており、特にPro+、Business、Enterpriseプランのユーザーは、幅広い選択肢からモデルを選べます。

利用可能なモデル一覧

Anthropicモデル

- Claude Sonnet 3.5, 3.7

- Claude Sonnet 3.7 Thinking

- Claude Sonnet 4

- Claude Opus 4 (プレビュー)

- Claude Opus 4.1 (プレビュー)

OpenAIモデル

- GPT-4.1(デフォルト)

- GPT-5 (プレビュー), GPT-5 mini (プレビュー)

- o3 (プレビュー), o3-mini

- o4-mini (プレビュー)

Googleモデル

- Gemini 2.0 Flash

- Gemini 2.5 Pro

タスク別最適モデル一覧表

| モデル | 最適な用途 |

| o4-mini (OpenAI) | 高速・低遅延の補完 |

| GPT-4.1 (OpenAI) | バランス型・マルチモーダル対応 |

| GPT-5 mini (OpenAI) | 軽量な推論タスク |

| GPT-5 (OpenAI) | 複雑タスクの高度推論 |

| o3 (OpenAI) | 高度な計画・マルチステップ推論 |

| Claude Sonnet 3.5 | 日常的なコーディングタスク |

| Claude Sonnet 3.7 | 大規模コードベースの深い推論 |

| Claude Sonnet 3.7 Thinking | 長期視点での構造化問題解決 |

| Claude Sonnet 4 | より深い推論能力 |

| Claude Opus 4 | プレミアム推論パワー |

| Claude Opus 4.1 | Anthropic最高峰オプション |

| Gemini 2.0 Flash | 高速マルチモーダル機能 |

| Gemini 2.5 Pro | 高度マルチモーダル推論 |

機能ごとに最適化されたモデルの割り当て

Copilotは、その多様な機能の裏側で、インテリジェントにモデルを使い分けています。

コード補完

開発者が最も頻繁に利用するこの機能では、速度と精度が重要視されます。そのため、デフォルトでGPT-4.1が使用されています。これにより、待機時間を短縮し、30以上のプログラミング言語でスムーズなコーディング体験を実現しています。

Copilot Chat

コードに関する質問や相談では、自然言語の理解力と生成能力が求められます。ここでもGPT-4.1が基本となりますが、ユーザーはより対話に特化したClaudeシリーズ(3.5/3.7 Sonnet、3.7 Sonnet Thinking)、Gemini 2.0 Flash、o1、o3-miniなどを選択することも可能です。

エージェントモードとコーディングエージェント(新機能)

issueの分析、プルリクエストの自動生成、脆弱性の修正といった、複数のステップを要する複雑なタスクでは、高度な計画・実行能力が必要です。ここでもGPT-4.1がデフォルトですが、より深い推論が可能なClaudeシリーズやOpenAIの推論モデル(o1、o3-mini)などを選択することで、より自律的で高度なサポートを受けられます。

コーディングエージェントは、Copilotを単なるツールではなく、タスクを委任できる同僚のような存在に変える新機能です。github.comのAgentパネルからもアクセスできます。

コードレビュー(新機能)

新機能であるコードレビューでは、正確性と応答性のバランスが良いGPT-4.1が採用されています。大規模なコードベース全体を深く分析したい場合は、Claude 3.7 SonnetやClaude 3.7 Sonnet Thinkingなどが推奨されています。

GPT-4.1による大幅なパフォーマンス向上

最近のアップデートで、Copilot Chat、コード補完、プルリクエストサマリーがGPT-4.1に移行しました。この変更により、以下の改善が実現されています:

- 約40%の高速化: GPT-4oと比較して応答生成が大幅に高速化

- コンテキストウィンドウの大幅拡張: 従来のデフォルトモデルと比較して、はるかに多くのコンテキストをサポート

- 30以上のプログラミング言語での最適化されたパフォーマンス

プラン別の機能アクセス

基本機能(全プラン)

- GPT-4.1によるコード補完、チャット、エージェントモードへの無制限アクセス

プレミアム機能(Pro+、Business、Enterpriseプラン)

- 上記の全モデルへのアクセス(プレミアムリクエスト経由)

- コンテキスト駆動型チャット

- 高度なエージェントモード機能

新しいPro+プランでは、個人開発者でもこれらの高度なモデルの全機能を活用できるようになりました。

「エージェント的ワークフロー」がもたらす開発体験の向上

Copilotの進化で特に重要なのが、エージェント的ワークフローの強化です。これは、Copilotが単に指示を待つツールではなく、開発者からタスクを委任され、自律的に作業を進めるパートナーへと変化していることを意味します。

具体的には、以下のような作業をCopilotに任せることができます:

- issueコメントの整理と優先順位付け

- リポジトリを横断する依存関係の問題解決

- セキュリティ脆弱性の特定と修正パッチの作成

- プルリクエストの自動生成

- コードベースの分析とインデックス化

- ブランチ保護の尊重とレビューサイクルへの統合

重要なのは、開発者がエディターやGitHubから離れる必要がないことです。CopilotはGitHub Nativeであり、IDEとGitHub内で直接動作するため、フローを中断することなくタスクを委任できます。

これにより、開発者は煩雑な作業から解放され、より本質的で創造的な作業に集中できるようになります。これが、GitHubが目指す開発者体験(DevEx)の向上に直結しています。

まとめ

GitHub Copilotは、登場からわずか数年で、単なるコード補完ツールから、開発者の隣で自律的に作業をこなす強力なパートナーへと進化を遂げました。その心臓部であるAIモデルは、単一のCodexから、OpenAI、Anthropic、Googleの最新モデルを選択できるマルチモデル構成へと大きく変わりました。

この変化の核心は、開発者自身が最適なツールを選べるようになったことにあります。デフォルトのGPT-4.1は40%の高速化と拡張されたコンテキスト処理により優れた基本性能を提供しますが、より複雑なタスクや特定のニーズに合わせてモデルを切り替えることで、Copilotの能力を最大限に引き出すことができます。