はじめに

中国のAI研究機関DeepSeekが2026年1月1日、AIモデルの性能を向上させる新技術「mHC(Manifold-Constrained Hyper-Connections)」を発表しました。この技術は、大規模言語モデル(LLM)の訓練プロセスで広く使用されている残差接続メカニズムを改良したもので、SiliconANGLEが報じています。本稿では、mHCの技術的特徴と、既存手法との比較結果について解説します。

参考記事

- タイトル: DeepSeek develops mHC AI architecture to boost model performance

- 著者: Maria Deutscher

- 発行元: SiliconANGLE

- 発行日: 2026年1月1日

- URL: https://siliconangle.com/2026/01/01/deepseek-develops-mhc-ai-architecture-boost-model-performance/

参考論文

- 論文タイトル:mHC: Manifold-Constrained Hyper-Connections

- 著者:Zhenda Xie, Yixuan Wei, Huanqi Cao, Chenggang Zhao, Chengqi Deng, Jiashi Li, Damai Dai, Huazuo Gao, Jiang Chang, Liang Zhao, Shangyan Zhou, Zhean Xu, Zhengyan Zhang, Wangding Zeng, Shengding Hu, Yuqing Wang, Jingyang Yuan, Lean Wang, Wenfeng Liang

- 発行元:DeepSeek

- 発行日:2025年12月31日

- URL:https://arxiv.org/abs/2512.24880

要点

- DeepSeekは、AIモデルの学習メカニズムである残差接続を改良したmHC(Manifold-Constrained Hyper-Connections)アーキテクチャを開発し、論文を公開した

- mHCは2024年9月に登場したHyper-Connectionsの改良版で、manifoldと呼ばれる数学的構造を用いて勾配の安定性を維持する

- 3億、90億、270億パラメータの3つのLLMで検証した結果、Hyper-Connectionsを使用したモデルと比較して8つのベンチマークすべてで優れた性能を示した

- ハードウェア効率の面でも優位性があり、訓練時のメモリオーバーヘッドはわずか6.27%に抑えられている

詳細解説

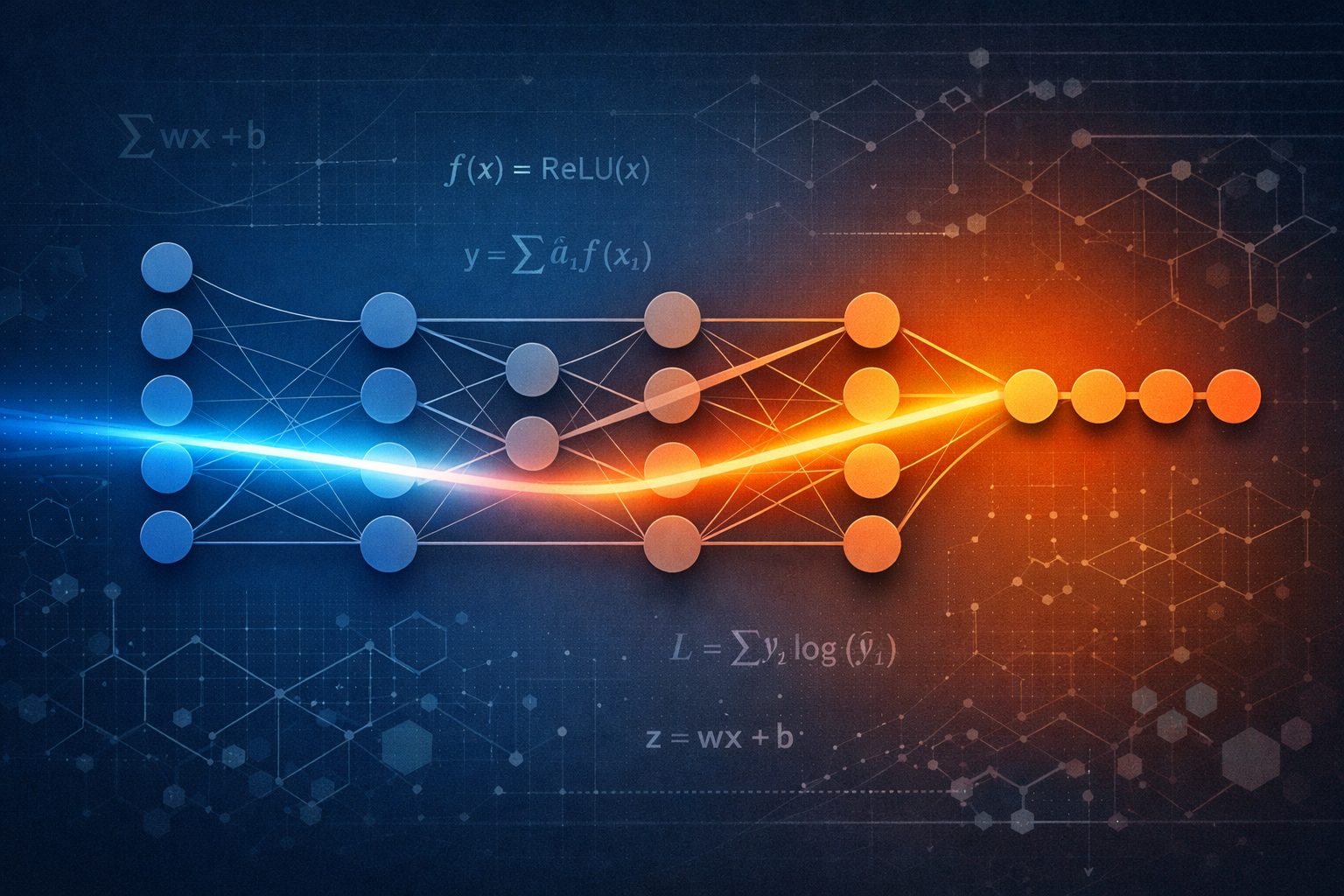

残差接続の役割とAI訓練の仕組み

AIモデルは、層(layer)と呼ばれる多数のソフトウェアコンポーネントで構成されています。ユーザーがプロンプトを入力すると、テキストは最初の層に入り、応答生成に必要な計算の一部を実行します。第1層は計算結果を第2層に送り、第2層はさらに処理を行って第3層に渡すという流れが続き、最終層がユーザーの質問に対する回答を出力します。

AI訓練プロセスでは、最終層が重要な役割を果たします。DeepSeekによれば、モデルが誤った応答を出力すると、最終層は勾配(gradient)と呼ばれる信号を受け取ります。勾配はモデルが誤りを犯したことを示すだけでなく、改善方法に関する情報も含んでいます。この勾配は最終層から逆方向に移動し、すべての層を通過して第1層まで到達します。

この勾配の移動プロセスは、誤差逆伝播(backpropagation)として知られる機械学習の基本的な仕組みです。各層は勾配を受け取ることで、自身のパラメータをどのように調整すべきかを学習します。

残差接続の発明と意義

2015年、研究者たちは残差接続(residual connection)と呼ばれる勾配管理メカニズムを発明しました。これは、勾配が2つの離れた層の間を、間にあるすべての層を経由せずに直接移動できるショートカットです。残差接続は一般的な訓練の問題を軽減するため、ほとんどLLMやビジョンモデルで使用されています。

残差接続は、深層ニューラルネットワークの訓練において勾配消失問題を解決する重要な技術として評価されています。層が深くなるにつれて勾配が小さくなりすぎて学習が進まなくなる問題を、ショートカット接続によって緩和できるためです。

Hyper-Connectionsの登場とその課題

2024年9月、研究者たちは残差接続の代替手法としてHyper-Connectionsを発表しました。この手法は残差接続のいくつかの欠点に対処していますが、独自の制約も抱えています。DeepSeekが今週発表したmHCアーキテクチャは、Hyper-Connectionsの改良実装です。Hyper-Connectionsに関連する技術的課題のいくつかを回避することで、本番環境での使用により適したものになっています。

具体的には、Hyper-ConnectionsはLLMの訓練時のメモリ要件を大幅に増加させるという問題がありました。この点がmHCの主要な改善点の一つとなっています。

mHCの主要な革新:manifoldの活用

mHCの主な革新は、manifoldと呼ばれる数学的構造を組み込んでいる点です。Manifoldは複雑さが大きく異なる数学的オブジェクトの幅広いファミリーです。DeepSeekによれば、円のような単純な幾何学的形状であるmanifoldもあれば、3次元を超えて広がるmanifoldもあります。mHCは、AIモデルの層間を移動する勾配の安定性を維持するためにmanifoldを使用しています。

Manifoldは位相幾何学(トポロジー)の概念で、局所的にはユークリッド空間のように見えるが全体としては異なる構造を持つ空間を指します。この数学的な枠組みを勾配の伝播に適用することで、より安定した学習が可能になると考えられます。

性能検証とベンチマーク結果

DeepSeekは、mHCアーキテクチャを使用して30億、90億、270億パラメータの3つのLLMを訓練することでテストを実施しました。同時に、同じパラメータ数を持つ3つのモデルをHyper-Connectionsを使用して訓練しました。DeepSeekによれば、mHCを搭載したLLMは8つの異なるAIベンチマークすべてで優れた性能を示しました。

この結果は、mHCがモデルのサイズに関わらず一貫して性能向上をもたらすことを示唆しています。30億パラメータの比較的小規模なモデルから270億パラメータの大規模モデルまで、すべてのスケールで改善が見られた点は注目に値します。

ハードウェア効率の向上

DeepSeekは、mHCアーキテクチャがHyper-Connectionsよりもハードウェア効率に優れていると述べています。前述のように、Hyper-ConnectionsはLLMの訓練中のメモリ要件を大幅に増加させます。DeepSeekの内部テストでは、mHCのハードウェアオーバーヘッドはわずか6.27%でした。

この低いオーバーヘッドは、大規模モデルの訓練において重要な意味を持ちます。訓練コストの大部分はハードウェアリソースに起因するため、メモリ効率の改善は実用性を大きく高めると考えられます。

今後の展望

DeepSeekの研究者は論文の中で、「位相構造が最適化と表現学習にどのように影響するかの理解を深めることで、mHCは現在の制約に対処し、次世代の基盤アーキテクチャの進化に向けた新しい道を照らす可能性があります」と述べています。

この表明は、mHCが単なる性能改善にとどまらず、AIアーキテクチャ設計における新しい研究方向を示す可能性を示唆しています。位相幾何学的アプローチがニューラルネットワーク設計にどのように応用できるか、今後の研究が注目されます。

まとめ

DeepSeekが発表したmHCアーキテクチャは、残差接続の改良版として、複数のベンチマークで性能向上を示し、ハードウェア効率の面でも優位性を持つことが確認されました。Manifoldという数学的構造を活用した勾配管理の新しいアプローチは、AIモデル訓練の効率化に貢献する可能性があります。位相幾何学とニューラルネットワークの融合という視点は、今後のAIアーキテクチャ研究に新たな方向性を提供するかもしれません。