はじめに

本稿では、人工知能(AI)が人間にとっては簡単なタスクであるアナログ時計の読み取りやカレンダーの理解に苦戦するという最新の研究結果について、Live Science の記事「AI models can’t tell time or read a calendar, study reveals」をもとに、解説します。

引用元記事

- タイトル: AI models can’t tell time or read a calendar, study reveals

- 発行元: Live Science

- 発行日: 2025年5月17日

- URL: https://www.livescience.com/technology/artificial-intelligence/ai-models-cant-tell-time-or-read-a-calendar-study-reveals

論文

- タイトル: Lost in Time: Clock and Calendar Understanding Challenges in Multimodal LLMs

- 発行日: 2025年2月7日

- URL: https://arxiv.org/abs/2502.05092

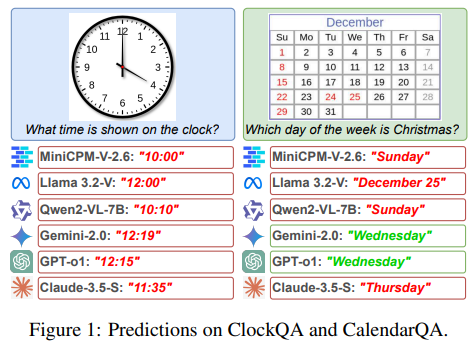

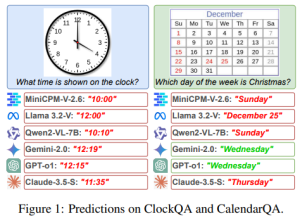

※上記論文より画像を引用しております。

要点

- 最新の研究により、AIモデルはアナログ時計の時刻読み取りやカレンダーの日付理解といった、人間にとっては基本的なタスクにおいて著しく低い正答率を示すことが明らかになった。

- 時計の読み取り正答率は38.7%、カレンダーの理解に関する正答率は26.3%に留まる。

- この原因は、AIの空間処理能力の課題と、訓練データの偏りや不足にあると指摘されている。

- AIはパターン認識には長けているが、人間のような抽象的な推論やルールの理解は不得手である。

- この発見は、AIを実世界の時間に制約されるアプリケーション(スケジュール管理、自動化技術など)に統合する上で、克服すべき重要な課題を示唆している。

詳細解説

AIが直面する「時間」という壁

近年、目覚ましい進化を遂げている人工知能(AI)は、文章作成、画像生成、プログラミング、さらには試験合格といった高度なタスクをこなす能力を示してきました。しかし、エジンバラ大学の研究者らによる最新の研究(2025年国際学習表現会議(ICLR)で発表、査読前論文はarXivにて2025年2月7日に公開)で、AIがアナログ時計の時刻を正確に読み取ったり、特定の日付が何曜日にあたるかを理解したりすることが非常に苦手であるという、意外な事実が明らかになりました。

研究チームは、Meta社の「Llama 3.2-Vision」、Anthropic社の「Claude-3.5 Sonnet」、Google社の「Gemini 2.0」、OpenAI社の「GPT-4o」といった、テキスト情報と視覚情報の両方を処理できるマルチモーダル大規模言語モデル(MLLM)に対し、時計やカレンダーの画像を提示してその読解能力をテストしました。その結果は驚くべきもので、時計の画像を正しく読み取れたのは平均で38.7%、カレンダーの日付(例:「その年の153日目は何曜日か?」)を正しく理解できたのはわずか26.3%でした。

なぜAIは時計やカレンダーが読めないのか?

人間にとっては幼い頃から習得できるこれらのスキルを、なぜ高度なAIが苦手とするのでしょうか。研究の筆頭著者であるロヒット・サクセナ氏は、その理由を次のように説明しています。

- 空間認識能力の課題:

- アナログ時計の読み取りには、単に物体を認識するだけでなく、針の重なりを検出し、角度を測定し、ローマ数字や様式化された文字盤といった多様なデザインを解釈するといった、高度な空間認識能力が求められます。

- 従来のAI(特に初期の画像認識モデル)は、「これは時計である」と認識することはできても、その文字盤が示す具体的な時刻を読み取るような、より複雑な空間的推論は苦手としています。AIは画像をピクセルの集合として処理するため、人間のように針の位置関係や文字盤の構造を直感的に理解することが難しいのです。

- 算術演算と訓練データの限界:

- カレンダーの理解には、基本的な算術演算(例えば、特定の日から何日後が何曜日か、など)が必要です。従来のコンピュータにとって算術演算は得意中の得意ですが、大規模言語モデル(LLM)は異なります。

- LLMは、数学的なアルゴリズムを実行するのではなく、訓練データに含まれる膨大なテキストや画像データの中のパターンに基づいて、最もそれらしい出力を予測します。そのため、算術的な問いに対して時折正解することはあっても、その推論が一貫しているわけでも、ルールに基づいているわけでもありません。

- 特に、うるう年や特殊なカレンダー計算のように、訓練データ中に出現頻度が低い現象に関しては、AIが正しく処理するための十分なパターンを学習できていない可能性があります。LLMが「うるう年」という概念を説明できたとしても、それを視覚的なタスクや具体的な日付計算に結びつけることができないのです。

人間の理解とAIの「理解」の違い

この研究は、AIが情報を「理解する」方法と、人間が理解する方法との間には、依然として大きな隔たりがあることを浮き彫りにしています。AIは訓練データに存在するパターンを学習し、類似のタスクには優れた性能を発揮しますが、未知の状況への汎化能力や、抽象的な概念に基づいた推論は苦手とする傾向があります。

サクセナ氏は、「私たちにとって時計を読むような非常に簡単なタスクが、AIにとっては非常に難しい場合があり、その逆もまた然りです」と述べています。これは、AIの能力を過信することの危険性を示唆しています。

今後の課題と展望

今回の研究結果は、AIをスケジュール管理、自動化システム、支援技術といった、時間に制約のある実世界のアプリケーションに安全かつ効果的に統合するためには、克服すべき重要な課題があることを示しています。

研究者らは、AIの訓練データに、よりターゲットを絞った事例(例えば、多様なデザインの時計の画像や、複雑なカレンダー計算の事例など)を増やすことの必要性を指摘しています。また、AIが論理的推論と空間的推論を組み合わせる能力、特に遭遇頻度の低いタスクを処理する能力をどのように向上させるかについて、再考する必要があるとしています。

サクセナ氏は、「AIは強力ですが、知覚と正確な推論が混在するタスクでは、依然として厳密なテスト、フォールバックロジック(エラー発生時の代替処理)、そして多くの場合、人間による監視(ヒューマン・イン・ザ・ループ)が必要です」と結論付けています。

まとめ

本稿では、AIがアナログ時計の読み取りやカレンダーの理解といった、人間にとっては基本的なタスクに苦戦するという最新の研究結果について解説しました。この問題の背景には、AIの空間認識能力の未熟さや、算術演算に対するアプローチの違い、そして訓練データの限界があることが示唆されています。

この発見は、AIの能力を正しく理解し、その限界を認識した上で、社会実装を進めていくことの重要性を改めて教えてくれます。AIは多くの可能性を秘めた技術ですが、万能ではありません。特に、正確性や安全性が求められる分野においては、AIの出力を鵜呑みにせず、人間の判断や検証を組み合わせることが不可欠です。今後のAI研究開発においては、こうした弱点を克服し、より人間社会に調和した形で貢献できるAIの実現が期待されます。