はじめに

スマートウォッチやフィットネストラッカーといったウェアラブルデバイスは、私たちの生活にすっかり浸透しました。心拍数や歩数、睡眠パターンなど、膨大なデータを日々記録し続けています。これらのデータは、個人の健康状態をより深く理解するための大きな可能性を秘めていますが、一つ大きな課題がありました。それは、データが示す「何が(What)」は分かっても、その背景にある「なぜ(Why)」という文脈が欠けていることです。例えば、心拍数が150bpmという数値だけでは、それが「激しい運動の結果」なのか、「ストレスのかかるプレゼンテーション中」なのかを区別できません。

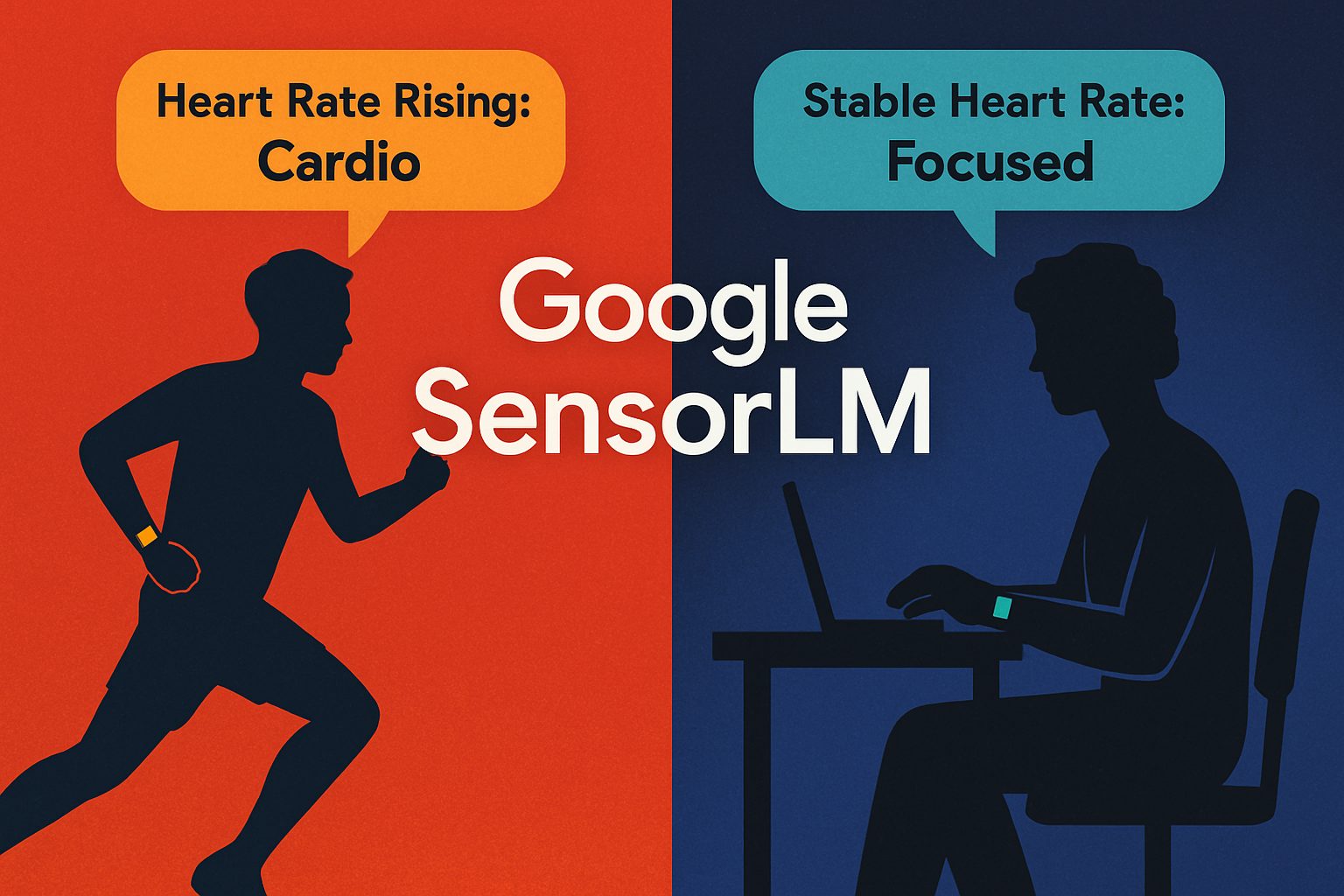

本稿では、この課題を乗り越えるためにGoogle Researchが発表したウェアラブルセンサーのデータと自然言語を結びつける新しい基盤モデル「SensorLM」について、その仕組みと可能性を解説します。

参考記事

- タイトル: SensorLM: Learning the language of wearable sensors

- 発行元: Google Research

- 発行日: 2025年7月28日

- URL: https://research.google/blog/sensorlm-learning-the-language-of-wearable-sensors/

要点

- SensorLMは、ウェアラブルセンサーから得られる多様な時系列データと、その状況を説明する自然言語を結びつけるために開発された、センサー言語基盤モデル群である。

- 従来の研究における最大の課題であった「センサーデータとテキストラベルの大規模なペアデータセット」の不足を、センサーデータ自体から統計情報やイベントを抽出し、自動でテキストキャプションを生成する独自のパイプラインを開発することで克服した。

- 学習には、センサーデータと対応するテキストを正しく関連付ける「対照学習」と、センサーデータから直接テキストを生成する「生成的系列前学習」という2つの手法を統合的に用いている。これにより、データの識別能力と文脈に沿った説明生成能力の両方を獲得している。

- 事前学習済みのSensorLMは、特定のタスクに関する追加学習なしで活動を分類する「ゼロショット学習」や、ごく少数の事例から新しいタスクを学ぶ「フューショット学習」において、既存のモデルを上回る高い性能を示した。

- モデルサイズ、データ量、計算量を増やすほど性能が向上するスケーリング則が確認されており、このアプローチの将来的な発展可能性は大きい。

詳細解説

ウェアラブルデータ活用の課題:「何が」は分かっても「なぜ」が分からない

私たちが日常的に使うスマートウォッチは、心拍数、加速度、皮膚温といった様々なデータを24時間記録し続けています。これらのデータは客観的な数値として非常に有用ですが、それだけでは断片的な情報に過ぎません。

論文でも指摘されている通り、例えば心拍数が急上昇したというデータがあったとします。この時、私たちはその数値が「何を」意味するのかは分かりますが、「なぜ」そうなったのかという文脈までは分かりません。それは、坂道を駆け上がったからかもしれませんし、大勢の前でスピーチをして緊張したからかもしれません。あるいは、単に興奮する映画を見ていただけかもしれません。活動の背景にある文脈が異なれば、そのデータの解釈も全く変わってきます。

このように、生のセンサーデータとその意味内容との間にあるギャップを埋めることが、ウェアラブルデバイスの価値を真に引き出す上での大きな障壁となっていました。

SensorLMの核心:データセット構築の壁をどう乗り越えたか

AI、特に言語モデルが賢くなるためには、大量の質の高い学習データが不可欠です。センサーデータの文脈をAIに理解させるには、「特定のセンサーデータのパターン」と「その時に何をしていたかを説明するテキスト」がペアになったデータセットが大量に必要になります。しかし、何百万時間ものセンサーデータに人手で正確な説明(アノテーション)を付けていくのは、時間とコストの面から現実的ではありませんでした。

この根本的な問題を解決するため、SensorLMの研究チームは非常に独創的なアプローチを取りました。それは、センサーデータ自体から、その説明文を自動で生成する仕組み(階層的パイプライン)を開発することです。このパイプラインは、センサーデータから統計的な特徴(平均心拍数など)や傾向、特徴的なイベント(急な動きなど)を自動で算出し、それらを組み合わせて自然な文章のキャプションを生成します。

この技術革新により、研究チームは10万人以上の被験者から得られた、合計約6000万時間にも及ぶ膨大なセンサーデータに対して、自動でテキストキャプションを付与することに成功しました。これは、これまで報告されている中で最大規模のセンサー言語データセットであり、SensorLMの強力な性能の基盤となっています。

SensorLMを賢くする2つの学習戦略

SensorLMは、大規模なデータセットを効果的に学習するために、2つの主要な機械学習の手法を組み合わせています。

- 対照学習 (Contrastive Learning)

これは、モデルに「区別する能力」を教える学習方法です。具体的には、あるセンサーデータの断片に対して、それとペアになる正しいテキスト説明と、全く関係のない複数のテキスト説明を提示し、モデルに正しいペアを選ばせます。これを繰り返すことで、モデルは「軽い水泳」と「筋力トレーニング」のような、似ているようで異なる活動の微妙なセンサーパターンの違いを識別できるようになります。 - 生成的系列前学習 (Generative Pre-training)

こちらは、モデルに「表現する能力」を教える学習方法です。センサーデータだけを入力として与え、そのデータが示す状況を説明するテキストキャプションをモデル自身に生成させます。これにより、モデルは高次元の複雑なセンサー信号のパターンを理解し、それを豊かで文脈に沿った言葉で表現する能力を身につけます。

SensorLMは、これら2つのアプローチを一つのフレームワークに統合することで、センサー信号と言語の関係性を深く、多角的に理解することができるのです。

SensorLMはどれくらい「使える」のか?

開発されたSensorLMは、様々なタスクでその有効性を証明しています。

- 優れた適応能力(ゼロショット/フューショット学習)

SensorLMの特筆すべき点の一つは、ゼロショット学習の能力です。これは、特定の活動について一度も追加学習をしていないにもかかわらず、20種類もの活動を正確に分類できることを意味します。また、フューショット学習(数個の事例を学習するだけで新しいタスクに対応できる能力)にも優れており、新しいユーザーや未知の活動に対しても、最小限のデータで迅速に適応できることを示しています。 - 高精度なキャプション生成

論文で示された実験結果では、SensorLMはセンサーデータのみから、その状況を説明するキャプションを生成するタスクにおいて、他の強力な汎用大規模言語モデル(LLM)よりも一貫性があり、事実に基づいた正確なキャプションを生成できることが示されています。これは、SensorLMがウェアラブルセンサーの「言語」を専門的に学習したことによる成果と言えます。 - 性能向上の可能性(スケーリング則)

さらに重要な発見として、SensorLMの性能は、学習データの量、モデルのサイズ、計算量を増やすにつれて一貫して向上することが確認されました。これは「スケーリング則」として知られる現象で、このアプローチが正しい方向性であり、今後さらに投資を続けることで、モデルがさらに賢くなる大きなポテンシャルを秘めていることを示唆しています。

まとめ

本稿で解説したSensorLMは、ウェアラブルセンサーが収集する膨大な生データを、私たち人間が理解できる「意味のある情報」へと変換するための重要な一歩です。センサーデータから説明文を自動生成するという独創的な手法でデータセット構築の壁を乗り越え、対照学習と生成的学習を組み合わせることで、センサーデータの文脈を深く理解するモデルを創り出しました。

この技術は、単に日々の活動を記録するだけだったウェアラブルデバイスを、私たちの健康状態を解釈し、自然言語で対話できるパーソナルヘルスコーチや、より高度な臨床モニタリングツールへと進化させる可能性を秘めています。将来的には、代謝状態の分析や詳細な睡眠解析など、さらに複雑な領域への応用も計画されており、SensorLMが切り拓く未来に大きな期待が寄せられます。