はじめに

本稿では、Google Cloudの公式ブログ「Save early and often with multi-tier checkpointing to optimize large AI training jobs」を基に、大規模なAIモデルの学習効率を劇的に向上させる新技術「多層チェックポイント(Multi-tier Checkpointing)」について、その仕組みと重要性を解説します。

引用元記事

- タイトル: Save early and often with multi-tier checkpointing to optimize large AI training jobs

- 発行元: Google Cloud Blog

- 発行日: 2025年6月17日

- URL: https://cloud.google.com/blog/products/ai-machine-learning/using-multi-tier-checkpointing-for-large-ai-training-jobs?hl=en

要点

- 巨大なAIモデルの学習では、数万の計算ユニット(アクセラレータ)を使うため、ハードウェア障害が数時間おきに発生し、学習の進捗が失われることが大きな課題である。

- 従来のチェックポイント(学習状態の保存)は、保存と復旧に最大30分かかり、これが大きな時間のロスに繋がっていた。

- Google Cloudが開発した「多層チェックポイント」は、①ノード内メモリ(RAM)、②クラスタ内の別ノード、③クラウドストレージという3つの階層に段階的に状態を保存する技術である。

- この技術により、チェックポイントの保存は5分未満、障害からの復旧は1分未満へと劇的に短縮され、学習の中断時間を最小化できる。

- 結果として、計算リソースの有効利用率(ML Goodput)が大幅に向上し(35,000チップの構成で6.59%向上)、これは数百万ドル規模のインフラコスト削減に直接貢献する。

詳細解説

なぜ大規模AI学習で「チェックポイント」が重要なのか?

「チェックポイント」とは、AIモデルの学習途中における「セーブデータ」のようなものです。AIの学習は、時に数週間から数ヶ月かかる非常に長いプロセスです。もし学習の途中で機材の故障やシステムエラーが発生すると、それまでの学習成果がすべて失われ、また最初からやり直しになってしまいます。それを防ぐために、定期的にモデルの状態(パラメータや重みなど)を保存するのがチェックポイントの役割です。

問題は、AIモデルが巨大化し、学習に使うコンピュータの規模(クラスタ)が数千、数万個のプロセッサ(GPUやTPU)にまで膨れ上がると、ハードウェア障害は「起こるかもしれない」ものではなく「必ず頻繁に起こる」ものになることです。部品が多ければ多いほど、どこかが故障する確率は上がります。

従来の方式では、このチェックポイントを安全な外部ストレージ(Google Cloud Storageなど)に保存していましたが、巨大なモデルのデータを保存・復旧するにはそれぞれ最大で30分もかかっていました。障害が発生するたびにこれだけの時間が中断されると、トータルでは膨大な時間とコストの無駄、いわば「Badput(バッドプット)」(無駄な処理時間)が生じています。

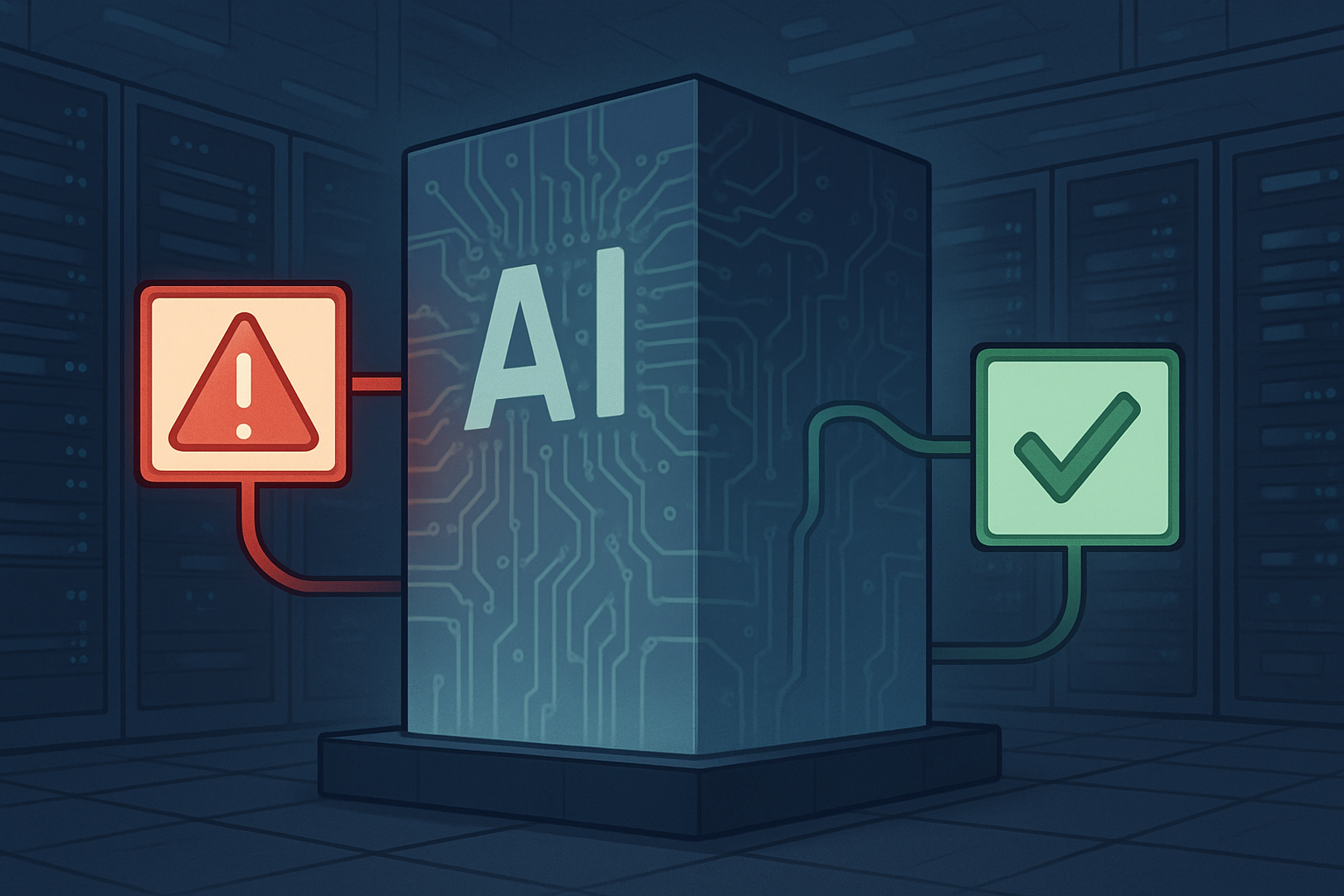

解決策としての「多層チェックポイント」の仕組み

そこでGoogle Cloudが開発したのが、「多層チェックポイント」という画期的なアプローチです。これは、性質の異なる3つのストレージ層を使い分けることで、スピードと安全性の両立を図るものです。

(画像出典:Google Cloud Blog)

- 第1層:ノードのRAM(メモリ)

- 現在計算を行っているコンピュータ(ノード)のメモリ内に、最も頻繁にチェックポイントを保存します。RAMへのアクセスは非常に高速なため、保存にかかる時間はごくわずかです。

- 第2層:クラスタ内の別ノード

- 次に、第1層のデータを、クラスタを構成する別のコンピュータのRAMに複製します。これにより、元のノード自体が故障しても、近くの「同僚」から高速にデータを復旧できます。

- 第3層:Google Cloud Storage (GCS)

- そして最後に、より低い頻度で、データをGoogle Cloud Storageという非常に堅牢で永続的なストレージにバックアップします。これは、クラスタ全体に影響するような大規模な障害に備えるための「最終防衛ライン」です。

障害が発生すると、システムはまず最も高速な第1層にデータがないか探し、なければ第2層、それでもなければ第3層からデータを復旧します。この仕組みにより、ほとんどの障害は高速なメモリからの復旧で済むため、復旧時間を1分未満にまで短縮できます。

技術的な心臓部「Replicator」の賢い働き

この洗練されたデータのやり取りを裏で支えているのが、「Replicator(レプリケーター)」というコンポーネントです。Replicatorは各コンピュータ上で動作し、以下のようないくつかの賢い機能を持っています。

- 最適な複製先の選択: ネットワークの構造を理解しており、通信が速く、かつ障害の影響を受けにくい最適なコンピュータを複製先に選び出します。

- データの重複排除: 複数のコンピュータが同じ計算を行っている場合、同じチェックポイントデータをわざわざコピーしません。これにより、ネットワーク帯域やストレージ容量の無駄を徹底的に省きます。

- 自動的なお掃除: 新しいチェックポイントが全ノードで無事に保存されたことを確認すると、古くなった不要なデータを自動的に削除し、ストレージを常にクリーンに保ちます。

これらの機能により、システムの規模がどれだけ大きくなってもチェックポイントの保存時間が延びることなく、常に高速な保存と復旧が可能になります。

もたらされる絶大な効果:コストと時間の削減

この技術がもたらす最大の価値は、「ML Goodput(グッドプット)」、すなわち計算リソースが本当に有効な学習処理に使われた時間の割合を大幅に向上させる点にあります。

Googleの最新プロセッサであるTPU v5pを35,000チップ使った巨大な学習ジョブにおいて、Goodputが6.59%も向上したと報告されています。これは、学習に費やす全体の時間とコストが、そのまま6.59%削減されることを意味します。

例えば、「1000台の高性能マシンを1週間使うようなジョブの場合、約100万ドル(1.5億円以上)ものインフラコストを節約できる可能性がある」と試算されており、この技術の経済的インパクトの大きさが伺えます。

まとめ

本稿で解説した「多層チェックポイント」は、大規模AI学習における障害という避けられない問題に対し、保存場所を階層化するという賢いアプローチで立ち向かう画期的なソリューションです。

その核心は、高速な保存と復旧によって学習の中断を最小限に抑え、高価な計算リソースの利用効率(Goodput)を最大化することにあります。これは、単なる技術的な改善に留まらず、AI開発の期間短縮とコスト削減に直接的に貢献する、非常に実践的な価値を持つものです。