Googleが2025年5月6日にarxivに発表した医療分野におけるAIシステムに関する論文「Advancing Conversational Diagnostic AI with Multimodal Reasoning」を紹介します。従来のテキストベースの対話だけでなく、「マルチモーダルデータ」(画像や医療文書といった様々な種類のデータ)を理解し、診断に活用できるようになった対話型診断AIシステム「AMIE:the Articulate Medical Intelligence Explorer」の進化について詳細に報告しています。

医療現場では、高齢化による負担増、医師の燃え尽き症候群、地域による医療アクセス格差など、多くの課題を抱えています。近年、大規模言語モデル(LLM:Large Language Model)をベースとしたAIシステムが、これらの課題の一部を解決する可能性を秘めているとして注目されています。

これまでにも、AMIEはテキストベースの対話において、現役の医師(プライマリケア医:PCPs)と同等以上の診断能力や対話品質を示すなど、そのポテンシャルが示されてきました。しかし、実際の遠隔医療(テレヘルス)では、患者さんが症状の写真を送ったり、検査結果のPDFを共有したりと、テキスト以外のデータも頻繁にやり取りされます。従来のLLMベースのAIは、こうしたマルチモーダルデータを適切に扱えるかどうかが未知数でした。

本論文は、この課題に取り組み、AMIEがマルチモーダルデータを取り入れて診断会話を進化させた成果を発表しています。

引用元論文

- タイトル:Advancing Conversational Diagnostic AI with Multimodal Reasoning

- 発行日:2025年5月6日

- URL:https://arxiv.org/abs/2505.04653

・あくまで個人の理解に基づくものであり、正確性に問題がある場合がございます。

必ず参照元論文をご確認ください。

・本記事内での画像は、上記論文より引用しております。

論文の要点

- マルチモーダル対応の実現:AMIEがテキストだけでなく、皮膚の画像、心電図(ECG:Electrocardiogram)、臨床文書(検査結果など)といったマルチモーダルデータを会話の中で受け取り、解釈し、診断に活用できるようになった点が最大の進化です。

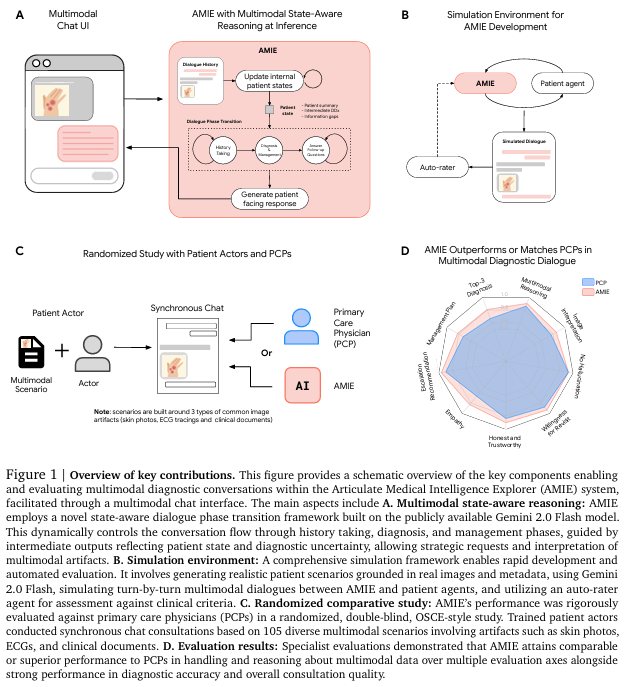

- ステートアウェアな推論フレームワーク:会話の流れ、患者の状態、診断の可能性(鑑別診断、DDx:Differential Diagnosis)や不確実性をAIが内部的に認識し(これを「ステートアウェア」と呼びます)、それに基づいて次に取るべき行動(追加質問、マルチモーダルデータの要求など)を動的に決定する仕組みが導入されました。これにより、経験豊富な医師のような構造的かつ適応的な問診プロセスを模倣しています。

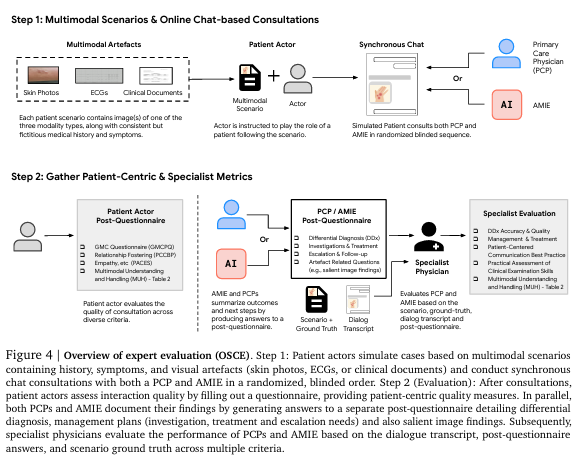

- 厳格な評価手法:医療教育や医師免許試験で標準的に用いられる「Objective Structured Clinical Examination (OSCE:客観的臨床能力試験)」という評価形式を応用しました。訓練された患者役と医師(PCP)、そしてAMIEがチャット形式で対話を行い、その様子を18名の専門医が評価しました。105種類のシナリオが用意され、皮膚科、循環器科、内科に関する多様な症例とマルチモーダルデータが含まれました。

- PCPを凌駕または同等以上の性能:評価の結果、マルチモーダルAMIEは、マルチモーダルデータの取り扱いと推論に関する9つの評価軸のうち7つでPCPを上回り、診断精度や問診、マネジメント計画、コミュニケーション能力、共感といったテキストベースの評価軸でも32のうち29で同等以上の高い性能を示しました。特に、患者役からのマルチモーダルデータに関する質問への対応や、画像・文書から得られた所見の説明において、PCPよりも高く評価されています。

- シミュレーション環境の活用:迅速な開発と評価のために、リアルな患者シナリオとマルチモーダルデータを用いた対話シミュレーション環境が構築され、自動評価(オートレイター)が活用されました。この環境での評価により、ステートアウェアな推論フレームワークや対話を取り入れることの有効性が定量的に確認されました。

詳細解説

論文の内容をセクションごとに解説します。

1. はじめに (Introduction)

まず、世界の医療が直面している課題(高齢化、医療の断片化、医師の燃え尽き症候群など)が提示され、これが受診待ち時間の増加や医療アクセスの制限につながっている現状が説明されます。そして、LLMをベースとしたAIシステムが、これらの課題に対する潜在的な解決策として期待されていることが述べられています。

以前のAMIEに関する研究では、テキストベースの対話において、AMIEが現役のPCPと同等またはそれ以上の問診能力や診断精度を持つことが示されました。また、AIによるトリアージ(緊急度判断)や受診ナビゲーションの実装も始まっており、患者からの受け入れやすさ(アクセプタビリティ)も良好であることが報告されています。

しかし、これまでの研究や実装は主にテキストのみのやり取りに限定されており、皮膚病変の画像、心電図の波形、臨床検査結果のPDFなど、実際の医療現場で重要な役割を果たすマルチモーダルデータをAIがどのように扱うかという点は未解明でした。

2. アプローチ (Approach)

本研究の核心は、AMIEの診断能力をマルチモーダル認識によって向上させることにあります。これにより、テキストだけでなく様々な医療データを取り込んだ、より臨床的に現実的な診断会話を可能にすることを目指しました。

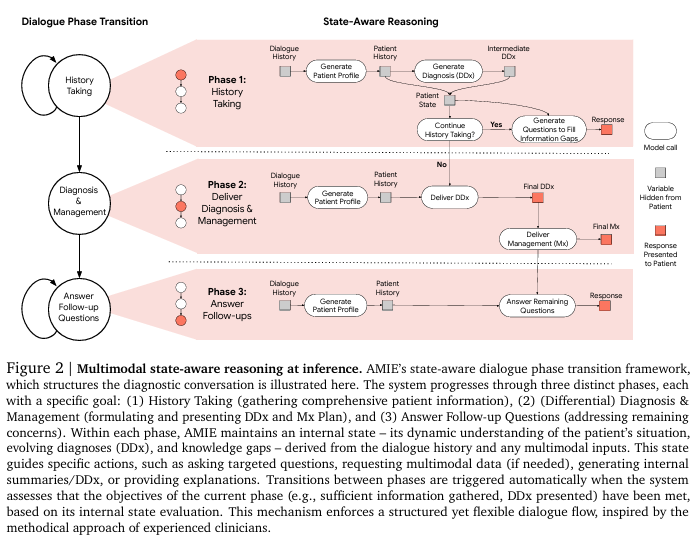

このために導入されたのが、ステートアウェアな対話フェーズ遷移フレームワークです。これは、診断プロセスを構造化するために設計された仕組みです。AIは会話の進行に応じて、以下の3つのフェーズを動的に遷移します。

3段階のフェーズ

- 問診(History Taking): 患者さんの包括的な情報を収集するフェーズです。

- 診断とマネジメント(Diagnosis & Management): 鑑別診断(DDx)を形成し、その可能性とマネジメント計画(Mx)を患者さんに提示するフェーズです。

- フォローアップ質問への回答(Answer Follow-up Questions): 患者さんの残っている疑問や懸念に答えるフェーズです。

各フェーズにおいて、AMIEは会話履歴とマルチモーダル入力から得られる、患者さんの状況、診断の可能性(DDx)、そして情報不足(Knowledge Gaps)といった内部状態(Internal State)を動的に更新し、維持します。この内部状態に基づいて、AIは次に取るべき行動(特定の質問をする、マルチモーダルデータを要求する、内部サマリーを作成するなど)を決定します。例えば、発疹の訴えがあれば、AIの内部状態が「視覚的な情報が必要」という知識ギャップを認識し、画像提出を患者に促す、といった具合です。

フェーズ間の遷移は、現在のフェーズの目標(例: 十分な情報が集まった、診断が提示できた)が、この内部状態の評価に基づいて達成されたとシステムが判断した場合に自動的にトリガーされます。これにより、経験豊富な医師が診察を進める際に、患者さんの話を聞き、必要に応じて検査や画像を見て、診断を考え、治療方針を説明し、患者さんの質問に答える、といった一連の流れを柔軟かつ構造的に模倣できるようになります。

このフレームワークは、マルチモーダル認識と推論能力に優れた基盤モデルである「Gemini 2.0 Flash」を活用して実装されています。Gemini 2.0 Flashは、テキストと画像を同時に理解・処理できる能力を持つAIモデルです。

システム全体の評価戦略としては、自動評価パイプラインと人間による比較評価(OSCE)の二本立てで行われました。

3. シミュレーション環境(Simulation Environment)

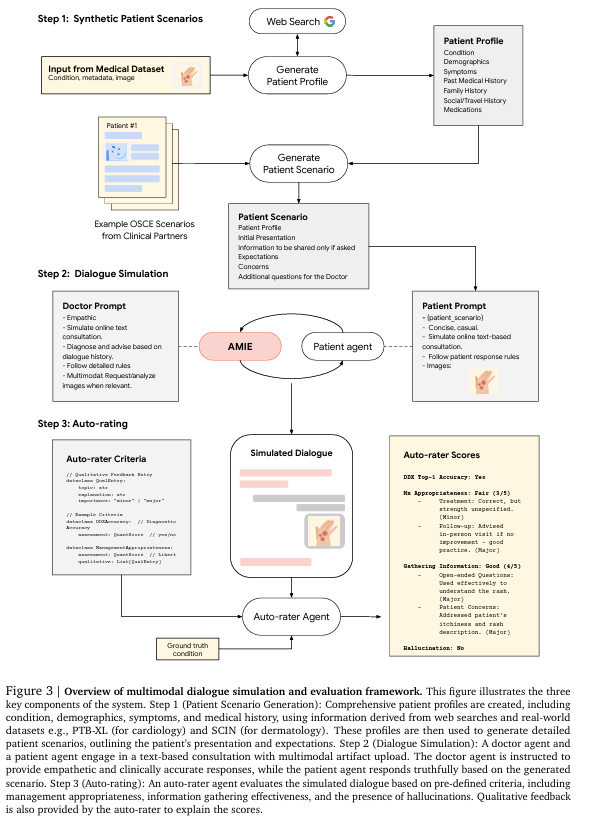

迅速な開発と頑健な評価のために、包括的なシミュレーション環境が開発されました。これは以下のステップで行われます。

- リアルな患者シナリオの生成: 実際の医療画像データセットやWeb検索で得られた情報を基に、詳細な患者プロフィール(症状、病歴、年齢、性別など)とマルチモーダルデータを含むシナリオを作成します。

- 対話シミュレーション: 作成されたシナリオに基づき、AMIEエージェント(共感的かつ臨床的に正確な対応をするよう指示)と患者エージェント(シナリオ通りに正直に応答)がテキストベースの対話を行います。患者エージェントは必要に応じて医療アーティファクト(画像など)をアップロードします。AMIEはこれを分析し、診断推論に組み込みます。

- 自動評価(オートレイティング): 対話の記録をオートレイターエージェントが、診断精度、情報収集の有効性、マネジメント計画の適切さ、幻覚(ハルシネーション)の有無など、事前に定義された臨床基準に従って評価します。オートレイターはGemini 2.0 Flashをベースとしており、人間による評価(専門医による評価)との相関が高いことが確認されています。これにより、開発中のAIの性能を迅速かつ大規模に評価することが可能になりました。

OSCEスタディ(OSCE Study)

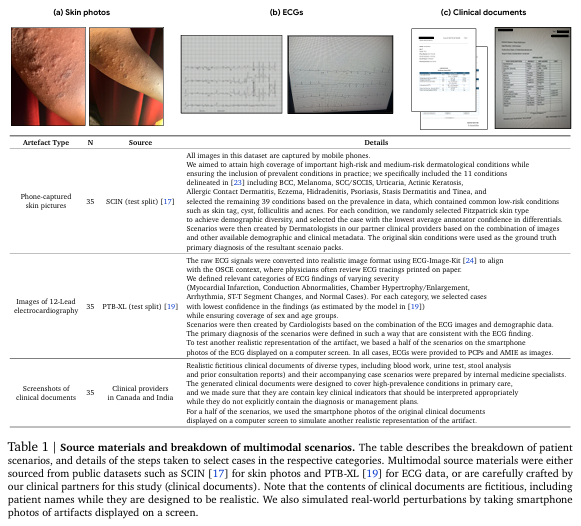

本研究の主要な評価は、医療教育で広く使われている標準的な評価手法であるOSCE形式を採用した無作為化二重盲検比較研究として実施されました。訓練を受けた25名の患者役が、AMIEまたは現役のPCPと、チャット形式で診断コンサルテーションを行いました。

評価シナリオは合計105種類用意され、皮膚疾患のスマートフォン写真、心電図の波形、臨床文書(PDF形式の検査結果など)といったマルチモーダルデータが必須となるように設計されました。シナリオは多様な病状や患者層を網羅し、テキスト情報だけでは診断に至らず、マルチモーダルデータの解釈と問診の両方が必要な、難易度の高いケースも含まれています。

評価は18名の専門医(皮膚科医、循環器科医、内科医)によって行われました。評価項目は多岐にわたり、マルチモーダルデータの取り扱い・推論能力に加え、問診、診断精度、マネジメント推論、コミュニケーションスキル、共感など、臨床的に重要な様々な側面が網羅されました。

4. 結果 (Results)

本セクションでは、OSCEスタディと自動評価の結果が報告されています。

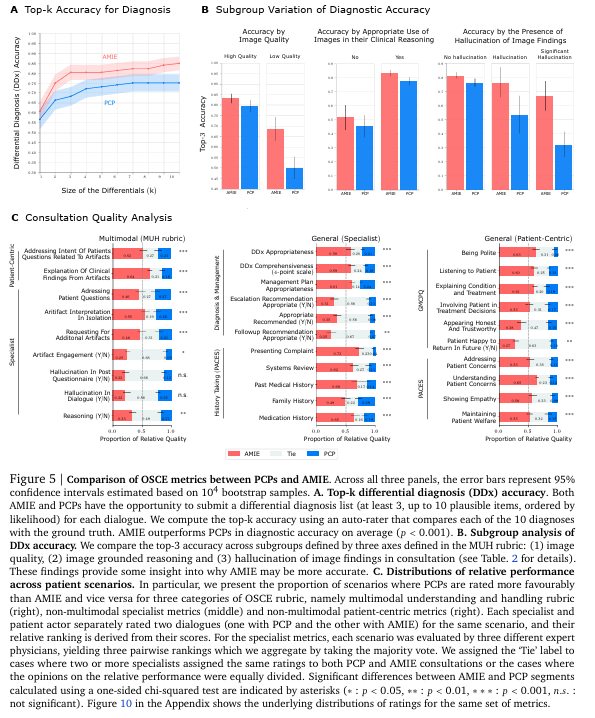

PCPとの比較評価(OSCEスタディ)

OSCEスタディの結果、マルチモーダルAMIEは、現役のPCPと比較して、多くの臨床的に重要な評価軸で同等またはそれ以上の性能を示しました。特に、マルチモーダルデータの取り扱いと推論能力に関する評価では、AMIEは9つの軸のうち7つでPCPよりも高く評価されました。これには、アーティファクト(画像や文書)への関与、単体での解釈、アーティファクトに基づいた推論などが含まれます。

専門医は、AMIEが画像や文書から得られた所見を正確に解釈し、会話の中で明確に伝達する能力において、PCPよりも有意に優れていると評価しました。

さらに、患者役による評価では、AMIEはマルチモーダルデータに関する彼らの質問の意図を捉え、そのデータから得られた臨床的な所見を説明する能力において、PCPよりも有意に高く評価されています。これは、AMIEが画像を具体的に参照し、その所見と患者の訴えを結びつけて説明したのに対し、PCPは画像に直接言及しないことがあったためと考えられます。患者は、提供した視覚的証拠が正しく伝わり、診断に活用されていることを確認できる明示的なコミュニケーションを重視する可能性があることが示唆されます。

診断精度については、AMIEはPCPと比較して同等以上の高い性能を示しました。マルチモーダルデータの品質が低い場合でも、AMIEの診断精度の低下はPCPよりも小さく、テレヘルスで起こりうる不完全なデータに対する頑健性が高い可能性が示されました。

また、AIまたはPCPが視覚的アーティファクトを推論に適切に使用した場合、どちらも診断精度が向上しており、マルチモーダルデータの統合が診断成功に不可欠であることが確認されました。これは、AMIEの優れた性能が単なるテキスト分析だけでなく、画像ベースの診断情報を活用した結果であることを裏付けています。

自動評価(Automated Evaluations)

OSCEスタディに加えて、自動評価フレームワークを用いた評価も行われました。

まず、基盤モデルであるGemini 2.0 Flashの医療マルチモーダルデータ認識能力が検証され、皮膚画像や臨床文書の解釈において堅牢な能力を持っていることが確認されました。心電図に関しては、静止画像からの解釈の複雑さから、他のモダリティほど高い性能ではありませんでしたが、それでも以前のバージョンからは向上が見られました。

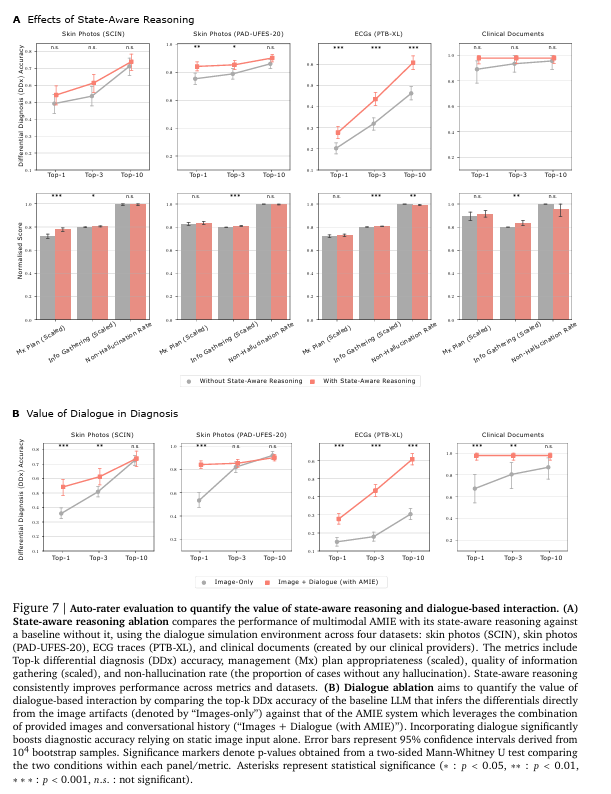

次に、ステートアウェアな推論フレームワークの効果を定量化するためのアブレーションスタディ(一部の機能を無効にして比較する研究)が、シミュレーション環境で行われました。ステートアウェアな推論を持つAMIEは、そうでないベースラインと比較して、鑑別診断精度、情報収集、マネジメント計画の適切さなど、主要な診断指標全体で一貫して優れた性能を示しました。特に、臨床文書からの情報抽出や、特定のデータセットにおける診断精度が大幅に向上しました。

また、マルチモーダルデータのみからの診断と、マルチモーダルデータに加えて対話(問診)を組み合わせた診断の価値を比較するアブレーションスタディも行われました。結果、対話を取り入れた「Images + Dialogue」設定のAMIEは、「Images-only」設定と比較して、診断精度が大幅に向上しました。これは、単に2つの独立した情報源を使うのではなく、AMIEが対話と画像を相互参照しながら情報を統合していることの重要性を示しています。

シミュレーションシナリオの様々な変更(人口統計情報、性格、意味論的な表現の変更など)に対するシステムの頑健性も評価され、臨床的に重要でないバリエーションに対してAMIEの性能が安定していることが示されました。

5. 関連研究 (Related Work)

このセクションでは、対話型診断エージェント、医療分野のマルチモーダルAI、AIシステムの評価、そして現代の遠隔医療プラットフォームといった関連分野の研究がレビューされています。MYCINのような初期のルールベースシステムから、テキストベースのAMIE、そして医療特化型のLLMやVLM(Vision-Language Model)まで、これまでの進歩が紹介されています。

本研究は、これらの先行研究に対し、マルチモーダルデータの取り扱い能力を診断会話に統合した点で貢献しています。既存のVLMが画像に関する質問応答や会話に焦点を当てているのに対し、本研究は診断プロセス全体においてマルチモーダルデータをダイナミックに収集、解釈、推論に組み込む点に違いがあります。

評価方法についても、OSCEの応用や、マルチモーダルデータの取り扱い・推論に特化した新しい評価基準(MUH rubric)を導入した点が新規性として挙げられています。

6. 考察 (Discussion)

論文の考察セクションでは、研究成果が持つ意義と今後の展望について議論されています。

マルチモーダル認識の統合により、AMIEが従来のテキストのみの評価で確立された高い診断精度と会話品質を維持できたことが強調されています。特に、OSCE評価では、より現実的で難易度の高いシナリオにおいても、診断精度、共感性、明確さ、問診能力などの点でPCPを上回るか同等以上の結果が得られました。

重要な点は、基盤モデルのマルチモーダル能力を、診断会話の動的な流れの中に効果的に組み込めたことです。これは、ステートアウェアな推論フレームワークによって実現され、マルチモーダルデータを会話の中盤で扱いつつ、臨床的に適切で共感的な対話を維持することを可能にしました。このようなテキスト以外の情報処理・統合能力は、現実世界のテレヘルスアプリケーションにおいてAIシステムが信頼性高く機能するために不可欠です。

AMIEは、マルチモーダルアーティファクトの取り扱いと推論において顕著な能力を示しました。専門医は、アーティファクトへの関与、単体での解釈、そしてアーティファクトに基づいた推論において、AMIEにPCPよりも高い評価を与えました。患者役も、アーティファクトに関する質問意図への対応と、視覚的証拠から得られた所見の説明において、AMIEを高く評価しました。これは、AMIEの系統的かつ明示的な説明方法が、患者にとって価値がある可能性を示唆しています。

本研究では、強力な汎用基盤モデル(Gemini 2.0 Flash)を、ドメイン特化型の推論時戦略(ステートアウェアフレームワーク)で強化するアプローチが成功しました。これは、モデルの訓練時ではなく、推論時にカスタマイズを行うことで高い効果を得られることを示しています。

ただし、重要な点として、本研究の結果はシミュレーション環境でのものであり、実際の医療現場への適用にはさらなる研究が不可欠であると述べられています。AMIEはまだ研究段階のシステムであり、このまま臨床現場で使用されることを意図したものではないことが強調されています。実際のヘルスケア環境の複雑さと制約の下での性能、安全性、信頼性を厳格に評価し、臨床ワークフローや患者アウトカムへの潜在的な影響を理解することが今後の課題とされています。責任ある開発と継続的な検証が極めて重要です。

7. 結論 (Conclusion)

最後に、本論文は、対話型診断AIにおけるマルチモーダル推論の統合という主要な課題に取り組んだ成果としてまとめられています。AMIEは、ステートアウェアな推論手法とGemini 2.0 Flashの能力を活用し、会話の状況と診断の進化に基づいて医療アーティファクトを戦略的に要求、解釈、推論する能力を獲得しました。

マルチモーダルなテキストベースOSCEという厳格な評価において、AMIEは現役のPCPと同等またはそれ以上の性能、特にマルチモーダルデータの取り扱いと推論、診断精度、そして全体のコンサルテーション品質において高い能力を示しました。

現実世界への臨床応用にはさらなる研究が必要ですが、本研究の成果は、より包括的で現実的な臨床対話が可能なAIシステム開発に向けた大きな一歩となることを示唆しています。

その他の補足情報

- 本研究で使用された一部のデータセット(SCIN, PAD-UFES-20, PTB-XL, ECG-QA)は公開されています。臨床文書データセット(ClinicalDoc-QA)は、この研究のために作成された非特定化された臨床記録に基づいています。

- システムの実装はGoogle内部のインフラストラクチャに依存しており、医療分野でのAIシステムの無許可での展開に伴う安全性の問題から、コードベースや特定のプロンプトは現時点では非公開となっています。

- 本研究はAlphabet Incおよび/またはその子会社から資金提供を受けています。

まとめ

本論文は、単にテキストを処理するだけでなく、画像や文書といった多様なデータ形式を診断会話に組み込むという、医療AIの次のステップを示しています。

特に、患者の状態や情報収集の進捗に合わせて対話の流れをコントロールする「ステートアウェアなフレームワーク」は、AIが単なる応答システムではなく、医療従事者のような思考プロセスを模倣しようとする高度な設計思想が感じられます。マルチモーダルデータの解釈能力と、それを会話の中で活用する能力の両方が、AIの診断能力向上に寄与していることが、OSCE評価やアブレーションスタディによって明確に示されました。

もちろん、論文の著者自身も強調しているように、これはまだ研究段階であり、実際の医療現場で安全かつ効果的に利用されるには、さらなる検証と開発が必要です。倫理的な側面や、多様な医療環境への適応、既存の医療システムとの連携など、クリアすべき課題は多くあります。

しかし、医療アクセスが限られる地域があったり、医師の負担が増大している現状を考えると、このようなAI技術の進化は、将来の医療を支える重要な鍵となる可能性を秘めています。