はじめに

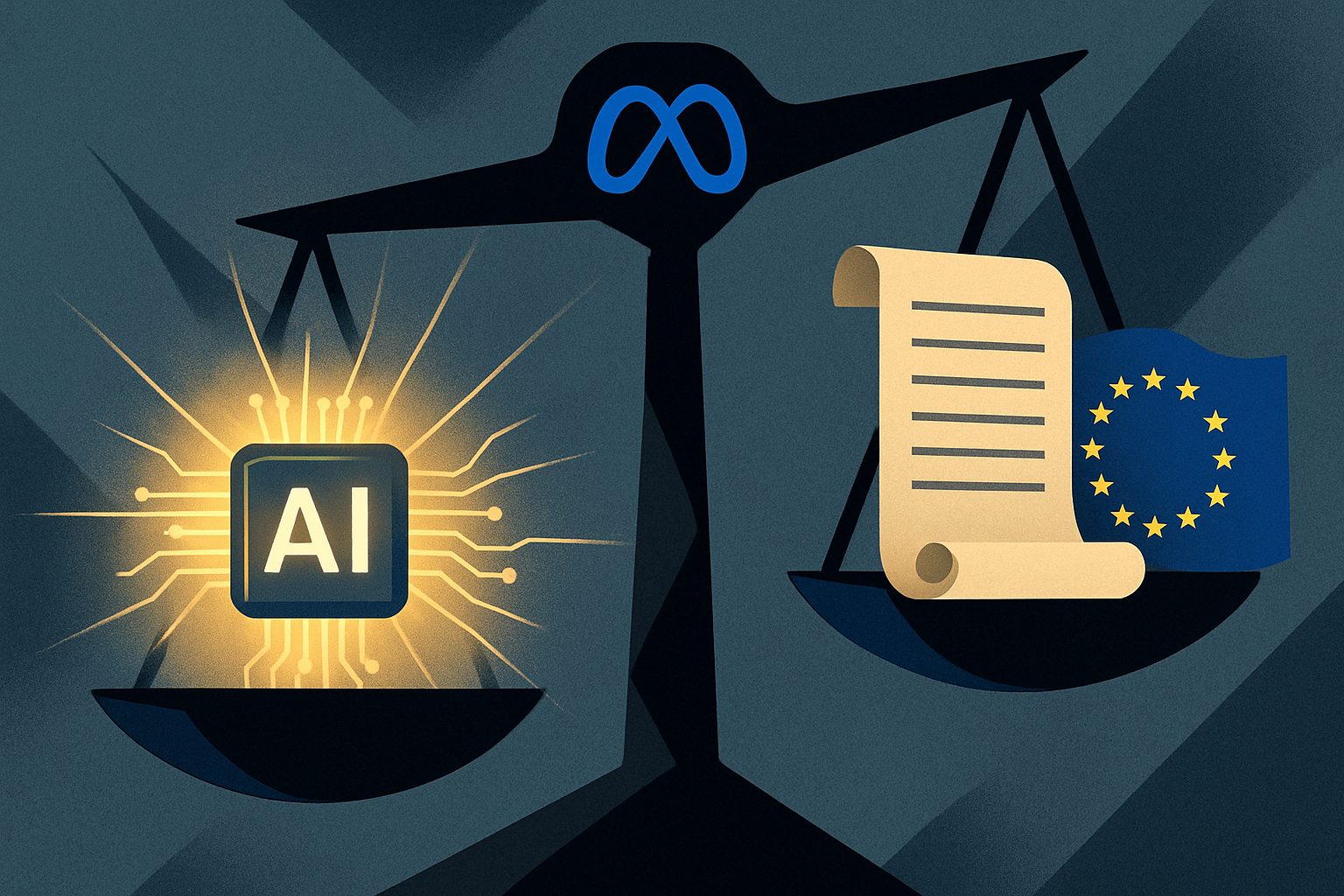

本稿では、Meta社(旧Facebook)が、欧州連合(EU)が新たに導入するAI規制の重要な一部である「行動規範」への署名を拒否したというニュースについて、その背景と意味を深く掘り下げて解説します。この決定は、AI技術の発展と規制のバランスをめぐる世界的な議論において、非常に象徴的な出来事と言えます。

参考記事

- 発行元: TechCrunch

- タイトル: Meta refuses to sign EU’s AI code of practice

- 発行日: 2025年7月18日

- URL: https://techcrunch.com/2025/07/18/meta-refuses-to-sign-eus-ai-code-of-practice/

- 発行元: CNBC

- タイトル: Meta says it won’t sign Europe AI agreement, calling it an overreach that will stunt growth

- 発行日: 2025年7月18日

- URL: https://www.cnbc.com/2025/07/18/meta-europe-ai-code.html

要点

- Meta社は、EUの「AI行動規範」への署名を公式に拒否した。

- その理由は、行動規範が法的 incertidumbre を生み、AI法の範囲を超えた「行き過ぎ」な規制であり、欧州のAI開発とビジネスの成長を阻害するとの懸念からである。

- EUの「AI法」とは、AIの利用をリスクレベルに応じて分類し、規制する世界初の包括的な法律である。

- Metaが拒否した「行動規範」は、このAI法を企業が遵守しやすくするための自主的な枠組みである。

- AI業界内では意見が分かれており、OpenAIは署名を約束する一方、MicrosoftやGoogleなど他の多くのテック企業もMetaと同様の懸念を示している。

詳細解説

何が起きたのか?Metaの「署名拒否」という決断

2025年7月18日、Meta社のグローバルアフェアーズ責任者であるジョエル・カプラン氏は、「欧州はAIに関して間違った道に進んでいる」と述べ、EUが提示した「AI行動規範」に署名しない意向を明確にしました。Meta社は、この行動規範が「モデル開発者に多くの法的な不確実性をもたらす」だけでなく、「AI法の範囲をはるかに超える措置」を含んでいると主張しています。これは、AI規制をリードしようとするEUに対し、業界の巨大プレイヤーが公然と異議を唱えた形となり、大きな注目を集めています。

そもそも「EU AI法」とは何か?

今回のニュースを理解する上で欠かせないのが、背景にある「EU AI法(EU AI Act)」です。これは、世界で初めてAIに特化した包括的な法律であり、その目的は「安全で信頼できるAI」の普及です。この法律の最大の特徴は、「リスクベースのアプローチ」を採用している点にあります。AIの利用方法を、社会や人々に与えるリスクの高さに応じて4つのカテゴリーに分類し、それぞれ異なる規制を課します。

- 許容できないリスク(禁止): サブリミナル(潜在意識への)操作や、政府による市民の格付け(社会的スコアリング)など、人権を脅かすと見なされるAIの利用は全面的に禁止されます。

- 高リスク: 採用活動、医療診断、自動運転、重要インフラなど、人々の安全や権利に大きな影響を与える可能性のあるAIシステムです。これらには、高品質なデータセットの使用、人間の監督、高いレベルのセキュリティ確保など、厳格な義務が課せられます。

- 限定的なリスク: チャットボットやディープフェイクなど、AIが生成したコンテンツであることをユーザーが認識する必要があるシステムです。これらには、AIと対話していることを明かすなどの透明性の義務が求められます。

- 最小限のリスク: 上記以外(ビデオゲームやスパムフィルターなど)のほとんどのAIアプリケーションです。これらには特別な法的義務は課されません。

このようにEU AI法は、AIの危険性を一括りにするのではなく、用途に応じてきめ細かく対応しようとするものです。

Metaが拒否した「AI行動規範」とは?

では、Metaが署名を拒否した「行動規範(Code of Practice)」とは何でしょうか。これはAI法そのものではなく、法律の要件、特に「高リスク」に分類されない「汎用AIモデル(GPAI)」の提供者が、AI法を円滑に遵守できるよう支援するためにEUが作成した自主的な枠組みです。汎用AIモデルとは、OpenAIのGPTシリーズやMetaのLlamaシリーズのように、特定の目的に限定されず、多様なタスクを実行できる基盤的なAIモデルを指します。

この行動規範には、AIモデルの能力や限界に関する詳細な文書を定期的に更新することや、著作権で保護されたコンテンツ(海賊版など)を学習データとして使用しないことなどが盛り込まれています。Metaは、これらの要求が法律本体の範囲を超えており、事実上の規制強化につながる「行き過ぎ」だと批判しているのです。

なぜMetaは強く反発するのか?

Metaの反発の根底には、規制がイノベーションを阻害するという強い懸念があります。特にMetaは、自社開発した大規模言語モデル「Llama」をオープンソース(設計図を無償で公開すること)で提供しており、世界中の開発者が自由に利用・改良できるエコシステムの構築を目指しています。

しかし、行動規範のような厳しいルールが課せられると、開発プロセスは複雑になり、スピードも鈍化します。特に「法的な不確実性」は、開発者にとって大きなリスクとなります。どこまでの対応が求められるのかが不明確なままでは、新しい挑戦に踏み出しにくくなるのです。Metaは、こうした規制が結果的に欧州における最先端AIの開発を遅らせ、AIを基盤とした新しいビジネスの芽を摘んでしまうと主張しています。

AI業界の反応と今後の展望

AI業界の反応は一枚岩ではありません。Metaと同様に、GoogleやMicrosoft、さらには欧州の主要企業であるASMLやAirbusなども規制への懸念を示しています。一方で、ChatGPTを開発したOpenAIは、この行動規範への署名を約束しており、対照的な姿勢を見せています。この違いは、クローズドなモデルでビジネスを展開するOpenAIと、オープンソース戦略を推進するMetaとの企業戦略の違いも影響していると考えられます。

EUのAI法における汎用AIモデルに関する規則は、2025年8月初旬に発効し、対象となる企業は2027年8月までに法を完全に遵守する必要があります。Metaの署名拒否は、この自主的な枠組みの実効性に疑問を投げかけるものです。今後、EUと巨大テック企業との間で、AIの未来を形作るためのルール作りをめぐる駆け引きがさらに激化することが予想されます。

まとめ

今回、Meta社がEUのAI行動規範への署名を拒否したことは、単なる一企業の決定に留まりません。これは、「AI技術の急速なイノベーション」と「社会の安全と倫理を守るための規制」という、二つの重要な価値をいかに両立させるかという、現代社会が直面する大きな課題を象徴する出来事です。

EUのAI法は、信頼できるAI社会の実現に向けた野心的な試みですが、その運用方法を誤れば、Metaが懸念するようにイノベーションの火を消しかねません。この対立は、私たち日本にとっても、将来のAI規制のあり方を考える上で非常に重要な示唆を与えてくれます。今後、テクノロジー企業と規制当局がどのように対話し、妥協点を見出していくのか、その動向を注意深く見守る必要があります。