はじめに

近年、大規模言語モデル(LLM)は目覚ましい進化を遂げていますが、依然として解決が難しい課題の一つに「ハルシネーション(Hallucination)」があります。これは、モデルが事実に基づかない情報を、もっともらしく自信を持って生成する現象を指します。なぜこのようなことが起こるのでしょうか。

本稿では、OpenAIが2025年9月5日に公開した記事「Why language models hallucinate」を基に、ハルシネーションが起こる根本的な原因と、その解決に向けたアプローチについて紹介します。

参考記事

- タイトル: Why language models hallucinate

- 発行元: OpenAI

- 発行日: 2025年9月5日

- URL: https://openai.com/index/why-language-models-hallucinate/

※より詳細に理解されたい方

要点

- 言語モデルのハルシネーションは、現在の標準的な訓練および評価方法に起因する。

- 多くの評価指標が「正答率」を過度に重視するため、モデルは不確実な問いに対して「わからない」と回答するよりも、「推測してでも回答する」方がスコア上有利になる。

- この「推測」が、もっともらしいが誤った情報、すなわちハルシネーションを生み出す根本的なメカニズムである。

- ハルシネーションはAIの神秘的な欠陥や不可避な現象ではなく、評価の仕組みを「正直さ」を奨励するように変更することで抑制可能である。

詳細解説

ハルシネーションとは何か?

ハルシネーションとは、AIが「もっともらしいが、事実とは異なる情報」を生成する現象です。あたかも人間が幻覚を見ているかのように、存在しない事実を語ることからこのように呼ばれています。

OpenAIの発表では、論文の著者の一人であるアダム・タウマン・カライ氏の博士論文のタイトルをチャットボットに尋ねたところ、自信満々に3つの異なる間違ったタイトルを生成した、という例が挙げられています。このように、一見簡単そうな質問に対しても、ハルシネーションは起こり得ます。これは、AIが「知らない」という状態を認識できず、手持ちの情報から最もそれらしい答えを創作してしまうために発生します。

問題の核心:テストで高得点を取るための「推測」

では、なぜモデルは「知らない」と正直に答えず、推測してしまうのでしょうか。OpenAIは、その原因が現在のAIの評価方法にあると指摘します。

多くのAI性能評価は、学校のテストのように「どれだけ多くの問題に正解できたか(正答率)」を主な指標としています。この仕組みでは、わからない問題に対して「わかりません」と答えると0点ですが、当てずっぽうで答えて偶然正解すれば得点になります。そのため、AIは不確実な場合でも、推測して何かを答える戦略を取るように学習してしまいます。

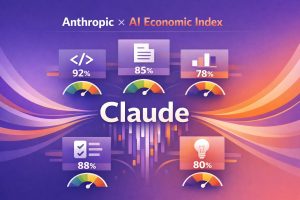

記事では、性能評価の具体的な例として、2つのモデルの比較データを提示しています。

| 評価指標 | gpt-5-thinking-mini | OpenAI o4-mini |

| 棄権率(具体的な回答をしない) | 52% | 1% |

| 正答率(高いほど良い) | 22% | 24% |

| 誤答率(低いほど良い) | 26% | 75% |

この表を見ると、旧モデルである「o4-mini」は正答率がわずかに高いですが、その一方で誤答率(ハルシネーションの割合)が75%と極めて高いことがわかります。これは、o4-miniが不確かな質問に対しても積極的に「推測」で回答し、正答率を稼いでいる結果です。現在の評価リーダーボードでは、このようなモデルの方が優秀だと見なされがちなのです。

ハルシネーションはどこから生まれるのか?

ハルシネーションの起源は、言語モデルの基本的な学習プロセスである「事前学習(pretraining)」にまで遡ります。モデルは、インターネット上の膨大なテキストデータを読み込み、「次の単語」を予測する訓練を繰り返すことで言語能力を獲得します。

この学習データには、一つひとつの文章が「正しい」か「間違い」かというラベルは付いていません。モデルは流暢な文章のパターンをひたすら学習します。その結果、スペルや文法のような一貫したルールは非常にうまく習得できます。

しかし、「特定の人物の誕生日」のような、文脈だけでは予測不可能な低頻度の事実は、パターンとして学習することが困難です。そのため、モデルは関連情報から最もそれらしい日付を「創作」してしまい、これがハルシネーションの原因となるのです。

OpenAIが提案する解決策

この問題に対し、OpenAIは解決策は単純だと述べています。それは、評価のルールを変えることです。

- 誤答へのペナルティ強化:自信を持って間違った回答をした場合に、より大きな減点を行う。

- 不確実性の表明を評価:「わかりません」と正直に回答したことを、単なる0点ではなく、部分点を与えるなどして適切に評価する。

重要なのは、ハルシネーションを測るための新しい評価指標をいくつか追加するだけでは不十分だという点です。AI開発の現場で広く使われている主要な評価指標そのもののスコアリング方法を、推測を抑制し、正直さを奨励するように作り直す必要があるとOpenAIは主張しています。

まとめ

本稿では、OpenAIの記事を基に、言語モデルのハルシネーションがなぜ起こるのかを解説しました。ハルシネーションは、AIの神秘的な欠陥ではなく、「正答率」を偏重する現在の評価方法が、モデルに「推測」を促してしまう」という、極めて合理的なメカニズムによって発生します。

この問題提起は、私たちがAIの性能をどのように測り、どのようなAIを目指すべきかという根本的な問いを投げかけています。より信頼性の高いAIを開発するためには、単にモデルの能力向上を追求するだけでなく、その「正直さ」や「慎重さ」をいかに正しく評価し、導いていくかという視点が不可欠になるでしょう。