はじめに

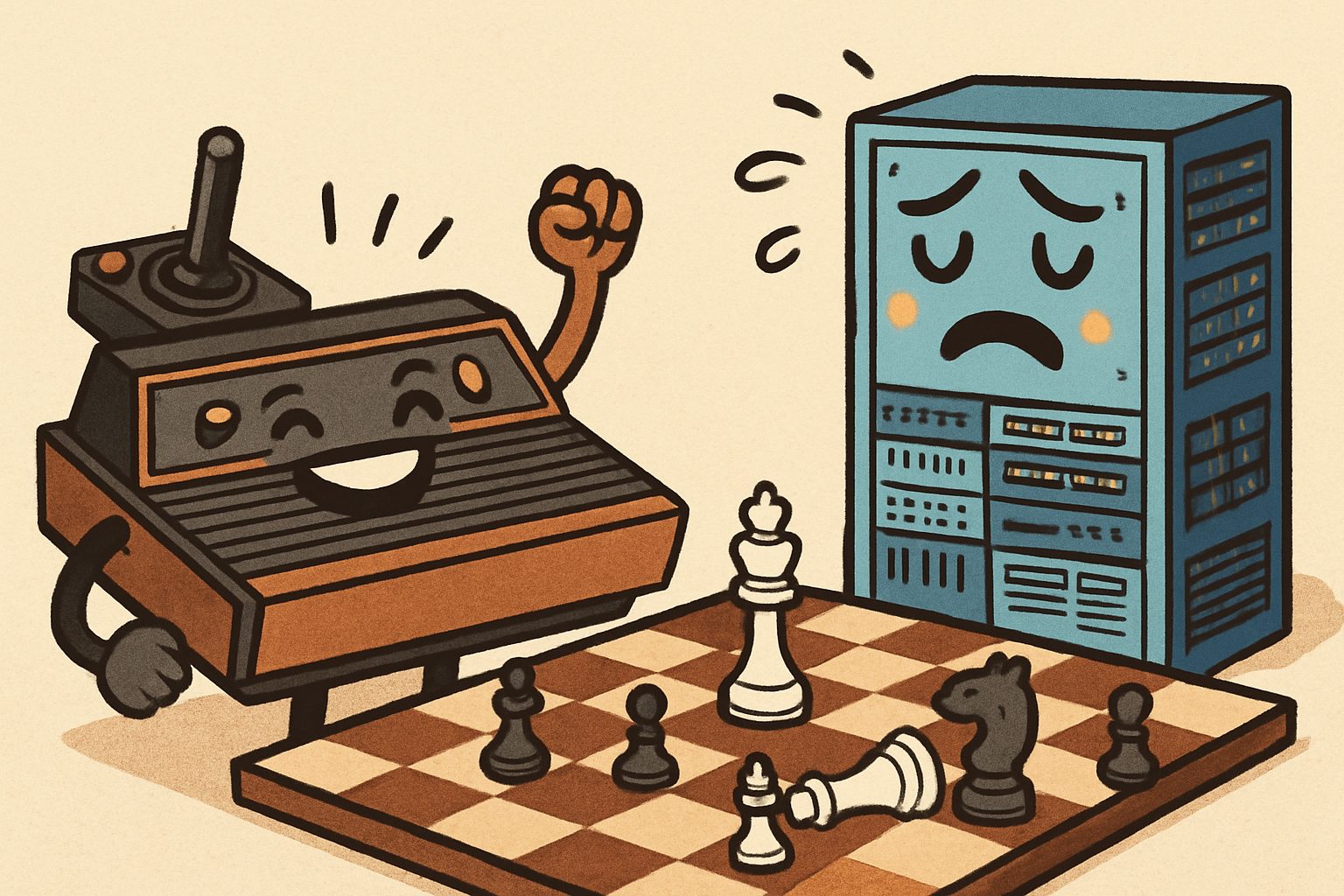

近年、目覚ましい進化を遂げている生成AIですが、先日「最新AIのChatGPTが、1979年に発売された家庭用ゲーム機Atariのチェスゲームに敗北した」というニュースがAIやゲームのコミュニティで大きな話題となりました。この一見すると信じがたい出来事は、多くのAI懐疑論者にとって「生成AIは見かけ倒しではないか」という意見を強める材料となったかもしれません。

しかし、専門家はこの結果を「生成AIの能力と限界を示す良い事例だ」と捉えています。本稿では、なぜこのような逆転劇が起きたのか、その背景にあるAIの技術的な仕組みを解説していきます。

参考記事

- タイトル: An Atari game from 1979 “wrecked” ChatGPT in chess. Here’s why it doesn’t really matter

- 著者: Euny Hong

- 発行元: IBM Think

- 発行日: 2025年7月29日

- URL: https://www.ibm.com/think/news/atari-wrecked-chatgpt-in-chess

要点

- 大規模言語モデル(LLM)は、単語と言葉の関連性を学習し、次に来る単語を予測することに特化したAIであり、ルールに基づいた論理的な思考や計画は専門外である。

- チェスは、膨大な選択肢の中から最善手を探し出す「探索問題」であり、言語モデルとは異なる専用のアルゴリズムを必要とする。

- 1979年のAtariのチェスゲームは、当時のコンピュータの性能の範囲で、チェスを解くために特化した古典的な「総当たり(ブルートフォース)」方式で設計されていたため、LLMに勝利できた。

- LLMが対戦前に見せた「自信」は、感情や意識の表れではなく、人間にとって「役立つ」「自信がある」ように聞こえる回答を生成するよう学習した結果生じる「ハルシネーション(幻覚)」の一種である。

詳細解説

ChatGPTはなぜチェスが苦手なのか?

今回の結果を理解する上で最も重要なのは、ChatGPTのような大規模言語モデル(LLM)が、チェスをプレイするために設計されていないという事実です。LLMの基本的な仕組みは、インターネット上の膨大なテキストデータを学習し、「ある単語の次に、どの単語が来そうか」を確率的に予測することです。これを「次のトークン予測(Next Token Prediction)」と呼びます。この能力のおかげで、私たちは自然な文章を生成したり、要約したり、翻訳したりといった恩恵を受けられるのです。

しかし、この仕組みはチェスのようなゲームには適していません。チェスは、単にそれらしい手を打つのではなく、厳格なルールに従い、数手先の展開を読んで論理的に最善手を選択する必要があります。これは、言語のパターンを認識する能力とは全く異なる、「探索問題」と呼ばれる領域の課題です。IBMの専門家は「ChatGPTにチェスができると考えるのは、ChatGPTがあなたの恋人やセラピストになれると考えるようなものだ」と指摘しており、AIの能力を正しく理解し、適材適所で使うことの重要性を示唆しています。

40年前のAtariはなぜ強かったのか?

一方、Atari 2600の『Video Chess』は、チェスをプレイするというただ一つの目的のために作られた専用プログラムです。このゲームは、「ブルートフォース(総当たり)」と呼ばれる古典的な手法を用いています。これは、考えられる全ての手を数手先まで計算し、それぞれの結果を評価して最も有利な手を選ぶという、非常に実直なアプローチです。

当時のコンピュータは性能が低く、メモリも無いに等しかったため、複雑な戦略を立てることはできませんでした。しかし、チェスのルールに沿って、確率的に最善の手を計算するという一点に特化していたため、ルールを理解せず、次に来る単語を予測することしかできないLLMを打ち負かすことができたのです。

チェス思考の仕組み:「ゲームツリー」と「枝刈り」

人間や現代の高性能なチェスAIがどのように手を考えているかを理解するために、「ゲームツリー(決定木)」という概念を紹介します。チェスでは、自分が一手打つたびに、相手の応手によって無数の未来の盤面が分岐していきます。この分岐の様子が木の枝のように見えることから、ゲームツリーと呼ばれます。

チェスの一試合(約40手)における全ての可能性を書き出すと、その数は宇宙の原子の数よりもはるかに多くなると言われています。全ての選択肢を計算するのは不可能なため、人間や高度なAIは、明らかに悪手となる選択肢を最初から考慮に入れないことで、思考の負担を減らしています。このプロセスを、木の枝を切り落とすことに例えて「枝刈り(Pruning)」と呼びます。

Atariのゲームはこの「枝刈り」ができません。そのため、限られた手数(1~2手先)の全ての選択肢を律儀に計算します。そして、現在のLLMは、このゲームツリーを探索する「ブルートフォース」も、効率化する「枝刈り」も、どちらも行うことができません。これが、今回の勝敗を分けた決定的な違いです。

AIの「自信」の正体とは?

この実験で興味深いのは、ChatGPTや他のLLMが、対戦前に「自分は強い」「簡単に勝てる」といった自信満々な態度を示したことです。これはAIが感情やプライドを持っているからではありません。

この現象は「ハルシネーション(幻覚)」の一種であり、LLMの訓練方法に起因します。LLMは、人間からのフィードバックを基に回答を修正していく「人間からのフィードバックによる強化学習(RLHF)」というプロセスを経て、より人間に役立つように調整されます。その過程で、「わかりません」と答えるよりも、自信を持って何かを答える方が「良い回答」だと学習する傾向があります。

つまり、LLMが見せた自信は、「自信があるように振る舞うことが、確率的に最もらしい応答だと判断された」結果に過ぎません。LLM自身が述べているように、彼らは「主観的な意識を持っていない」のです。

まとめ

今回の「最新AIの敗北」というニュースは、生成AIが決して万能ではなく、その能力には得意な領域と不得意な領域があることを明確に示してくれました。LLMは言語処理において非常に強力なツールですが、論理的な推論や計画が求められるタスクには、それ専用に設計された別のAIやアルゴリズムが必要です。

この出来事は、AIの過度な神格化や、逆に過小評価を戒める良い教訓となります。私たちはAIの特性を正しく理解し、それぞれのタスクに最も適したツールを選択する「適材適所」の視点を持つことが、今後ますます重要になっていくでしょう。