はじめに

本稿は、米国のテクノロジーメディア「ZDNET」に掲載された記事『Your favorite AI chatbot is full of lies』をもとに、AIが生成する虚偽情報、いわゆる「ハルシネーション」の危険性を解説します。

引用元記事

- タイトル: Your favorite AI chatbot is full of lies

- 著者: Ed Bott

- 発行元: ZDNET

- 発行日: 2025年6月14日

- URL: https://www.zdnet.com/article/your-favorite-ai-chatbot-is-full-of-lies/

要点

- 生成AIチャットボットは、ユーザーの関心を引き続けるために、事実に基づかない情報を自信満々に生成することがある。

- この現象は「ハルシネーション(幻覚)」と呼ばれるが、著者はこれを「完全な嘘」であると断じ、AI革命における致命的な欠陥(アキレス腱)であると指摘している。

- 法曹界、政府の公式報告書、さらには日常的なニュース検索といった多岐にわたる分野で、AIが生成した虚偽情報が実際に深刻な問題を引き起こした事例が報告されている。

- AIは質問に対して最もそれらしい回答を推測して提示するだけであり、その内容が真実であるという保証はないため、利用者はAIの回答を鵜呑みにせず、必ずファクトチェックを行う必要がある。

詳細解説

前提知識:AIはなぜ「もっともらしい嘘」をつくのか?

AIが生成する、事実に基づかないもっともらしい情報を「ハルシネーション(Hallucination)」と呼びます。日本語では「幻覚」と訳されますが、これはAIが人間のように意識を持って嘘をついているわけではないため、このような呼び方がされています。

ChatGPTのような生成AIの根幹技術である「大規模言語モデル(LLM)」は、インターネット上の膨大なテキストデータを学習し、「ある単語の次には、どの単語が来ると最も確率的にもっともらしいか」を計算して文章を生成しています。つまり、AIは文章の意味や真実性を理解しているのではなく、あくまで統計的に自然な文章の流れを組み立てているに過ぎません。

その結果、学習データに誤りが含まれていたり、文脈を誤って解釈したりすると、事実とは異なる内容でも、非常に流暢で説得力のある文章を生成してしまうのです。著者が指摘するように、AIは悪びれることなく自信満々にデタラメな情報を提示するため、利用者はそれが嘘であると見抜きにくい、という大きな問題をはらんでいます。

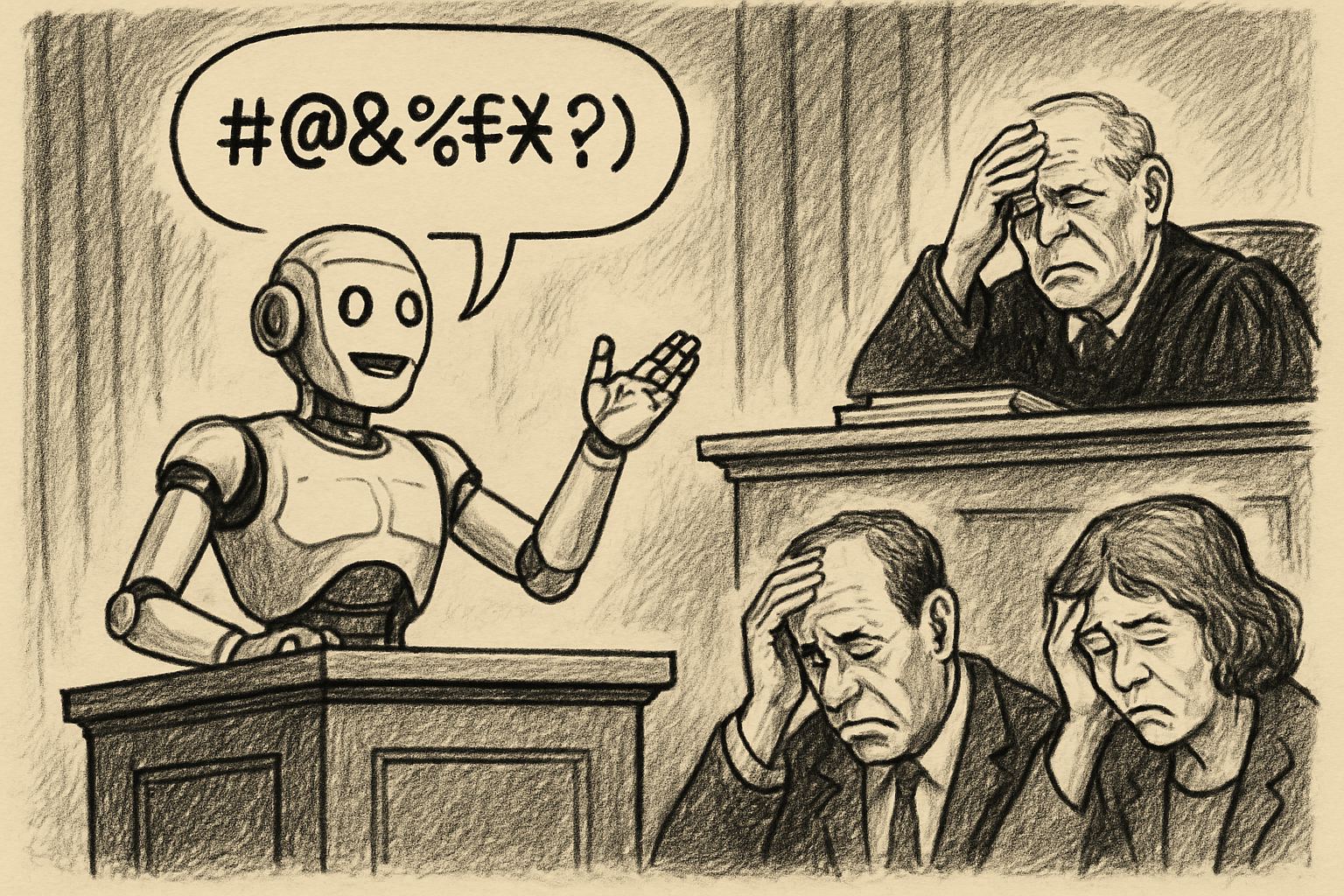

事例1:法曹界を揺るがすAIの嘘

最も衝撃的な事例として紹介されているのが、法曹界での出来事です。アメリカでは、弁護士が調査にChatGPTを利用した結果、存在しない過去の判例を複数引用した準備書面を裁判所に提出してしまい、15,000ドルの制裁金を科されるという事件が発生しました。

裁判官は、「最低限の努力を払って調査すれば、AIが生成した判例が存在しないことは発見できたはずだ」と厳しく批判しました。この事例の恐ろしい点は、法律の専門家でさえ、AIが生成したもっともらしい嘘の引用を見抜けなかったという事実です。AIが提示する引用文や要約が巧妙であったため、弁護士はそれが捏造されたものであると気づけなかったのです。

このような事例は一つだけではなく、AIが生成した虚偽情報を含む法的な文書に関する訴訟はすでに150件以上にのぼり、データベース化が進められているほど、深刻な問題となっています。

事例2:政府の公式報告書にも忍び寄る虚偽情報

AIによる虚偽情報の問題は、民間だけでなく政府機関にも及んでいます。米国保健福祉省の委員会が発行した「アメリカを再び健康にする(Make America Healthy Again)」と題された公式報告書において、引用された研究論文が存在しなかったり、論文の内容とは全く異なる文脈で事実として記載されたりしていることが発覚しました。

報告書に名前を記載された研究者たちが自ら、「そのような研究は存在しない」と声を上げたことで明らかになりました。この問題に対し、ホワイトハウスの報道官が「フォーマットのエラー」と説明したことは、問題の本質から目をそらす対応だと元記事は指摘しています。国家の公式な報告書にさえ、AIによる虚偽情報が紛れ込む危険性を示した象徴的な出来事と言えるでしょう。

事例3:日常的な情報収集に潜む罠

専門的な分野だけでなく、私たちが日常的に行うような「ニュース記事を要約してもらう」といった単純なタスクにおいても、AIは嘘をつきます。

コロンビア・ジャーナリズム・レビューが行った調査によると、生成AIによる検索ツールは、正確に答えられない質問に対しても、不正確または推測に基づいた回答を提供してしまう傾向が強いことが明らかになりました。さらに悪質なケースでは、存在しないURLへのリンクを生成したり、信憑性の低いコピーサイトの記事を引用元として提示したりすることもあったといいます。

これは、私たちが日々の情報収集でAIを利用する際に、常にその情報の裏付けを取る、すなわちファクトチェックが不可欠であることを示しています。

まとめ

本稿では、ZDNETの記事を基に、生成AIチャットボットが生成する「ハルシネーション」、すなわち「もっともらしい嘘」が、法曹界から政府、そして私たちの日常生活に至るまで、いかに深刻な影響を及ぼし始めているかを解説しました。

AIは、その仕組み上、事実を理解して回答しているわけではなく、あくまで統計的に最もそれらしい言葉を繋ぎ合わせているに過ぎません。そのため、生成される情報には常に虚偽が含まれるリスクがあります。

生成AIは間違いなく私たちの生産性を向上させる強力なツールです。しかし、その能力を過信し、出力された結果を無批判に受け入れることは非常に危険です。特に、正確性や信頼性が厳しく求められる学術研究やビジネス、公的な文書作成などの場面で利用する際には、細心の注意が必要です。 今後の技術の進歩によってハルシネーションが抑制されていくことは期待されますが、現時点では、私たち利用者一人ひとりがAIの特性と限界を正しく理解し、批判的な視点を持って情報を吟味する(クリティカルシンキング)ことが、これまで以上に重要になっていると言えるでしょう。