はじめに

本稿では、MIT Newsが2025年6月3日に公開した記事「Teaching AI models what they don’t know」をもとに、AIの「信頼性」という課題に対して、AIが自身の知識の限界や不確実性をどのように認識し、それをどう克服していくのかという点について、マサチューセッツ工科大学(MIT)の研究者たちが設立したThemis AIの取り組みを紹介します。

引用元記事

- タイトル: Teaching AI models what they don’t know

- 発行元: MIT News

- 発行日: 2025年6月3日

- URL: https://news.mit.edu/2025/themis-ai-teaches-ai-models-what-they-dont-know-0603

要点

- ChatGPTのようなAIシステムは、もっともらしい回答を生成するが、自身の知識のギャップや不確実性を常に示すわけではない。これは、医薬品開発や自動運転など、重大な結果を招きかねない分野でのAI利用において大きな問題となる。

- MIT発のスタートアップThemis AIは、AIモデルの不確実性を定量化し、問題が大きくなる前に出力を修正するプラットフォーム「Capsa」を開発した。

- Capsaは、既存の機械学習モデルに適用でき、データ処理のパターンから曖昧さ、不完全さ、バイアスを検出するようにモデルを修正することで、信頼性の低い出力を数秒で特定し、修正する。

- Themis AIは、この技術を用いて、通信、石油・ガス、製薬、大規模言語モデル(LLM)の信頼性向上など、多様な産業でのAI活用を支援している。

- AIが「知らないこと」を自覚し、その限界を示すことは、AIの誤りによる壊滅的な結果を未然に防ぎ、より安全で信頼できるAIの実現に不可欠である。

詳細解説

AIが抱える「知らないこと」の問題

近年、ChatGPTに代表される生成AIは、人間と自然な対話ができたり、創造的な文章を生成したりと、目覚ましい進歩を遂げています。しかし、これらのAIは、まるで何でも知っているかのように振る舞う一方で、自身の知識の限界や、回答に対する確信度を常に明確に示すわけではありません。この「知らないことを知らない」あるいは「知らないことを示さない」という特性は、AIが誤った情報や偏った見解を、さも真実であるかのように提示してしまう「ハルシネーション(幻覚)」と呼ばれる現象を引き起こす一因となります。

例えば、AIが医療診断の補助、金融取引の判断、あるいは自動運転車の制御といった、人命や社会システムに大きな影響を与える可能性のある領域で利用される場合、AIの出力が不確かであったり、誤っていたりすると、その結果は計り知れません。したがって、AI自身が「この情報には自信がない」「この判断は不確かだ」と認識し、それをユーザーに伝えられる能力は、AIを安全かつ有効に活用する上で極めて重要になります。

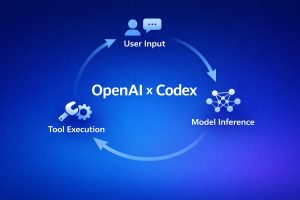

Themis AIと「Capsa」プラットフォーム

このような課題に対処するため、MITの研究者たちはThemis AIという会社を設立し、「Capsa」という画期的なプラットフォームを開発しました。Themis AIの共同設立者であり、MITコンピュータ科学・人工知能研究所(CSAIL)の所長でもあるダニエラ・ラス教授は、「私たちの目標は、モデルをCapsaで包み込み、モデルの不確実性や故障モードを特定し、そしてモデルを強化することです」と述べています。

Capsaの核心的な機能は、あらゆる機械学習モデル(特定の種類のAIアルゴリズム)に適用可能であるという点です。Capsaは、AIモデルがデータを処理する際のパターンを分析し、そこに曖昧さ、不完全さ、あるいは訓練データに潜むバイアス(偏り)がないかを検出するように、元のAIモデルを修正します。これにより、AIモデルは自身の出力が信頼性に欠ける可能性を「自覚」し、それを報告することができるようになります。このプロセスは非常に高速で、数秒のうちに信頼できない出力を特定し、場合によっては修正まで行うことができます。

Themis AIの共同設立者であるアレクサンダー・アミニ氏は、「私たちは、あらゆる産業の最もリスクの高いアプリケーションでAIを可能にしたいと考えています。AIがハルシネーションを起こしたり、間違いを犯したりする例を誰もが見てきました。AIがより広範に展開されるにつれて、それらの間違いは壊滅的な結果につながる可能性があります。Themisは、AIが自身の失敗を、それが起こる前に予測し、予見することを可能にします」と強調しています。

Capsaの技術的背景と応用事例

Themis AIの技術は、ラス教授の研究室で長年行われてきたモデルの不確実性に関する研究に基づいています。例えば、研究チームは過去に、顔認識システムにおける人種的・性別的バイアスを検出し、モデルの訓練データを自動的に再重み付けすることでバイアスを排除するアルゴリズムを構築しました。このアルゴリズムは、訓練データ内の代表性の低い部分を特定し、それに類似した新しいデータサンプルを生成してバランスを取るというものでした。

このような「データセットの不均衡や偏りを是正する」というアプローチは、Capsaの設計思想にも通じるものがあります。Capsaは、AIモデルが学習したデータの中に、判断の根拠となる十分な証拠があるのか、それとも単なる推測に過ぎないのかを見極める手助けをします。

Themis AIは、Capsaプラットフォームを様々な分野で活用しています。

- 通信業界: ネットワークの計画や自動化を支援。

- 石油・ガス業界: AIを用いた地震画像の解析精度を向上。

- 製薬業界: AIモデルを用いた新薬候補の特性予測や臨床試験での性能予測を改善。これは、薬剤開発のコスト削減と期間短縮に大きく貢献する可能性があります。アミニ氏は、「Capsaは、予測が訓練セットの証拠に裏付けられているのか、それとも根拠の薄い単なる推測なのかを理解するための洞察を即座に提供できます。これにより、最も強力な予測の特定を加速でき、社会にとって大きな可能性を秘めていると考えています」と述べています。

- 大規模言語モデル(LLM): 企業が自社データに基づいてLLMを構築・利用する際の信頼性向上を支援。LLMが自身の回答に対する確信度や不確実性を自己報告できるようにすることで、より信頼性の高い質疑応答や、不確かな出力へのフラグ立てが可能になります。

- エッジコンピューティング: スマートフォンや組み込みシステムなど、クラウド環境外で動作するAIソリューションの精度向上。Themis AIの技術責任者であるスチュワート・ジェイミソン氏は、「通常、これらの小型モデルはサーバー上で実行できるものと比較してあまり正確ではありませんが、私たちは両方の長所を得ることができます。つまり、品質を犠牲にすることなく、低遅延で効率的なエッジコンピューティングが実現できます」と説明しています。将来的には、エッジデバイスがほとんどの処理を行い、不確実な場合のみ中央サーバーにタスクを転送するような仕組みも構想されています。

「連鎖的思考(Chain-of-Thought)」への応用

さらにThemis AIは、Capsaが「連鎖的思考(Chain-of-Thought)推論」と呼ばれるAI技術の精度向上に貢献できる可能性を探っています。連鎖的思考推論とは、LLMが回答に至るまでの思考プロセスやステップを説明する手法です。ジェイミソン氏は、「Capsaがこれらの推論プロセスを導き、最も確信度の高い推論の連鎖を特定するのに役立つ兆候が見られています。これは、LLMの体験を向上させ、遅延を減らし、計算要件を削減するという点で、非常に大きな影響を与える機会だと考えています」と述べています。AIがどのように結論に至ったのか、その思考プロセス自体の信頼性を評価できれば、AIの判断に対する理解と信頼はさらに深まるでしょう。

まとめ

本稿では、MIT Newsの記事を基に、Themis AIが開発したCapsaプラットフォームが、AIモデルの不確実性を定量化し、その信頼性を向上させる取り組みについて解説しました。AIが「知らないこと」を自覚し、それをユーザーに伝える能力は、AI技術が社会に広く受け入れられ、安全に活用されていくための鍵となります。 Themis AIの取り組みは、AIが出力する情報の信頼性を見極め、誤った情報によるリスクを低減し、特に医薬品開発や自動運転といった人命に関わるような重要な分野でのAIの健全な発展を促すものです。AIがより賢くなるだけでなく、自身の限界を理解し、人間と効果的に協調できるようになるための技術開発は、今後ますます重要になるでしょう。Capsaのような技術は、AIの進化に伴う課題に対処し、AIが持つ計り知れない可能性を最大限に引き出し、AIと人間がより良い信頼関係を築いていくための、重要な一歩と言えるでしょう。