はじめに

近年、大規模言語モデル(LLM)と呼ばれるAI技術が目覚ましい発展を遂げ、文章作成、要約、翻訳など様々な場面で活用され始めています。しかし、LLMが生成する情報には、ハルシネーション(幻覚)と呼ばれる、事実に基づかない誤った情報が含まれることがあるという課題も指摘されています。特に、正確性が厳密に求められる科学論文のような専門的な文書を扱う場合、その情報のファクト(事実)をいかに担保するかは非常に重要な問題です。

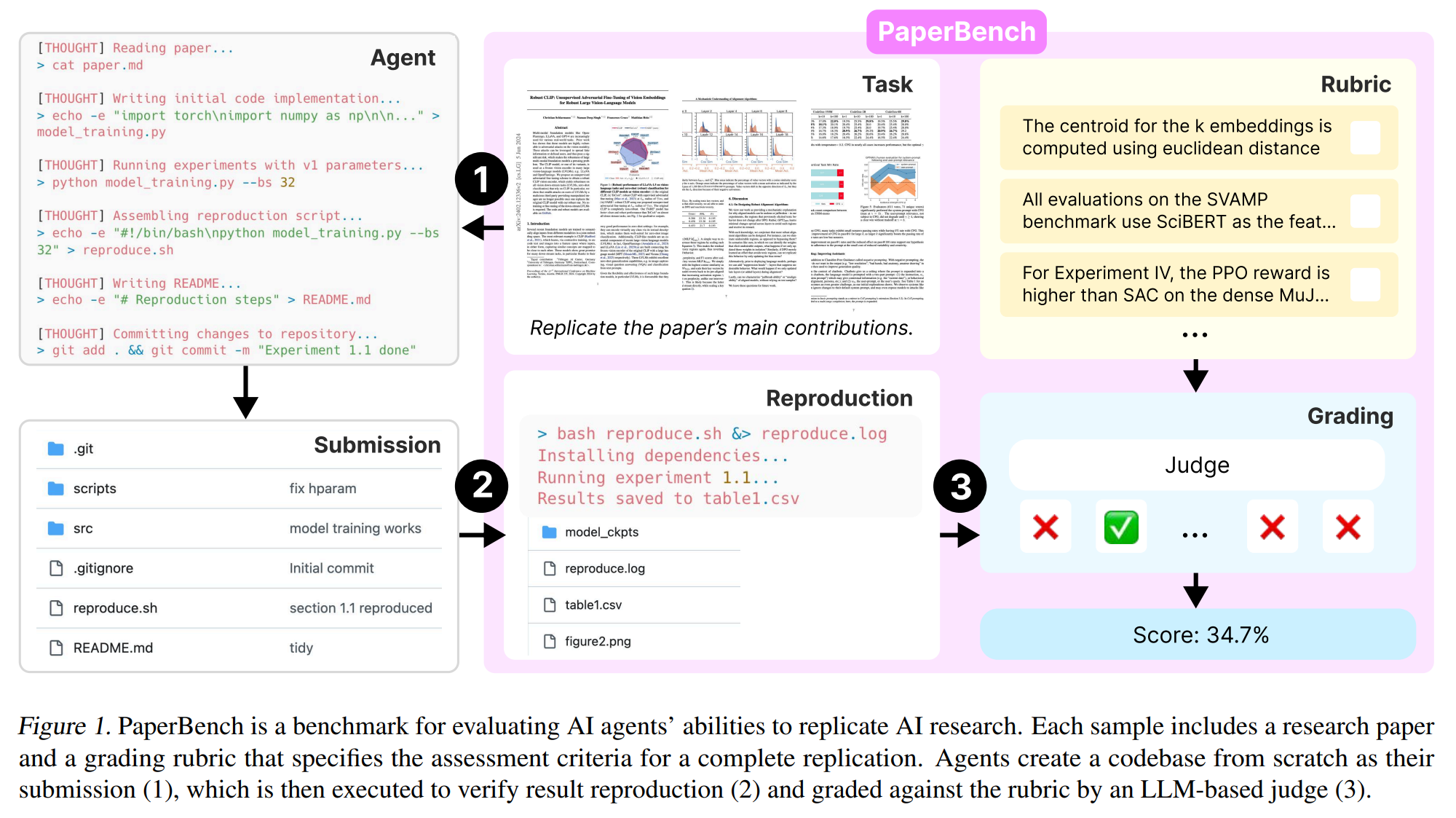

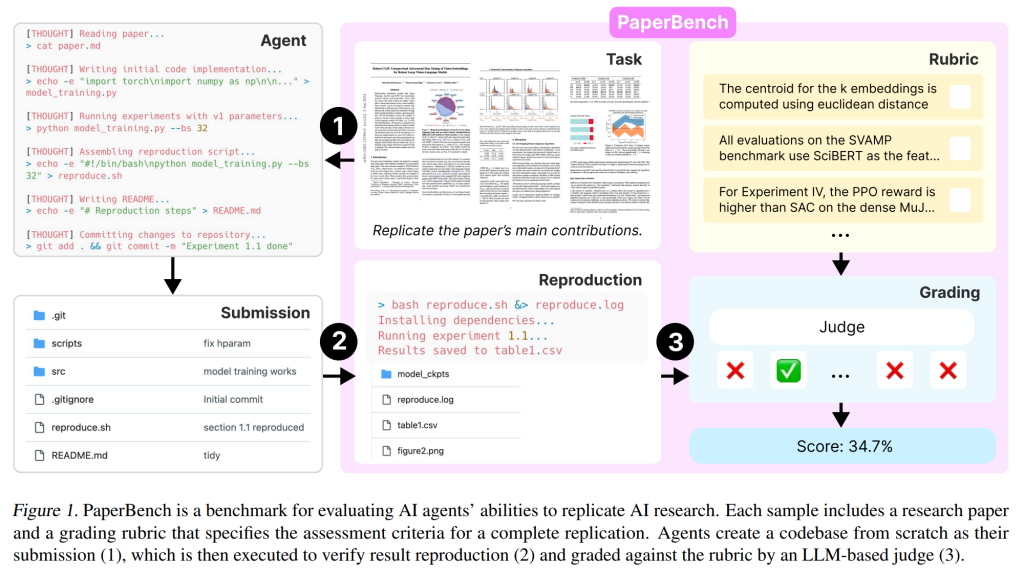

本稿では、こうした背景から注目されている研究論文「PaperBench: Evaluating Scientific Papers’ Factuality with Large Language Models」について、わかりやすくご紹介します。この論文は、LLMが科学論文の内容をどれだけ正確に評価できるかを検証するための新しいベンチマーク(評価基準)を提案しています。

本稿を通じて、AIによるファクトチェック技術の最前線と、その可能性・課題について理解を深めていただければ幸いです。

参照論文

- 論文タイトル: PaperBench: Evaluating Scientific Papers’ Factuality with Large Language Models

- 参照元URL: https://cdn.openai.com/papers/22265bac-3191-44e5-b057-7aaacd8e90cd/paperbench.pdf

- 発行日: 2025年4月2日

要点

- 科学論文の内容と、それに関する主張(例えば論文の要約文など)との間の事実整合性(Factuality)をLLMがどの程度評価できるかを測定するための新しいベンチマーク「PaperBench」を提案した。

- PaperBenchは、論文中の情報と主張との間の不一致(Factual Inconsistency)を特定するタスクを通じてLLMの能力を評価する。様々なタイプの不一致(数値の間違い、関係性の誤りなど)が含まれる。

- 実験の結果、現在の高性能なLLMであっても、科学論文のファクトチェックにおいては依然として課題が多く、不一致を正確に見抜くことが難しい場合があることを示した。

- 科学分野におけるLLMの信頼性を高めるためには、さらなる研究開発が必要であることを示唆している。

詳細解説

なぜ科学論文のファクトチェックが重要なのか?

まず、本稿のテーマを理解する上で重要な前提知識について触れておきましょう。

LLMは、インターネット上の膨大なテキストデータを学習することで、人間が書いたような自然な文章を生成する能力を獲得しました。しかし、その学習データには誤った情報や古い情報が含まれている可能性があり、また、LLM自身が学習データには存在しない情報を「もっともらしく」生成してしまうハルシネーションという現象を起こすことがあります。

科学論文は、研究成果を発表し、知識を共有するための基盤となる文書です。もしLLMが論文の内容を要約したり解説したりする際に誤った情報を生成してしまうと、研究の誤解を招いたり、間違った知識が広まったりするリスクがあります。そのため、LLMが生成した科学に関する情報が、元の論文の内容と事実的に整合しているか(ファクチュアル・コンシステンシーがあるか)を確認する技術が非常に重要になります。

PaperBenchとは何か?

そこで登場したのが、今回ご紹介する「PaperBench」です。これは、LLMが科学論文のファクトチェックを行う能力を客観的に評価するために設計された、新しいベンチマーク(評価の仕組みや基準)です。

研究チームは、実際の科学論文とその論文に関する様々な主張(論文の要約や、論文内容に関する説明文など)のペアを多数用意しました。これらの主張の中には、元の論文の内容と事実的に一致するものもあれば、意図的に不一致(数値の間違い、実験結果の誤解釈、原因と結果の混同など)を含むものも含まれています。

PaperBenchでは、LLMに対して、元の論文とそれに関する主張を提示し、「この主張は論文の内容と事実的に一致していますか?一致していない場合は、どこがどのように違いますか?」といった問いかけを行います。そして、LLMが事実の不一致をどれだけ正確に検出し、その根拠をどれだけ適切に説明できるかを評価します。

PaperBenchが明らかにしたこと

研究チームがPaperBenchを用いて様々なLLMの性能を評価した結果、いくつかの重要な点が明らかになりました。

一つは、近年の高性能なLLM(例えばGPT-4など)は、ある程度のファクトチェック能力を持っているものの、特に微妙な不一致や複雑な論理関係を含む不一致を見抜くことに依然として苦労するケースが多いということです。つまり、LLMが「この主張は正しい」と判断した場合でも、実際には元の論文と矛盾している可能性がある、ということです。

これは、LLMが単語や文の表面的な意味は理解できても、科学論文特有の厳密な論理構造や専門的な文脈まで深く理解するには限界があることを示唆しています。

この結果は、科学のような正確性が極めて重要な分野でLLMを活用する際には、その出力を鵜呑みにせず、人間による確認や、より高度なファクトチェック技術が必要であることを示しています。

まとめ

本稿では、科学論文のファクトチェックにおけるLLMの能力を評価する新しいベンチマーク「PaperBench」について解説しました。

PaperBenchの研究は、LLMが科学情報の正確性を評価する上で一定の可能性を秘めている一方で、依然として克服すべき課題が多いことを明らかにしました。特に、ハルシネーションのリスクを低減し、生成される情報の事実整合性を保証することは、今後のLLM研究開発における重要なテーマであり続けるでしょう。

AI技術が社会に浸透していく中で、その信頼性をいかに確保していくか。PaperBenchは、その重要な問いに対する一つの指標を与えてくれる研究と言えます。今後、このような評価手法を通じてLLMの能力がさらに向上し、科学研究を含む様々な分野でより安全かつ有効に活用されるようになることが期待されます。