はじめに

本稿では、現代のAIおよび自動化戦略において非常に重要な概念である「ビッグデータ」と「ファストデータ」の違いについて、詳しく解説していきます。データはAIの基盤ですが、すべてのデータが同じように扱えるわけではありません。これらのデータの特性を理解し、それぞれのデータに適したアプローチを取ることが、AI戦略を成功に導く鍵となります。

引用元記事

- タイトル: Big Data vs Fast Data: Optimize Your AI Strategy

- 発行元: IBM

- 発行日: 2025年6月3日

- URL: https://www.youtube.com/watch?v=vWVOMV_vxxs

- タイトル: What is big data?

- 発行元: IBM

- 発行日: 2024年11月18日

- URL: https://www.ibm.com/think/topics/big-data

要点

- ビッグデータは、膨大な量のデータを蓄積・分析し、時間をかけて深い洞察を得ることを目的とする。AIモデルのトレーニング、過去のパターン分析、大規模なデータアーカイブの管理に適している。

- ファストデータは、リアルタイムに近い速度でデータを処理し、即時の意思決定に活用することを目的とする。不正検知、パーソナライゼーション、IoTデバイスからのデータ処理などに適している。

- 両者はトレードオフの関係にあり、ビッグデータに最適化するとファストデータの柔軟性が失われる可能性がある。

- AI戦略においては、データの価値がどこにあるのか(蓄積された量か、瞬時の情報か)を見極め、適切なデータ戦略を選択・組み合わせることが不可欠である。

詳細解説

ビッグデータとは? ~蓄積と分析による深い洞察~

まず、「ビッグデータ」について解説します。ビッグデータという言葉は、ここ10年以上頻繁に耳にするようになりました。これは、従来のデータ管理システムでは扱うことが困難なほど巨大で複雑なデータセットを指します。IBMの記事によれば、ビッグデータは「量(Volume)、速度(Velocity)、多様性(Variety)、正確性(Veracity)、価値(Value)」という5つのVで特徴づけられます。

- 量 (Volume): テラバイトやペタバイト単位で計測される膨大なデータ量。

- 速度 (Velocity): データが生成・流入する速さ。リアルタイムに近い処理が求められる場合もある。

- 多様性 (Variety): 構造化データ(データベースの表など)、半構造化データ(JSON、XMLなど)、非構造化データ(テキスト、画像、動画など)といった多様な形式のデータが含まれる。

- 正確性 (Veracity): データの正確性と信頼性。ノイズやエラーが含まれる可能性があり、データ品質の確保が重要。

- 価値 (Value): データから引き出される実用的な価値。ビジネスの成長やイノベーションを促進する。

ビッグデータの主な目的は、時間をかけて大量のデータを分析し、そこから深い洞察やパターンを見つけ出すことです。例えば、過去数年間の販売データから来年の売上を予測する、膨大な顧客データから新たなマーケティング戦略を立案する、といった用途が考えられます。AIモデルのトレーニング、特にディープラーニングのように大量のデータを必要とする場合にも、ビッグデータは不可欠です。

ビッグデータ活用のためのアーキテクチャでは、以下の要素が重要になります。

- データストレージと管理:

- データウェアハウス (DWH): 構造化データを大量に格納し、分析しやすいように整理・統合するシステム。

- データレイク: あらゆる形式の生データをそのままの形で大量に保存できるストレージ。柔軟性が高いが、利用するにはデータの加工が必要になる場合が多い。

- データレイクハウス: データレイクの柔軟性とデータウェアハウスの構造化・管理機能を組み合わせた新しいアプローチ。

これらの大規模なデータリポジトリに情報を集約することで、これまで見えなかった価値を引き出すことが可能になります。

- データ処理と操作:

- Apache Spark のような分散処理フレームワークが代表的です。大量のデータを効率的に処理し、変換・操作するために用いられます。

- ビジネスインテリジェンス (BI) と AI プラットフォーム:

- 収集・処理されたデータからダッシュボードを作成したり、データサイエンティストがAIモデルを構築したりするためのツール群です。データ可視化ツールや、機械学習モデルを開発・運用するためのプラットフォームが含まれます。

ビッグデータアーキテクチャの成熟度には段階があります。最初は部門ごとにデータがサイロ化している状態から始まり、次にこれらを統合したデータリポジトリ(データファブリックやデータメッシュと呼ばれることもあります)を構築します。さらに進むと、AIや自動化技術を活用して、ストレージの自動スケーリングやスマートガバナンス(AIによるデータ管理の自動化・最適化)を実現し、データからより迅速に価値を引き出せるようになります。

ファストデータとは? ~リアルタイム処理による即時対応~

次に、「ファストデータ」について解説します。ビッグデータが「深さ」を追求するのに対し、ファストデータは文字通り「速さ」を重視します。その価値は、データが発生したその瞬間に、いかに迅速に意思決定やアクションに繋げられるかという点にあります。

ファストデータの活用例としては、以下のようなものが挙げられます。

- 不正検知: クレジットカードの不正利用をリアルタイムで検知し、被害を未然に防ぐ。

- パーソナライゼーション: ECサイトでユーザーの行動履歴に基づき、リアルタイムでおすすめ商品を表示する。

- IoT (モノのインターネット) デバイスからのデータ処理: 工場のセンサーデータから異常を即座に検知し、対応する。

重要なのは、ファストデータもデータ量が多い場合があるものの、その価値は「その瞬間のデータ」にあるという点です。例えば、「過去1年間の売上データ」はビッグデータの領域ですが、「直近5分間の売上データ」はファストデータの領域であり、それに基づいて即座に在庫調整やプロモーション変更を行うといった活用が考えられます。

ファストデータ活用のためのアーキテクチャでは、以下の要素が重要になります。

- データ統合とストリーミング処理:

- Apache Kafka のようなストリーミングプラットフォームが中心となります。これは、発生し続ける小さなデータイベント(ログ、センサーデータなど)をリアルタイムに収集・集約し、他のシステムに送り出す役割を担います。

- イベント処理とアクション実行:

- ストリーミングされたデータを受け取り、それに基づいて何らかのアクションをトリガーするシステムです。FaaS (Function as a Service) のようなサーバーレスコンピューティングや、低遅延で軽量な処理基盤が用いられます。これにより、個々のイベントに対して迅速かつ独立した処理を実行できます。

- 短期的なエフェメラルストレージ(一時的な保存領域):

- 処理に必要な短期間のデータを保持するためのキャッシュやエッジストレージが利用されることがあります。例えば、「直近1時間のデータ」を保持しておき、リアルタイム分析に活用するといった使い方です。これは永続的なデータ保存場所ではなく、あくまでリアルタイム性を担保するための一時的なものです。

ファストデータアーキテクチャの成熟度も段階的に進化します。最初は、イベント発生時にアラートを通知するような単純なログ分析や通知システムから始まります。次に、AIを活用してイベントを分類・要約したり、リスクレベルを判定したりできるようになります(例:不正の可能性が高い取引をフラグ付けする)。さらに進むと、通知や分類だけでなく、自動的にアクションを実行するレベルに到達します。例えば、リアルタイムの市場データや顧客行動に基づいて、動的に価格を変更するといった高度な自動化が可能になります。

ビッグデータとファストデータのトレードオフとAI戦略

ここまで見てきたように、ビッグデータとファストデータは、目的もアーキテクチャも大きく異なります。そして、これらはトレードオフの関係にあります。ビッグデータ処理に最適化されたシステムは、大量データの蓄積やバッチ処理には強いですが、リアルタイムの応答性には劣る傾向があります。逆に、ファストデータ処理に最適化されたシステムは、瞬時の処理は得意ですが、大規模な履歴データを扱ったり、複雑な分析を行ったりするには不向きです。

では、AI戦略において、どちらを選択すべきなのでしょうか? 答えは「どちらか一方」ではなく、「両者を理解し、目的に応じて使い分ける、あるいは組み合わせる」ことです。

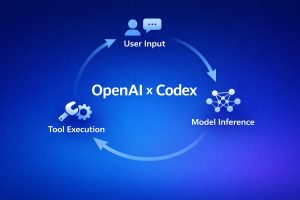

例えば、ファストデータによってリアルタイムに収集されたイベントデータを分類するためのAIモデルを考えてみましょう。このAIモデル自体をトレーニングするためには、過去の大量のイベントデータ(ビッグデータ)が必要になります。そして、トレーニング済みのモデルを実際の運用環境でリアルタイムに適用する際には、ファストデータのアーキテクチャが活用されます。

つまり、多くの高度なAI活用においては、ビッグデータとファストデータの両方の側面が必要となるのです。重要なのは、自社のビジネスにおいて、データの価値がどこから生まれるのかを正確に把握することです。

- 長期的な傾向分析や予測モデルの構築が重要か? → ビッグデータ戦略が中心

- リアルタイムの状況把握や即時対応が重要か? → ファストデータ戦略が中心

そして、多くの場合、これらを組み合わせたハイブリッドなアプローチが求められます。例えば、小売業であれば、過去の販売実績(ビッグデータ)から需要予測モデルを構築しつつ、店舗のリアルタイムの顧客行動(ファストデータ)に基づいてパーソナライズされたクーポンを発行する、といった戦略が考えられます。

AIと自動化は、適切なデータ基盤なしには成り立ちません。ビッグデータへの投資は、深い洞察と長期的なAIの成長基盤を築きます。一方、ファストデータへの投資は、リアルタイムAIと迅速な最適化を実現します。自社のAI戦略が、データの特性とビジネス目標に合致しているかを見極めることが、これからのAI時代を勝ち抜くために不可欠です。

まとめ

本稿では、ビッグデータとファストデータの違い、それぞれの特徴的なアーキテクチャ、そしてAI戦略におけるそれらの重要性について解説しました。

- ビッグデータは「深さ」を追求し、大量のデータを蓄積・分析することで、時間をかけた洞察を得ることを目指します。

- ファストデータは「速さ」を追求し、リアルタイムに近いデータ処理によって、即時の意思決定やアクションを可能にします。

これらの特性はトレードオフの関係にあり、どちらか一方に偏るのではなく、自社のビジネス目標やデータの価値がどこにあるのかを理解した上で、最適なデータ戦略を構築することが重要です。多くの場合、AIモデルの学習にはビッグデータが、そのモデルをリアルタイムで活用する際にはファストデータの仕組みが役立つなど、両者を組み合わせることで、より高度なAI活用が実現できます。