はじめに

Metaが2025年10月24日、PyTorch Conference 2025でAIエージェント構築を支援する5つの新しいプロジェクトを発表しました。ExecuTorch 1.0、Torchforge、Monarch、TorchComms、Helionという、カーネル開発からエージェント実装まで、機械学習の全段階に対応したツールセットです。本稿では、これらのプロジェクトとその特徴、実装上の意義について解説します。

参考記事

- タイトル:The Building Blocks of Agentic AI: From Kernels to Clusters

- 著者:Meta AI Team

- 発行元:Meta AI Blog

- 発行日:2025年10月24日

- URL:https://ai.meta.com/blog/introducing-pytorch-native-agentic-stack/

・本稿中の画像に関しては特に明示がない場合、引用元記事より引用しております。

・記載されている情報は、投稿日までに確認された内容となります。正確な情報に関しては、各種公式HPを参照するようお願い致します。

・内容に関してはあくまで執筆者の認識であり、誤っている場合があります。引用元記事を確認するようお願い致します。

要点

- MetaはPyTorchネイティブなエージェンティックAI構築向けのスタックを5つのプロジェクトで発表した

- スタックは大規模ワークロード(数千〜数十万GPU)への対応、異種ハードウェアサポート、PyTorch統合の3つの原則で設計されている

- Helion、TorchComms、Monarch、Torchforge、ExecuTorch 1.0という各層のツールで、カーネル開発から本番環境へのデプロイまでをカバーしている

- HuggingFaceとの協業で、強化学習環境の共有プラットフォーム「OpenEnv」も発表され、開発者コミュニティ主導の環境開発が可能になる

詳細解説

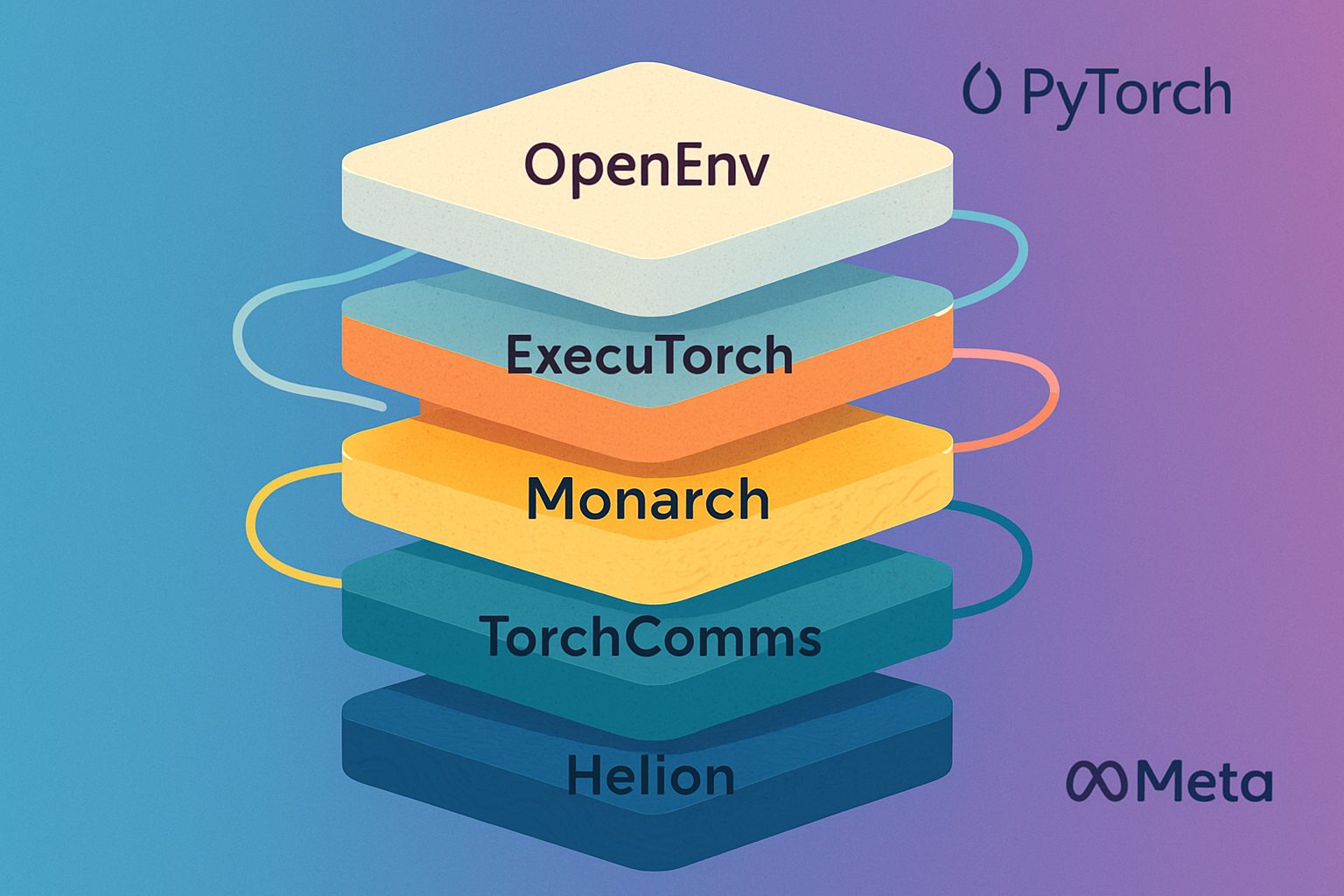

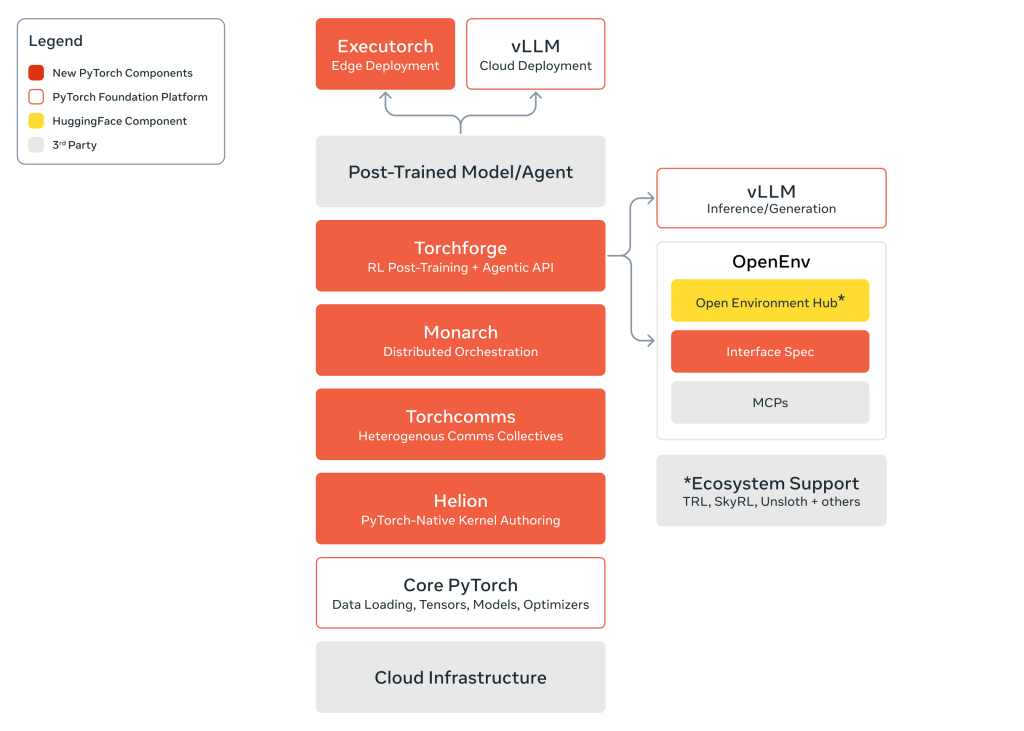

エージェンティックAIスタックの全体構想

今回Metaが発表したスタックは、研究段階から本番利用段階へのAI技術の移行に伴う開発者のギャップを埋めることを目的としています。低層のカーネル開発から高層のエージェント実装まで、AI開発の全段階を統合的にサポートするように設計されています。

スタックは3つの基本原則に基づいています。第一に「構築段階からの大規模対応」で、数千のGPUから数十万のGPUへの拡張、高度な並列化戦略、耐障害性を考慮した設計になっています。第二に「PyTorchネイティブ」で、PyTorchのエコシステムに深く統合されており、Pythonの直感性が保たれています。第三に「異種ハードウェア対応」で、エッジデバイスからデータセンター、マルチクラウド環境まで、多様なハード環境を想定した構成です。

このアプローチにより、開発者は複雑な抽象化層を意識せずに、スケーラブルなコードを書くことができます。これまでは、パフォーマンスと拡張性のいずれかを選ぶ必要がある場合が多くありましたが、統合されたスタックにより、その二者択一を避けられるようになっています。

各層の機能とその役割

カーネル開発層:Helion

Helionは、機械学習カーネル開発用のPython組み込みドメイン固有言語です。Trition への直接コンパイルに対応し、GPU および他のアクセラレーターのパフォーマンスチューニングを自動化・抽象化します。

最大の特徴は、Tritionと比較して4分の1のコード量でロープラインパフォーマンスを達成できる点です。これまで、パフォーマンス最適化を目指すカーネル開発は高い専門性が求められてきました。Helionはこの障壁を低くし、より多くの開発者にハードウェアレベルでのAIシステムの調整と拡張を可能にします。

スーパーインテリジェンスへの競争が加速する中、数千人の開発者がAIスタック全体をハードウェアレベルで最適化できるようになることは、技術開発全体の速度に大きな影響を与えると考えられます。

分散通信層:TorchComms

TorchCommsは、分散システムにおける通信を統一されたAPIで管理するPyTorchネイティブライブラリです。大規模クラスタにおいて、10万GPUを超える規模でもスケールし、多様なハードウェア環境における堅牢で耐障害性のある分散通信を実現します。

特徴は、統一されたAPIにより、基盤となるインフラストラクチャや展開規模に関係なく、効率的で復元力のある通信を可能にしている点です。これまで、異なるハードウェア環境への対応には、複数の通信ライブラリの学習と選択という負担がありました。統一APIにより、開発者はハードウェア依存の複雑性を意識することなく、通信パターンの設計に集中できるようになります。

クラスタ実行層:Monarch

Monarchは、PyTorchの分散実行エンジンで、クラスタスケールの実行とオーケストレーションを再考したツールです。単一の中央コントローラーを活用し、マルチノード環境の複雑性を抽象化し、開発者がローカルの単一GPU環境でのコードと変わらない体験で、スケーラブルなコードを書くことができます。

エージェンティックAIのスケーリングには通常、大規模な計算リソースが必要です。Monarchはこのパワーを活用しつつ、開発者体験を損なわない設計になっています。シンプルなアーキテクチャにより、プロトタイプ作成ノートブック環境と同じ直感性で、クラスタスケールの能力にアクセスできるようになります。

この「単一コントローラー」アプローチは、従来の分散トレーニングフレームワークとは異なる選択です。複数のコントローラーを持つ設計と比べて、プログラミングの簡潔性を優先した判断と言えます。開発者の学習曲線が緩やかになることで、大規模実験への参入障壁が低くなります。

強化学習層:Torchforge

Torchforgeは、スケーラブルな強化学習(RL)ポストトレーニングとエージェンティック開発を目的に設計されたPyTorchネイティブライブラリです。インフラストラクチャ上の懸念とモデル上の懸念を明確に分離することで、RL実験を容易にします。

主な特徴は3つあります。第一に「実験の迅速性」で、RLループをインフラから分離することにより、アルゴリズム開発に集中できます。第二に「パワーユーザー向けのカスタマイズ性」で、RLループのすべての部分が、インフラとの相互作用なしに簡単に変更できます。第三に「スケーラビリティ」で、非同期と同期トレーニング間の切り替え、数千GPUにわたるシフトが可能です。

Stanfordとの協業では、報酬モデリングと自動検証を推し進めるWeaver技術をTorchforgeに統合し、最先端のRL手法を試行しています。このように、学術機関との連携により、実装の洗練が進められています。

エッジデバイス層:ExecuTorch 1.0

ExecuTorch 1.0は、MetaのオンデバイスAI向けエンドツーエンドソリューションで、Facebook、Instagram、Meta Quest、Ray-Ban Meta、WhatsAppなどで活用されています。モバイル、デスクトップ、エッジデバイス上での先進的なAI能力の実装を実現し、大規模言語モデル、コンピュータビジョン、音声認識、テキスト音声変換など、幅広いモデルに対応しています。

Qualcomm、Apple、Armなど業界大手の支援を受けており、多様なハードウェアプラットフォームへの統合を想定した設計です。1.0 GA(General Availability)リリースでは、パフォーマンス、安定性、主要プラットフォームとの統合が強化され、オンデバイスAIの実装による新型生成AIアプリケーションの可能性が広がります。

エッジデバイスは、従来、計算能力の制約から高度なAI処理の実装が難しい領域でした。ExecuTorch 1.0により、スマートフォン、スマートウォッチ、眼鏡型デバイスなど、日常接するデバイスでの直接的なAI利用が広がることが期待できます。

エージェント開発環境の民主化:OpenEnv

MetaとHugging Faceの協業により、強化学習環境の共有プラットフォーム「OpenEnv」がローンチされました。開発者は、新しい環境ハブを訪問し、OpenEnv対応の環境を構築・共有・探索できます。

・HuggingFaceのブログ:https://huggingface.co/blog/openenv

具体的には、Hugging Face上の環境ハブで、初期環境を利用し、開発者とモデルの相互作用を検証し、環境が公開するツールと観測の定義を検査できます。ハブにアップロードされたOpenEnv仕様に準拠するすべての環境は、自動的にこの機能を獲得するため、本格的なRLトレーニング実行前の検証と反復を迅速に行うことができます。

同時に、OpenEnv 0.1仕様(RFC)が公開され、コミュニティからのフィードバック収集と標準化のプロセスが開始されています。これは、モデル共有を民主化したHugging Faceが、エージェント開発環境においても同様の役割を果たすという戦略的な展開です。これにより、エージェント開発の初期段階が、モデル開発と同様にコミュニティ主導で進められるようになります。

スタック全体の統合設計

これらのプロジェクトは、単なるツール集合ではなく、統合的なビジョンに基づいています。低層のハードウェア最適化(Helion)から、中層の基盤技術(TorchComms、Monarch)、高層の応用技術(Torchforge、ExecuTorch、OpenEnv)まで、各層が相互に補完する設計です。

すべてがPyTorchネイティブであることにより、開発者は複数のエコシステムを学習する負担を軽減できます。また、各プロジェクトが早期段階でのコミュニティ参加を想定しており、オープンソース開発の原則に基づいています。

まとめ

MetaはPyTorch Conferenceで、エージェンティックAI構築の全段階をカバーするスタックを発表しました。ハードウェアレベルのカーネル開発から、本番環境へのデプロイまで、従来は個別のツールやフレームワークで対応していた領域を、統合的に支援する構成です。OpenEnvなどHugging Faceとの協業により、開発環境の民主化も同時に進められており、より多くの開発者がエージェント開発に参入できるようになるでしょう。今後、コミュニティでの実装と改善を通じて、このスタックがどのように進化していくか、注視する価値があります。