はじめに

近年、AI技術は目覚ましい発展を遂げ、私たちの生活やビジネスに大きな変化をもたらしています。しかし、その一方で、AIの悪用やプライバシー侵害といったリスクも顕在化しており、安全で信頼できるAIの開発と利用が喫緊の課題となっています。

本稿では、Meta社が2025年4月29日に開催した初のLlamaConで発表した、オープンソースAIコミュニティ向けの新しい保護ツールやAIのプライバシーとセキュリティに関する最新の取り組みについてご紹介します。

引用元記事

- タイトル: Sharing new open source protection tools and advancements in AI privacy and security

- 発行元: Meta AI Blog

- 発行日: 2025年4月29日

- URL: https://ai.meta.com/blog/ai-defenders-program-llama-protection-tools/

参考情報

本稿で紹介したツールやプロジェクトに関する追加情報は、以下のページで確認できます。

- Llama Protections: Meta社が提供するLlama関連の保護ツール群に関する公式ページです。

URL: https://www.llama.com/llama-protections/ - Purple Llama (GitHub): Llama Guardなどのツールを含む、責任あるAI開発のためのツールと評価を提供するプロジェクトのGitHubリポジトリです。

URL: https://github.com/meta-llama/PurpleLlama

・本稿中の画像に関しては特に明示がない場合、引用元記事より引用しております。

・記載されている情報は、投稿日までに確認された内容となります。正確な情報に関しては、各種公式HPを参照するようお願い致します。

・内容に関してはあくまで執筆者の認識であり、誤っている場合があります。引用元記事を確認するようお願い致します。

要点

Meta社は、AIの安全性とプライバシー保護を強化するため、以下の主要な発表を行いました。

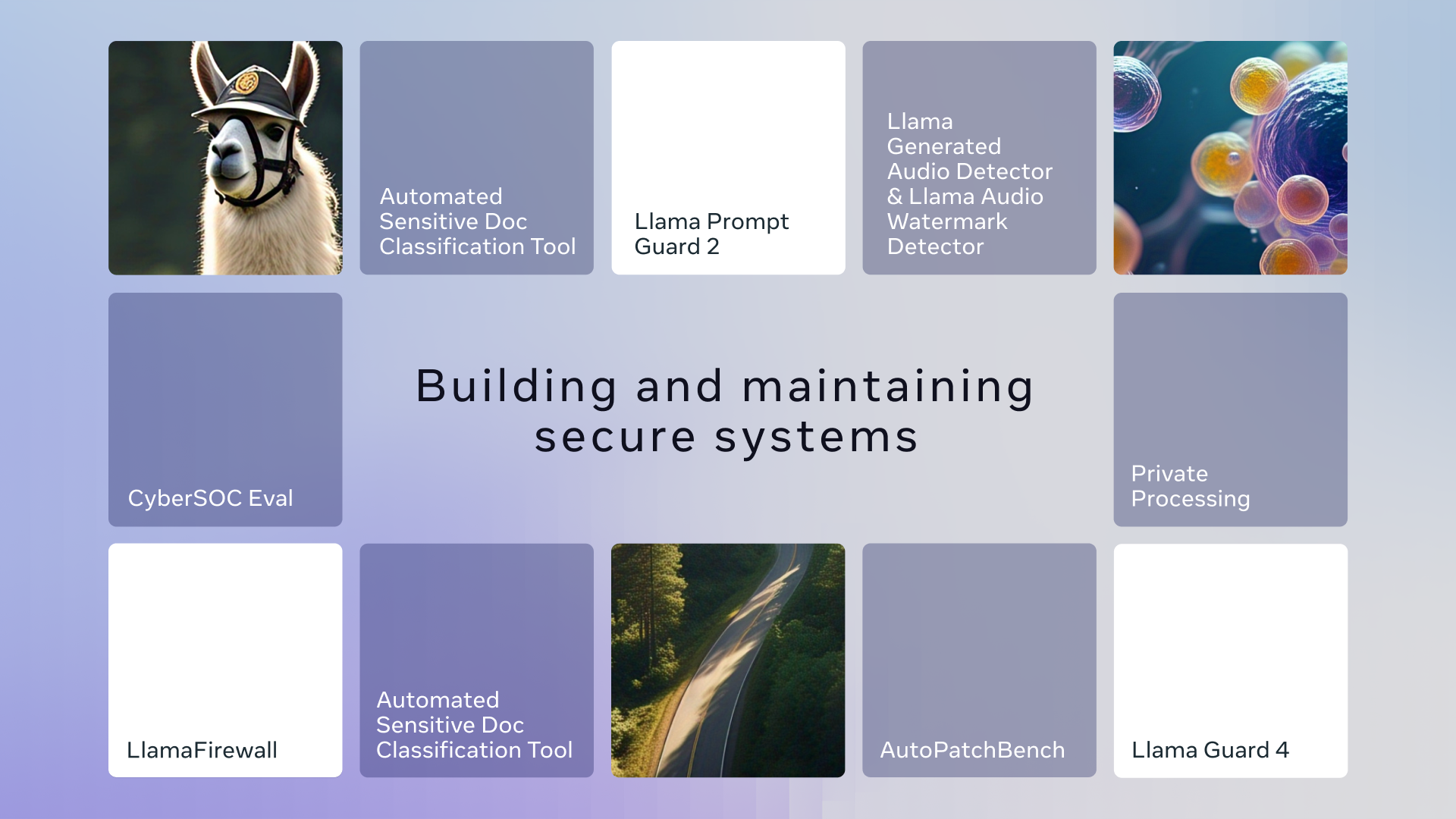

- Llama保護ツール群の拡充: オープンソースAIモデル「Llama」を安全に利用するための新しいツール群(Llama Guard 4、LlamaFirewall、Llama Prompt Guard 2)をリリースしました。これらは、テキストだけでなく画像を含む多様なデータ形式(マルチモーダル)に対応し、プロンプトインジェクション(※1)のような巧妙な攻撃や、安全でないコード生成のリスクを検知・防止します。

- 防御側コミュニティ支援: AIを活用してサイバーセキュリティ対策を強化したい組織向けに、AIシステムの有効性評価ツール(CyberSec Eval 4、CyberSOC Eval、AutoPatchBench)や、機密文書の自動分類ツール、AI生成コンテンツ検出ツールなどを提供します。また、パートナー企業と連携する「Llama Defenders Program」を開始しました。

- プライベート処理技術のプレビュー: WhatsAppのようなメッセージングアプリで、ユーザーのメッセージ内容をMeta社がアクセスすることなく、AI機能(要約や文章推敲など)を利用可能にする新技術「Private Processing」の概要を公開しました。

(※1)プロンプトインジェクション: AIモデルに対して、開発者が意図しない指示を不正に注入し、誤った情報や有害なコンテンツを生成させたり、内部情報を漏洩させたりする攻撃手法。

詳細解説

今回のMeta社の発表は、AI開発の最前線における「安全性」と「プライバシー」への強いコミットメントを示すものです。それぞれの取り組みについて、もう少し詳しく見ていきましょう。

1. Llama保護ツールの進化:「Purple Llama」プロジェクトの一環

Meta社は、「Purple Llama」という包括的なプロジェクトの下で、オープンな生成AIモデルを責任を持って構築するためのツールや評価基準を提供しています。「Purple」という名前は、サイバーセキュリティの世界における「レッドチーム(攻撃側)」と「ブルーチーム(防御側)」の両方の視点を取り入れ、協力してリスクを評価・軽減するという「パープルチーム」の考え方に由来します。今回発表されたツール群も、このプロジェクトの一環です。

- Llama Guard 4: これは、従来のLlama Guardをアップデートしたもので、テキストだけでなく画像の内容も理解し、不適切なコンテンツを検出できるマルチモーダル対応のセーフガード(安全装置)です。これにより、より多様なAIアプリケーションでの安全性を確保できます。現在、限定プレビュー中の新しいLlama APIでも利用可能です。

- LlamaFirewall: 安全なAIシステム構築を支援する包括的なセキュリティフレームワークです。PromptGuard 2、Agent Alignment Checks、CodeShieldという3つのツールを統合し、リアルタイムで多層的な防御を実現します。プロンプトインジェクション、ゴールハイジャッキング(目的の乗っ取り)、安全でないコード生成といったリスクを検知・防止します。

- Llama Prompt Guard 2: プロンプトインジェクションやジェイルブレイク(※2)の検出性能を向上させた分類モデルです。特に注目すべきは、より小型で高速なバージョン(22M)も導入された点です。これにより、性能の低下を最小限に抑えつつ、遅延(レイテンシ)と計算コストを最大75%削減できるため、リソースが限られた環境でも導入しやすくなります。

(※2)ジェイルブレイク: AIモデルに組み込まれた安全機能や倫理的な制約を回避するように設計された、悪意のある指示。

これらのツールは、開発者がLlamaを用いてAIアプリケーションを構築する際に、より容易に、かつ効果的に安全対策を組み込むことを可能にします。オープンソースとして提供されることで、コミュニティ全体での知見共有や改善も期待されます。

2. 防御側コミュニティへのAI活用支援

AIは攻撃だけでなく、防御にも活用できます。Meta社は自社での経験に基づき、他の組織がAIをセキュリティ運用に活用できるよう、以下のツールやプログラムを提供します。

- CyberSec Eval 4: AIシステムのサイバーセキュリティ防御能力を評価するためのオープンソースのベンチマーク(評価基準)スイートです。これには以下の新しいツールが含まれます。

- CyberSOC Eval: CrowdStrike社と共同開発した、セキュリティオペレーションセンター(SOC)におけるAIシステムの有効性を測定するフレームワーク。

- AutoPatchBench: LlamaなどのAIシステムが、ソフトウェアの脆弱性を自動的に修正(パッチ適用)する能力を評価する新しいベンチマーク。特にC/C++の脆弱性に対する自動修復能力を標準化された評価フレームワークで測定します。

- Llama Defenders Program: パートナー組織や開発者が、様々なセキュリティニーズに対応するために、オープンソース、早期アクセス、クローズドなAIソリューションにアクセスできるよう支援するプログラムです。ZenDesk、AT&T、Bell Canadaなどが初期パートナーとして参加しています。

- Automated Sensitive Doc Classification Tool: Meta社内で使用されているツールで、組織内の文書に自動的にセキュリティ分類ラベルを付与し、不正アクセスや配布を防いだり、AIシステムのRAG(※3)実装から機密文書を除外したりするのに役立ちます。

- Llama Generated Audio Detector & Llama Audio Watermark Detector: AIによって生成された音声コンテンツを検出するツールです。これにより、詐欺やフィッシングなどのAI生成脅威を組織が検出するのに役立ちます。

(※3)RAG (Retrieval-Augmented Generation): AIモデルが回答を生成する際に、外部の知識データベースから関連情報を検索し、その情報を参照して回答の精度や信頼性を向上させる技術。

これらの取り組みは、AI技術が進化する中で、ソフトウェアシステムの堅牢性を向上させるための重要なステップです。特に、脆弱性の自動修正やAI生成コンテンツの検出は、巧妙化するサイバー攻撃への対策として期待されます。

3. プライバシー保護の新技術:「Private Processing」

AIの利便性を享受しつつ、個人のプライバシーをどう守るかは大きな課題です。Meta社は、WhatsAppユーザーがメッセージの内容をMeta/WhatsAppに知られることなくAI機能を利用できるようにする新技術「Private Processing」の初期情報を公開しました。

これは、例えば未読メッセージの要約やメッセージの下書き支援といった機能を、エンドツーエンド暗号化のような高いプライバシーを保ちながら提供することを目指すものです。Meta社は、潜在的な攻撃経路を特定し防御するための脅威モデルを含む、この技術のセキュリティアプローチに関する情報を公開し、セキュリティコミュニティと協力してアーキテクチャの監査と改善を進めていくとしています。製品への導入前に、研究者と協力しながらオープンに開発を進める姿勢を示しています。

LlamaConでの追加発表

今回の発表は、Meta社が初めて開催した「LlamaCon」というLlamaモデルファミリーに特化したイベントの中で行われました。このイベントでは、上記の安全性ツールに加えて、以下の重要な発表もありました。

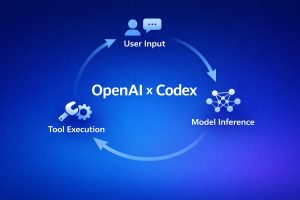

- Llama API: 開発者向けに新しいLlama APIが限定プレビューとして提供開始。インタラクティブなモデルプレイグラウンド、ワンクリックでのAPIアクセス、Python/TypeScript SDKなどを提供。OpenAI SDKと互換性があり、移行が容易。

- Meta AI: Llama 4を搭載した独立型AIアプリケーションとして発表。ユーザーのFacebookとInstagramアカウントに基づいてパーソナライズされた応答を提供し、Meta AIグラスとも統合。

- Llama Impact Grants: Llamaを公益のために活用するプロジェクトへの助成金プログラムの第2ラウンドを発表。150万ドルを10の国際的な受賞者に提供。

まとめ

本稿では、Meta社が発表したAIの安全性とプライバシーに関する最新の取り組みについて解説しました。オープンソースのLlama保護ツールの拡充、防御側コミュニティへのAI活用支援、そしてプライバシー保護のための新技術「Private Processing」は、AIをより安全で信頼できるものにするための重要な前進と言えるでしょう。

特に、Llama Guard 4のマルチモーダル対応やLlamaFirewallによる包括的なリスク対策、Llama Prompt Guard 2の効率化は、開発者が直面する課題への具体的な解決策を提供します。また、CyberSec Evalのような評価基準の整備や、Private Processingのようなプライバシー保護技術の開発は、AIエコシステム全体の健全な発展に不可欠です。

Meta社は今後もこの分野での取り組みを継続し、さらなる情報を共有していくとしています。オープンソースの理念に基づいたこれらの取り組みは、AIの未来が特定の企業に閉じられたものではなく、コミュニティ全体で育てていくものであることを示しています。AI技術の恩恵を最大限に享受するためには、こうした安全性とプライバシーへの配慮がますます重要になっていくでしょう。