はじめに

Metaが2025年11月21日、同社のAI推論エンジン「ExecuTorch」のReality Labs製品群での実装事例を公式ブログで発表しました。本稿では、VRヘッドセットやAIグラスにおけるオンデバイスAIの実現方法、開発者向けの具体的な使用方法、そしてオープンソースエコシステムの拡大について解説します。

参考記事

メイン記事:

- タイトル: ExecuTorch Adoption in Reality Labs: Powering On-Device AI Across Meta Devices

- 発行元: Meta AI Blog

- 発行日: 2025年11月21日

- URL: https://ai.meta.com/blog/executorch-reality-labs-on-device-ai/

関連情報:

- タイトル: PyTorch ExecuTorch GitHub Repository

- 発行元: GitHub

- URL: https://github.com/pytorch/executorch

・本稿中の画像に関しては特に明示がない場合、引用元記事より引用しております。

・記載されている情報は、投稿日までに確認された内容となります。正確な情報に関しては、各種公式HPを参照するようお願い致します。

・内容に関してはあくまで執筆者の認識であり、誤っている場合があります。引用元記事を確認するようお願い致します。

要点

- ExecuTorchは、MetaのオープンソースAI推論エンジンで、スマートフォンからマイクロコントローラまで幅広いデバイスで軽量かつ効率的なオンデバイス推論を実現する技術である

- Meta Quest 3/3S、Ray-Ban Meta Display、Oakley Meta Vanguardなど、Reality Labs製品群でExecuTorchが活用され、Instagram、WhatsApp、Quest 3などMeta製品全体で数億人のユーザーに展開されている

- PyTorchネイティブなフローを提供し、.onnxや.tfliteなどの中間形式への変換を不要とすることで、研究から実装までの開発サイクルを短縮している

- 50KBという小さなランタイムフットプリントを持ち、Android、iOS、Linux、組み込みシステムなど12以上のハードウェアバックエンドをサポートしている

- Apple、Arm、Qualcommなど主要ハードウェアパートナーとの協業により、オープンソースエコシステムが拡大し、Hugging Face、Ultralyticsなどの主要ライブラリとも統合されている

詳細解説

ExecuTorchの技術的特徴と動作原理

ExecuTorchは、Metaが開発したオープンソースのAI推論エンジンです。Metaによれば、この技術は高性能なシステムオンチップ(SoC)から超低消費電力マイクロコントローラまで、多様なハードウェア環境で効率的に動作する設計となっています。

従来のオンデバイスAI実装では、PyTorchモデルを他の形式に変換する必要があり、数値的な不一致やデバッグサイクルの長期化といった課題がありました。ExecuTorchはこの変換ステップを排除し、PyTorchネイティブなフローを提供することで、開発者が研究段階から実装まで一貫した環境で作業できる仕組みを実現しています。

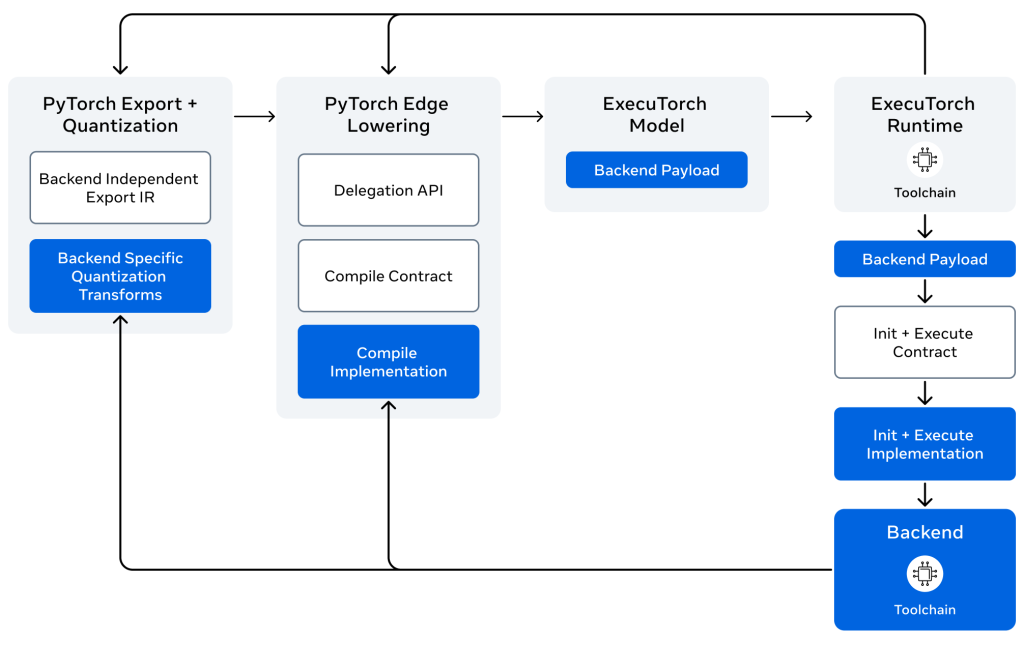

ExecuTorchの動作原理は、事前コンパイル(AOT: Ahead-of-Time)方式を採用しています。具体的には、まずPyTorchモデルグラフをtorch.export()で取得し、次に量子化や最適化を行ってハードウェアバックエンドに分割し.pteファイルを生成、最後に軽量なC++ランタイム経由でデバイス上で.pteファイルを読み込んで実行する、という3段階のプロセスとなります。

この技術の重要な利点として、ハードウェア固有の最適化(量子化やコンパイラパスの適用など)をデプロイ前にPyTorch内で検証できる点が挙げられます。これにより、実機での動作確認前に多くの問題を発見できるため、開発効率の向上が期待できます。

また、ExecuTorchはわずか50KBという小さなランタイムフットプリントを持つため、マイクロコントローラから高性能スマートフォンまで幅広いデバイスで動作可能です。モデルは標準化されたCore ATenオペレータセットを使用し、パーティショナーが部分グラフを専用ハードウェア(NPU/GPU)に委譲しつつ、CPUフォールバックも提供する仕組みとなっています。

開発者向けの基本的な使い方

ExecuTorchの導入は、pip経由で簡単にインストールできます。基本的なモデルのエクスポートとデプロイは、3つのステップで完了します。

まず、PyTorchモデルをエクスポートします。次に、ターゲットハードウェア向けに最適化を行います。この際、XnnpackPartitioner(CPU用)、CoreMLPartitioner(iOS用)、QnnPartitioner(Qualcomm用)など、バックエンドの切り替えは1行の変更で可能です。最後に、デプロイ用にmodel.pteファイルとして保存します。

デバイス上での実行は、C++、Swift(iOS)、Kotlin(Android)など複数の言語でサポートされています。例えばC++では、モジュールをロードしてテンソルを作成し、forwardメソッドを実行するだけでモデルを動かせます。

LLMの場合は、export_llmスクリプトやOptimum-ExecuTorchを使用してLlamaモデルをエクスポートし、LLM runner APIを通じてC++、Swift、Kotlinで実行できます。マルチモーダルモデル(視覚、音声)の場合は、MultiModal runner APIを使用することで、画像や音声入力をテキストと組み合わせて処理できる仕組みとなっています。

開発者向けには、ステップバイステップのチュートリアル、ブラウザで即座に試せるColabノートブック、量子化やモバイルデプロイメントを含むLlamaモデルの完全なワークフローといった学習リソースが用意されています。

プラットフォームとハードウェアのサポート状況

ExecuTorchは、幅広いプラットフォームとハードウェアバックエンドをサポートしています。

Androidでは、XNNPACK、Vulkan、Qualcomm、MediaTek、Samsung Exynosがサポートされています。iOSでは、XNNPACK、MPS、CoreML(Neural Engine)が利用可能です。Linux/Windowsでは、XNNPACK、OpenVINO、CUDA(実験的)がサポートされ、macOSではXNNPACK、MPS、Metal(実験的)が利用できます。組み込みシステムやマイクロコントローラ向けには、XNNPACK、ARM Ethos-U、NXP、Cadence DSPがサポートされています。

これらのバックエンドの詳細な要件や最適化ガイドは、公式のバックエンドドキュメントで確認できます。1つのモデルを複数のハードウェアターゲットに展開する際、バックエンドの切り替えだけで対応できる設計は、開発コストの削減に寄与すると考えられます。

本番環境での実装とサポートモデル

ExecuTorchは、Meta内部での大規模な本番環境での実装実績があります。Metaによれば、InstagramやWhatsAppを含むMetaアプリファミリー全体、VR/ARデバイス、パートナー展開を通じて、数億人のユーザーに対してリアルタイムのオンデバイス推論を提供しています。

サポートされるモデルの範囲も広く、LLMではLlama 3.2/3.1/3、Qwen 3、Phi-4-mini、LiquidAI LFM2などが動作します。マルチモーダルモデルでは、Llava(ビジョン言語)、Voxtral(音声言語)、Gemma(ビジョン言語)がサポートされています。また、視覚や音声認識では、MobileNetV2、DeepLabV3、Whisperなどの実装例が提供されています。

これらのモデルは、GitHubのexamplesディレクトリやexecutorch-examplesリポジトリで実装例を確認でき、Hugging Faceモデル向けにはOptimum-ExecuTorchという専用ツールも用意されています。

高度な機能と開発ツール

ExecuTorchは、本番環境でのデプロイメントに必要な高度な機能を提供しています。

量子化機能では、torchaoを通じて8ビット、4ビット、動的量子化などの組み込みサポートが利用できます。メモリプランニングでは、事前割り当て戦略によりメモリ使用量を最適化できます。開発ツールとしては、ETDumpプロファイラ、ETRecordインスペクタ、モデルデバッガーが提供されています。

選択的ビルド機能を使用すれば、未使用のオペレータを除去してバイナリサイズを最小化でき、カスタムオペレータによりドメイン固有のカーネルで拡張することも可能です。また、動的シェイプのサポートにより、境界範囲を持つ可変入力サイズにも対応しています。

これらの量子化技術、カスタムバックエンド、コンパイラパスなどの詳細は、Advanced Topicsドキュメントで確認できます。

Meta Quest 3/3Sでの活用事例

Metaによれば、Meta Quest 3および3Sでは、ExecuTorchを用いて深度推定やシーン理解といった高度なAI処理をデバイス上で実行しています。

具体的な機能として、Passthrough機能では物理世界と仮想コンテンツをシームレスに融合させる処理が、ExecuTorchによって実現されています。また、ハンドトラッキングやコントローラートラッキングなどのリアルタイム処理も、この技術によって支えられています。

さらに、ExecuTorchの効率的な推論により、Meta Quest 3/3Sは最大15の異なる部屋のレイアウトと境界を記憶する「永続的なルームメモリ」機能を実装しています。これにより、ユーザーは使用場所を変えても一貫したパーソナライズされた体験を得られる仕組みとなっています。

Ray-Ban Meta Displayでの実装

Ray-Ban Meta DisplayおよびMeta Ray-Ban Displayグラスでは、ExecuTorchによって複雑なモデルがデバイス上で直接実行され、リアルタイム翻訳やディスプレイ上の視覚的キャプション表示を可能にしています。

Metaによれば、従来の音声のみの翻訳と異なり、この視覚的アプローチでは、ユーザーが自分のペースでトランスクリプトをスクロールして確認できるため、外国語での会話や騒がしい環境でのコミュニケーションがより利用しやすくなっています。

また、「text-in-the-wild」機能では、オンデバイスAIとエゴセントリックOCR(光学式文字認識)を活用しています。グラスがユーザーの視界をそのまま認識するため、視線の先にある関連テキストを即座に識別し、文書、メニュー、道路標識などからの翻訳、読み上げ、コンテキストアクションを提供できる仕組みです。

レストランで外国語のメニューを見た際に数秒で翻訳を得られる、あるいは特定の項目を指差して追加情報を得られるといった使用例が、Metaの発表で紹介されています。リアルタイムハンドトラッキングと高度なOCRモデルがデバイス上で動作することで、これらの機能が実現されています。

Oakley Meta Vanguardでのスポーツ活用

アスリート向けに設計されたOakley Meta Vanguardグラスでは、Garminアカウントと連携することで、ExecuTorchを活用したリアルタイムのパフォーマンス分析が提供されています。

Metaによれば、ランニング、サイクリング、ハイキングなどのアクティビティ中に、ペース、心拍数、消費カロリーといった主要なパフォーマンス指標について、シンプルな音声コマンドで即座にフィードバックを受けられます。例えば「Hey Meta, what’s my heartrate?」といった問いかけで、運動中の情報にアクセスできる仕組みとなっています。

オープンソースエコシステムの拡大

ExecuTorchは、Meta社内だけでなく、開発者、研究者、ハードウェアパートナーによる活発なコミュニティに成長しています。Metaによれば、Apple、Arm、Cadence、Intel、MediaTek、NXP、Qualcomm Technologies、Samsungといった企業からの貢献により、オープンソース開発が進められています。

これらのプラットフォーム向けのExecuTorchバックエンドは公開されており、誰でもアクセス可能です。また、Hugging Face transformers、Ultralytics、Unsloth AI、torchaoといったライブラリやフレームワークとの統合も進んでいます。さらに、Liquid AI、NimbleEdge、React-Native-ExecuTorchなどのSDKにも統合され、AIエコシステムの重要な要素となっています。

コミュニティリソースとしては、GitHub Discussionsでの質問と意見共有、Discordでのチームとコミュニティとのチャット、GitHubでのバグ報告や機能リクエスト、貢献ガイドラインなどが提供されています。

ExecuTorchはBSDライセンスで提供されており、PyTorchエコシステムの一部として、完全なガイドとチュートリアル、Python、C++、Java/Kotlin APIリファレンス、カスタムハードウェアバックエンドの構築ガイド、トラブルシューティングといった包括的なドキュメントが整備されています。

オンデバイスAIは多様なプラットフォーム、チップ、ユースケースにまたがるため、オープンな開発によってエコシステム全体が協力して革新を進められる環境が整いつつあると考えられます。PyTorchモデルがスマートフォンからAIアプリ、将来のARグラスまで、あらゆる場所で効率的に動作できる基盤が構築されています。

まとめ

MetaのExecuTorchは、VRヘッドセットやAIグラスでのオンデバイスAI実装を実現する推論エンジンとして、Reality Labs製品群で広く活用されています。PyTorchネイティブなフローと50KBという小さなフットプリント、12以上のハードウェアバックエンドのサポートにより、開発効率を向上させながら幅広いデバイスへの展開を可能にしています。Apple、Qualcommなど主要ハードウェアパートナーとの協業、Hugging FaceやUltralyticsなどの主要ライブラリとの統合により、オープンソースエコシステムが拡大している点も注目されます。