はじめに

Meta社が、新しいパーソナルAIアシスタントアプリ「Meta AI」の第一弾を発表しました。本稿では、AIエンジニアの視点も交えつつ、このMeta AIアプリがどのようなもので、どんな技術が使われているのか、公式ブログをもとに解説します。特に、基盤となる大規模言語モデル(LLM)や音声対話技術、パーソナライゼーションの仕組み、そして複数のデバイスやサービスを連携させる戦略に焦点を当てていきます。

※ご注意:2025年4月30日現在、まだ日本で提供開始はされていません。

MetaAIへのアクセスURL: https://www.meta.ai/?utm_source=ai_meta_site&utm_medium=web&utm_content=AI_nav&utm_campaign=04292025_moment

引用元記事

- タイトル: Introducing the Meta AI App: A New Way to Access Your AI Assistant

- 発行元: Meta

- 発行日: 2025年4月29日

- URL: https://about.fb.com/news/2025/04/introducing-meta-ai-app-new-way-access-ai-assistant/

・本稿中の画像に関しては特に明示がない場合、引用元記事より引用しております。

・記載されている情報は、投稿日までに確認された内容となります。正確な情報に関しては、各種公式HPを参照するようお願い致します。

・内容に関してはあくまで執筆者の認識であり、誤っている場合があります。引用元記事を確認するようお願い致します。

要点

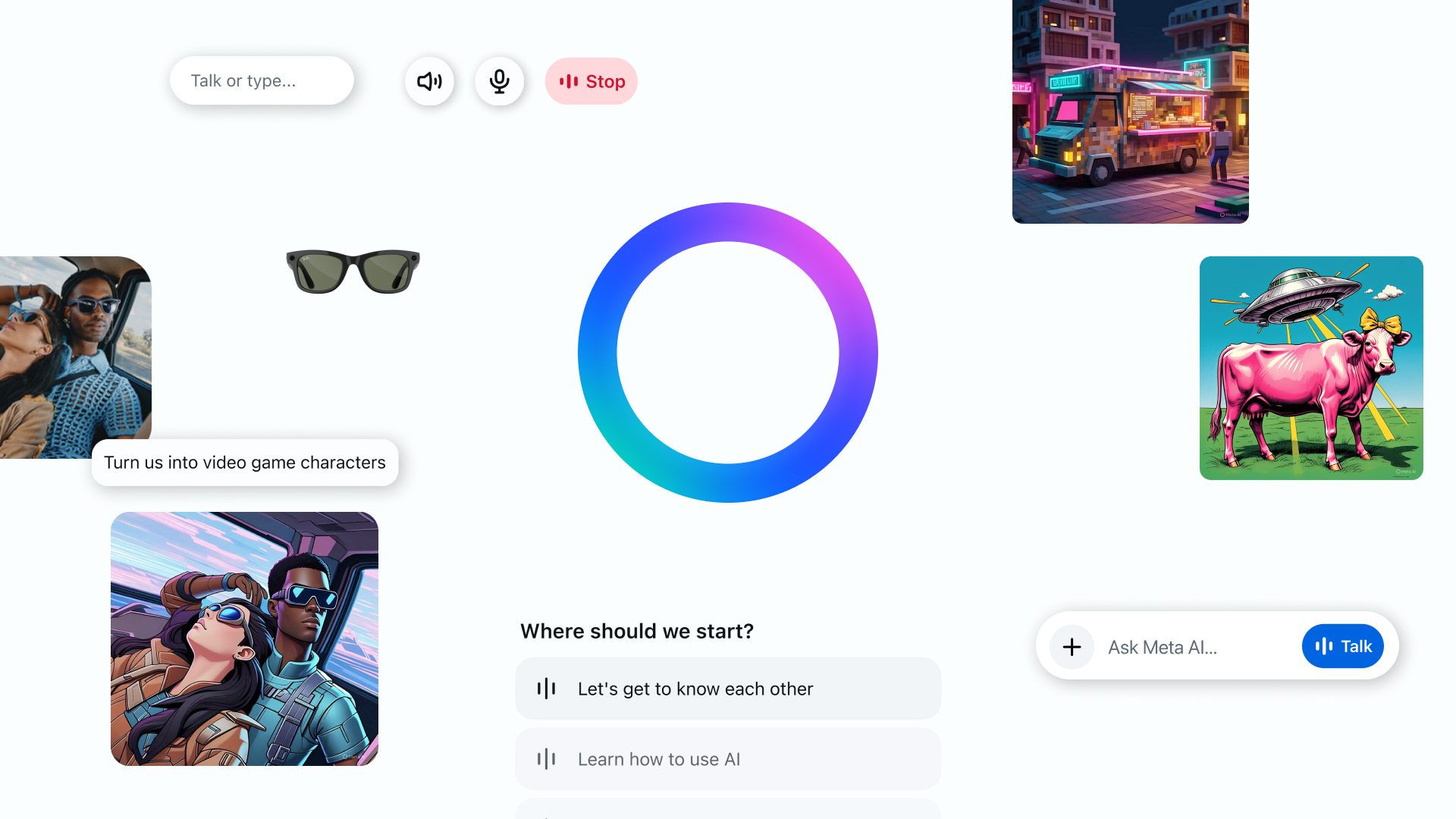

Meta AIアプリは、Meta社の最新AIモデル Llama 4 を基盤とし、ユーザーの好みや文脈を理解してパーソナライズされた応答を提供する新しいAIアシスタントです。主な特徴は以下の通りです。

- スタンドアロンアプリ: WhatsApp、Instagram、Facebook、Messengerといった既存プラットフォームに加え、独立したアプリとしても提供されます。

- 音声対話: より自然な音声でのやり取りを目指しており、フルデュプレックス音声技術のデモ版も搭載しています。

- パーソナライゼーション: ユーザーが直接教えた好みや過去の対話履歴、さらに許可した場合、Meta製品(Facebook/Instagram)でのアクティビティ情報を活用し、応答を最適化します。

- クロスプラットフォーム連携: スマートグラス(Ray-Ban Meta)のコンパニオンアプリとしても機能し、Web版(meta.ai)とも連携して、デバイス間でシームレスな体験を提供します。

- Discoverフィード: 他のユーザーがAIをどのように活用しているかを発見し、共有できる機能です。

- Web版の強化: デスクトップ向けに最適化され、画像生成機能の強化や、文書生成・分析機能のテストが行われています。

詳細解説

Llama 4による高度な対話能力

Meta AIアプリの頭脳にあたるのが、Llama 4 という最新の大規模言語モデル(LLM)です。LLMとは、膨大な量のテキストデータを学習することで、人間のように自然な文章を生成したり、質問に答えたり、文章を要約したりできるAIのことです。Meta社によると、Llama 4を採用したことで、従来のAIアシスタントよりも人間味があり、文脈に即した、より会話的なトーンでの応答が可能になったとされています。例えば、単に情報を提供するだけでなく、ユーザーの状況や過去の会話を踏まえた、より親身な応答が期待できます。AIエンジニアの視点からは、Llama 4が具体的にどのようなモデル構造を持ち、どのようなデータで学習し、どのように調整(ファインチューニング)されているのかが、この高度な対話能力を実現する鍵となります。

音声対話技術:フルデュプレックスへの挑戦

Meta AIは、キーボード入力だけでなく、声で操作することも重視しています。特に注目すべきは、フルデュプレックス音声技術のデモ版が搭載されている点です。「フルデュプレックス」とは、私たち人間が会話するように、相手の話を聞きながら同時に話せる通信方式のことです。従来のAIアシスタントの多くは、ユーザーが話し終えるのを待ってから応答を生成し、それを読み上げる「半二重」に近い方式でした。しかし、フルデュプレックス技術では、AIがテキストを読み上げるのではなく、直接音声を生成することで、より自然でタイムラグの少ない会話体験を目指します。

- 技術的背景: これを実現するには、AIが相手の声を聞き取り(音声認識)、意図を理解し、応答を考え(応答生成)、それを自然な音声でリアルタイムに発話する(音声合成)という一連の処理を、極めて短い時間で行う必要があります。周囲の雑音を除去したり、複数人が同時に話していても特定の話者を聞き分けたり、相手の話に割り込んだりする高度な技術も求められます。

- 現状と課題: 記事によると、このデモ版はまだ実験段階であり、インターネット上の最新情報にアクセスすることはできません。技術的な問題や応答の一貫性の欠如が発生する可能性も示唆されており、Meta社はユーザーからのフィードバックを基に改善を進めるとしています。AIエンジニアにとっては、この技術がどのようにノイズ除去、話者分離、割り込み処理などを実現しているのか、その具体的な仕組みが関心の的となります。

パーソナライゼーションの仕組み

Meta AIは、画一的な応答ではなく、ユーザー一人ひとりに合わせた体験を提供することを目指しています。そのために、いくつかの方法でユーザーに関する情報を学習します。

- 明示的な情報: ユーザーが「私は旅行と言語学習が好きです」といった情報をMeta AIに直接伝えることで、AIはその情報を記憶し、関連する応答(例えば、旅行先のおすすめや言語学習アプリの情報など)に反映させます。

- 暗黙的な情報: ユーザーとの対話の文脈から、その人の好みや関心事といった重要な詳細を学習します。例えば、特定の話題について繰り返し質問していれば、その分野に関心があると推測します。

- Metaプラットフォーム連携: ユーザーが許可した場合、FacebookやInstagramなどのMeta製品で共有しているプロフィール情報や、「いいね!」した投稿、フォローしているアカウントなどの情報を活用します。さらに、FacebookとInstagramのアカウントを「アカウントセンター」で連携させている場合は、両方のプラットフォームから情報を統合し、より深くユーザーを理解したパーソナライゼーションを実現します。

- 技術的考察: このようなパーソナライゼーションを実現するには、ユーザーの情報を分析して特徴を捉える技術(ユーザープロファイリング)、会話の流れを理解する技術(コンテキスト理解)が重要です。同時に、ユーザーのプライバシーをどのように保護するか、という点も極めて重要になります。どのようなデータを収集・利用し、それをどのように管理しているのか、ユーザーが自身のデータをどこまで制御できるのかといった透明性や制御性が、技術的にも倫理的にも問われます。

クロスプラットフォーム戦略とデバイス連携

Meta AIは、単体のアプリとしてだけでなく、Metaが提供する様々なサービスやデバイスに組み込まれ、連携して動作します。

- 既存アプリ連携: すでに多くの人が利用している WhatsApp、Instagram、Facebook、Messenger の中でもMeta AIを利用できます。

- スマートグラス連携: AI機能付きのスマートグラス Ray-Ban Meta の設定や操作を行うためのコンパニオンアプリ「Meta View」が、今回のMeta AIアプリに統合されました。これにより、例えば外出先でスマートグラスを使ってMeta AIと会話した内容を、後でスマートフォンのMeta AIアプリやWeb版の履歴で確認し、会話を続けるといった連携が可能になります(ただし、現時点ではアプリやWebで始めた会話をグラスで引き継ぐことはできないようです)。

- Web版 (meta.ai): パソコンのブラウザからアクセスできるWeb版も提供されており、アプリと同様に音声対話や後述するDiscoverフィードを利用できます。これにより、スマートフォン、スマートグラス、パソコンといった異なるデバイス間で、一貫した体験を提供することを目指しています。

- 技術的意義: このような複数のプラットフォームやデバイス間でのシームレスな連携を実現するには、ユーザーの状態(ログイン情報、設定など)や対話履歴といったデータを、リアルタイムかつ正確に同期させる技術が必要です。どのようにして一貫性を保ちながらデータを管理しているのかは、システム設計の観点から興味深い点です。

Discoverフィードとコミュニティ

Meta AIアプリ内には、Discoverフィードという機能があります。これは、他のユーザーがMeta AIをどのように活用しているか(例えば、どのような質問や指示=プロンプトを使っているか)を発見し、共有できる場です。他のユーザーが作成した優れたプロンプトを見たり、それを自分なりにアレンジ(リミックス)して使ったりすることができます。これは、ユーザー同士がAIの活用方法を学び合い、新たな使い方を発見していくコミュニティのような役割を果たすことを意図していると考えられます。

Webインターフェースの強化

パソコンから利用するWeb版のMeta AI (meta.ai) は、デスクトップでの作業に適した機能強化が行われています。

- 画像生成: AIに指示して画像を生成する機能が強化され、あらかじめ用意された設定(プリセット)が増えたり、画像のスタイル(画風)、ムード(雰囲気)、ライティング(光の当たり方)、色などを細かく調整できる新しいオプションが追加されたりしています。

- 文書処理(テスト中): テキストと画像を組み合わせた文書をAIが生成し、それをPDFファイルとして出力する機能や、既存の文書ファイル(PDFなど)をアップロードして、その内容をAIに分析・理解させる機能が一部の国でテストされています。これが実用化されれば、レポート作成や資料の要約といったビジネスシーンでの活用も期待できます。

ユーザーコントロール

Meta社は、ユーザーが自身のAI体験をコントロールできることを強調しています。例えば、Discoverフィードに自分のプロンプトを共有するかどうかはユーザーが選択できます。また、音声入力を常にオンにしておく機能(Ready to talk)も、設定でオン・オフを切り替えられます。パーソナライゼーションに関しても、どの情報をAIに利用させるかなど、ユーザー自身が設定できる範囲やその分かりやすさが、今後の信頼性を左右する重要な要素となるでしょう。

まとめ

本稿では、Metaが新たに発表したMeta AIアプリについて、特にAIエンジニアの関心が高いであろう技術的な側面を中心に、一般の方にもご理解いただけるように解説しました。Llama 4による高度な対話能力、フルデュプレックス音声技術への挑戦、Metaプラットフォーム全体を活用したパーソナライゼーション、そしてスマートグラスやWebを含むクロスプラットフォーム連携は、今後のAIアシスタントが目指す方向性を示すものとして非常に注目されます。

特に、Llama 4の具体的な性能の詳細、フルデュプレックス音声技術がどこまで自然な会話を実現できるか、パーソナライゼーションにおけるプライバシー保護と精度向上の両立、そして異なるデバイス間でのシームレスな体験を支える技術的な実装方法は、今後の技術的な進展を見守る上で重要なポイントとなるでしょう。Meta AIアプリはまだ初期バージョンであり、今後のアップデートや機能追加、そして私たちユーザーからのフィードバックによって、さらに洗練されていくことが期待されます。