はじめに

本稿では、2025年7月にGoogleが公式ブログで発表した検索機能のアップデートについて、解説します。Googleは私たちの情報収集のあり方を変えてきましたが、今回紹介するAIモードは、学習という観点からさらに加速させる可能性を秘めています。(なお、2025年7月30日現在は、米国のみで利用が可能です。)

参考記事

- タイトル: New ways to learn and explore with AI Mode in Search

- 著者: Robby Stein (VP of Product, Google Search)

- 発行元: Google

- 発行日: 2025年7月29日

- URL: https://blog.google/products/search/ai-mode-updates-back-to-school/

・本稿中の画像に関しては特に明示がない場合、引用元記事より引用しております。

・記載されている情報は、投稿日までに確認された内容となります。正確な情報に関しては、各種公式HPを参照するようお願い致します。

・内容に関してはあくまで執筆者の認識であり、誤っている場合があります。引用元記事を確認するようお願い致します。

要点

- Google検索に、対話形式でより複雑な情報収集を可能にするAIモードが導入され、新機能が追加された。

- 新機能には、画像やPDFファイルをアップロードして内容について質問する機能が含まれる。これにより、手持ちの資料を基にした深い情報収集が可能になる。

- Canvas機能は、AIとの対話を通じて学習計画やプロジェクトの整理を助ける。情報はサイドパネルに動的に整理され、継続的な利用が可能である。

- Search Live with video機能は、スマートフォンのカメラで映した映像について、リアルタイムでAIと対話しながら質問できる。これはGoogleの高度AIプロジェクト「Project Astra」の技術を応用したものである。

- Chromeブラウザとの連携により、閲覧中のWebサイトやPDF内の図表など、画面に表示されている内容について直接質問できるようになる。

詳細解説

そもそも「AIモード」とは?

まず前提として、Google検索のAIモードについて説明します。これは、従来のキーワード検索のように単語を入力して関連サイトのリストを得るだけでなく、AIと対話しながらより複雑で文脈に沿った回答を得ることを目的とした新しい検索の形です。質問を入力すると、AIがWeb上の膨大な情報を基に要約や回答を生成し、対話形式でさらに深掘りしていくことができます。これにより、ユーザーは断片的な情報を自分で組み合わせる手間を省き、より本質的な理解に集中できるようになります。

画像やPDFの内容をAIに質問する

今回のアップデートで特に注目されるのが、画像やPDFファイルをアップロードし、その内容についてAIに質問できる機能です。これまでもスマートフォンアプリでは画像に関する質問が可能でしたが、これがデスクトップでも利用可能になり、さらにPDFにも対応が拡大されます。

例えば、大学の講義で配布された心理学のPDF資料をアップロードし、「このスライドで説明されている『認知バイアス』の具体例を、日常生活の中から探して教えてください」といった質問を投げかけることができます。AIはPDFの内容を解析し、Web上の情報と照らし合わせながら、より理解を深めるための回答を生成します。これにより、手元にある資料を起点とした、よりパーソナルな学習体験が実現します。将来的にはGoogle Drive内のファイルにも対応する予定とのことです。

AIと作る学習計画「Canvas機能」

Canvas(キャンバス)は、大規模なプロジェクトや学習計画を立てる際に役立つ新機能です。AIモードで「期末試験のための学習計画を作って」のように依頼すると、「Canvasを作成」ボタンが表示されます。

クリックすると、画面のサイドパネルにAIが生成した計画案が表示されます。ユーザーはAIとの対話を続けることで、その計画を自分に合わせて修正・改良していくことができます。例えば、「歴史の範囲をもう少し細分化して」「この項目には参考になるWebサイトへのリンクを追加して」といった指示が可能です。作成したCanvasは保存され、後からいつでも見返して作業を再開できます。学習計画だけでなく、旅行の計画やレポートの構成案作成など、情報を整理しながら段階的に進める必要があるタスク全般で活用が期待されます。

見ているものをリアルタイムで解説「Search Live with video」

Search Live with videoは、スマートフォンのカメラを使った非常に先進的な機能です。これは、Googleの視覚と言語の理解能力を統合したAIアシスタント技術「Project Astra」の成果を応用したものです。

使い方は、Googleアプリ内のGoogle Lensを起動し、「Live」アイコンをタップするだけです。カメラで目の前のものを映しながら、「この実験装置の仕組みを教えて」「この植物の名前と育て方は?」といった質問を声で投げかけると、AIが映像をリアルタイムで認識し、対話形式で回答してくれます。まるで専門家が隣にいて、見ているものについて解説してくれるような体験です。静止画だけでなく、動いているものや様々な角度からの視覚情報を基に対話できるため、より直感的で深い理解が可能になります。

ブラウザで見ている画面について質問する

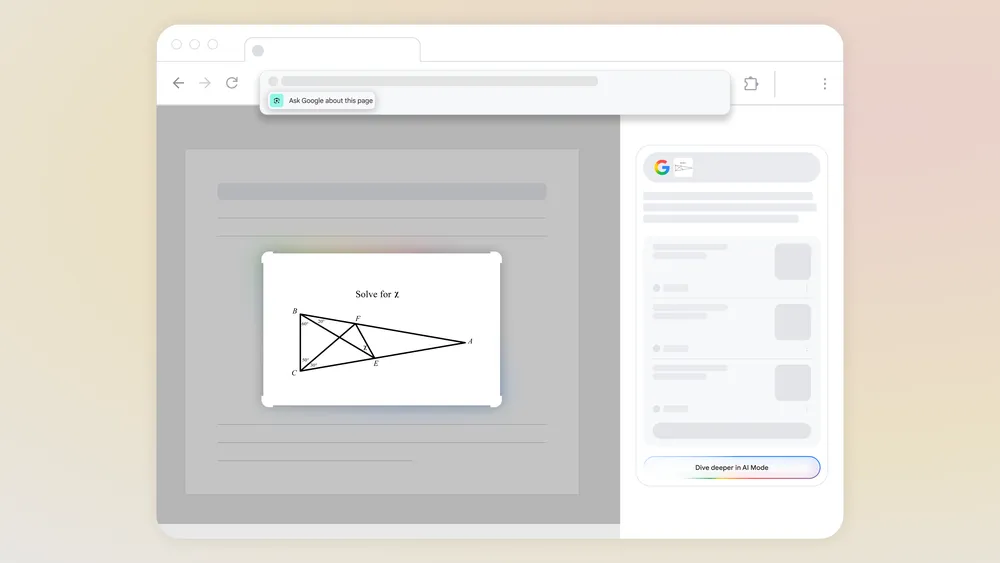

Webサイトを閲覧中に、特定の図やグラフについて詳しく知りたくなることがあります。今回のアップデートでは、Chromeブラウザとの連携が強化され、閲覧中のページに表示されている内容について直接質問できるようになります。

Chromeのアドレスバーをクリックすると、「このページについてGoogleに質問する」という新しい選択肢が表示されます。これを選んでページ内の図形問題の図を選択すると、サイドパネルにAIが生成した概要が表示されます。さらにAIモードを選択すれば、「この図形が持つ他の性質は?」「この定理を使った別の例題は?」といった深掘りの質問を続けることができます。これにより、Webブラウジングと情報探求の境界がよりシームレスになります。

まとめ

今回Googleが発表したAIモードの新機能群は、私たちが情報を「検索する」という行為を、AIと「対話しながら探求する」という、より能動的で知的な活動へと進化させるものです。PDFや画像といった手持ちの資料から、目の前のリアルな風景まで、あらゆるものが情報収集の入り口となります。また、Canvas機能のように、得た情報を整理し、計画を立てるプロセスまでをサポートすることで、学習やタスク遂行の効率を大きく向上させる可能性を秘めています。

2025年7月現在では米国など一部地域での先行提供(Labs)となっていますが、これらの機能が日本で利用可能になれば、学生の学習方法から専門家のリサーチ、さらには私たちの日常生活における情報との関わり方まで、多岐にわたる場面で大きな変化をもたらすことになるでしょう。今後の展開に大いに期待が寄せられます。