はじめに

最近、「ChatGPT」や「Gemini」といった言葉をよく耳にするようになりました。スマートフォンやパソコンで簡単に使えるこれらのAIツールは、私たちの日常生活やビジネスに大きな変化をもたらしています。しかし、「結局これらは何なのか」「どう違うのか」「今後どのように発展していくのか」という疑問を持つ方も多いでしょう。

この記事では、自然言語処理(NLP: Natural Language Processing)の歴史から最新のAIモデル、そして未来への展望まで、数式を使わずに直感的に理解できるよう解説します。

忙しい方のための要約

- 自然言語処理(NLP)は1950年代の単純なルールベースシステムから始まり、2010年代のディープラーニング革命を経て、2017年のTransformerモデルの登場で大きく変化しました。

- 現在のChatGPT(OpenAI)、Gemini(Google)、Claude(Anthropic)、Llama(Meta)などの大規模言語モデルは、各社の強みを活かした特徴を持っています。

- 今後はマルチモーダル理解の深化、推論能力の向上、専門分野への特化、デバイス上で動作するエッジAI、複数AIの協働といった方向に発展し、労働市場や教育、情報の信頼性、プライバシーなど社会的課題も生じています。

- AIと人間社会は共進化の段階に入り、両者の共存を模索していく時代になっています。

自然言語処理の歴史:単純な規則から複雑なAIへ

自然言語処理とは何か?

自然言語処理(NLP)とは、コンピュータが人間の言語を理解し、生成するための技術です。私たちが日常で使う言葉をコンピュータが「理解」して、人間のように反応できるようにする技術と言えます。

初期の自然言語処理(1950年代〜1980年代):ルールベースの時代

自然言語処理の歴史は1950年代に始まります。アラン・チューリングが提唱した「チューリングテスト」は、機械が人間と区別がつかないほど会話ができるかを測る指標となりました。

この時代の自然言語処理は「ルールベース」が中心でした。例えば、1966年に開発された「ELIZA」は、心理療法士のような応答をするプログラムでしたが、実際には単純な文章置換ルールを使っていただけでした。

人間:「私は悲しい気分です」

ELIZA:「なぜあなたは悲しい気分なのですか?」この応答は、「私は〇〇です」というパターンを見つけて「なぜあなたは〇〇なのですか?」と返すという単純なルールで実現していました。

統計的自然言語処理の台頭(1990年代〜2000年代初頭)

1990年代になると、コンピュータの処理能力の向上と大量のテキストデータの利用可能性から、統計的手法が主流になりました。言葉の出現確率や文脈での使われ方を統計的に分析し、より自然な言語処理を目指す時代です。

この時代の代表例が「Google翻訳」の初期バージョンです。大量の対訳データから単語やフレーズの翻訳確率を計算し、最も確率が高い翻訳を選んでいました。

ディープラーニングによる革命(2010年代〜)

2010年代に入ると、ディープラーニング(特に深層ニューラルネットワーク)が自然言語処理に革命をもたらしました。2013年に提案された「Word2vec」は単語を数百次元のベクトル空間に表現し、意味的な関係性を捉えることができるようになりました。

例えば、「王様」-「男性」+「女性」=「女王」のような計算が可能になったのです。これは単語の意味をコンピュータが数値的に把握し始めたことを示しています。

Transformerモデルの登場(2017年〜)

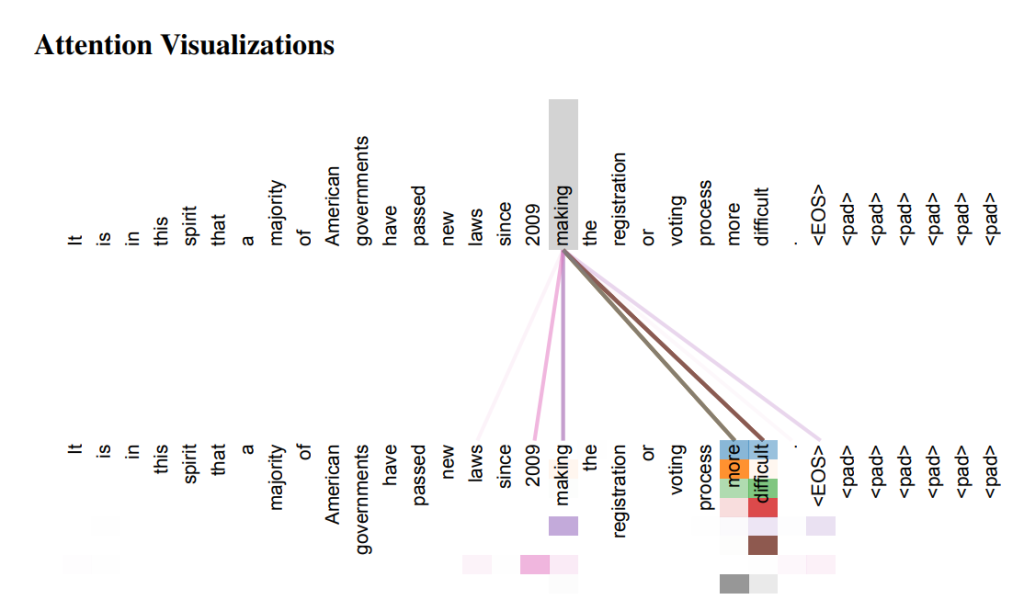

2017年にGoogleが発表した「Transformer」というモデル構造が、現代の自然言語処理の基盤となりました。Transformerは、文章中のあらゆる単語間の関係性を同時に考慮できるという特徴を持ち、従来のモデルより文脈理解能力が飛躍的に向上しました。

この論文「Attention Is All You Need」(https://arxiv.org/abs/1706.03762)は、現在のAI言語モデルの基礎となっています。

引用元:「Attention Is All You Need」(https://arxiv.org/abs/1706.03762)

大規模言語モデル(LLM)の時代(2018年〜現在)

Transformerをベースにして、GPT(Generative Pre-trained Transformer)、BERT、T5などの「事前学習済み言語モデル」が開発されました。特に2018年のGPT、2019年のGPT-2、2020年のGPT-3と進化し、モデルサイズと性能が飛躍的に向上しました。

GPT-3は1750億のパラメータを持ち、膨大なインターネット上のテキストで学習されました。この大規模化によって、特定のタスク向けに細かく調整しなくても、様々な言語タスクをこなせるようになったのです。

現在の主要な大規模言語モデル(LLM)と開発組織

現在、多くの人が利用している主要な大規模言語モデルについて見ていきましょう。

OpenAIとChatGPT/GPT-4

OpenAIは2015年に非営利組織として設立され、後に営利部門も設けられました。創設者にはイーロン・マスク(後に離脱)やサム・アルトマンなどがいます。2022年11月に一般公開されたChatGPTは、対話に特化したGPT-3.5をベースとしたモデルで、爆発的な人気を集めました。

2023年3月には、さらに高性能なGPT-4が発表され、テキスト理解・生成能力がさらに向上しただけでなく、画像理解能力も加わりました。GPT-4は多くの専門職試験で人間と同等以上の成績を収めるなど、その能力の高さが証明されています。

ChatGPTの特徴:

- 広範な知識ベース

- 自然な対話能力

- 文章生成の流暢さ

- サービスとしての使いやすさ

- OpenAI: https://openai.com/ja-JP/

- ChatGPT: https://chatgpt.com

GoogleとBard/Gemini

GoogleはBERTやT5など多くの言語モデルの研究を主導してきましたが、ChatGPTの成功を受けて2023年に対話型AI「Bard」をリリースしました。その後、Bardは「Gemini」にリブランドされ、さらに高性能なモデルとなっています。

Geminiは特に多モーダル(テキスト、画像、音声など複数の形式のデータを扱う)能力に優れており、Googleの検索やAndroidデバイスとの連携を強みとしています。

Geminiの特徴:

- Google検索との統合

- 多モーダル処理能力

- リアルタイム情報へのアクセス

- Googleのサービスエコシステムとの連携

- Google AI: https://ai.google/

- Gemini: https://gemini.google.com/app

AnthropicとClaude

Anthropicは2021年にOpenAIの元研究者らによって設立されました。同社の「Claude」シリーズは、特に安全性と「Constitutional AI」というアプローチを重視しています。これは、AIが従うべき原則(「憲法」)を設定し、それに基づいて学習させる手法です。

Claudeの特徴:

- 安全性と倫理的配慮の強調

- 長文の処理能力

- 自然で人間らしい対話スタイル

- より控えめで誤情報を広げにくい設計

- Anthropic: https://www.anthropic.com/

- Claude: https://claude.ai/new

Meta AIとLlama

Metaは2023年2月にLlama(ラマ)という大規模言語モデルを発表し、後にLlama 2を一般公開しました。特筆すべきは、商用利用も含めて無料で公開されていることで、これによりオープンソースコミュニティでの言語モデル開発が加速しました。

Llamaの特徴:

- オープンソースでの提供

- 個人のコンピュータでも動作可能なサイズのバリエーション

- コミュニティによる改良の可能性

- プライバシーを重視した自己ホスティング可能なモデル

- Meta AI: https://ai.meta.com/

- Llama: https://www.llama.com/

MistralとMistral AI

フランスのスタートアップMistral AIは、効率的なモデル設計で注目を集めています。比較的小さなモデルサイズながら高性能を実現し、オープンソースと商用モデルの両方を提供しています。

Mistralの特徴:

- 効率的なモデル設計

- 多言語サポート

- オープンソースと商用の両立

- ヨーロッパ発のAI技術としての位置づけ

- Mistral: https://mistral.ai/

- Mistral AI: https://chat.mistral.ai/chat?q=

サービスやモデル間の違いによる影響

一般ユーザーにとって、これらのモデルやサービスの違いは主に以下の点に現れます。

- 知識の新しさ:

GPT-4やGeminiは定期的に更新され、比較的新しい情報にアクセスできます。特にGeminiはGoogle検索と連携してリアルタイムの情報を提供できる場合があります。 - 得意分野:

Geminiは検索と情報統合、GPT-4は創造的な文章生成、Claudeはより慎重な回答と倫理的考慮、Llamaはカスタマイズ性に強みがあります。 - 使いやすさとアクセス:

ChatGPTは使いやすいインターフェースとモバイルアプリの提供、Geminiは既存のGoogleサービスとの統合、Claudeはウェブインターフェースの簡潔さを特徴としています。 - 利用制限と価格:

無料版と有料版で利用できる機能や応答速度、利用回数に違いがあります。

自然言語処理の将来展望

理解の深化:世界知識とマルチモーダルの統合

今後のAIモデルは、より深い「世界知識」を持ち、テキストだけでなく画像、音声、動画など様々な形式の情報を統合的に理解するマルチモーダル能力が向上するでしょう。

例えば、現在のGPT-4VやGeminiはすでに画像を理解できますが、将来的には動画の内容や状況の理解、音楽の感情分析なども発展すると考えられます。

推論能力の向上

現在のモデルは膨大な相関関係を学習していますが、因果関係の理解や複雑な推論は発展途上です。論理的思考や複数のステップを要する問題解決能力は、今後大きく向上する可能性があります。

「Chain-of-Thought」(思考の連鎖)手法やDeepMindの「Gopher」などの研究がすでに進められており、より明示的な推論能力を持つモデルの開発が期待されています。

専門化とカスタマイズ

汎用的な大規模モデルから、医療、法律、科学研究など特定分野に特化した専門モデルの開発が進むでしょう。また、個人やビジネスのニーズに合わせてカスタマイズできる柔軟なモデルも増えていくと予想されます。

すでにGPT-4では「GPTs」というカスタムバージョンの作成が可能になっています。今後はより深いレベルでのカスタマイズや、個人のデータに基づいた「パーソナルAI」の発展も期待されます。

プライバシーと効率性の向上

クラウド上の大規模モデルだけでなく、個人のデバイス上で動作する小型で効率的なモデル(「エッジAI」)の開発も進んでいます。これにより、プライバシー保護と即時応答性を両立させることが可能になります。

MistralやLlamaのようなモデルはすでにこの方向性を示しており、今後も発展が期待されます。

AI同士の協働とエージェント化

複数のAIモデルが協力して問題を解決したり、人間に代わって特定のタスクを自律的に実行したりする「AIエージェント」の発展も重要なトレンドです。

OpenAIの「GPT-4 with Assistants API」やAnthropicの「Claude Opus」など、すでにこの方向への取り組みが始まっています。

信頼性と説明可能性の向上

AIモデルが「なぜその回答を出したのか」を説明できる「説明可能なAI(XAI: eXplainable AI)」の研究も進んでいます。特に医療診断や法的判断など重要な決定を支援する場面では、その理由を人間が理解できることが重要です。

社会的影響と課題

労働市場への影響

AIによる自然言語処理の発展は、翻訳、コンテンツ作成、カスタマーサポート、法務、医療など様々な職種に影響を与えます。単純な作業は自動化される一方、AIと協働する新たな役割も生まれるでしょう。

あるレポートによれば、現在の労働活動の約60-70%がAI技術によって影響を受ける可能性があるとされています。

教育と学習の変化

AIアシスタントは個別指導やパーソナライズされた学習体験を提供し、教育のあり方を大きく変える可能性があります。一方で、批判的思考力や創造性をどう育むかという課題も生じています。

情報の信頼性と「深層偽造」(ディープフェイク)

AIによる文章や画像、音声の生成能力の向上は、フェイクニュースや詐欺的コンテンツの高度化につながる懸念もあります。情報の信頼性を確保するための技術的・社会的対策が重要になります。

プライバシーと監視の問題

AIの言語理解能力は、個人的なコミュニケーションの分析や監視にも利用される可能性があり、プライバシーの問題を引き起こします。適切な規制と倫理的ガイドラインの整備が必要です。

まとめ:共進化するAIと人間社会

自然言語処理技術は、単純なルールベースのシステムから始まり、統計的手法を経て、現在の大規模言語モデルへと発展してきました。ChatGPTやGemini、Claude、Llamaなどの現代のAIモデルは、それぞれに特徴を持ちながら、人間の言語理解に近づきつつあります。

将来的には、より深い理解力や推論能力、専門性を持ち、私たちの生活や仕事の多くの場面で活用されるでしょう。一方で、雇用の変化、情報の信頼性、プライバシーなど多くの社会的課題も生じています。

私たちは今、AIと人間社会が共に進化する時代の入り口に立っています。技術の発展を理解し、その可能性と課題を認識することで、AIとの共存をより良いものにしていくことができるでしょう。

参考文献

- Vaswani, A., et al. (2017). “Attention Is All You Need”. https://arxiv.org/abs/1706.03762

- Brown, T. B., et al. (2020). “Language Models are Few-Shot Learners”. https://arxiv.org/abs/2005.14165

- Ouyang, L., et al. (2022). “Training language models to follow instructions with human feedback”. https://arxiv.org/abs/2203.02155

- Bai, Y., et al. (2022). “Constitutional AI: Harmlessness from AI Feedback”. https://arxiv.org/abs/2212.08073

- Wei, J., et al. (2022). “Chain of Thought Prompting Elicits Reasoning in Large Language Models”. https://arxiv.org/abs/2201.11903