はじめに

Google Researchが2025年10月14日、エッジデバイス向けの新たなAIプラットフォーム「Coral NPU」を発表しました。ウェアラブルやIoTデバイス上で常時稼働するAIを実現するために設計されたオープンソースのフルスタックプラットフォームです。本稿では、発表内容をもとに、Coral NPUのアーキテクチャ、開発環境、そして目指す未来について解説します。

参考記事

- タイトル: Introducing Coral NPU: A full-stack platform for Edge AI

- 著者: Billy Rutledge

- 発行元: Google Developers Blog

- 発行日: 2025年10月14日

- URL: https://developers.googleblog.com/ja/introducing-coral-npu-a-full-stack-platform-for-edge-ai/

・本稿中の画像に関しては特に明示がない場合、引用元記事より引用しております。

・記載されている情報は、投稿日までに確認された内容となります。正確な情報に関しては、各種公式HPを参照するようお願い致します。

・内容に関してはあくまで執筆者の認識であり、誤っている場合があります。引用元記事を確認するようお願い致します。

要点

- Coral NPUは、エッジデバイス上で低消費電力かつ常時稼働するAIを実現するための、オープンソースのフルスタックプラットフォームである

- パフォーマンスギャップ、フラグメンテーション、ユーザー信頼という3つの根本的な課題に対処するために設計されている

- RISC-V準拠のアーキテクチャを採用し、スカラーコア、ベクター実行ユニット、マトリックス実行ユニットで構成される

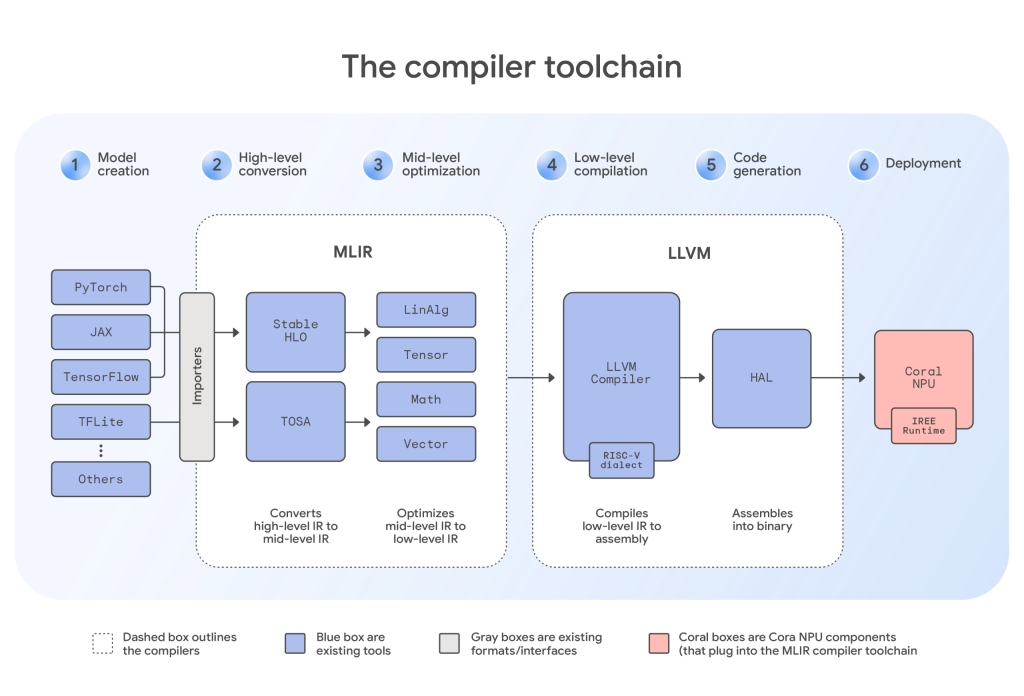

- IREE、TFLM、MLIRなど標準的なコンパイラツールチェーンに対応し、TensorFlow、JAX、PyTorchなどのフレームワークを統一的に扱える

- Synapticsが初の商用実装製品「Astra SL2610」を発表し、産業用およびコンシューマー向けIoTシステムでの実用化が進んでいる

詳細解説

エッジAIが直面する3つの課題

公式発表によれば、Coral NPUは「クラウドからパーソナルデバイスへ」というAIの移行において、3つの根本的な問題を解決するために開発されました。

第一にパフォーマンスギャップの問題があります。最先端の機械学習モデルは高い計算能力を必要としますが、エッジデバイスは電力、熱、メモリの制約が厳しく、クラウドと同等の処理を実現することが困難でした。

第二にフラグメンテーションの問題です。多様なプロプライエタリプロセッサに対してMLモデルをコンパイル・最適化することは難しく、コストもかかります。これが、デバイス間で一貫したパフォーマンスを実現する妨げになっていました。

第三にユーザー信頼の欠如があります。パーソナルAIが真に役立つものになるには、個人データとコンテキストのプライバシーとセキュリティを優先する必要がありますが、既存のアーキテクチャではこれが十分に担保されていませんでした。

これらの課題に対処するため、Coral NPUはGoogle ResearchとGoogle DeepMindとの共同設計により開発されました。

AI優先のアーキテクチャ設計

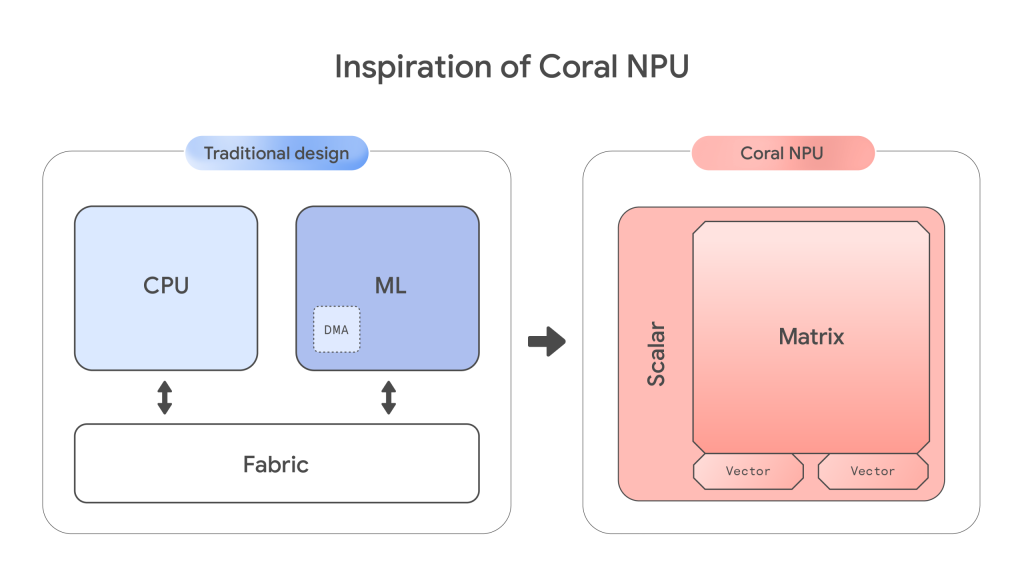

公式発表では、従来のチップ設計を逆転させたアプローチが説明されています。従来、低消費電力エッジデバイス向けの開発者は、汎用CPUと特化型アクセラレーターのどちらかを選ばなければなりませんでした。汎用CPUは柔軟性と広範なソフトウェアサポートを提供しますが、ML処理には非効率的です。一方、特化型アクセラレーターはML処理効率は高いものの、柔軟性に欠け、プログラミングが難しく、汎用タスクには不向きでした。

Coral NPUは、スカラー演算よりもMLマトリックスエンジンを優先することで、シリコンレベルからAI処理に最適化されたアーキテクチャを実現しています。これにより、より効率的なオンデバイス推論が可能になります。

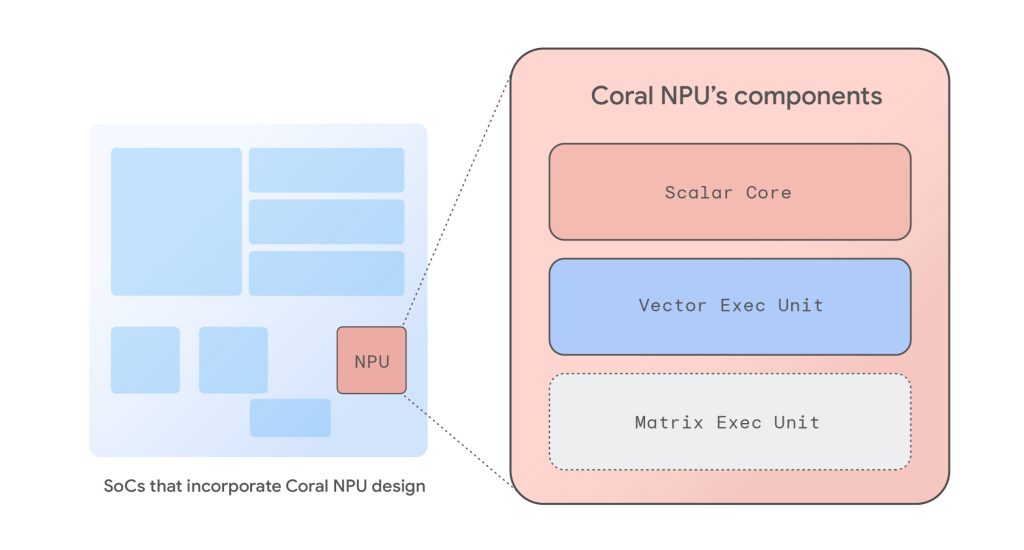

具体的なアーキテクチャとして、以下の3つのコンポーネントが組み込まれています。

スカラーコアは、軽量でC言語でプログラム可能なRISC-Vフロントエンドです。バックエンドコアへのデータフローを管理し、「run-to-completion」モデルを使用することで、超低消費電力と従来のCPU機能を実現します。

ベクター実行ユニットは、RISC-Vベクター命令セット(RVV) v1.0に準拠した堅牢なSIMDコプロセッサです。大規模データセットに対する同時操作を可能にします。

マトリックス実行ユニットは、高効率な量子化外積乗算累積(MAC)エンジンで、ニューラルネットワークの基本的な演算を加速するために特別に設計されています。なお、このマトリックスコアは現在開発中で、2025年後半にGitHubでリリースされる予定です。

基本設計では、わずか数ミリワットの消費電力で512 GOPS(ギガオペレーション/秒)のパフォーマンスを提供します。これにより、エッジデバイス、ヒアラブル、ARグラス、スマートウォッチなどで強力なオンデバイスAIが可能になります。

統一された開発者体験

公式発表によれば、Coral NPUアーキテクチャはシンプルでC言語でプログラム可能なターゲットであり、IREEやTFLMなどの最新コンパイラとシームレスに統合できます。これにより、TensorFlow、JAX、PyTorchなどのMLフレームワークを容易にサポートできます。

具体的なツールチェーンとしては、TensorFlow向けのTFLMコンパイラなどの専門ソリューションに加え、汎用MLIRコンパイラ、Cコンパイラ、カスタムカーネル、シミュレーターが含まれています。

開発フローの例として、JAXなどのフレームワークからのモデルは、まずStableHLO dialectを使用してMLIR形式にインポートされます。この中間ファイルは、Coral NPUのアーキテクチャを認識するハードウェア固有のプラグインを適用するIREEコンパイラに渡されます。そこから、コンパイラは段階的な低レベル化(progressive lowering)を実行します。これは、コードを一連のdialectを通じて体系的に変換し、マシンのネイティブ言語に近づけていく重要な最適化ステップです。最適化後、ツールチェーンはエッジデバイス上で効率的に実行できる、最終的なコンパクトなバイナリファイルを生成します。

さらに注目すべき点として、Coral NPUの共同設計プロセスは2つの重要な領域に焦点を当てています。第一に、現在のオンデバイスビジョンおよびオーディオアプリケーションで使用されている主要なエンコーダーベースアーキテクチャを効率的に加速します。第二に、小規模トランスフォーマーモデルに対してCoral NPUを最適化するため、Gemmaチームと緊密に協力しています。

この二重の焦点により、Coral NPUはウェアラブルデバイスにLLMをもたらすように設計された、初のオープンで標準ベースの低消費電力NPUになる見込みです。

想定されるアプリケーション

公式発表では、Coral NPUが超低消費電力で常時稼働するエッジAIアプリケーション、特にアンビエントセンシングシステムに焦点を当てて設計されていると説明されています。主な目標は、ウェアラブル、モバイルフォン、IoTデバイスで終日AI体験を可能にしながら、バッテリー使用を最小限に抑えることです。

具体的なユースケースとして、以下が挙げられています。

コンテキスト認識では、ユーザーの活動(歩行、ランニングなど)、近接性、環境(屋内/屋外、移動中など)を検出し、「応答不可」モードやその他のコンテキストに応じた機能を有効にします。

音声処理では、音声・発話検出、キーワードスポッティング、リアルタイム翻訳、文字起こし、音声ベースのアクセシビリティ機能が実現できます。

画像処理では、人物・物体検出、顔認識、ジェスチャー認識、低消費電力ビジュアル検索が可能になります。

ユーザーインタラクションでは、手のジェスチャー、音声キュー、その他のセンサー駆動入力による制御が実現できます。

ハードウェアレベルで担保されるプライバシー

公式発表によれば、Coral NPUの中核原則は、ハードウェアで強制されるセキュリティを通じてユーザーの信頼を構築することです。アーキテクチャは、きめ細かいメモリレベルの安全性とスケーラブルなソフトウェア区画化を提供するCHERIなどの新興技術をサポートするように設計されています。

このアプローチにより、機密性の高いAIモデルと個人データをハードウェアで強制されたサンドボックスに隔離し、メモリベースの攻撃を軽減できる可能性があります。

エコシステムの構築

オープンハードウェアプロジェクトが成功するには、強力なパートナーシップが不可欠です。公式発表では、Googleの最初の戦略的シリコンパートナーであるSynapticsとの協業が紹介されています。Synapticsは、IoT向けの組み込みコンピューティング、ワイヤレス接続、マルチモーダルセンシングのリーダー企業です。

2025年10月14日のTech Dayで、Synapticsは新しい「Astra SL2610」AI-Native IoTプロセッサ製品ラインを発表しました。この製品ラインには、Coral NPUアーキテクチャを業界で初めて商用実装した「Torq NPU」サブシステムが搭載されています。

このNPU設計はトランスフォーマー対応で、動的オペレーターをサポートしており、開発者がコンシューマーおよび産業用IoT向けの将来対応型エッジAIシステムを構築できるようになっています。

Synaptics Torq Edge AIプラットフォームは、IREEとMLIRベースのオープンソースコンパイラとランタイム上に構築されており、統一された開発者体験というGoogleのコミットメントを支援しています。

まとめ

Coral NPUは、エッジデバイス上で常時稼働する低消費電力AIを実現するための、包括的なプラットフォームです。RISC-V準拠のオープンアーキテクチャ、統一された開発環境、そしてハードウェアレベルのプライバシー保護という特徴を持ち、ウェアラブルやIoTの未来を形作る可能性を秘めています。Synapticsとの提携により、すでに商用実装も始まっており、今後のエコシステムの広がりに期待したいところです。