はじめに

近年、大規模言語モデル(LLM)を活用したAIアプリケーションは目覚ましい進化を遂げています。しかし、音声や映像といった複数のデータをリアルタイムで処理する高度なアプリケーションを開発する現場では、様々な処理を繋ぎ合わせる作業が複雑化し、コードが壊れやすく、メンテナンスが困難になるという課題に直面していました。

本稿では、この課題を解決するためにGoogle DeepMindが発表したオープンソースのPythonライブラリ「GenAI Processors」について、Google Developers Blogの記事「Announcing GenAI Processors: Build powerful and flexible Gemini applications」を基に解説していきます。

参考記事

- タイトル: Announcing GenAI Processors: Build powerful and flexible Gemini applications

- 発行元: Google Developers Blog

- 発行日: 2025年7月10日

- URL: https://developers.googleblog.com/2024/07/announcing-genai-processors-build-powerful-and-flexible-gemini-applications.html

公式HP

・公式Github:https://github.com/google-gemini/genai-processors

・公式GoogleColab:https://colab.research.google.com/github/google-gemini/genai-processors/blob/main/notebooks/processor_intro.ipynb

・本稿中の画像に関しては特に明示がない場合、引用元記事より引用しております。

・記載されている情報は、投稿日までに確認された内容となります。正確な情報に関しては、各種公式HPを参照するようお願い致します。

・内容に関してはあくまで執筆者の認識であり、誤っている場合があります。引用元記事を確認するようお願い致します。

要点

- GenAI Processorsは、LLM、特にGeminiを用いた高度なAIアプリケーション開発の複雑さを解消し、構造化するためのオープンソースPythonライブラリである。

- データ処理、モデル呼び出しといった全ての処理を「Processor」という統一されたインターフェースに抽象化し、部品のように組み合わせることで開発を簡素化する。

- 全ての入出力は非同期のデータストリームとして扱われ、処理の並行実行が自動的に最適化されるため、リアルタイム応答性に優れたアプリケーションを容易に構築できる。

- モジュール化、Gemini APIとのシームレスな統合、高い拡張性が特徴であり、開発者はより本質的なロジックの実装に集中できる。

詳細解説

なぜ今「GenAI Processors」が必要なのか? AI開発の「複雑なパズル」

今日のAIアプリケーションは、単にテキストを生成するだけでなく、ユーザーの音声を聞き取り、カメラの映像を認識しながら、リアルタイムで対話するような高度な機能が求められています。このようなアプリケーションを開発することは、「複雑なパズルを組み立てるようなもの」と表現されているように、非常に困難な作業でした。

具体的には、以下のような課題がありました。

- 多様なデータ処理: 音声データ、映像データ、テキストデータなど、形式の異なるデータをそれぞれ適切に前処理する必要がある。

- 非同期処理の複雑さ: ユーザーからの入力を待ち受けながら、同時にモデルからの応答を処理するといった「待ち」が発生する処理(非同期処理)を管理するのが難しい。

- コードの保守性: 様々な処理を力技で繋ぎ合わせると、コードの依存関係が複雑になり、少しの修正が全体に影響を及ぼす「壊れやすい」コードになりがち。

GenAI Processorsは、これらの課題を解決するために、開発プロセスに「構造」と「シンプルさ」をもたらすことを目指して設計されました。

GenAI Processorsの核心:統一された「Processor」とデータの「ストリーム」

GenAI Processorsを理解する上で最も重要な概念が「Processor」と「非同期ストリーム」です。

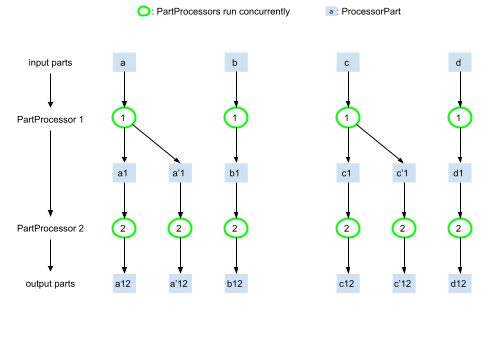

- Processor(プロセッサ):

これは「特定の処理を行う独立した部品」と考えることができます。「マイクから音声を取得する」「テキストを音声に変換する」「Geminiモデルに応答を生成させる」といった一つ一つの機能が、すべてProcessorという統一された形式で定義されます。これにより、複雑な処理を小さな部品に分割して管理できるようになります。 - 非同期ストリーム(Asynchronous Stream):

すべてのデータは、ProcessorPartと呼ばれる標準化された形式で、非同期のストリーム(データの流れ)に乗って処理されます。これは、工場で製品がベルトコンベアを流れていく様子に似ています。データ(部品)はストリーム(ベルトコンベア)に乗り、各Processor(作業工程)を通過することで、次々と処理されていきます。

このライブラリの画期的な点は、これらのProcessorを、まるで足し算をするかのように「+」演算子で直感的に連結できることです。

# 例:マイク入力 → Gemini Live API → 音声出力 というエージェントの構築

from genai_processors.core import audio_io, live_model, video

# Input processor: combines camera streams and audio streams

input_processor = video.VideoIn() + audio_io.PyAudioIn(...)

# Output processor: plays the audio parts. Handles interruptions and pauses

# audio output when the user is speaking.

play_output = audio_io.PyAudioOut(...)

# Gemini Live API processor

live_processor = live_model.LiveProcessor(...)

# Compose the agent: mic+camera -> Gemini Live API -> play audio

live_processor = live_model.LiveProcessor(...)

live_agent = input_processor + live_processor + play_output

async for part in live_agent(streams.endless_stream()):

# Process the output parts (e.g., print transcription, model output, metadata)

print(part)このように、複雑なデータフローをシンプルで可読性の高いコードで表現できるため、開発者はパイプライン全体の流れを容易に把握できます。

技術的ハイライト:応答性を最大化する「並行実行の自動最適化」

GenAI Processorsのもう一つの強力な特徴は、処理の並行実行をライブラリが自動的に最適化してくれる点です。

例えば、「ユーザーの顔を認識する処理」と「ユーザーの音声をテキストに変換する処理」を同時に実行したい場合、従来は複雑な並行処理のコードを書く必要がありました。しかし、GenAI Processorsでは、連結されたProcessorの依存関係を解析し、実行可能な処理から自動的に並行して実行します。

これにより、TTFT(Time To First Token)、つまりユーザーがアクションを起こしてからAIが最初の応答を返すまでの時間を大幅に短縮できます。これは、リアルタイム性が求められる対話型AIなどにおいて、ユーザー体験を決定づける非常に重要な要素です。

GenAI Processorsがもたらす5つのメリット

GenAI Processorsの優れた設計思想として以下の5点が挙げられています。

- モジュール設計: 処理を再利用可能な部品に分割することで、テストや保守が容易になります。

- 非同期 & 並行: Pythonのasyncioを最大限に活用し、開発者が複雑な並行処理を意識することなく、応答性の高いアプリを構築できます。

- Gemini APIとの統合: Gemini API、特にリアルタイム処理を行うLive APIとの連携が非常に簡単になる専用Processorが用意されています。

- 拡張性: 開発者は独自のProcessorを簡単に作成でき、外部APIや独自のロジックをシームレスにパイプラインへ組み込めます。

- 統一されたマルチモーダル処理: テキスト、画像、音声といった多様なデータをProcessorPartという統一されたラッパーで扱うため、データ形式の違いを意識する必要がありません。

実際の使い方

ライブラリーをインストールすれば、すぐに利用を開始できます。(Python 3.10以上)

pip install genai-processors以下のように利用できます。

from genai_processors import content_api

from genai_processors import streams

# Create an input stream (strings are automatically cast into Parts).

input_parts = ["Hello", content_api.ProcessorPart("World")]

input_stream = streams.stream_content(input_parts)

# Apply a processor to a stream of parts and iterate over the result

async for part in simple_text_processor(input_stream):

print(part.text)

... 詳しくは、以下の公式ドキュメント等から使い方を学べます。

・公式Github:https://github.com/google-gemini/genai-processors

・公式GoogleColab:https://colab.research.google.com/github/google-gemini/genai-processors/blob/main/notebooks/processor_intro.ipynb

まとめ

GenAI Processorsは、これまで複雑で困難だった高度なAIアプリケーション、特にマルチモーダル入力をリアルタイムで扱うシステムの開発に、構造化されたシンプルさと高い生産性をもたらす画期的なライブラリです。

処理を「Processor」という部品に分け、それらをストリーム上で繋ぎ合わせるというアプローチにより、開発者はコードの複雑な管理から解放され、アプリケーションの創造的な側面に集中できるようになります。

このライブラリはまだ初期段階ですが、Geminiの能力を最大限に引き出すための強力な基盤となることは間違いありません。オープンソースとして公開されているため、誰でも利用でき、開発に貢献することが可能です。ぜひGitHubリポジトリを訪れ、その可能性を体験してみてください。