はじめに

本稿では、最新の大規模言語モデル(LLM)の能力を評価する新しいアプローチとして、古典的なテキストアドベンチャーゲームが注目されている現状について解説します。

参考記事

- タイトル: Classic text games are the new frontier for AI benchmarking

- 著者: Antonia Davison

- 発行元: IBM Think

- 発行日: 2025年9月23日

- URL: https://www.ibm.com/think/news/textquests-new-frontier-ai-benchmarking

要点

- AI研究者は、大規模言語モデル(LLM)の推論能力を測定するためのベンチマークとして、1970年代から80年代にかけて流行した古典的なテキストアドベンチャーゲームを再利用している。

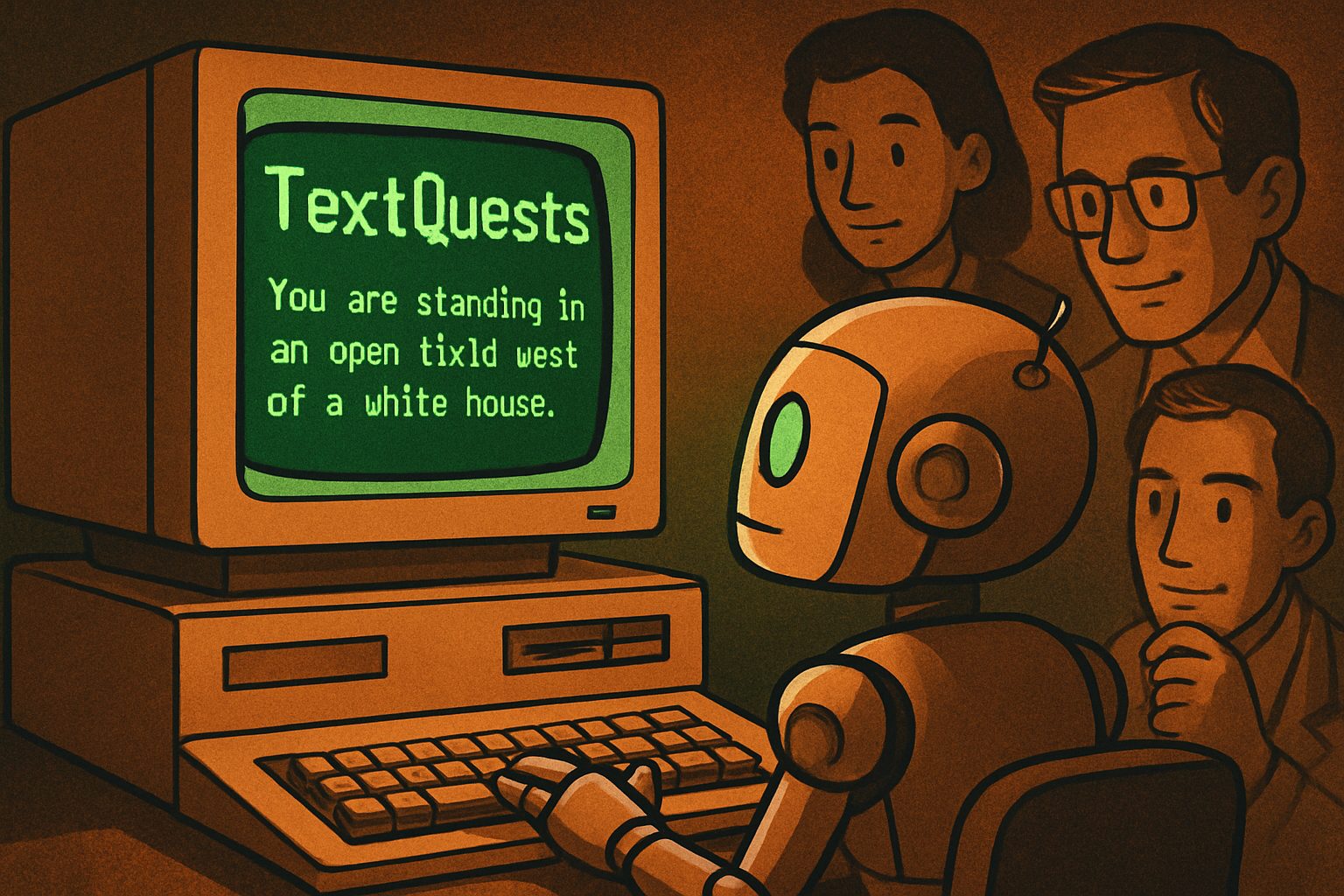

- 新しいツール「TextQuests」は、これらのゲームを用いて、視覚情報に頼らない純粋なテキストベースのシナリオでAIのエージェントとしての能力を評価することを目指すものである。

- 実験結果から、最先端のLLMでさえ、ヒントなしではオープンエンドな問題解決に苦戦することが明らかになった。これは、未知のアイデアを探求し、統合する能力がまだ発展途上であることを示唆している。

- これらのゲームが真の「知能」テストとなり得るかについては議論がある。LLMが訓練データに含まれるゲームの情報を記憶しているだけで、純粋な推論を行っているわけではない可能性が指摘されている。

- それでもなお、TextQuestsのようなベンチマークは、AIの予期せぬ振る舞いや思考パターンを理解する上で価値があり、より複雑な実世界の問題解決能力を開発するための重要なステップと見なされている。

詳細解説

テキストだけで世界を構築したゲームたち

1970年代後半、コンピューターゲームはまだグラフィックを持たず、プレイヤーはテキストのみで冒険を進めていました。「GO NORTH(北へ行け)」「TAKE LANTERN(ランタンを取れ)」といったコマンドを打ち込むと、ゲームが物語の断片や状況を描写して応答する、対話形式のゲームです。

このジャンルの先駆けとなったのが、1976年の『Colossal Cave Adventure』や、それに影響を受けて開発された『Zork』です。『Zork』は単純な2単語の命令だけでなく、「unlock the box with the brass key(真鍮の鍵で箱を開けろ)」といった、より複雑な文章を理解できました。これらのゲームは、視覚情報が一切ないにもかかわらず、何百もの部屋が繋がった広大な世界をテキストだけで表現しており、その構造的な複雑さが、現代のAI研究者たちを惹きつけています。

なぜLLMは『Zork』をプレイするのか?新ベンチマーク「TextQuests」

AIの能力を評価する際、例えばAIにゲームをプレイさせるベンチマークは多く存在します。しかし、グラフィックを持つゲームでは、AIが映像をどれだけうまく理解しているかという「視覚理解能力」と、状況を論理的に判断する「推論能力」が混ざってしまい、後者だけを正確に評価することが困難でした。

そこで登場したのが、本稿で紹介する新しいツール「TextQuests」です。このツールは、Center for AI Safetyの研究者であるLong Phan氏らが開発したもので、Infocom社が発売した25の古典的テキストゲームを現代のフォーマットで復活させました。目的は、視覚情報を完全に排除し、LLMの純粋な論理的・認知的思考力を測定することです。Phan氏は「テキストベースのゲームは、我々が評価したい核となる認知能力を分離し、測定することを可能にする」と述べています。

LLMがダンジョンに入ると何が起きるか

TextQuestsを用いた実験の結果は、LLMの進歩と限界の両方を浮き彫りにしました。

- 大規模なモデルほど高性能: より大きなLLMの方が、小さなモデルよりも一貫して高い成績を収めました。しかし、ジョージア工科大学のMark Riedl教授は、これは単に「大きなモデルほど訓練データの中に『Zork』のような有名なゲームの攻略法を記憶している可能性が高い」ためかもしれず、真に未知の状況に対応する能力を測るには、むしろ小規模モデルの方が適しているかもしれないと指摘しています。

- ヒントなしでは苦戦: 最も印象的だったのは、Anthropic社、Google社、OpenAI社の最先端の巨大モデルでさえ、ヒントがなければゲームの単純な序盤すら突破するのに苦労したという事実です。これは、現在のLLMが数学のような閉じられた問題解決は得意としつつも、自ら探求し、新しいアイデアを統合して問題を解決するオープンエンドな能力には、まだ課題があることを示唆しています。

- 「理解」ではなく「用心」: あるゲームでは、モデルが危険な道を歩いて降りる代わりに、魔法の力で崖をテレポートして移動するという安全策を取りました。専門家はこれを、状況を深く理解した上での判断ではなく、「創発的な用心深さ(emergent caution)」、つまりリスクを避けることを優先した結果ではないかと分析しています。

テキストゲームは本当に「知能」のテストか?

このアプローチに対して、懐疑的な見方も存在します。ビデオゲームライターのCara Ellison氏は、このベンチマークは推論能力ではなく記憶力をテストしているに過ぎないのではないかと主張します。「LLMにテキストゲームをプレイさせることは、『考えろ』と命令しているのではなく、『この言語表現に出会ったことがあるか』と尋ねているのと同じです」と彼女は語ります。

また、ゲームは元来、人間が楽しむために人間によって設計されたパズルであり、それを機械の知能テストとして使うこと自体の妥当性に疑問を呈しています。

AIエージェントを評価するツールとしての未来

こうした議論はありつつも、TextQuestsのようなベンチマークは、AIモデルの予期せぬ振る舞いや推論のパターンを明らかにする上で非常に有用だと考えられています。IBMの専門家であるJosh Spurgin氏は、「モデルが自信満々に間違った選択をした場合、なぜそれが最善手だと判断したのか、その推論過程を理解することに非常に興味がある」と述べています。

Riedl教授は、テキストゲームを足がかりに、AIが『ダンジョンズ&ドラゴンズ』のような、より創造的でオープンエンドなテーブルトークRPGをプレイできるようになり、将来的にはビジネスや法律といった実社会におけるチームでの問題解決に応用されるという壮大な展望を描いています。

開発者のPhan氏も、TextQuestsがAIコミュニティで標準的なツールとして採用され、人間レベルのエージェントに向けた進捗を測る一助となることを期待しています。

まとめ

本稿では、古典的なテキストアドベンチャーゲームが、現代のLLMの推論能力を評価するための新しいベンチマークとして利用されている事例を紹介しました。新ツール「TextQuests」による評価から、最先端のLLMでさえ、ヒントなしではオープンエンドな問題解決に苦労するという実態が明らかになりました。

これが真の「知能」を測るテストと言えるかについては議論の余地があるものの、AIの思考プロセスを深く理解し、その能力の限界と可能性を探る上で、このユニークなアプローチが重要な役割を担っていることは間違いありません。テキストというシンプルな情報から、いかにして複雑な世界を理解し、問題を解決していくか。この古典的でありながら新しい挑戦は、AIがより人間らしい思考を獲得するための重要な一歩となるでしょう。