はじめに

本稿では、2025年7月に発表された中国Moonshot AI社の革新的なAIモデル「Kimi K2」について、技術的特徴、性能評価、そして日本への影響を詳細に解説します。DeepSeek R1に続く「第二のDeepSeekモーメント」として研究コミュニティに衝撃を与えたこのモデルの全貌を、最新の技術情報とともに明らかにします。

参考記事

記事1:Natureニュース記事

- タイトル:’Another DeepSeek moment’: Chinese AI model Kimi K2 stirs excitement

- 著者:Elizabeth Gibney

- 発行元:Nature

- 発行日:2025年7月17日

- URL:https://www.nature.com/articles/d41586-025-02275-6

記事2:Moonshot AI公式発表

- タイトル:Kimi K2: Open Agentic Intelligence

- 著者:Moonshot AI

- 発行元:Moonshot AI

- 発行日:2025年7月11日

- URL:https://moonshotai.github.io/Kimi-K2/

記事3:公式GitHub リポジトリ

- タイトル:Kimi K2 Official Repository

- 著者:Moonshot AI

- 発行元:GitHub

- URL:https://github.com/MoonshotAI/Kimi-K2

要点

- Kimi K2は、中国Moonshot AI社が開発した1兆パラメータのオープンソース大規模言語モデルである

- DeepSeek R1に続く「第二のDeepSeekモーメント」として、研究コミュニティに大きな衝撃を与えている

- 特にコーディング、文章作成、エージェンシー(自律的タスク実行)において優秀な性能を示している

- 従来のプロプライエタリモデルと同等以上の性能を、無料のオープンソースモデルで実現している

- MoE(Mixture of Experts)アーキテクチャにより、実際の動作時は320億パラメータのみを使用する効率的な設計

- 新開発のMuonClip最適化手法により、大規模モデルの安定的な学習を実現

- 日本の研究者や開発者も自由に利用、改良、商用利用が可能

詳細解説

Kimi K2とは何か

Kimi K2は、北京に拠点を置くスタートアップ企業Moonshot AI(2023年3月設立)が開発した大規模言語モデルです。1兆個のパラメータを持つ巨大なAIモデルですが、実際の推論時には320億パラメータのみを使用する効率的な設計となっています。

この効率性は「MoE(Mixture of Experts)アーキテクチャ」によって実現されています。MoEとは、モデル内に複数の専門家(Expert)を配置し、入力された問題に応じて最も適切な専門家のみを活用する技術です。例えば、数学の問題が入力されれば数学専門の部分が、プログラミングの問題が入力されればコーディング専門の部分が動作するという仕組みです。

DeepSeekモーメントとは:中国AI技術の台頭

「DeepSeekモーメント」とは、2025年1月に中国のDeepSeek社が発表したAIモデル「DeepSeek R1」が、OpenAIのGPT-4やAnthropicのClaudeといった最先端の商用AIモデルに匹敵する性能を、オープンソースかつ低コストで実現したことで生まれた言葉です。

Kimi K2の登場は「第二のDeepSeekモーメント」と呼ばれており、これは中国のAI技術が偶然の産物ではなく、継続的に世界最高水準のモデルを生み出す能力を持っていることを示しています。Allen Institute for AIの機械学習研究者Nathan Lambert氏は「DeepSeek R1の発表は、AIの軌道における前奏曲であり、一回限りの偶然ではなかった」とコメントしています。

技術的革新:MuonClip最適化手法の数学的基盤

従来の最適化手法の限界

Kimi K2の技術的革新の核心は、新しく開発された「MuonClip最適化手法」にあります。従来のAIモデル学習では、AdamWという最適化アルゴリズムが広く使用されていましたが、大規模モデルの学習時に「attention logitの爆発」という深刻な問題が発生していました。

従来のAdamW最適化では、クエリ(q)とキー(k)の内積計算において:

$$\text{attention_logit} = \mathbf{q}_i^T \mathbf{k}_j$$

この値が異常に大きくなることで、softmax関数の入力が数値的に不安定になり、勾配爆発や学習停止を引き起こしていました。

qk-clip技術の数学的定式化

Moonshot AIは独自のMuon最適化手法を開発し、さらにそれを改良してMuonClipを生み出しました。MuonClipは、この問題を根本的に解決するため、クエリとキーの投影行列を直接制御する「qk-clip」技術を導入しました:

基本的な重み付け:

$$\mathbf{q}_i = \eta^{\alpha} \mathbf{W}_q \mathbf{x}_i$$

$$\mathbf{k}_i = \eta^{1-\alpha} \mathbf{W}_k \mathbf{x}_i$$

attention logitの制御:

$$(\eta^{\alpha} \mathbf{q}_i)^T (\eta^{1-\alpha} \mathbf{k}_j) = \eta \cdot \mathbf{q}_i^T \mathbf{k}_j$$

適応係数ηの計算:

$$\eta = \min\left(\frac{t}{\max_{i,j}(\mathbf{q}_i^T \mathbf{k}_j)}, 1\right)$$

ここで、tは事前設定された閾値、αは均衡パラメータです。

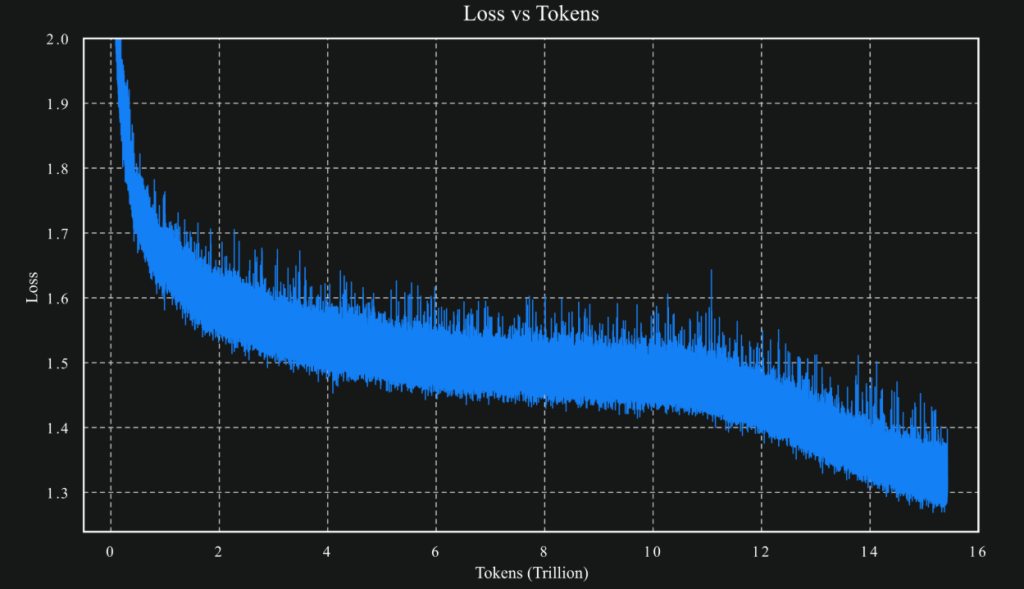

安定性保証の実現

この手法により、attention logitは常に閾値t以下に制限され、学習の安定性が数学的に保証されます。実際、Kimi K2は15.5兆トークンでの学習を一度もクラッシュすることなく完了させることに成功しました。

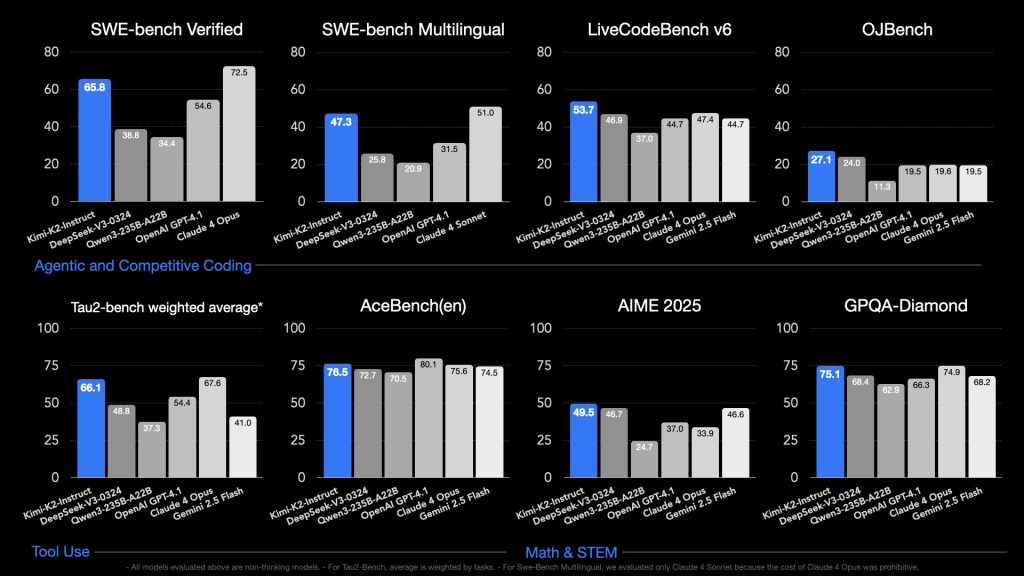

性能評価:世界最高水準のベンチマーク結果

Kimi K2は、様々なベンチマークテストで驚異的な性能を示しています。

コーディング性能の詳細

LiveCodeBench v6: 53.7%(対比:DeepSeek-V3の46.9%、GPT-4.1の44.7%、Claude Sonnet 4の48.5%を上回る)

SWE-bench Verified(エージェンシーコーディング):

- 単一試行:65.8%

- 複数試行(並列テスト時計算):71.6%

OJBench: 27.1%(推論モジュールなし)

数学・STEM分野の革新的結果

MATH-500: 97.4%(対比:GPT-4.1の92.4%を大幅に上回る)

AIME 2025: 49.5%(平均64回試行)

GPQA-Diamond: 75.1%

文章作成・感情知能

Creative Writing v3ベンチマーク: 首位

EQ-bench 3(感情知能テスト): 首位

エージェンシー能力:

- Tau2ベンチマーク: オープンソースモデル中で最高性能

- ACEBench: オープンソースモデル中で最高性能

これらの数値は、OpenAIのGPT-4.1、AnthropicのClaude 4、GoogleのGemini 2.5といった商用最先端モデルと同等以上の性能を示しており、しかもKimi K2はオープンウェイトとして無料で利用可能です。

エージェンシー能力:自律的タスク実行の実現

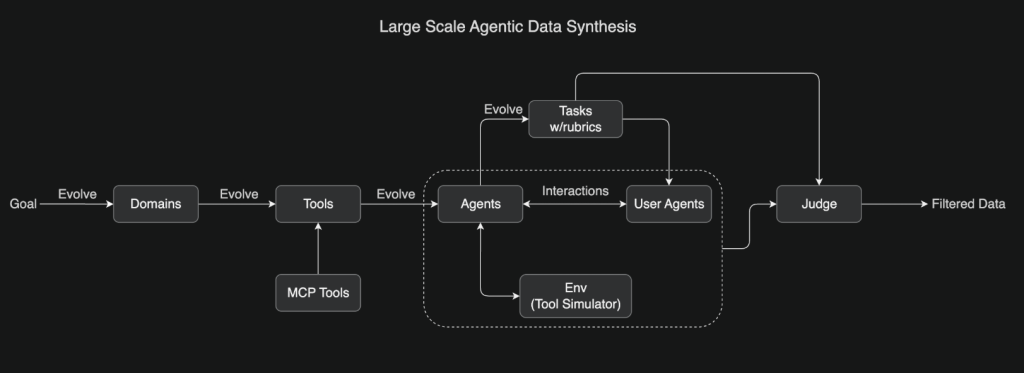

大規模エージェンシーデータ合成パイプライン

Kimi K2の最大の特徴の一つは、「エージェンシー(Agentic)能力」です。これは、単純な質問応答を超えて、複雑な多段階タスクを自律的に実行する能力を指します。

マルチドメイン環境シミュレーション:

- 数百のドメインと数千のツールを体系的に進化

- MCP(Model Context Protocol)ツールと合成ツールの組み合わせ

- ルーブリックベースのタスク評価システム

データ品質管理プロセス:

1. 環境シミュレーション → 2. エージェント相互作用 → 3. LLM審査官による評価 → 4. 高品質データフィルタリング

汎用強化学習システム

検証可能報酬と非検証可能報酬の統合:

- 検証可能タスク(数学、競技プログラミング):

- 明確な正解が存在

- 自動評価システムによる即座のフィードバック

- 非検証可能タスク(研究レポート作成、創作など):

- セルフジャッジング機構による評価

- モデル自身が批評者として機能

批評者更新メカニズム:

critic_update = on_policy_rollouts(verifiable_rewards) → improved_estimation(non_verifiable_rewards)

実際の使用事例

公式発表で紹介された具体的な事例:

- 給与データ分析: 16回のPythonコード実行を通じて統計分析、可視化、インタラクティブWebページ作成を自動実行

- スタンフォードNLP系譜図作成: 5回のWeb検索、4回のブラウジング、3回のクリック、5回のスクロール、6回の編集、2回のデプロイメントを自動実行

- Coldplayツアー計画: 17回のツール呼び出しでWeb検索、カレンダー、Gmail、フライト、Airbnb、レストラン予約を自動実行

これらの能力は、従来のAIが人間の指示に従って単発の作業を行うのに対し、目標達成のために必要な作業を自ら判断し、順序立てて実行するという機能です。

Kimi K2 実際の利用方法ガイド

1. Webブラウザでの利用方法

最も簡単な利用方法は、公式Webサイトでの利用です:

手順:

- https://kimi.com にアクセス

- アカウント作成またはログイン

- モデル選択画面で「Kimi K2」を選択

- チャット画面で質問や指示を入力

利用可能機能:

- 文章作成・編集

- コーディング支援

- 数学・科学的計算

- 複雑な推論タスク

- 多言語対応(日本語、英語、中国語など)

注意点:

- 現在、画像認識機能は未対応

- MCP(Model Context Protocol)機能は開発中

- エージェント機能は「Researcher」モードで体験可能

Researcherモードでのエージェント体験

Kimi K2のエージェント機能を体験するには:

- kimi.comにログイン

- 「Researcher」モードを選択

- 複雑なタスクを依頼(例:「○○について調査してレポートを作成して」)

- AIが自動的に検索、分析、レポート作成を実行

2. API経由での利用方法

2.1 前提条件

# Python環境(推奨3.8以上)

python --version

# OpenAI SDKのインストール

pip install --upgrade 'openai>=1.0'

# Node.js環境の場合

npm install openai@latest

2.2 APIキーの取得

- https://platform.moonshot.ai にアクセス

- アカウント作成またはログイン

- 「API Keys」セクションで新しいキーを生成

- 安全な場所に保存

2.3 基本的な使用例

Python での基本的な使用

from openai import OpenAI

# クライアントの初期化

client = OpenAI(

api_key="YOUR_MOONSHOT_API_KEY", # 取得したAPIキーを設定

base_url="https://api.moonshot.ai/v1",

)

# 基本的なチャット

completion = client.chat.completions.create(

model="kimi-k2",

messages=[

{

"role": "system",

"content": "あなたは日本語で回答するAIアシスタントです。"

},

{

"role": "user",

"content": "PythonでWebスクレイピングのコードを書いてください"

}

],

temperature=0.3,

max_tokens=4000

)

print(completion.choices[0].message.content)

2.4 ツール使用機能の活用

ツール呼び出しの設定

# ツール使用を有効化したAPI呼び出し

completion = client.chat.completions.create(

model="kimi-k2",

messages=[

{

"role": "user",

"content": "今日の東京の天気を調べて、その結果をもとに服装のアドバイスをしてください"

}

],

tools=[

{

"type": "function",

"function": {

"name": "get_weather",

"description": "指定された都市の天気情報を取得",

"parameters": {

"type": "object",

"properties": {

"city": {

"type": "string",

"description": "都市名"

}

},

"required": ["city"]

}

}

}

],

tool_choice="auto"

)

価格設定:

| Model | Standard Input Price / 1M tokens | Cache Tokens Call Price | Cache Creation / 1M tokens | Cache Storage / 1M tokens/min | Cache Call / time |

|---|---|---|---|---|---|

| moonshot-v1-8k | $0.20 | Limited Free | $1.00 | $0.15 | $0.0015 |

| moonshot-v1-32k | $1.00 | Limited Free | $1.00 | $0.15 | $0.0015 |

| moonshot-v1-128k | $2.00 | Limited Free | $1.00 | $0.15 | $0.0015 |

互換性:

- OpenAI API互換

- Anthropic API互換(temperature自動調整:real_temperature = request_temperature × 0.6)

3. 自社環境での展開方法

3.1 vLLMを使用した展開

システム要件

- 最小構成: H200または H20 GPU × 16基

- メモリ: 各GPU 80GB以上

- ネットワーク: 高速InfiniBand接続推奨

基本的な展開コマンド

# モデルのダウンロード

git clone https://huggingface.co/moonshotai/Kimi-K2-Instruct

# vLLMサーバーの起動

vllm serve ./Kimi-K2-Instruct \

--port 8000 \

--served-model-name kimi-k2 \

--trust-remote-code \

--tensor-parallel-size 16 \

--enable-auto-tool-choice \

--tool-call-parser kimi_k2 \

--gpu-memory-utilization 0.85 \

--max-num-batched-tokens 8192

3.2 その他の推論エンジン

SGLangを使用した展開

# SGLangでの起動例

python -m sglang.launch_server \

--model-path ./Kimi-K2-Instruct \

--host 0.0.0.0 \

--port 30000 \

--tp-size 16

KTransformersを使用した展開

# KTransformersでの起動例

ktransformers serve ./Kimi-K2-Instruct \

--port 8000 \

--workers 4 \

--tensor-parallel-size 16

Modified MIT License条件:

- 自由な使用、改良、商用利用が可能

- 月間アクティブユーザー1億人以上、または月間売上2000万ドル以上の商用製品・サービスの場合、UIに「Kimi K2」表示が必要

技術的限界と今後の課題

一方で、Kimi K2にも現時点での限界があります。公式発表では以下の課題が挙げられています:

既知の問題:

- 困難な推論タスクや不明確なツール定義に対して過剰なトークン生成を行う場合がある

- 出力の切り捨てや不完全なツール呼び出しが発生する可能性

- 特定のタスクでツール使用が有効化されると性能が低下する場合がある

- ワンショットプロンプティングでは完全なソフトウェアプロジェクト構築で性能低下

これらの課題は今後のバージョンで改善される予定ですが、現時点では使用場面を適切に選択する必要があります。

アメリカの対応:American DeepSeek Project

Kimi K2やDeepSeekの成功を受けて、アメリカでは「American DeepSeek Project」の必要性が議論されています。Nathan Lambert氏は「アメリカは、オープンソースおよび学術コミュニティにおける影響力の低下に対抗するため、DeepSeekやMoonshot AIが生産するレベルのオープンモデルを必要としている」と指摘しています。

まとめ

Kimi K2の登場は、AI技術の民主化と国際競争の新たな段階を示しています。世界最高水準の性能を持つAIモデルが無料で利用可能になったことで、研究機関、企業、個人開発者すべてにとって新たな可能性が開かれました。

特に日本にとって重要なのは、この技術を単に利用するだけでなく、改良し、独自の価値を付加することです。Kimi K2のオープンソース性を活用して、日本語処理能力の向上、日本特有の文化的コンテキストの理解、日本企業のニーズに特化した機能開発などが期待されます。

同時に、中国のAI技術力の急速な向上は、日本のAI戦略の見直しを促しています。政府、産業界、学術界が連携して、持続可能で競争力のあるAI生態系を構築することが急務といえるでしょう。 Kimi K2は単なる技術的成果ではなく、AIの未来を形作る重要な転換点として位置づけられます。日本の研究者や開発者がこの機会を活用し、AI技術の発展に貢献することを期待します。