はじめに

本稿では、中国のスタートアップ企業Z.aiが発表した新しい大規模言語モデル(LLM)「GLM-4.5」について解説します。)「GLM-4.5」は低コスト化を実現しており、世界のAI市場に新たな動きをもたらす可能性があります。

参考記事

- タイトル: China’s latest AI model claims to be even cheaper to use than DeepSeek

- 発行元: CNBC

- 発行日: 2025年7月28日

- URL: https://www.cnbc.com/2025/07/28/chinas-latest-ai-model-claims-to-be-even-cheaper-to-use-than-deepseek.html

公式

- タイトル: Chat with Z.ai – Free AI for Presentations, Writing & Coding

- 発行元: Z.ai

- URL: https://chat.z.ai/

- タイトル: GLM-4.5: Reasoning, Coding, and Agentic Abililties

- 発行元: Z.ai Blog

- 発行日: 2025年7月28日

- URL: https://z.ai/blog/glm-4.5

- タイトル: zai-org/GLM-4.5 · Hugging Face

- 発行元: Hugging Face

- URL: https://huggingface.co/zai-org/GLM-4.5

要点

- 中国のAIスタートアップZ.ai(旧Zhipu)が、新モデル「GLM-4.5」を発表した。

- GLM-4.5は、競合する中国のAIモデル「DeepSeek」よりもさらに低コストでの利用が可能である。

- このモデルはオープンソースであり、誰でも無料でダウンロードして利用できる。

- GLM-4.5は、タスクを自動的にサブタスクに分解して処理精度を高める「エージェント型AI」のアプローチを採用している。

- モデルサイズはDeepSeekの約半分で、米国の輸出規制に対応したNvidia社のH20チップ8基という比較的少ない計算資源で動作する。

- 中国のAI市場では、AlibabaやTencentなども含め、低コスト化とオープンソース化を軸とした開発競争が激化している。

詳細解説

AIのコストとオープンソース化の意義

AIモデル、特に大規模言語モデル(LLM)について語る上で重要な概念がいくつかあります。

一つは「トークン」です。これはAIが文章を処理する際の最小単位で、単語や文字の一部に相当します。AIの利用料金は、このトークンをどれだけ処理したか(入力および出力)によって決まるのが一般的です。したがって、「100万トークンあたりの料金」が、そのAIモデルのコストパフォーマンスを示す重要な指標となります。

もう一つは「オープンソース」です。これは、AIモデルの設計図にあたるソースコードが公開されており、誰でも無料で使用、複製、改変、配布できることを意味します。オープンソース化により、世界中の開発者がモデルを改良したり、特定の目的に合わせて調整したりできるため、技術革新が加速し、AI利用の裾野が大きく広がります。

GLM-4.5の技術仕様とアーキテクチャ

モデルの基本構成

GLM-4.5シリーズには、2つの主要バリエーションが存在します:

- GLM-4.5(フラッグシップモデル):総パラメータ数3,550億、アクティブパラメータ数320億

- GLM-4.5-Air(軽量版):総パラメータ数1,060億、アクティブパラメータ数120億

これらのモデルは、推論、コーディング、エージェント機能を単一のモデルに統合するよう設計されており、急速に発展するエージェント型アプリケーションの複雑な要求に対応することを目的としています。

ハイブリッド推論システム

GLM-4.5の特徴の一つは、ハイブリッド推論システムです。

このシステムは2つのモードを提供します:

- 思考モード(Thinking Mode):複雑な推論やツール使用が必要なタスクに対応

- 非思考モード(Non-thinking Mode):即座の応答が求められるタスクに対応

この柔軟なアプローチにより、ユーザーは状況に応じて最適なモードを選択できます。

MoE(Mixture of Experts)アーキテクチャ

GLM-4.5は、MoE(Mixture of Experts)アーキテクチャを採用しています。これは、モデル内に複数の「専門家」ネットワークを配置し、入力に応じて最適な専門家を選択して処理を行う仕組みです。この設計により、訓練と推論の両方において計算効率が大幅に向上します。現代の効率的なモデルでは採用されるのが一般的なアプローチではあります。

注目すべきは、GLM-4.5が他のモデル(DeepSeek-V3やKimi K2など)とは異なるアプローチを採用していることです。幅(隠れ次元と経路専門家の数)を減らす代わりに、高さ(レイヤー数)を増やすことで、より深いモデル構造を実現し、推論能力の向上を図っています。

Z.aiが発表した新モデル「GLM-4.5」

今回、Z.aiが発表した「GLM-4.5」が注目される最大の理由は、その圧倒的な低コストにあります。具体的な料金を見てみましょう。

| モデル | 入力料金(100万トークンあたり) | 出力料金(100万トークンあたり) |

| Z.ai GLM-4.5 | 11セント | 28セント |

| DeepSeek R1 | 14セント | 2ドル19セント |

| Moonshot Kimi K2 | 15セント | 2ドル50セント |

表を見ると、GLM-4.5は入力料金だけでなく、特に出力料金において競合モデルを大幅に下回っていることがわかります。これは、AIを利用する企業や開発者にとって、開発・運用コストを劇的に削減できることを意味します。

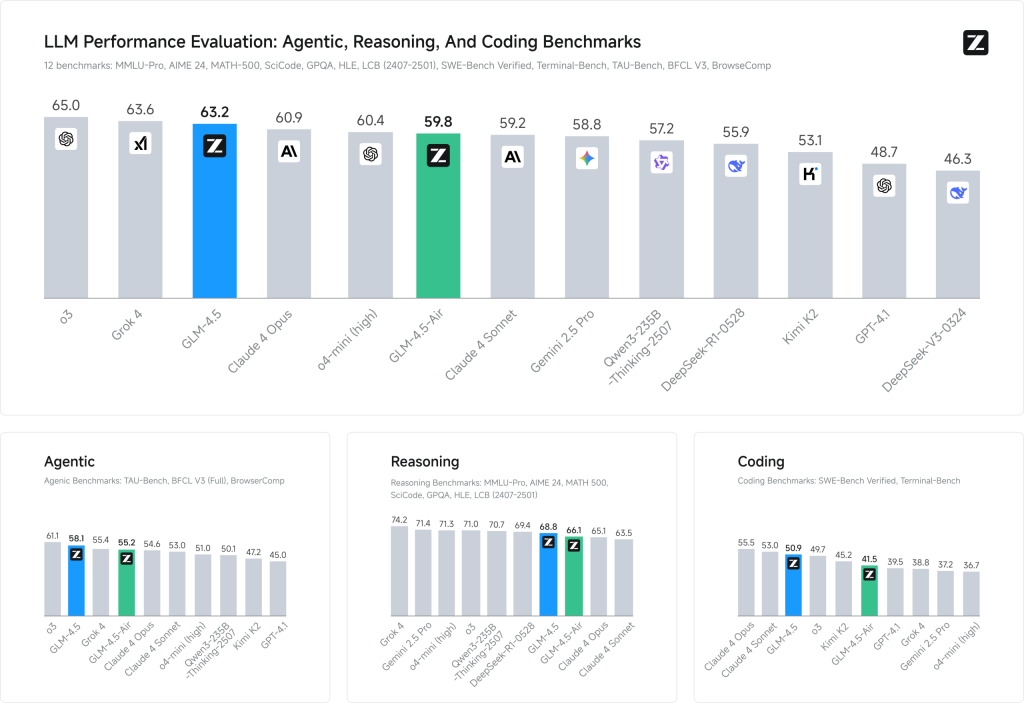

性能評価:包括的ベンチマーク結果

総合性能

GLM-4.5は、12の業界標準ベンチマークで63.2のスコアを達成し、すべてのプロプライエタリおよびオープンソースモデル中で第3位にランクインしています。GLM-4.5-Airも59.8の競争力のあるスコアを維持しながら、優れた効率性を実現しています。

エージェント型タスクでの卓越した性能

エージェント型AIの能力を測定する3つの主要ベンチマークでの結果:

| ベンチマーク | GLM-4.5 | Claude 4 Sonnet | o3 | DeepSeek-R1 |

| TAU-bench | 70.1 | 70.3 | 61.2 | 58.7 |

| BFCL v3 | 77.8 | 75.2 | 72.4 | 63.8 |

| BrowseComp | 26.4 | 14.7 | 49.7 | 3.2 |

特に、ウェブブラウジングタスクを評価するBrowseCompにおいて、GLM-4.5は26.4%の正解率を達成し、Claude-4-Opus(18.8%)を大幅に上回る性能を示しています。

コーディング能力

コーディングタスクにおいても、GLM-4.5は優秀な性能を発揮:

| ベンチマーク | GLM-4.5 | Claude 4 Sonnet | DeepSeek-R1 |

| SWE-bench Verified | 64.2 | 70.4 | 41.4 |

| Terminal-Bench | 37.5 | 35.5 | 17.5 |

特に注目すべきは、GLM-4.5が90.6%のツール呼び出し成功率を達成し、Claude-4-Sonnet(89.5%)、Kimi-K2(86.2%)、Qwen3-Coder(77.1%)を上回っていることです。

低コストを実現する技術的ポイント

1. モデルの小型化と効率化

GLM-4.5は、競合のDeepSeekのモデルの約半分のサイズでありながら、高い性能を維持しているとされています。そして、その動作に必要な計算資源は、Nvidia社が米国の輸出規制に対応するために中国市場向けに開発した「H20」というGPUチップわずか8基です。これは、AIモデルの運用に必要なハードウェアへの投資を大幅に抑えられることを示しており、低コスト化の大きな要因となっています。

2. 「エージェント型AI」アプローチの採用

GLM-4.5は「エージェント型AI(Agentic AI)」という考え方で構築されています。これは、与えられた複雑なタスクをAIが自律的に分析し、より小さなサブタスクに分解して、それらを順番に解決していくというアプローチです。これにより、一つ一つの処理の精度が向上し、結果として全体としてより正確な回答を効率的に生成できるとされています。

3. 最新の訓練技術とインフラストラクチャ

GLM-4.5の開発において、Z.aiはいくつかの革新的な技術を導入しています:

- Muon オプティマイザー:収束を加速し、より大きなバッチサイズに対応

- QK-Norm:アテンション logits の範囲を安定化

- MTP(Multi-Token Prediction)レイヤー:推論時の投機的デコーディングをサポート

- slime RL インフラストラクチャ:大規模モデル向けの高効率強化学習システム

技術詳細

MoEアーキテクチャの詳細メカニズム

GLM-4.5のMoE実装では、Loss-free balance routingとSigmoid gatesを採用しています。従来のMoEモデルが抱える専門家間の負荷不均衡問題を、損失なしバランシング手法により解決し、各専門家が適切に活用されるよう設計されています。Sigmoid gatesの使用により、専門家選択の勾配計算が安定化され、訓練時の収束性が向上しています。

アテンションメカニズム

GLM-4.5ではGrouped-Query AttentionとPartial RoPE(Rotary Position Embedding)を組み合わせています。特に注目すべきは、5120の隠れ次元に対して96のアテンションヘッド(従来の2.5倍)を配置している点です。この設計は訓練損失の改善には寄与しませんが、MMLU、BBHなどの推論ベンチマークで一貫した性能向上を実現しています。

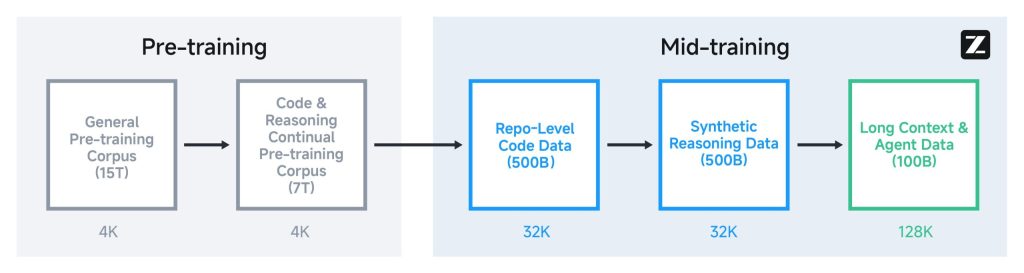

訓練プロセス

基盤モデルの訓練は複数段階で実施されます。まず15Tトークンの汎用事前訓練コーパスで訓練し、続いて7Tトークンのコード・推論特化コーパスで強化します。その後、中規模のドメイン特化データセットを用いた追加段階を経て、最終的にExpert distillationにより各専門スキルを統合し、全タスクにわたる包括的な能力を獲得します。

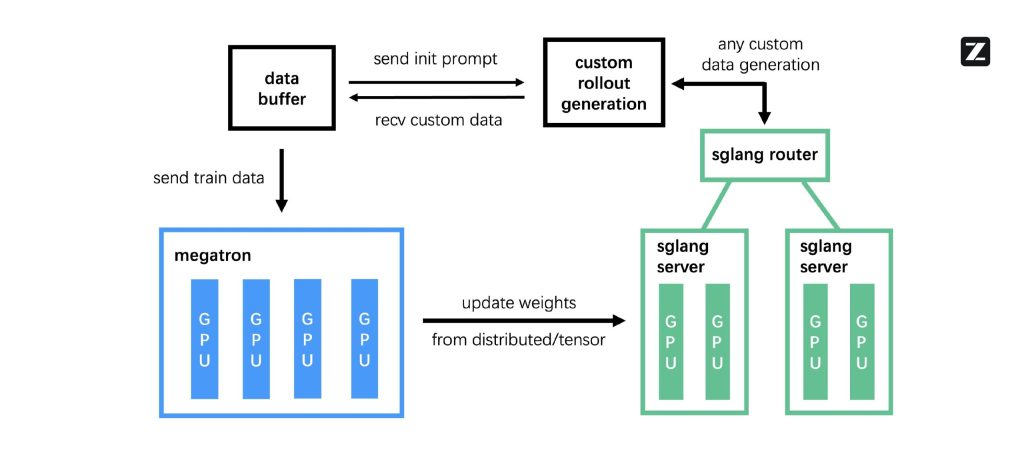

slime RLインフラストラクチャ

Z.aiが開発したslimeは、非同期分散訓練アーキテクチャを特徴とします。従来のRL訓練の主要ボトルネックである環境ロールアウトの遅延を、ロールアウトエンジンと訓練エンジンの完全分離により解決しています。FP8/BF16混合精度技術により、データ生成にはFP8の高効率性を、モデル訓練にはBF16の安定性を活用し、全体のスループットを大幅に向上させています。

効率化技術

Muon optimizerの採用により、従来のAdamWと比較して収束速度が向上し、より大きなバッチサイズでの安定訓練が可能になりました。QK-NormはQuery-Key正規化によりアテンション logitsの範囲を安定化し、長いシーケンス処理時の数値的安定性を確保します。MTP(Multi-Token Prediction)レイヤーは推論時の投機的デコーディングをサポートし、生成速度の向上に貢献しています。

ベンチマーク結果の分析

GLM-4.5のパレート最適性分析では、同規模モデル群において性能・効率の最適境界に位置することが確認されています。特にテストタイム・スケーリング効果により、BrowseCompベンチマークでは推論時間の増加と正解率の向上に明確な相関関係が観察されており、思考モードの有効性が数値的に実証されています。エージェント型タスクでの90.6%のツール呼び出し成功率は、関数呼び出しプロトコルの最適化と堅牢なエラーハンドリング機構の成果です。

GLM-4.5の具体的な使い方

1. Z.aiチャットプラットフォームでの利用

最も簡単な利用方法は、Z.aiプラットフォーム(https://chat.z.ai)でGLM-4.5モデルオプションを選択することです。このプラットフォームでは以下の機能が利用できます:

- アーティファクト生成:コード、文書、視覚的コンテンツの作成

- プレゼンテーションスライド作成:自動的なスライド生成機能

- フルスタック開発:ウェブアプリケーションの包括的な開発支援

2. API統合による開発者向け利用

Z.ai APIプラットフォーム(https://docs.z.ai/guides/llm/glm-4.5)では、OpenAI互換のインターフェースを提供しており、既存のOpenAI APIを使用しているアプリケーションからの移行が容易です。

基本的なAPI呼び出し例:

curl -X POST "https://api.z.ai/v1/chat/completions" \

-H "Content-Type: application/json" \

-H "Authorization: Bearer YOUR_API_KEY" \

-d '{

"model": "glm-4.5",

"messages": [

{"role": "user", "content": "Pythonでファイル処理のコードを書いてください"}

],

"max_tokens": 1000

}'3. コーディングエージェントとの統合

GLM-4.5は、以下のコーディングツールとシームレスに統合できます:

- Claude Code:Anthropic社の開発したコーディングアシスタント

- Roo Code:オープンソースのコーディングツール

- CodeGeex:中国製のコーディング支援ツール

4. ローカル環境での利用

モデルの入手

GLM-4.5のモデルウェイトは以下のプラットフォームから無料で入手できます:

- HuggingFace:https://huggingface.co/collections/zai-org/glm-45-687c621d34bda8c9e4bf503b

- ModelScope:https://modelscope.cn/collections/GLM-45-b8693e2a08984f

サポートされる推論フレームワーク

ローカルデプロイメントでは、以下のフレームワークがサポートされています:

- vLLM:高性能な推論エンジン

- SGLang:効率的な大規模言語モデル推論システム

デプロイメント例(vLLMを使用)

# モデルのダウンロード

git clone https://huggingface.co/zai-org/GLM-4.5-Chat

# vLLMでのサービス起動

python -m vllm.entrypoints.openai.api_server \

--model zai-org/GLM-4.5-Chat \

--served-model-name glm-4.5 \

--host 0.0.0.0 \

--port 80005. 特殊機能の活用

PPT/ポスター自動生成

GLM-4.5の強力なエージェント機能を活用して、プレゼンテーション資料を自動生成できます:

- ユーザーの簡単な指示からスライドを自動作成

- ドキュメントアップロード機能

- ウェブ検索と画像取得の自動化

フルスタックウェブ開発

GLM-4.5は、フロントエンドからバックエンドまでの包括的な開発をサポートします:

- 基本的なウェブサイトボイラープレートの提供

- マルチターン対話による機能追加と改良

- データベース管理とバックエンドデプロイメント

激化する中国AI市場と地政学的背景

Z.aiの動きは単独のものではありません。DeepSeek、Alibabaが支援するMoonshot、Tencentといった中国の巨大テック企業やスタートアップが、次々と高性能かつ低価格なオープンソースAIモデルを発表しており、市場は熾烈な競争環境にあります。

この背景には、米中間の技術覇権争いも影響しています。米国政府は、先端半導体の対中輸出規制を強化しており、Z.aiも米国の輸出規制対象リスト(エンティティリスト)に追加されています。このような状況下で、限られた計算資源(Nvidia H20チップなど)を最大限に活用し、コスト効率の高いモデルを開発することは、中国企業にとって非常に重要な戦略となっています。

今後の展望と開発者への影響

オープンソースエコシステムの発展

GLM-4.5のMITライセンスでの公開は、AI開発エコシステムに大きな影響を与えると予想されます。開発者は以下のメリットを享受できます:

- 商用利用の自由度:制限なしの商業利用

- カスタマイズの柔軟性:特定用途への調整と改良

- コミュニティ貢献:モデルの改善と機能拡張への参加

産業応用の可能性

GLM-4.5の低コストと高性能の組み合わせは、以下の分野での採用を促進すると考えられます:

- エンタープライズソフトウェア:コスト効率の高いAI統合

- 教育技術:アクセスしやすいAI学習支援ツール

- 中小企業向けソリューション:予算に優しいAI活用

まとめ

本稿では、CNBCの記事を基に、中国のAIスタートアップZ.aiが発表した新モデル「GLM-4.5」について解説しました。このモデルは、オープンソースでありながら、「エージェント型AI」という新しいアプローチと効率化により、競合を圧倒する低コストを実現しています。

技術的には、MoEアーキテクチャ、ハイブリッド推論システム、最新の訓練技術を組み合わせることで、限られた計算資源での高性能を実現しています。使い方の面では、簡単なチャットインターフェースから本格的なAPI統合、ローカルデプロイメントまで、幅広い利用オプションを提供しています。

この動きは、米国の半導体規制という逆風の中で、中国のAI技術がコスト競争力と独自の技術革新を武器に力強く発展していることを示しています。AIモデルの低コスト化とオープンソース化の流れは、世界中の開発者や企業にとってAI利用のハードルを下げ、今後さらに多様なサービスやアプリケーションが生まれるきっかけとなるでしょう。中国で繰り広げられるAI開発競争は、世界の技術トレンドを占う上で、今後も目が離せない重要な動きと言えます。