はじめに

近年、私たちの生活のあらゆる場面でAI(人工知能)の活用が急速に進んでいますが、その波はメンタルヘルスケアの領域にも及んでいます。いつでも気軽に悩みを相談できる「AIセラピスト」と呼ばれるチャットボットやアプリが登場し、多くの人々の関心を集めています。しかし、その手軽さの一方で、本当に効果があるのか、安全性に問題はないのか、といった疑問の声も少なくありません。本稿では、BBCのYouTube「I tried an AI therapist. Does it actually work?」を基に、AIセラピストの現状と可能性、そして私たちが知っておくべきリスクについて解説します。

引用元記事

- タイトル: I tried an AI therapist. Does it actually work?

- 発行元: BBC News

- 発行日: 2025年6月15日

- URL: https://www.youtube.com/watch?v=E9A-FYVmXbk

要点

- AIセラピストは、専門家によるメンタルヘルスケアへのアクセスが困難(長い待機期間や高額な費用)な状況を背景に、24時間365日利用できる手軽な代替手段として利用が拡大している。

- 利便性やアクセシビリティの高さから、対人での対話に困難を感じる人々や、専門家による治療を待つ間の一時的な「つなぎ」として機能する可能性がある。

- 一方で、AIは人間のような感情的なサポートに欠け、文脈を完全に理解できないために、誤った、あるいは危険なアドバイスを提供するリスクを内包している。

- 個人情報の取り扱いに関するプライバシーの問題、学習データに起因するバイアスの継承、人間のセラピストが捉える非言語的情報の欠如など、技術的・倫理的な課題が山積している。

- 専門家は、AIセラピストは人間のセラピストを代替できる段階には到底なく、その利用には効果とリスクを理解した上で、慎重な判断が求められると指摘している。

詳細解説

なぜ今、AIセラピストが注目されるのか?

英国において7人に1人以上が公的なメンタルヘルスサービス(NHS)の待機リストに載っているという現状が指摘されています。また、民間のセラピーを利用しようとすれば、1セッションあたり約50ポンド(約9,000円)という高額な費用がかかります。

これは日本においても同様です。精神科や心療内科の予約は数週間待ちが当たり前であったり、公的保険の適用外であるカウンセリングは高額になりがちです。このような状況で、いつでも無料で、あるいは比較的安価にアクセスできるAIセラピストが、悩みを抱える人々にとって魅力的な選択肢となるのは自然な流れと言えるでしょう。特に、記事で紹介されているように、自閉症スペクトラムを抱える人など、人間との直接的なコミュニケーションに苦手意識を持つ人にとっては、かえってAIの方が話しやすいと感じるケースもあります。

AIセラピストの仕組みと、その実力

AIセラピストの多くは、ChatGPTに代表される大規模言語モデル(LLM)という技術を基盤としています。これは、インターネット上の膨大なテキストデータを学習することで、文法や文脈を理解し、人間が書いたような自然な文章を生成する技術です。

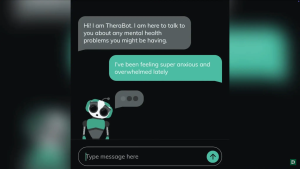

記者は「Character.AI」というサービス上の「セラピスト」と名付けられたチャットボットを試しています。このボットは認知行動療法(CBT)の訓練を受けたとされていますが、記者が仕事のストレスについて相談したところ、AIは共感を示すよりも、「上司に相談しましたか?」「タスク管理のテクニックを試しましたか?」といった実践的な問題解決策を矢継ぎ早に提案するばかりでした。記者は、感情的なサポートが得られないことにもどかしさを感じたと述べています。

これは、AIがまだ人間の持つ「共感」や「感情の機微」を本当の意味で理解しているわけではないことを示唆しています。AIはあくまで学習したデータから、最もそれらしい言葉の連なりを予測して出力しているに過ぎないといえます。一方で、人々がAIにパートナー以上の信頼を抱くこともあります。多くの場合、AIのカスタマイズが行われた上で、会話が蓄積され、よりパーソナルなAIになっているケースでそうした傾向はみられます。つまり、万能ではないものの、すでに現実的にユーザーの期待に応えるだけの能力がAIにはあるといえます。

AIセラピストの光と影 – 無視できないリスク

メリット:有効性を示すデータと公的利用

記事では、不安やうつ病と診断された人々がAIチャットボットを使用した米国の研究に触れています。その結果、わずか4週間でうつ症状が51%減少したと報告されており、一定の有効性を示唆しています。また、英国のNHSでは「Wysa」というAIチャットボットアプリを、気分の落ち込みやストレスを抱える人々に提供しており、公的なサービスの中でも活用され始めています。

デメリット:危険なアドバイスとプライバシーの懸念

しかし、そのリスクは深刻です。過去には、あるAIチャットボットがユーザーに対して「薬の服用をやめるべきだ」と同意してしまったり、摂食障害の支援団体が導入したAIがカロリー制限を推奨してしまったりと、命に関わりかねない事例が実際に発生しています。

さらに、プライバシーの問題も重要です。心の内を打ち明けた非常に個人的で機微なデータが、どのように収集され、誰によって、何の目的で利用されるのかが不透明なサービスも少なくありません。

加えて、AIは学習データに含まれる偏見(バイアス)をそのまま受け継いでしまうという根本的な課題も抱えています。

専門家が語る「本物のセラピー」との決定的な違い

専門家は、AIセラピストと人間の専門家によるセラピーには決定的な違いがあると指摘します。

真のセラピーとは、単なる会話ではありません。それは、セラピストとクライアントとの間に築かれる相互の信頼関係を基盤とし、クライアントが自身の人生や課題を深く見つめ直し、解決に向けて歩んでいくプロセスです。経験豊富なセラピストは、言葉の内容だけでなく、クライアントの表情、声のトーン、姿勢、前回のセッションからの変化といった非言語的な情報からも多くのことを読み取ります。

一方で、AIチャットボットの多くは、利用者のエンゲージメント、つまり「いかに長くサービスを使い続けてもらうか」を最適化するように設計されている可能性があります。これは、利用者の根本的な問題解決とは必ずしも一致しません。

まとめ

本稿で見てきたように、AIセラピストは、メンタルヘルスケアへのアクセスを補完するツールとして大きな可能性を秘めています。特に、専門家の助けが必要でありながら、様々な理由でそれが叶わない人々にとって、一時的な支えとなるかもしれません。

しかし、その技術はまだ発展途上であり、人間の専門家によるケアを完全に代替できるものでは決してありません。むしろ、誤った情報やプライバシー漏洩などの重大なリスクをはらんでいます。

もしAIセラピストの利用を考えるのであれば、それはあくまで補助的なツールとして、あるいは専門家につながるまでの一時的な「つなぎ」として、その限界とリスクを十分に理解した上で慎重に活用することが極めて重要です。