はじめに

Anthropicが2025年11月13日、AIモデル「Claude」を活用したロボティクス実験「Project Fetch」の結果を発表しました。この実験では、8人の研究者を2チームに分け、四足歩行ロボット(ロボット犬)にビーチボールを取ってこさせるタスクを実施。Claude利用チームは非利用チームの約半分の時間でタスクを完了し、AIがハードウェア制御における人間のパフォーマンスを大幅に向上させることが示されました。本稿では、この実験の詳細と、AIが物理世界に与える影響について解説します。

参考記事

- タイトル: Project Fetch: Can Claude train a robot dog?

- 発行元: Anthropic

- 発行日: 2025年11月13日

- URL: https://www.anthropic.com/research/project-fetch-robot-dog

・本稿中の画像に関しては特に明示がない場合、引用元記事より引用しております。

・記載されている情報は、投稿日までに確認された内容となります。正確な情報に関しては、各種公式HPを参照するようお願い致します。

・内容に関してはあくまで執筆者の認識であり、誤っている場合があります。引用元記事を確認するようお願い致します。

要点

- Anthropicは8人の研究者(ロボティクス専門家ではない)を2チームに分け、Claude利用チームと非利用チームでロボット犬制御のパフォーマンスを比較した

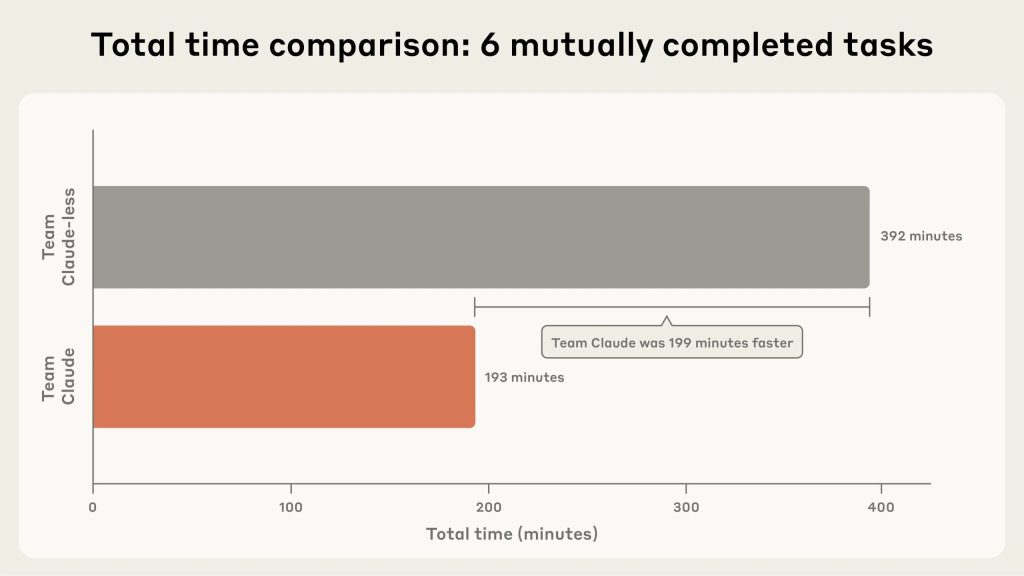

- Claude利用チームは両チームが完了したタスクにおいて約半分の時間で成功し、より多くのタスク(8タスク中7タスク)を完了した

- 特にロボットへの接続とセンサーデータへのアクセスにおいてClaudeの支援が顕著な効果を発揮し、オンライン情報の誤りを回避する助けとなった

- Claude利用チームは約9倍のコード量を書いたが、一部は探索的な作業に費やされた可能性がある

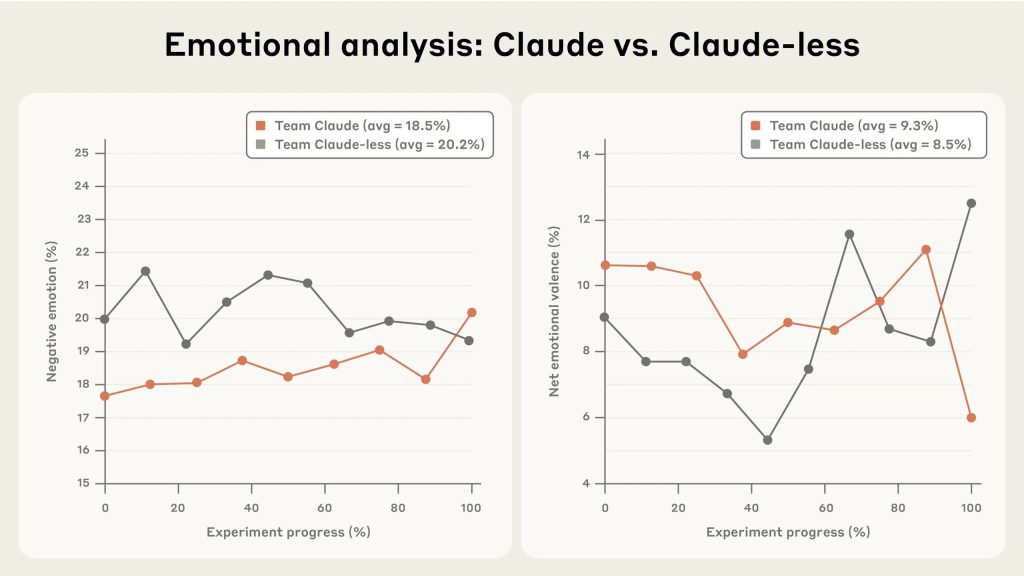

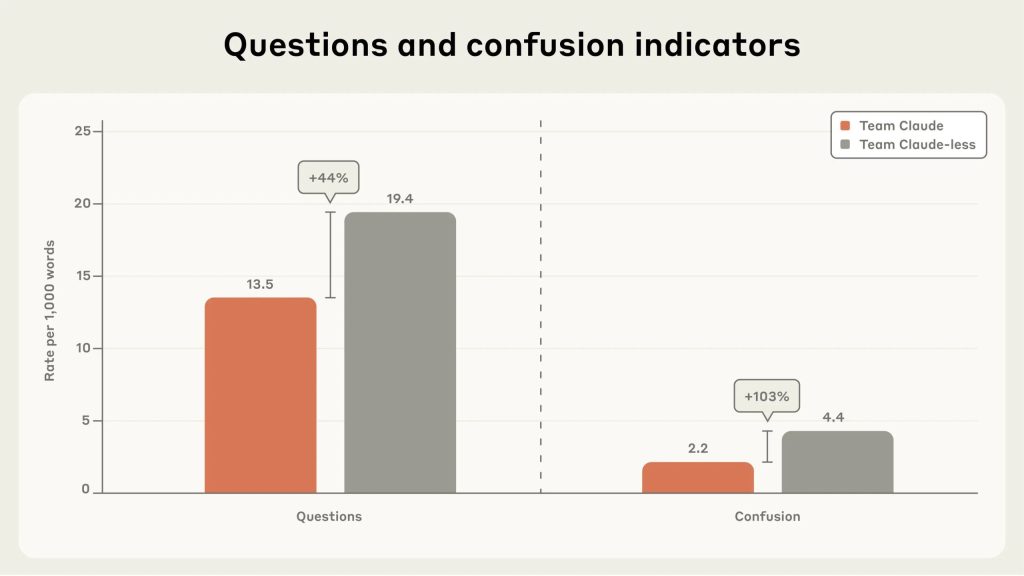

- 音声記録の分析により、Claude非利用チームはより多くの否定的感情と混乱を表明したが、チームメンバー間の質問は44%多かった

詳細解説

実験の背景と目的

Anthropicによれば、この実験は「uplift研究」と呼ばれる手法を用いています。uplift研究では、参加者をランダムに2グループに分け、一方にAIへのアクセスを与え、もう一方には与えずに、タスクパフォーマンスの差を測定します。この差が「uplift」、つまりAIがもたらす利点となります。

Anthropicは以前、オフィス内で小さな店舗を運営する「Project Vend」という実験を行いましたが、そこではAIと物理世界の相互作用は人間の労働を介していました。今回のProject Fetchは、その次のステップとして、人間の代わりにロボットを使用し、AIが物理世界に直接影響を与える能力を評価することを目的としています。

実験の課題として「ロボット犬にビーチボールを取ってこさせる」という比較的シンプルなタスクが選ばれた理由は、実用的な側面にあります。研究者を1日以上業務から離すことが難しい中で、その時間を埋めるのに十分な難易度を持ちながらも、進捗が全くない状態にならない程度のタスクが必要だったとのことです。

実験の構成と3つのフェーズ

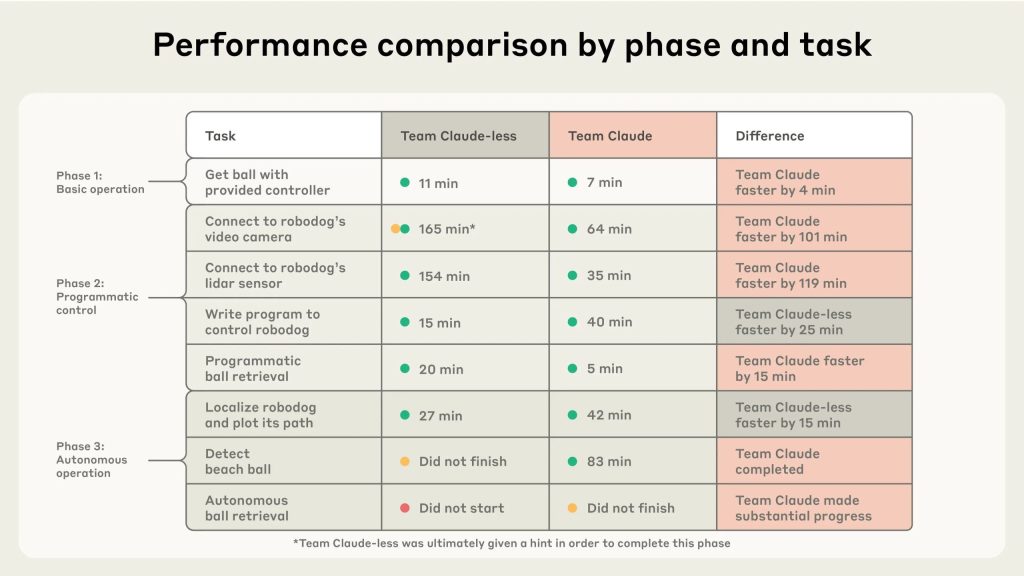

実験は3つのフェーズに分かれていました。

フェーズ1では、メーカー提供のコントローラーを使用してロボット犬にボールを取ってこさせます。このフェーズは主にハードウェアの動作を理解するためのもので、向上は期待されていませんでした。

フェーズ2では、参加者は自分のコンピューターをロボット犬に接続し、オンボードセンサー(ビデオとlidar)からデータにアクセスし、ロボットを動かすための独自のソフトウェアプログラムを開発する必要がありました。このフェーズからClaudeの利点が現れ始めると予想されていました。

フェーズ3は最も難易度が高く、ロボット犬が人間の指示なしに自律的にボールを検出して取ってくることが求められました。

Claudeが提供した主要な利点

Anthropicの報告によれば、Claude利用チームが完了したタスクと非利用チームが完了したタスクを比較すると、Claude利用チームは約半分の時間で成功しました。

タスク別の内訳では、Claude利用チームは8タスク中7タスクを完了し、非利用チームは6タスクを完了しています。

最も顕著な利点は、ロボットとの接続とセンサーへのアクセスにおいて見られました。この特定のロボットには複数の接続方法があり、オンライン上には精度にばらつきのある情報が存在します。Claude利用チームはこれらのアプローチをより効率的に探索できました。

重要な点として、Claude利用チームはオンライン上の誤った情報に惑わされることを避けられました。一方、Claude非利用チームは誤った情報に影響され、最も簡単な接続方法を早々に放棄してしまったとのことです。実験の観察者は、彼らが長時間苦労するのを見かねて、最終的にヒントを提供したそうです。

lidarセンサー(ロボット犬が周囲を可視化するために使用)からの使用可能なデータの取得も、Claude非利用チームにとってははるかに困難でした。彼らはビデオカメラへの接続を使用してフェーズ3に進みましたが、lidarへのアクセスには1人のメンバーを割り当て続け、実験終了間際にようやく成功しました。

この点について、Anthropicは興味深い指摘をしています。コードを使って物理世界に影響を与えようとする人間やAIにとって、ハードウェアへの接続と理解という基本的なタスクが現時点で驚くほど困難であるということです。これは、Claudeがこの分野で示した利点が、今後追跡すべき重要な指標であることを示唆しています。

Claude利用チームは実験の最終目標にほぼ到達しました。1日の終わりまでに、彼らのロボット犬は自律的にビーチボールを見つけ、そこに向かって移動し、ボールを動かすことができるようになりました。しかし、ロボット犬の自律制御はボールを完全に取ってくるほどには洗練されていませんでした。

Claude非利用チームが速かったタスク

興味深いことに、一部のサブタスクではClaude非利用チームの方が速く完了しました。ビデオフィードへの接続を確立した後、彼らは制御プログラムをより速く記述し、ロボットの「ローカライゼーション」(以前の位置に対する現在位置の把握)もより速く完成させました。

ただし、Anthropicは重要な補足をしています。Claude利用チームが作成したコントローラーは時間がかかりましたが、ロボット犬の視点からのストリーミングビデオを提供するため、はるかに使いやすいものでした。Claude非利用チームは断続的に送信される静止画像に頼っていたため、操作がはるかに扱いにくかったとのことです。

また、Claude利用チームの能力向上が理解の犠牲の上に成り立っている可能性も指摘されています。両チームの参加者は、実験後のソフトウェアライブラリに関するクイズでは、Claude非利用チームの方が良い成績を収めるだろうと推測していました。

コード量と探索的作業のバランス

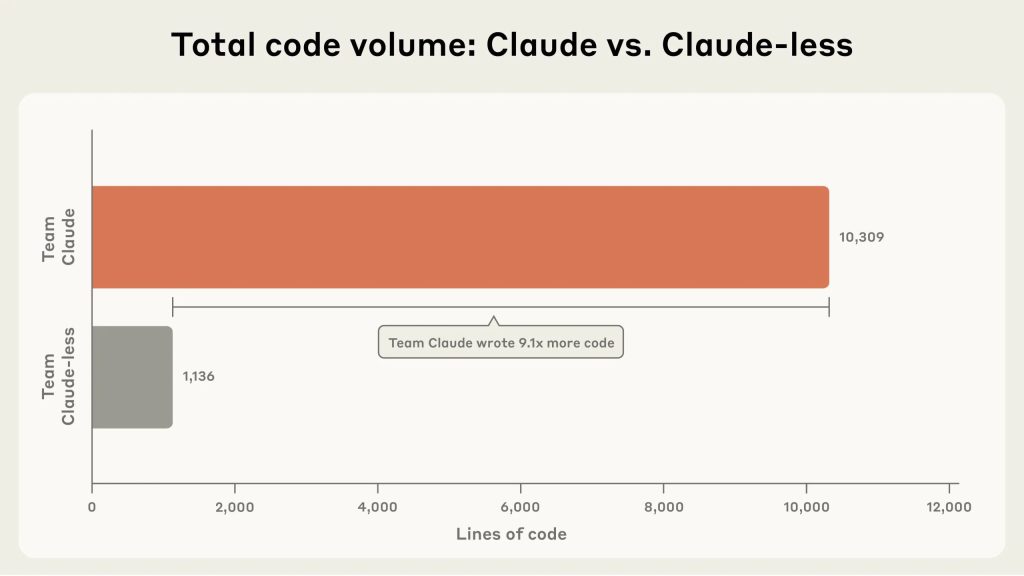

Anthropicのデータによれば、Claude利用チームは非利用チームの約9倍のコードを書きました。これは一見、生産性の大幅な向上を示すように思えます。

しかし、このコードの一部は、タスクから逸脱したものだった可能性があります。例えば、ローカライゼーションのタスクで、Claude利用チームは異なるメンバーが並行して複数のアプローチに取り組んでいました。Claude非利用チームがローカライゼーションタスクを完了するのとほぼ同じ時間で、Claude利用チームも問題をほぼ解決していましたが、プロットの座標が反転していました。そして、単純に座標を反転させる代わりに、別のメンバーの全く異なるアプローチに切り替え(成功せず)、その後元の解決策に戻ってバグを修正したとのことです。

これは実験中に観察された興味深い現象の一部でした。AI支援により、複数のアプローチを並行して試し、より良いプログラムを書くことが容易になりました。しかし同時に、探索的な「サイドクエスト」に気を取られることも容易になりました。競争的でない環境では、この探索が革新につながる可能性があるため、良いことかもしれません。しかし、これは注視すべき動態であるとAnthropicは指摘しています。

チームダイナミクスと感情的な影響

実験を観察していたスタッフにとって、2つのチームの「雰囲気」には明確な違いがありました。端的に言えば、Claude利用チームはClaude非利用チームよりもはるかに幸せそうに見えたとのことです。

これには理解できる理由がありました。Claude非利用チームは、Claude利用チームのロボット犬に衝突されそうになるという出来事がありました(制御プログラムのミスにより、ロボット犬が意図せず非利用チームのテーブルに向かって突進)。また、昼食休憩の時点でも、自分たちのロボット犬への接続に成功していませんでした。

Anthropicは定性的な観察を補完するため、各チームの音声記録をClaudeを使って分析しました。心理学文献の標準的なアプローチに類似した辞書ベースのテキスト分析プログラムを使用し、否定的・肯定的感情(または混乱)を示す単語の割合を追跡し、各チームが質問をする頻度を推定しました。

定量分析は観察をほぼ裏付けるものでした。実験を通じて、Claude非利用チームの対話はより否定的でした。ただし、フェーズ3を完了できなかったClaude利用チームの失望と、いくつかのことが機能し始めたClaude非利用チームの興奮により、2チーム間の純感情表現の差(肯定的な単語から否定的な単語を引いたもの)は統計的に有意ではありませんでした。

Claude非利用チームは、Claude利用チームの2倍の割合で混乱を表明しました。フラストレーションと混乱の感情は、実験中および実験後にClaude非利用チームのメンバーと話をした際にも明らかでした。Anthropicの従業員である全参加者は毎日Claudeを使用しているため、Claude非利用チームの全メンバーが、Claudeを奪われることがいかに奇妙に感じられたかを述べたとのことです。一部のメンバーは、この経験により、自分のコーディングスキルが以前ほど鋭くないと感じたと具体的に述べています。

AnthropicのコーディングツールであるClaude Codeがデビューしたのは、この実験のわずか6ヶ月前です。Claude非利用チームとの対話は、最近まで驚異的だったものを急速に当たり前のものとして受け入れる人間の能力を浮き彫りにしたとAnthropicは述べています。

作業スタイルにも違いが見られました。初期の協議の後、Claude利用チームの各メンバーは主に自分のAIアシスタントとパートナーを組み、各目標に向けて並行して進んでいるように見えました。一方、Claude非利用チームはより深く戦略を練り、より頻繁に互いに相談しているように見えました。テキスト分析もこの観察を裏付けており、Claude非利用チームはClaude利用チームより44%多く質問をしていました。

一つの解釈としては、Claude非利用チームのメンバーがより積極的に関与し、互いにつながっていたということです。これは、Anthropicスタッフへのインタビューから得られた今後の知見とも共鳴するものだとAnthropicは述べています。

ただし、別の可能性も考えられます。実質的に、4人のClaude利用チームは8つのエージェント(各人が独自のAIモデルインスタンスを使用)を持つチームでした。もしClaudeがタスクの性質をより認識していれば、戦略的に労働を分担し、必要に応じてコミュニケーションを促進することができた可能性があります。現時点では、Claudeは単一の人間とのパートナーシップに向いており、チームのサポートや調整には向いていませんが、これは最終的には変更可能な設計上の選択であるとAnthropicは指摘しています。

実験の限界と今後の展望

Anthropicは、この実験にはいくつかの制限があることを認めています。これはわずか2チームによる1回の実験であり、明らかに小さなサンプルサイズです。また、1日という限られた時間枠でのタスクのみをテストし、学術的には興味深いものの実用的には些細なタスクでした。

Anthropicの従業員ボランティアを使用したことは、便宜的サンプリングに相当します。AIに不慣れな参加者であれば、Claude利用グループと非利用グループの差はより狭くなる可能性があります。AI初心者がAIにアクセスする場合、技術に慣れるためにより多くの時間が必要になり、支援なしのAI初心者は、突然Claudeを奪われた研究者ほど混乱しないでしょう。

最後に、これはClaudeがロボティクス作業を端から端まで実施する能力のテストではありませんでしたが、将来的にそのような評価に向けた重要な第一歩でした。

AIの自律性への道筋と安全性への示唆

Anthropicは、この実験結果を踏まえた重要な考察を提示しています。

まず、この実験はClaudeが価値ある可能性のある領域で人間の能力を向上させることができる別の例を示しました。専門家でない人々が限られた時間内に困難なロボティクスタスクを実行できたということです。

しかし、AIにおいて、upliftはしばしば自律性に先行します。モデルが今日人間が達成するのを助けることができるものは、明日には単独で実行できることが多いのです。コーダーはもはやデバッグのためにAIにコードの断片を与えるだけでなく、AIにタスクを与え、モデル自身にコードを書かせます。

このような研究を考慮すると、Anthropicは、フロンティアAIモデルが以前未知のハードウェアと正常に相互作用できる世界が近づいていると考えています。

この能力を、Anthropicの別の研究ラインと組み合わせて追跡することが重要です。それは、AIが将来世代のAIの開発を自動化・加速する可能性の監視です。これは、Anthropicの「責任あるスケーリング政策(Responsible Scaling Policy)」に含まれる能力閾値の一つです。真に自律的なAI R&Dが、私たちの評価や新たなリスクへの対処能力を上回る急速で予測不可能な進歩をもたらす可能性があるためです。

現在、Anthropicのモデルはまだこの段階には達していません。しかし、この閾値に近づいた場合、Project Fetchの結果は、ロボティクスやその他のハードウェアに対するAIモデルの習熟度を、急激な改善が起こる可能性のある領域として監視する必要があることを示唆しています。

多くの不確実性が残っています。タイムラインは不明確であり、モデルの改善と物理世界での反復がボトルネックを生み出す度合いの両方が不透明です。また、既存のハードウェアを制御することと、新しいハードウェアを設計、構築、改善することは別の問題です。

しかし、強力で知的で自律的なAIシステムが、その知性と力の一部をロボットを介して世界で行動するために使用するという考えは、聞こえるほど突飛なものではないとAnthropicは結論づけています。

まとめ

AnthropicのProject Fetchは、AIモデルがハードウェア制御における人間のパフォーマンスを大幅に向上させることを示しました。Claude利用チームは非利用チームの約半分の時間でタスクを完了し、特にロボットとの接続やセンサーデータへのアクセスにおいて顕著な利点を示しています。一方で、より多くのコードを書く代わりに探索的な作業に時間を費やす傾向や、チーム間のコミュニケーションパターンの違いなど、AI支援がもたらす複雑な影響も明らかになりました。Anthropicは、AIの物理世界への影響力が急速に進展する可能性を指摘し、この領域での能力追跡の重要性を強調しています。