はじめに

Meta社から、新世代の大規模言語モデル(LLM)ファミリー「Llama 4」が発表されました。本稿では、AIエンジニアの皆様がLlama 4を実際に利用し、アプリケーションに組み込むことに焦点を当て、その始め方、実装例、注意点などを中心に解説します。技術的な背景についても触れますが、ここでは概要の理解に留めます。

参照元

- モデル情報・コード例参照元: Hugging Face Model Card: meta-llama/Llama-4-Scout-17B-16E-Instruct

- 発行日: 2025年4月5日

詳細

Llama 4とは?

Llama 4は、Metaによる最新のオープンウェイトLLMシリーズです。主な特徴は以下の通りです。

- ネイティブマルチモーダル: テキストだけでなく、**画像や動画(フレーム)**も自然に理解し、処理できます。これにより、画像に関する質問応答や、テキストと画像を組み合わせた指示などが可能です。

- Mixture-of-Experts (MoE) アーキテクチャ: 効率的な計算を実現するアーキテクチャです。推論時にモデル全体の一部(エキスパート)のみを使用するため、大規模ながらも比較的少ない計算リソースで動作させることが可能です。

- 驚異的なコンテキスト長: 特にLlama 4 Scoutモデルでは、最大1000万トークンという非常に長いコンテキストを扱えます。これにより、長文の文書やコード全体の解析、長期的な対話履歴の保持などが期待できます。

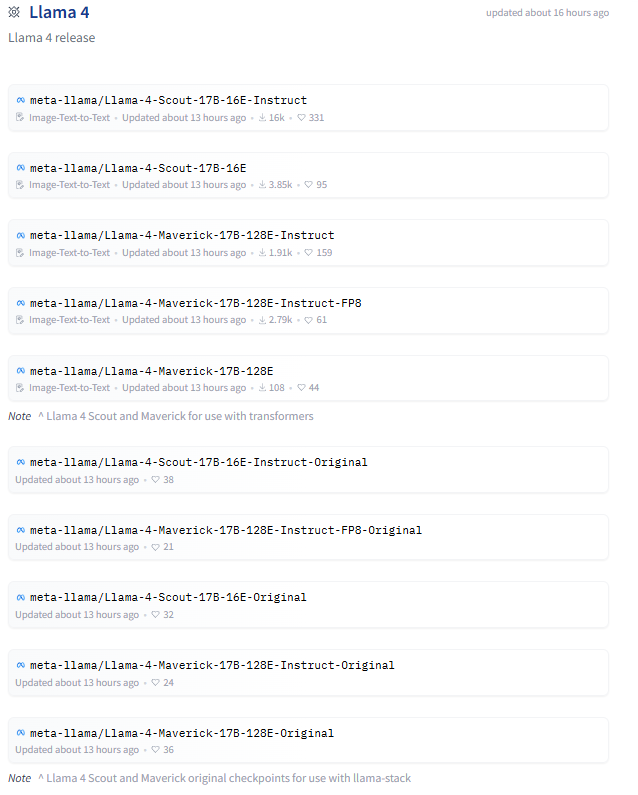

公開モデル紹介

現在、主に以下の2つのモデルが公開されており、用途に応じて選択できます。

- Llama 4 Scout (17Bアクティブ/109Bトータルパラメータ, 16エキスパート):

- 特徴: 1000万トークンのコンテキスト長が最大の特徴。長文処理、複数文書要約、コード解析などに強み。画像グラウンディング能力も高い。

- ターゲット: 長いコンテキストを必要とする研究やアプリケーション。

- 効率: Int4量子化により、単一のNVIDIA H100 GPU (80GB VRAM) で動作可能。

- Llama 4 Maverick (17Bアクティブ/400Bトータルパラメータ, 128エキスパート):

- 特徴: GPT-4oなどに匹敵するクラス最高のマルチモーダル性能。画像理解、チャットボット、創造的なテキスト生成など、汎用的なタスクに最適。

- ターゲット: 高性能なAIアシスタントやマルチモーダルアプリケーション。

- 効率: 100万トークンのコンテキスト長。FP8量子化版はNVIDIA H100 DGXホスト(複数GPU構成)での動作が想定されています。BF16精度ではより多くのリソースが必要。

使い方

1. モデルの入手

Llama 4 ScoutおよびMaverickモデルは、以下のサイトからダウンロードできます。利用にはライセンスへの同意が必要です。

- Meta Llama 公式サイト: https://llama.com/

- Hugging Face Hub: https://huggingface.co/meta-llama

2. 実装例 (Python & Hugging Face Transformers)

Hugging Faceの transformers ライブラリを使えば、比較的簡単にLlama 4を動かすことができるとのことです。以下は、テキストと複数の画像を入力として与え、応答を生成する例です(Maverick Instructモデルを使用)。

# ライブラリのインストール (transformers v4.51.0以降)

# pip install -U transformers torch accelerate Pillow requests

from transformers import AutoProcessor, Llama4ForConditionalGeneration

import torch

from PIL import Image

import requests

# --- 設定 ---

# 利用するモデルIDを選択

model_id = "meta-llama/Llama-4-Maverick-17B-128E-Instruct"

# model_id = "meta-llama/Llama-4-Scout-17B-16E-Instruct"

# 使用するデバイス (GPUが利用可能なら "cuda", なければ "cpu")

# device = "cuda" if torch.cuda.is_available() else "cpu"

# device_map="auto" を使うと自動で割り当ててくれる

# --- 設定終わり ---

print(f"Loading processor for {model_id}...")

processor = AutoProcessor.from_pretrained(model_id)

print(f"Loading model {model_id}...")

# モデルのロード

# torch_dtype=torch.bfloat16 は高性能GPU向け。環境に応じて変更。

# device_map="auto" で自動的にGPU/CPUに割り当て。メモリ不足時はCPUも利用。

model = Llama4ForConditionalGeneration.from_pretrained(

model_id,

device_map="auto", # 自動デバイス割り当て

torch_dtype=torch.bfloat16, # BF16でロード

# attn_implementation="flash_attention_2", # Flash Attention 2が利用可能なら高速化

)

print("Model loaded.")

# --- 入力データの準備 ---

# 画像URLの例

url1 = "https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/diffusers/rabbit.jpg"

url2 = "https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/datasets/cat_style_layout.png"

print("Downloading and opening images...")

try:

image1 = Image.open(requests.get(url1, stream=True).raw)

image2 = Image.open(requests.get(url2, stream=True).raw)

print("Images loaded.")

except Exception as e:

print(f"Error loading images: {e}")

exit()

# ユーザーからの質問(テキスト)

text_prompt = "この2つの画像の類似点と相違点を説明してください。"

# チャット形式のメッセージリストを作成

messages = [

{

"role": "user",

"content": [

{"type": "image"}, # 1つ目の画像のプレースホルダ

{"type": "image"}, # 2つ目の画像のプレースホルダ

{"type": "text", "text": text_prompt},

]

},

]

print("Message template created.")

# --- 入力データの準備終わり ---

# --- モデル入力の作成 ---

print("Applying chat template and tokenizing...")

# プロセッサでテンプレート適用とトークン化

inputs = processor.apply_chat_template(

messages,

images=[image1, image2], # 画像データをリストで渡す

add_generation_prompt=True, # モデルが応答しやすいようにプロンプト末尾を調整

tokenize=True,

return_dict=True,

return_tensors="pt", # PyTorchテンソルで返す

).to(model.device) # モデルと同じデバイスに送る

print("Inputs prepared for the model.")

# --- モデル入力の作成終わり ---

# --- 応答生成 ---

print("Generating response...")

# モデルで応答を生成

try:

outputs = model.generate(

**inputs,

max_new_tokens=256, # 生成する最大トークン数

do_sample=True, # サンプリングを有効にする場合

temperature=0.7, # 生成の多様性を調整 (do_sample=Trueの場合)

top_p=0.9, # Top-pサンプリング (do_sample=Trueの場合)

)

print("Response generated.")

# 生成されたトークンをデコード

# 入力部分を除いた生成テキストのみを取得

response_text = processor.batch_decode(outputs[:, inputs["input_ids"].shape[-1]:], skip_special_tokens=True)[0]

# 結果の表示

print("\n--- モデルの応答 ---")

print(response_text)

print("--- 応答終わり ---")

except Exception as e:

print(f"Error during generation: {e}")

# --- 応答生成終わり ---

3. 注意点 (Important Notes)

- 必要ライブラリ: 上記コードの実行には

transformers,torch,accelerate,Pillow,requestsが必要です。 - ハードウェア要件 (VRAM):

- Llama 4 Scout: Int4量子化を使用する場合、80GB VRAM (例: NVIDIA H100) 1枚で動作する可能性があります。

- Llama 4 Maverick: BF16精度では複数GPU(合計数百GB VRAM) が必要になる可能性が高いです。FP8量子化版はH100 DGXホスト(複数GPU構成)での動作が想定されています。単一の80GB VRAMでは不足する可能性が高いです。

device_map="auto"を使うと、VRAMが不足する場合にCPUメモリも利用しようとしますが、パフォーマンスは大幅に低下します。

データ型 (torch_dtype):torch.bfloat16は比較的新しいGPUが必要です。環境に応じてtorch.float16やtorch.float32(より多くのメモリが必要) に変更してください。- ライセンス: モデルの利用には Llama 4 Community License Agreement への同意が必要です。商用利用に関する条件(特に月間アクティブユーザー数)も確認してください。

- アクセス許可: Hugging Faceでモデルを利用するには、アクセスリクエストが必要な場合があります。

安全な利用のために

Metaは、Llama 4を安全に利用するためのツールも提供しています。これらをアプリケーションに組み込むことを検討してください。

- Llama Guard: 入力プロンプトやモデルの出力が、設定した安全ポリシーに違反していないかをチェックできるモデル。

- Prompt Guard: 不適切な指示(ジェイルブレイク)や意図しない操作(プロンプトインジェクション)を狙った入力を検出するモデル。

- CyberSecEval: 生成AIに関連するサイバーセキュリティリスクを評価するためのツール群。

これらのツールはオープンソースで提供されており、開発者が自身のユースケースに合わせてカスタマイズすることが推奨されています。

まとめ

Llama 4は、強力なマルチモーダル機能と長いコンテキスト長を、オープンウェイトモデルとして提供することで、AI開発の新たな可能性を広げます。本稿で紹介した実装例や注意点を参考に、ぜひLlama 4を試してみてください。

特に、Hugging Faceの transformers ライブラリを活用することで、比較的容易にこれらの先進的なモデルを自身のプロジェクトに導入できます。ただし、モデルサイズに応じた適切なハードウェアの準備と、ライセンス、そして安全な利用のためのガイドライン遵守が重要です。