はじめに

科学研究の世界において、論文の品質を担保する「査読」は極めて重要なプロセスです。しかし、査読者の負担増大やプロセスの透明性は長年の課題でした。そこに登場したのがAIです。本稿では、世界的なオープンアクセス出版社であるFrontiersが2025年に発表した、学術研究と出版プロセスにおけるAI活用に関するレポート「Unlocking AI’s untapped potential: responsible innovation in research and publishing」について解説します。

本稿で紹介するFrontiersのレポートは、世界中の研究者1,645名を対象とした調査に基づき、AIが研究執筆だけでなく、評価プロセス(査読)においても「静かな革命」を起こしている現状を明らかにしています。

現在のAI利用がテキストの整形といった「表面的なタスク」に留まっており、データ分析や方法論の検証といった「深い潜在能力」が未活用のままであるという指摘は、今後のAIエージェント開発やRAG(検索拡張生成)システムの設計において重要なヒントになるはずです。

解説論文

- 論文タイトル: Unlocking AI’s untapped potential: responsible innovation in research and publishing (AIの未開拓の可能性を解き放つ:研究と出版における責任あるイノベーション)

- 論文URL: https://www.frontiersin.org/documents/unlocking-ai-potential.pdf

- 発行日: 2025年(調査期間:2025年5月~6月)

- 発表者: Frontiers Media

・あくまで個人の理解に基づくものであり、正確性に問題がある場合がございます。

必ず参照元論文をご確認ください。

・本記事内での画像は、上記論文より引用しております。

要点

- 査読におけるAI利用の一般化:査読者の53%がすでにAIツールを使用しており、AI利用はもはや一部の例外的な行為ではなく、標準的なプロセスになりつつある。

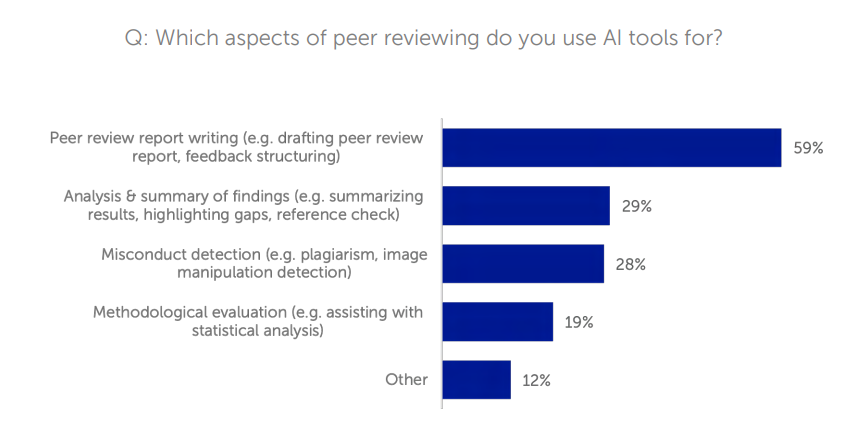

- 「表層的利用」と「深層的価値」の乖離:現在のAI利用の多くは、文法チェックやレポートのドラフト作成(59%)などの表面的なタスクに集中しており、方法論の検証や統計のチェックといった、科学的厳密性を高めるための深い分析(19%)には十分に活用されていない。

- 地域・世代間のギャップ:中国やアフリカではAIを「言語の壁を超えるエンパワーメントツール」として積極的に採用している一方、北米や欧州では倫理的懸念から慎重な姿勢が見られる。また、若手研究者の方がシニア層よりもAI利用率が高い。

- 3つの主要な障壁:AIの可能性を阻害している要因として、「信頼(Trust)」「トレーニング(Training)」「ガバナンス(Governance)」の3つのギャップが特定された。特に研究者の35%は独学でAIを利用しており、体系的な教育が不足している。

- 責任あるAIガバナンスの枠組み:Frontiersは、透明性、説明責任、公平性などを柱とする6つの原則からなるAIガバナンスフレームワークを提唱している。

詳細解説

以下、レポートの構成に従い、各項目の詳細を解説します。

The quiet revolution: The rise of AI in peer review(静かな革命:査読におけるAIの台頭)

これまでAIの影響は主に論文の「執筆」において注目されてきましたが、本レポートでは「査読」プロセスにおけるAI利用が急速に進んでいることが報告されています。調査によると、査読者の 53% が何らかの頻度でAIツールを使用しており、過去12ヶ月でその利用頻度が増加したと回答した人は24%に上ります。これは、科学的な品質評価のシステムにおいて、文化的なシフトが起きていることを示しています。

Surface use, deep potential(表面的な利用、深い潜在能力)

AIエンジニアとして注目すべきは、AIが「何に使われているか」という点です。

- 表面的な利用(Surface use):レポートの下書き作成(59%)、要約(29%)、剽窃検知(28%)など、効率化や形式的なチェックが主です。

- 深い潜在能力(Deep potential):方法論の健全性評価や統計分析の検証といった、科学的発見の信頼性を高めるための利用はわずか 19% に留まっています。

レポートは、AIの真の価値はルーチンワークの加速ではなく、人間の専門知識を補完し、研究の再現性や厳密性を高める「戦略的かつ分析的な展開」にあると指摘しています。

Unlocking AI’s potential globally and across generations(世界規模および世代間でAIの可能性を解き放つ)

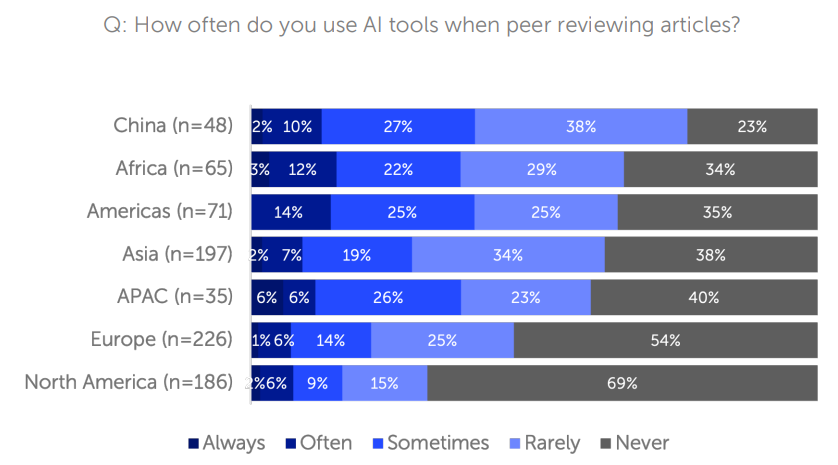

AIの受容には地域差があります。

- 高採用地域:中国(77%が利用)やアフリカ(66%が利用)。これらの地域では、AIは英語のハンディキャップを克服し、参入障壁を下げるための「イコライザー(公平化ツール)」として歓迎されています。

- 慎重な地域:北米(31%)や欧州(46%)。倫理、バイアス、透明性への懸念が先行し、利用が抑制されています。

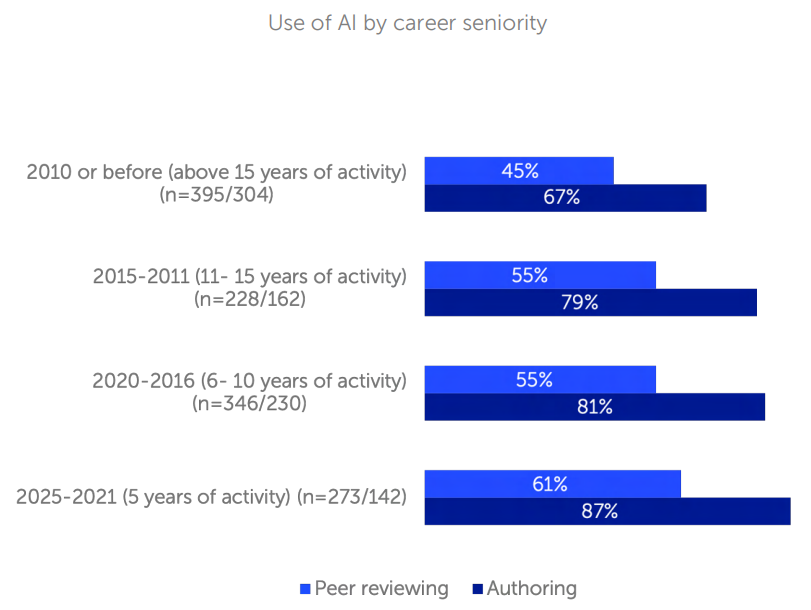

また、キャリア5年未満の若手研究者の61%が査読でAIを利用しているのに対し、15年以上のベテラン層では45%に留まるという世代間ギャップも存在します。

Bridging the gap to impactful AI use in research(研究におけるインパクトあるAI利用へのギャップを埋める)

AIの本格的な統合を阻む、3つのギャップが特定されました。

The trust gap(信頼のギャップ)

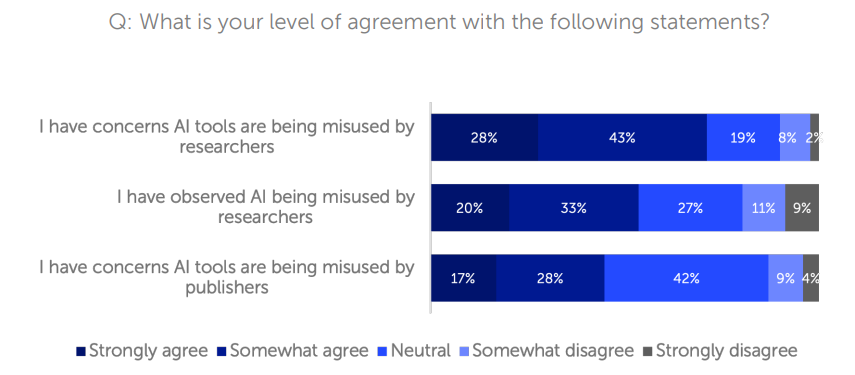

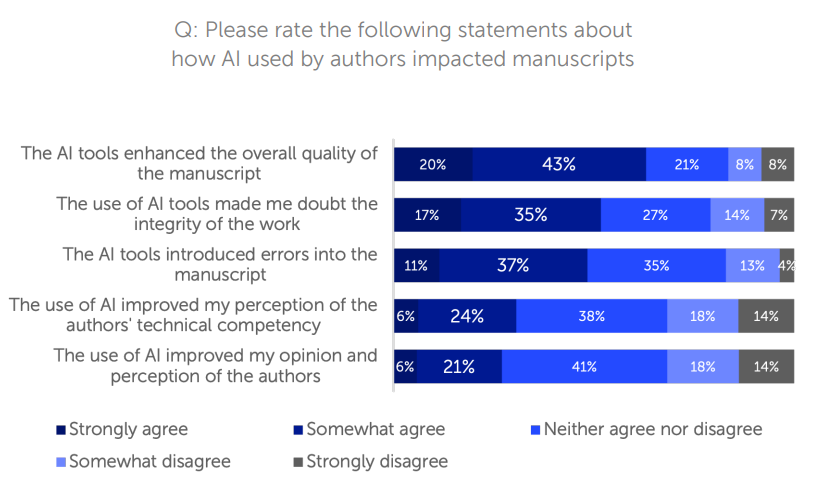

研究者はAIの利点を認めつつも、その境界線に不安を抱いています。回答者の71%が「研究者によるAIの誤用」を懸念しています。

52%はAIが使用されたことを知ると「研究の誠実さを疑う」と回答しています。

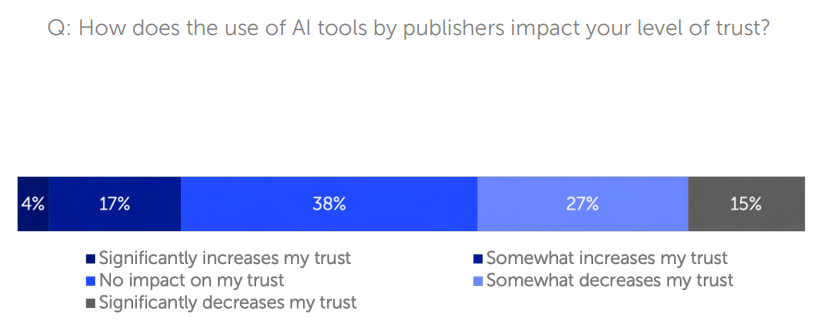

ここで言う「誤用」とは、悪意ある捏造だけでなく、検証なしに生成テキストを使用するといった不適切な慣行も含みます。出版社がAIを使用することに対しても、信頼が高まると答えたのはわずか21%でした。この不信感の背景には「透明性の欠如」があり、誰がどこでAIを使ったかが不明確であることが不安を増幅させています。

The training gap(トレーニングのギャップ)

AIリテラシーの欠如も深刻です。

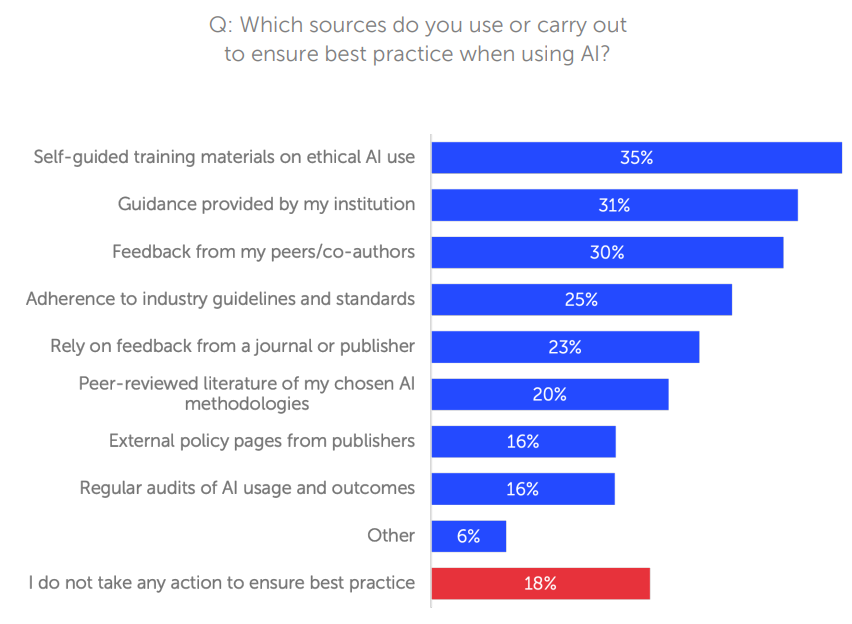

- 35% が完全な独学。

- 18% はベストプラクティスを保証するための行動を何もとっていない。

AIエンジニアであれば、モデルの限界やハルシネーションのリスクを理解していますが、多くの研究者は「AIは査読のような複雑なタスクを扱えない」と懐疑的であるか、逆に過信してしまっています。プロンプトエンジニアリングや出力の検証方法に関する公的なトレーニングが不足しています。

The policy and governance gap(ポリシーとガバナンスのギャップ)

回答者の20%が、AI利用の最大の障壁として「ガバナンスの欠如やルールの不明確さ」を挙げています。明確なルールがないため、研究者は手探り状態です。出版社や機関からのガイダンスに頼っている研究者は少数派であり、現場の混乱が浮き彫りになっています。

What’s next? Actions to unlock AI’s full potential(次は何か? AIの可能性を完全に解き放つためのアクション)

レポートは、各ステークホルダーに対して具体的なアクションを提言しています。

- 教育機関向け:AIリテラシーをカリキュラムに統合し、認定トレーニングを提供する。

- 資金配分機関(Funders)向け:資金提供した研究におけるAI利用の開示を義務付け、透明性を確保する。

- ツール開発者向け:AIの内部動作(ブラックボックス性)を可能な限り説明し、独立した監査を可能にする。

- 出版社向け:AI利用ポリシーを外部に公開し、編集者や査読者と共同でAIリテラシープログラムを開発する。

Frontiers’ framework for responsible AI governance(責任あるAIガバナンスのためのFrontiersのフレームワーク)

Frontiersは、OECDやUNESCOなどの国際基準に準拠した、以下の6つの柱からなるフレームワークを策定しました。

- 透明性と説明責任(Transparency and accountability):いつ、どこでAIが使われたかを完全に可視化する。

- AIリテラシーと能力構築(AI literacy and capacity building):内部の専門知識を高めるための構造化された教育を開発する。

- 倫理と誠実性のガードレール(Ethics and integrity guardrails):AI展開のための明確な基準を設定する(バイアス許容度など)。

- 公平性とアクセスのガバナンス(Equity and access governance):AI導入のあらゆる層に公平性を組み込む(言語バイアスの排除など)。

- コミュニティエンゲージメント(Community engagement):科学コミュニティを巻き込んでポリシーを改善する。

- 監視、監査、ポリシーリーダーシップ(Monitoring, audit and policy leadership):責任あるAIガバナンスを推進する。

Conclusion(結論)

AIの利用は転換点を迎えています。今必要なのは、躊躇することではなく、急速かつ責任を持ってAIを統合することです。出版社や研究機関は、AIを単なる効率化ツールとしてではなく、科学的発見を加速し、不平等を是正するためのインフラとして位置づけ、リーダーシップを発揮する必要があります。

まとめ

本稿では、Frontiersのレポートをもとに、学術研究の査読プロセスにおけるAI活用の現状と課題を解説しました。

興味深いのは、「表面的なタスク(要約・整形)」から「深層的なタスク(論理検証・データ分析)」への移行が求められている点です。RAGやエージェント技術の進化により、今後は「論文の論理的整合性をチェックするAI」や「統計データの異常を検知するAI」が査読者の強力なパートナーとなると想定されています。