はじめに

Anthropicが2025年12月5日、AIを活用した大規模インタビューツール「Anthropic Interviewer」を発表しました。このツールを使用して1,250人の専門職を対象に実施した調査から、AIが職場でどのように受け入れられ、活用されているかという実態が明らかになりました。本稿では、この研究の内容と、AIによるインタビュー手法の技術的な仕組み、そして各職種における具体的な活用状況について解説します。

参考記事

- タイトル: Introducing Anthropic Interviewer: What 1,250 professionals told us about working with AI

- 著者: Kunal Handa, Michael Stern, Saffron Huang, Jerry Hong, Esin Durmus, Miles McCain, Grace Yun, AJ Alt, Thomas Millar, Alex Tamkin, Jane Leibrock, Stuart Ritchie, Deep Ganguli

- 発行元: Anthropic

- 発行日: 2025年12月5日

- URL: https://www.anthropic.com/research/anthropic-interviewer

・あくまで個人の理解に基づくものであり、正確性に問題がある場合がございます。

必ず参照元論文をご確認ください。

・本記事内での画像は、上記論文より引用しております。

要点

- Anthropic InterviewerはClaudeを活用した自動インタビューツールで、計画、インタビュー実施、分析の3段階で動作する

- 1,250人の専門職(一般労働者1,000人、科学者125人、クリエイター125人)を対象に、AIの職場での活用状況と感情を調査した

- 一般労働者の86%が時間節約を実感し、65%がAIの役割に満足している一方、55%が将来への不安を表明している

- クリエイターは生産性向上を実感しつつも、70%が同業者からの評価を気にしており、経済的不安も抱えている

- 科学者は79%が信頼性の問題を指摘し、現時点では仮説生成や実験設計といった中核的研究にAIを使用していない

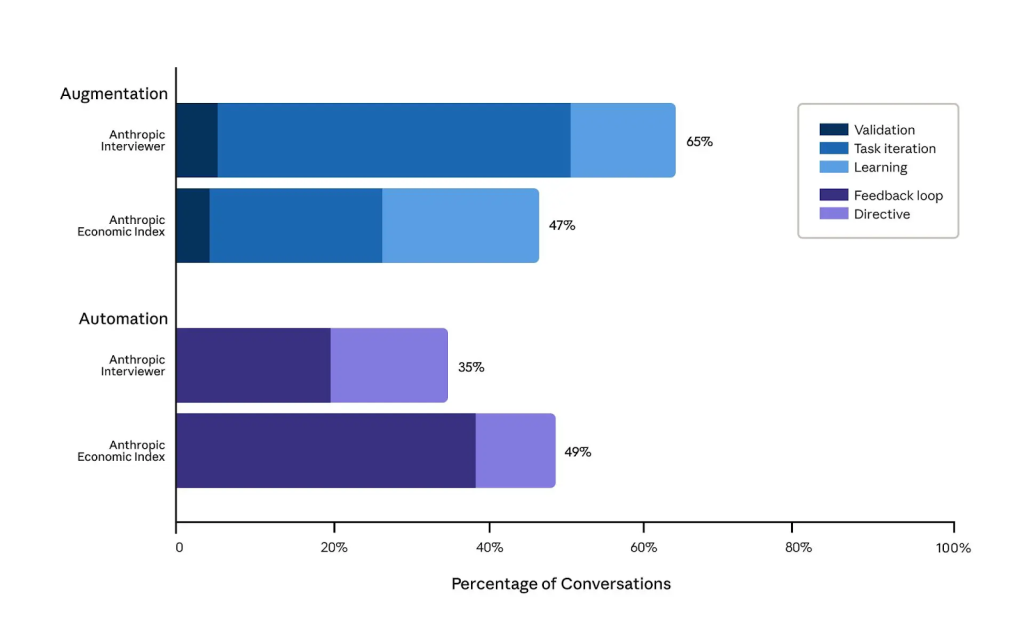

- 参加者は自己申告でAI利用の65%を「拡張的」と答えたが、実際のClaude利用データでは47%拡張、49%自動化とほぼ均等だった

詳細解説

Introduction(序論)

数百万人が日常的にAIを使用する時代において、人々がどのようにAIを活用し、それが彼らにどのような影響を与えているかを理解することは、AI開発企業にとって重要な課題です。Anthropicは以前、ユーザーのプライバシーを保護しながらAI利用パターンを分析するツールを開発し、経済全体でのAI利用の変化を分析しました。しかし、このツールではClaude内での会話内容しか把握できず、会話終了後に人々が実際にどのようにClaudeの出力を利用しているか、それについてどう感じているか、将来AIにどのような役割を期待しているかといった点は分かりませんでした。

そこでAnthropicは、人々に直接尋ねるという手法を採用することにしました。ただし、包括的な理解を得るには数百件のインタビューが必要となるため、AI自身にインタビューを実施させる「Anthropic Interviewer」というツールを開発しました。このツールは、Claudeを活用して大規模なインタビューを自動的に実施し、その結果を人間の研究者が分析できる形で提供します。

初期テストでは、一般労働者1,000人、科学者125人、クリエイター125人の合計1,250人を対象にインタビューを実施しました。Anthropicはすべてのインタビューデータを(参加者の同意を得た上で)研究者向けに公開しています。

Method(手法)

Participants(参加者)

今回の調査では、クラウドワーカープラットフォームを通じて1,250人の専門職を募集しました。ただし、すべての参加者はクラウドワーキング以外に主たる職業を持っている人々です。

一般サンプルの1,000人の内訳は、教育分野(17%)、コンピュータ・数学分野(16%)、芸術・デザイン・エンターテインメント・メディア分野(14%)が最大のグループでした。

また、2つの専門サンプルとして、クリエイター125人(作家・著者が48%、ビジュアルアーティストが21%、他に映画制作者、デザイナー、音楽家など)と、科学者125人(物理学者9%、化学者9%、化学工学者7%、データサイエンティスト6%、その他50以上の科学分野)を募集しました。

クリエイターと科学者を専門サンプルとして追加した理由は、これらの職業分野ではAIの役割が急速に進化しており、議論の余地が残っているためです。これらの分野では、AIの導入に関する独特のパターンや専門的な懸念が浮かび上がると仮説を立てました。

How Anthropic Interviewer works(Anthropic Interviewerの動作原理)

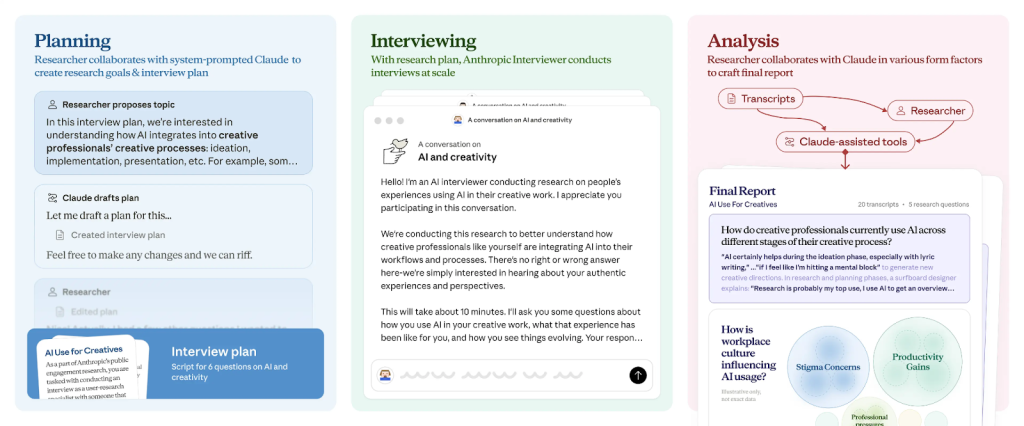

Anthropic Interviewerは、計画(Planning)、インタビュー(Interviewing)、分析(Analysis)の3つの段階で動作します。

Planning(計画段階)

この段階では、Anthropic Interviewerが数百から数千のインタビューにわたって同じ研究課題に焦点を当てながらも、個々のインタビューで生じる変化や脱線にも柔軟に対応できるインタビュー計画を作成します。

まず、AIモデルにどのように動作すべきかの全体的な指示を与えるシステムプロンプトを開発しました。ここには各サンプルに関する仮説や、インタビュー計画作成のベストプラクティス(ユーザーリサーチチームとの協力で確立)を含めました。

システムプロンプトを設定した後、Anthropic Interviewerは研究目標の知識を使用して、具体的な質問と計画的な会話の流れを生成します。その後、人間の研究者がAnthropic Interviewerと協力してレビューを行い、必要な編集を加えて計画を完成させました。

Interviewing(インタビュー段階)

Anthropic Interviewerは、作成したインタビュー計画に従ってリアルタイムで適応的なインタビューを実施しました。この段階では、インタビューのベストプラクティスをAnthropic Interviewerに指示するシステムプロンプトを含めました。

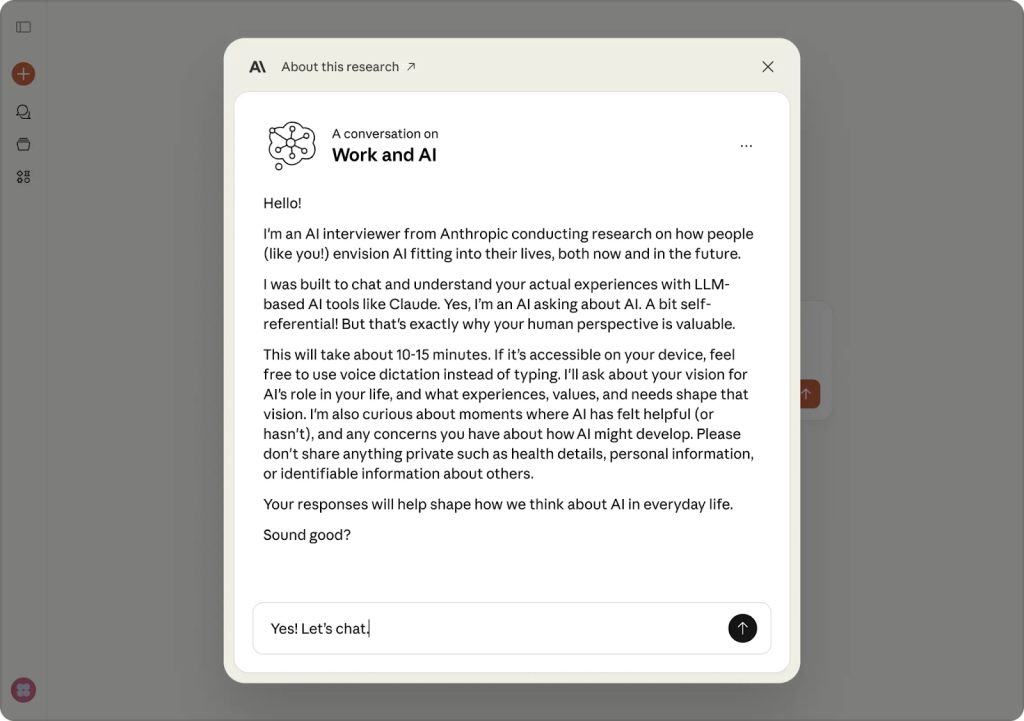

インタビューはClaude.ai上で実施され、各参加者との対話は約10〜15分間続きました。インタビューのインターフェースは、現在ユーザー向けに公開されているモジュールと同様の形式で表示されました。

Analysis(分析段階)

インタビュー完了後、人間の研究者がAnthropic Interviewerと協力してトランスクリプトを分析しました。Anthropic Interviewerの分析ステップは、初期のインタビュー計画を入力として受け取り、研究課題への回答と説明的な引用を出力します。この段階では、自動化されたAI分析ツールも使用して、浮かび上がってきたテーマを特定し、参加者全体でのその普及度を定量化しました。

定性分析においては、すべての定性研究と同様に、研究者が尋ねた質問やデータから探したパターンが解釈に反映されることを認識しておく必要があります。

Research goals(研究目標)

Anthropic Interviewerは、システムプロンプトを通じて研究目標を認識し、それに対応する形でインタビューを実施しました。各サブサンプルの主な研究目標は以下の通りです:

- 一般労働者: 個人がAIツールを専門的なワークフローにどのように統合しているか、使用パターン、タスクの好み、インタラクションスタイルを探索し、職場における人間とAIの進化する関係についての洞察を得ること

- クリエイター: クリエイティブ専門職が現在AIをクリエイティブプロセスにどのように統合しているか、AIが自身の仕事に与える影響についての経験、AIと人間の創造性の将来的な関係についてのビジョンを理解すること

- 科学者: AI システムが科学者の日常的な研究ワークフローにどのように統合されるか、現在の使用パターン、認識される価値、信頼レベル、科学的プロセスの異なる段階における導入の障壁を理解すること

Results(結果)

AI’s impact in the general workforce(一般労働者へのAIの影響)

一般サンプルの専門職は、全体的にAIが生産性を向上させると述べました。調査では、専門職の86%がAIによって時間を節約でき、65%が自身の仕事におけるAIの役割に満足していると回答しました。

浮かび上がってきたテーマの1つは、職場のダイナミクスがAIの採用にどのように影響するかという点です。専門職の69%が、職場でAIツールを使用することに伴う社会的スティグマ(偏見)について言及しました。あるファクトチェッカーは次のように述べています:「同僚が最近、AIが嫌いだと言ったので、私は何も言いませんでした。多くの人がAIについてどう感じているか知っているので、自分のプロセスを誰にも話しません。」

一方で、インタビュー対象者の41%は自分の仕事に安心感を持ち、人間のスキルは置き換えられないと信じていましたが、55%はAIが将来に与える影響について不安を表明しました。不安を表明したグループの25%は、AI使用に関して境界線を設定し(例えば、教育者が常に自分でレッスンプランを作成するなど)、別の25%は職場での役割を適応させ、追加の責任を引き受けたり、より専門的なタスクを追求したりしていました。

AI使用へのアプローチは大きく異なりました。あるデータ品質マネージャーは、自動化よりも学習を意図的に選択しました:「外国語を勉強するように考えようとしています。翻訳アプリを使うだけでは何も教わりませんが、質問に答えてくれて、ニーズに合わせてカスタマイズしてくれるチューターがいれば、本当に役立ちます。」マーケティング担当者は柔軟なアプローチを取りました:「強力なニッチを保ちながら多様化しようとしています。」通訳者はすでに分野を完全に離れる準備をしていました:「AIは最終的にほとんどの通訳者を置き換えると信じています…だから、すでにキャリアチェンジの準備をしており、おそらくディプロマを取得して別の職種に入ろうとしています。」注目すべきことに、専門職のわずか8%のみが、明確な改善計画なしに不安を表明していました。

また、6つの主要な職業カテゴリー(O*NETデータベースから)について、インタビュー中に参加者が表現した感情の強度も分析しました。希望、心配、満足、フラストレーション、安堵、信頼という6つの主要な感情を測定しました。異なる職業は、高い満足度レベルを特徴とする均一な感情プロファイルを示しました。しかし、これはフラストレーションと組み合わさっており、専門職がAIを有用だと感じている一方で、重要な実装上の課題に直面していることを示唆しています。

Augmentation versus automation(拡張 vs 自動化)

以前の分析で、AI使用を拡張(AIがユーザーと協力してタスクを実行)または自動化(AIが直接タスクを実行)のいずれかに分類しました。Anthropic Interviewerのデータでは、参加者の65%がAIの主な役割を拡張的と説明し、35%が自動化的と説明しました。注目すべきことに、これは人々がClaudeをどのように使用しているかについての最新の分析とは異なっていました。実際の使用では、47%のタスクが拡張、49%が自動化でした。

この違いには複数の潜在的な説明があります:

- Anthropic Interviewerの調査回答者と以前の調査のユーザーの間にサンプルの違いがある可能性

- 人々のClaudeでの会話は、実際よりも自動化的に見える可能性があり、ユーザーがチャット終了後にClaudeの出力を洗練または適応させている可能性

- 参加者が異なるタスクに異なるAIプロバイダーを使用している可能性

- 自己申告のインタラクションスタイルが実際の使用から乖離している可能性

- 専門職が、Claudeでの会話パターンが示すよりも、AI使用をより協力的だと認識している可能性

専門職は、拡張と自動化の両方を含む未来を想定していました。すなわち、日常的で管理的なタスクの自動化と、人間の監督の維持です。インタビュー対象者の48%が、直接的な技術作業を行うのではなく、AIシステムの管理と監督に焦点を当てた職位への転職を検討していました。

あるリーダーは「AIでスキルを高めれば、管理面で多くの時間を節約でき、人々と一緒にいる時間が増える」と述べました。また、「良い境界線」の重要性を強調し、「AIに依存しすぎて、それなしでは生きられない、または自分が呼ばれていることを実行できない」状態を避けることの重要性を指摘しました。

コミュニケーション専門職は次のように述べました:「私の仕事の大部分はおそらくいつかAIに引き継がれると信じています。私の役割は最終的に、実際に作業を行うのではなく、プロンプト作成、監督、トレーニング、モデルの品質管理に焦点を当てるようになると思います。」現在職場でのAI使用が禁止されている専門職(例えば、一部の弁護士、会計士、医療従事者)は、将来的に多くのタスクを自動化できるようになる政策変更を予想していました。

AI’s impact on creative professions(クリエイティブ職業へのAIの影響)

クリエイティブ専門職のサンプルも、AIが生産性を向上させると報告しました。97%がAIによって時間を節約でき、68%が作品の質が向上したと回答しました。ある小説家は「リサーチが intimidating ではなくなったので、より速く書けると感じる」と説明し、ウェブコンテンツライターは「磨かれた専門的なコンテンツを1日2,000語から5,000語以上生産できるようになった」と報告しました。写真家は、AIが日常的な編集作業を処理することで、ターンアラウンドタイムが「12週間から約3週間」に短縮され、「以前は見逃していたかもしれない、または時間がなかった意図的な編集と調整を行える」ようになったと述べました。

一般サンプルと同様に、クリエイターの70%がAI使用に関する同業者の評価を管理しようとしていることに言及しました。あるマップアーティストは次のように述べました:「自分のブランドとビジネスイメージが、AIとそれを取り巻くスティグマに過度に結びつくことを望んでいません。」

経済的不安はクリエイターのインタビュー全体に現れました。ある声優は次のように述べました:「産業用声優など、声優の特定のセクターはAIの台頭により本質的に死滅しました。」作曲家は、「出版ライブラリと共にAI技術を活用して無限に新しい音楽を生成する」プラットフォームについて懸念し、人間が制作した音楽の安価な代替品で市場を溢れさせる可能性を心配していました。別のアーティストは同様の懸念を捉えました:「現実的には、市場で競争力を保ち生計を立てるために、生成AIを使い続け、生成されたコンテンツを販売し始める必要があるのではないかと心配しています。」クリエイティブディレクターは次のように述べました:「私の利益が別のクリエイターの損失であることを完全に理解しています。以前は1日2,000ドル支払っていたプロダクト写真家は、もう私のビジネスを得られません。」(なお、Claudeは画像、ビデオ、音楽を生成しないため、参加者が表明した不安はAI全般に関するものであり、Claudeに特定したものではありません。)

125人の参加者全員が、クリエイティブな出力のコントロールを維持したいと述べました。しかし、この境界線は実際には不安定であることが判明しました。多くの参加者は、AIが創造的決定を主導する瞬間があることを認めました。あるアーティストは次のように認めました:「AIがコンセプトのかなりの部分を主導しています。私は単にそれを導こうとしているだけです…60%がAI、40%が私のアイデアです。」ミュージシャンは次のように述べました:「認めたくないですが、これを使用するときはプラグインがほとんどの支配権を持っています。」

6つの主要なクリエイティブ分野について感情を分析したところ、分野によって異なる感情プロファイルが見られました。ゲーム開発者とビジュアルアーティストは高い満足度を報告しましたが、同時に高い心配も示しました。デザイナーは逆のパターンを示し、フラストレーションが支配的で満足度は著しく低い状態でした。すべての分野で信頼は一貫して低く、人間の創造性の未来に関する不確実性が共有されていることを示唆しています。満足度と心配の間の緊張は、AIツールを受け入れながらも人間の創造性の未来に関する懸念と格闘しているクリエイティブ専門職の立場を浮き彫りにしています。

AI’s impact on scientific work(科学的研究へのAIの影響)

化学、物理学、生物学、計算分野の研究者へのインタビューから、多くの場合、AIはまだ仮説生成や実験などの研究の中核的要素を扱えないことが明らかになりました。科学者は主に、文献レビュー、コーディング、執筆などの他のタスクにAIを使用していると報告しました。これは、Anthropicを含むAI企業が、ツールと機能の改善に取り組んでいる分野です。

信頼性の懸念が、インタビューの79%で主要な障壁でした。AIシステムの技術的限界は、インタビューの27%で現れました。ある情報セキュリティ研究者は次のように指摘しました:「エージェントが提供するすべての詳細を二重チェックして確認し、間違いがないことを確認しなければならないなら、エージェントにこの作業をさせる目的が somewhat defeats されます。」数学者はこのフラストレーションを反映しました:「AI出力を検証するのに時間を費やした後、基本的に同じ時間になります。」化学エンジニアは sycophancy(追従性)に関する懸念を指摘し、次のように説明しました:「AIは[ユーザーの]感受性に迎合し、質問の言い方によって答えを変える傾向があります。この不一致は、AI応答に対して私を懐疑的にする傾向があります。」

6つの主要な科学分野について感情を分析したところ、ほとんどの科学分野が高い満足度を報告しましたが、フラストレーションパターンは異なっていました。物理学者とデータサイエンティストは高いフラストレーションを示しましたが、化学および機械エンジニアは最小限のフラストレーションを示しました。これは、計算分野と実験分野がAIを中核的な研究ワークフローに統合しようとする方法の違いを反映している可能性があります。実世界とのインタラクションを必要とする作業をする科学者は、まだ中核的な科学実験にAIを使用しようとしていないのかもしれません。信頼はすべての分野で比較的低いままであり、分野に関係なく広範な信頼性の懸念を示しています。AIの影響について高いレベルの懸念を表明するクリエイティブ専門職とは異なり、科学者は比較的低い心配レベルを示しています。これは、仮説生成と実験タスクを完了するAIの能力に関する彼らの述べたフラストレーションと一致しています。

科学者は一般的に、AIによる雇用の代替を恐れていませんでした。一部の人々は、デジタル化に抵抗する暗黙知を指摘し、ある微生物学者は次のように説明しました:「私が扱っていた1つの細菌株では、細胞が特定の色に達したときに様々なステップを開始する必要がありました。色の違いは見て理解する必要があり、[指示は]めったにどこにも書き留められていません。」他の人々は、研究の意思決定の本質的に人間的な性質を強調し、あるバイオエンジニアは次のように述べました:「実験と研究も…本質的に私次第です」と述べ、「研究プロセスの特定の部分は、最も自動化するのに便利な部分であるにもかかわらず、残念ながらAIと互換性がありません、例えば実験を実行することです。」

外部的な制約もAIによる置き換えへの障壁を生み出しました。機密環境の研究者は、「組織が私たちにエージェンティック・フレームワークを使用することを許可する前に、多くの『すべきこと』と『すべきでないこと』があり、セキュリティ指向のプロセスが設置されなければなりません、例えばLLMです」と指摘しました。限られたリソースを管理している機械エンジニアは、「AIは実験デザインを考え出すのは得意です」が、実際には「私の研究のほとんどは予算/時間/標本の制限があるため、『理想的な』デザインは必ずしも実行可能ではありません」と説明しました。それにもかかわらず、規制遵守の制約、スキルの萎縮に関する懸念、コスト障壁は、それぞれインタビューの10%未満で言及されました。

科学者の91%が、今日の製品が要求を満たしていないと感じていても、研究においてより多くのAI支援を求めました。約3分の1は主に執筆タスクの支援を想定していましたが、大多数は研究全体にわたる支援を望んでいました:実験デザインの批評、科学データベースへのアクセス、分析の実行。共通の願望は、新しい科学的アイデアを生み出せるAIでした。ある医学科学者は次のように述べました:「AIが…仮説の生成や支援、または人間には immediately 明らかでない新しい相互作用/関係を探すのを手伝ってくれることを願っています。」別の科学者はこの感情を反映しました:「価値ある研究パートナーのように感じられるAIが欲しいです…何か新しいものをテーブルに持ってこられる。」

Looking forward(今後の展望)

この初期テストは、Anthropic Interviewerが規模において効果的であることを実証しました。さまざまな専門職を対象とした1,250件のインタビューを実施し、職場でのAIに関する彼らの感情を理解することができました。従来の「手動」インタビュー手法では、この参加者数での研究は高価で時間がかかったと考えられます。

しかし、Anthropic Interviewerの重要性は方法論を超えています。これは、社会におけるAIの役割について質問し、答えることができる問いを根本的に変えるものであり、あらゆるトピックに関するインタビューがこの新しい規模で実施できるようになります。Anthropic Interviewerを使用した意義のある大規模研究への取り組みは、始まったばかりです。以前は、人々がチャットウィンドウ内でClaudeをどのように使用しているかについての洞察しかありませんでした。人々がAIの使用についてどのように感じているか、技術とのインタラクションについて何を変えたいか、または人々がAIの将来の役割をどのように想定しているかは分かりませんでした。

この初期調査からの発見は、人々が職場でAIをどのように使用しているかを理解するためのEconomic Indexの取り組みを超えた新しい洞察を提供します。Anthropicは、これらの初期発見をEconomic Advisory CouncilおよびHigher Education Advisory Boardと議論するために共有しています。この研究を継続するにつれて、パイロット結果と、発見が将来の作業にどのように情報を提供するかを公に共有する予定です。

Anthropic Interviewerは、AIモデルの開発に関する会話に人間の声を中心に据える最新のステップです。これは、Collective Constitutional AIの取り組みで始まったもので、Claudeの動作を形作るために公的な視点を収集しました。これらの会話は、Claude自体の特性とトレーニングプロセスを改善するのに役立ち、Anthropicが支持し採用する将来の政策に情報を提供することができます。以下は、特定のコミュニティとのパートナーシップを探索するために講じた実践的なステップの一部です:

- クリエイター: AIが創造性をどのように拡張しているかを理解するために、展示会、ワークショップ、イベントの開発を支援しています。LAS Art Foundation、森美術館、Tateなどの主要な文化機関、およびRhizomeやSocraticaなどのクリエイティブコミュニティとパートナーシップを結んでいます。さらに、人気のあるクリエイティブツールの背後にある企業と協力して、Model Context Protocolを介してClaudeがどのようにクリエイターの作業を拡張できるかを探索しています。

- 科学者: AI for Science助成金受領者とパートナーシップを結び、AIが彼らの研究にどのように最善のサービスを提供できるかを理解しています。Anthropic Interviewerを使用して、科学者のAIに関する視点とプログラムへの期待を収集しています(また、プライバシー保護分析ツールを使用して、彼らのClaude会話がこれらの期待と一致しているかどうかを評価します)。定量的および定性的なデータを組み合わせることで、科学者向けにClaudeを改善し、助成金の影響を測定するのに役立ちます。

- 教師: 最近、American Federation of Teachers(AFT)とパートナーシップを結び、より一層利用可能なAIの時代に教師トレーニングを再構築しています。このプログラムは、400,000人の教師をAI教育で支援し、AIシステムの開発に彼らの視点を導入することを目指しています。

Anthropic Interviewerを使用することで、特定の政策に情報を提供する targeted research、AIに関する会話にさまざまなコミュニティを関与させる participatory research、および人間とAIの進化する関係を追跡する定期的な研究を実施できます。

Conclusions and limitations(結論と制限事項)

1,250人の専門職へのインタビューは、AIとの関係を積極的に交渉している労働力を明らかにしました。参加者は一般的に、専門的アイデンティティの中心となるタスクを保持しながら、生産性向上のために日常的な作業を委任していました。クリエイターは、同業者のスティグマや経済的不安にもかかわらずAIの効率性を受け入れ、一方で科学者は、どの研究タスクをAIに委ねるかについて選択的でした。

Anthropicは、チャットウィンドウ内で起こることを超えて、AIが人々の生活に与える影響を理解するためにこの研究を実施しました。すべての定性的分析と同様に、これらのインタビューの解釈は、研究者が尋ねることを選択した質問と、データで探したパターンを反映しています。このような大規模なインタビュートランスクリプトのデータセットを公に利用可能にすることで、人間とAIの関係がどのように進化しているかについての集団的理解を進めることを望んでいます。そして、Anthropic Interviewerを規模で展開することで、人々がAIで経験することとそれをどのように開発するかの間にフィードバックループを作成できます。目標は、公的な視点とニーズを反映するAIシステムを構築することです。

Limitations(制限事項)

Anthropic Interviewerの初期使用には、発見の範囲と一般化可能性に影響する重要な制限事項がいくつかあります:

- Selection bias(選択バイアス): クラウドワーカープラットフォームを通じて関与したため、調査参加者の経験は一般労働力とは大きく異なる可能性があり、対象に関するより肯定的または経験豊富な視点に応答がバイアスされている可能性があります。

- Demand characteristics(需要特性): 参加者は、AI使用に関してAIシステムによってインタビューされていることを知っていたため、人間とのインタビューと比較して、関与する意欲や与える応答の種類が変わった可能性があります。

- Static analysis(静的分析): 専門職の現在のAI使用と態度のスナップショットを捉えましたが、これらのデータでは、これらの関係が時間とともにどのように発展するか、または初期の熱意が長期使用でどのように変化するかを追跡することはできません。

- Emotional analysis(感情分析): Anthropic Interviewerはテキストのみであり、声のトーン、表情、ボディランゲージを読むことができないため、インタビュー対象者の発言の意味に影響する感情的な手がかりを見逃す可能性があります。

- Self-report versus objective measures(自己申告 vs 客観的測定): 参加者のAI使用の説明は、実際の実践とは異なる可能性があることを上記で指摘しました(スマートフォン使用についても同様のことが分かっています)。これは、社会的望ましさバイアス、不完全な記憶、または職場でのAI開示に関する進化する規範によるものである可能性があります。実際、インタビューデータは、実際の使用データと比較したときに重要な不一致を明らかにしました。この認識と実践の間のギャップは、自己申告の固有の曖昧さを強調しています。例えば、インタビュー応答は願望的な使用や社会的望ましさ効果を捉えている可能性があります。これらの不一致を理解することは、この種の研究における発見を解釈する上で重要です。

- Researcher interpretation(研究者の解釈): すべての定性研究と同様に、分析は研究者自身の関心と視点を反映しています。体系的な方法を使用してパターンを特定しましたが、異なる研究者はこれらのインタビューの異なる側面を強調したり、別の結論を導き出したりする可能性があります。

- Global generalizability(グローバルな一般化可能性): サンプルは主に西洋ベースの労働者を反映しており、AIに対する文化的態度、職場のダイナミクス、専門的アイデンティティはグローバルな文脈全体で大きく異なる可能性があります。

- Non-experimental research(非実験的研究): 多くの参加者が生産性の向上と品質の改善を報告しましたが、AI使用がこれらの結果を直接引き起こしたかどうか、または他の要因がどの程度貢献したかを判断することはできません。

まとめ

Anthropic Interviewerは、AIを活用して大規模なインタビュー調査を実施する新しい手法を提示しました。1,250人の専門職へのインタビューから、労働者がAIとの関係を積極的に構築している様子が明らかになりました。一般労働者は生産性向上を実感しつつも、職場での社会的スティグマや将来への不安を抱えており、クリエイターは効率性を享受しながらも経済的代替への懸念を持ち、科学者は現時点ではAIを中核的研究には使用していないものの、将来的な可能性には期待を寄せています。このツールは、従来の手法では困難だった規模でのインタビュー調査を可能にし、AI開発に人々の声を反映させる新たな道を開くものと考えられます。