はじめに

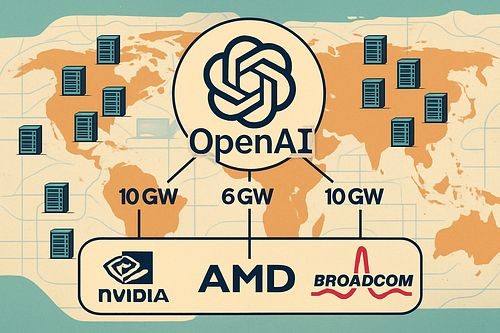

OpenAIが2025年10月13日、半導体大手のBroadcomと戦略的パートナーシップを締結し、10ギガワット規模のカスタムAIアクセラレータを共同開発すると発表しました。これは、先日報じられたAMDとの6ギガワット規模の提携に続くものです。本稿では、この発表内容をもとに、OpenAIが独自チップ開発に踏み切る背景と、一連のパートナーシップが持つ意味について解説します。

参考記事

- タイトル: OpenAI and Broadcom announce strategic collaboration to deploy 10 gigawatts of OpenAI-designed AI accelerators

- 発行元: OpenAI

- 発行日: 2025年10月13日

- URL: https://openai.com/index/openai-and-broadcom-announce-strategic-collaboration/

要点

- OpenAIとBroadcomが10ギガワット規模のカスタムAIアクセラレータを共同開発する戦略的提携を発表した

- OpenAIがチップとシステムを設計し、Broadcomが開発・展開を担当する形で、2026年後半から展開を開始し2029年末までに完了予定である

- システムはBroadcomのEthernetソリューションを使用したスケールアップ・スケールアウトを実現し、OpenAIの施設およびパートナーデータセンターに展開される

- これはNVIDIAからの10ギガワット、AMDからの6ギガワットに加えた供給確保であり、OpenAIの計算インフラ多様化戦略の一環である

詳細解説

10ギガワットという規模感と全体像

公式発表によれば、今回の提携で展開されるカスタムAIアクセラレータの規模は10ギガワットとされています。これは一般的なデータセンターの電力消費量をはるかに超える規模です。OpenAIのCEOであるSam Altman氏は「Broadcomとの提携は、AIの可能性を解き放ち、人々やビジネスに真の利益をもたらすために必要なインフラを構築するための重要なステップ」だと述べています。

発表では、展開は2026年後半に開始され、2029年末までに完了する予定とされています。OpenAIの施設だけでなく、パートナーデータセンターにも展開される計画です。

ここで注目すべきは、OpenAIがこれまでに発表してきた半導体調達の全体像です。先日の報道では、OpenAIはNVIDIAから10ギガワット規模の供給を受けているほか、2025年10月6日にはAMDと6ギガワット規模のパートナーシップを締結したことが明らかになっています。今回のBroadcomとの10ギガワットを合わせると、合計で26ギガワットという膨大な規模になります。

なぜOpenAIは独自チップを開発するのか

公式発表では、OpenAI共同創業者でありCEOのSam Altman氏が「独自のアクセラレータを開発することで、AIの能力を推進するために必要な能力を構築するパートナーのより広いエコシステムに貢献する」と説明しています。また、OpenAI共同創業者でありプレジデントのGreg Brockman氏は「独自のチップを構築することで、フロンティアモデルや製品の開発から学んだことをハードウェアに直接組み込むことができ、新たなレベルの能力と知性を解き放つことができる」と述べています。

つまり、モデル開発で得た知見をハードウェア設計に反映させることで、ソフトウェアとハードウェアの最適化を図るという狙いがあるようです。

ただし、背景にはNVIDIAへの依存度を下げるという戦略的意図もあると考えられます。現在、AI向けGPU市場ではNVIDIAが8割以上のシェアを占める一強体制にあり、供給不足や価格高騰のリスクが指摘されています。AMDとの提携に続き、今回Broadcomとの協業で独自チップ開発に踏み切ることで、OpenAIは計算インフラのサプライチェーンを多様化し、特定企業への依存リスクを低減しようとしていると見られます。

Broadcomの役割とEthernet技術の採用

発表によれば、OpenAIがアクセラレータとシステムを設計し、Broadcomが開発と展開を担当する分業体制になります。システムには、Broadcomのスケールアップおよびスケールアウト向けのアクセラレータとEthernetソリューションが組み込まれます。

BroadcomのPresident兼CEOであるHock Tan氏は「OpenAIとのコラボレーションは、汎用人工知能の追求における極めて重要な瞬間を意味する」と述べています。また、Broadcom Semiconductor Solutions GroupのPresidentであるCharlie Kawwas博士は「カスタムアクセラレータは、標準ベースのEthernetスケールアップおよびスケールアウトネットワーキングソリューションと非常によく組み合わせることができ、コストとパフォーマンスを最適化した次世代AIインフラを提供する」と説明しています。

発表では、ラックにはBroadcomのEthernet、PCIe、光接続ソリューションのエンドツーエンドポートフォリオが含まれるとされています。

OpenAIの現状と今後の展望

公式発表によれば、OpenAIは週間アクティブユーザー数が8億人を超え、グローバル企業、中小企業、開発者の間で強い採用が進んでいます。今回の提携は、AGI(汎用人工知能)の恩恵を全人類に届けるというOpenAIのミッションを前進させるためのものだとされています。

発表では、OpenAIとBroadcomは長年にわたるAIアクセラレータの共同開発と供給に関する合意を持っており、両社はAIアクセラレータとBroadcomネットワーキングソリューションを組み込んだラックの展開に関するタームシートに署名したとのことです。

※見解:巨額投資の裏にある構造的な課題

この発表から3つの点が気になりました。

1つ目は、AIインフラへの投資規模の大きさです。NVIDIA(10ギガワット)、AMD(6ギガワット)、Broadcom(10ギガワット)を合わせた26ギガワットという数字は、単なる計算能力の強化というよりも、AI開発において計算資源が今後の最大の制約条件になっていると想定していることを示しているのではないでしょうか。OpenAIのような企業がこれほどの規模のインフラを確保しなければならないと考えている状況は、AI技術の「民主化」という理念と、実際のコスト面でのハードルの高さとの間にあるギャップを浮き彫りにしているように感じます。

2つ目は、複雑化する企業間関係です。先日、Barron’sがAI業界における「循環融資」の問題を報じました。NVIDIAがOpenAIに1000億ドルを投資する一方でOpenAIがNVIDIAの顧客でもあるという関係や、MicrosoftのOpenAIへの130億ドルの投資など、主要AI企業間で資金が循環している実態が指摘されています。今回のBroadcomとの提携では、AMDとの提携時のようなワラント(新株予約権)取得といった資本関係は発表されていませんが、OpenAI自身がチップを設計しBroadcomが製造するという形態は、従来の単純な買い手と売り手の関係を超えた深い協業関係です。こうした複雑な企業間関係が増えることで、AI市場における真の需要を評価することがますます難しくなるのではないかという懸念があります。

3つ目は、ハードウェアとソフトウェアの垂直統合が進んでいる点です。Greg Brockman氏が述べている「フロンティアモデルや製品の開発から学んだことをハードウェアに直接組み込む」というアプローチは、Appleなどが成功させてきた戦略と似ています。技術的には理にかなったアプローチですが、こうした垂直統合が進むことで、特定のプラットフォームへの依存度が高まり、選択肢が狭まる可能性も懸念されます。

とはいえ、OpenAIが「パートナーのより広いエコシステムに貢献する」と述べている点は注目に値します。独自開発を進めつつも、より広範なパートナーシップを通じてAIインフラ全体の底上げを目指しているのであれば、業界全体にとってプラスの影響があるかもしれません。今後の展開を注視していきたいところです。

まとめ

OpenAIとBroadcomが10ギガワット規模の独自AIアクセラレータを共同開発するという今回の発表は、NVIDIAやAMDとの提携と合わせて、OpenAIが合計26ギガワット規模という膨大な計算インフラを確保しようとしていることを示すものでした。2026年後半から展開が始まる予定で、OpenAIのミッション実現に向けた大きな一歩となるでしょう。ただ、この規模の投資が必要だという事実は、AI技術の普及に向けた課題も浮き彫りにしているのではないでしょうか。