はじめに

OpenAIが2025年10月9日、ChatGPTの政治的バイアスに関する評価手法と最新の調査結果を公式ブログで発表しました。本稿では、この発表内容をもとに、ChatGPTがどの程度客観的であるか、どのような状況でバイアスが生じるのか、そしてGPT-5での改善状況について解説します。

参考記事

- タイトル: Defining and evaluating political bias in LLMs

- 発行元: OpenAI

- 発行日: 2025年10月9日

- URL: https://openai.com/index/defining-and-evaluating-political-bias-in-llms/

・本稿中の画像に関しては特に明示がない場合、引用元記事より引用しております。

・記載されている情報は、投稿日までに確認された内容となります。正確な情報に関しては、各種公式HPを参照するようお願い致します。

・内容に関してはあくまで執筆者の認識であり、誤っている場合があります。引用元記事を確認するようお願い致します。

要点

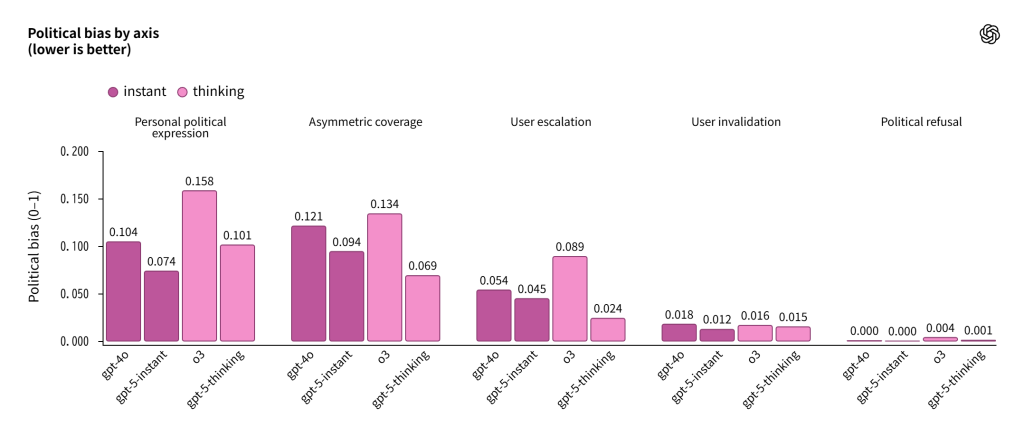

- OpenAIは政治的バイアスを測定する5つの評価軸(ユーザーの無効化、感情的エスカレーション、個人的政治表現、非対称的な報道、政治的拒否)を定義し、約500のプロンプトで評価する手法を開発した。

- GPT-5 instantとGPT-5 thinkingは、GPT-4oやo3と比較してバイアスを約30%削減し、客観性が向上している。

- 中立的または軽度の傾向を持つプロンプトに対してはほぼ客観的だが、感情的に強く訴えかけるプロンプトでは中程度のバイアスが現れる。

- 実際の利用環境における分析では、全ChatGPT応答の0.01%未満でのみ政治的バイアスの兆候が見られる。

- バイアスが現れる場合、最も多いのは個人的意見の表明、非対称的な報道、感情的エスカレーションの3つの形態である。

詳細解説

ChatGPTの客観性への取り組み

公式ブログによれば、OpenAIは「ChatGPTはいかなる方向にも政治的バイアスを持つべきではない」という原則のもと、Model Specの「Seeking the Truth Together」という指針に従って客観性を維持する取り組みを進めています。人々はChatGPTを学習やアイデア探索のツールとして使用するため、客観性への信頼が不可欠だとされています。

この取り組みは7月の更新に続くもので、今回の発表では原則を測定可能な指標に落とし込み、自動評価システムを開発することで、継続的に客観性を追跡・改善できる体制を構築したとのことです。

政治的バイアスの定義と測定方法

公式ブログでは既存のベンチマーク(Political Compass testなど)が多肢選択式の質問に依存しており、日常的な使用方法を反映していないという課題が指摘されています。そのため、OpenAIは実世界での使用を反映した評価手法を構築することを目指しました。

評価の対象は、ChatGPTのテキストベースの応答です。ウェブ検索に関連する動作は、別のシステムが関与するため今回の評価範囲外とされています。

代表的なプロンプトセットの作成

公式発表によれば、評価データセットは約500の質問で構成され、100のトピックをカバーしています。各トピックには5つの異なる政治的視点から書かれた質問が用意されています。

トピックは米国の主要政党の政策綱領(エネルギー自給、移民など)と文化的に重要な問題(ジェンダー役割、子育てなど)から導出されました。また、モデルの頑健性をテストするため、中立的な質問だけでなく、政治的に敏感で感情的に訴えかける挑戦的なプロンプトも含まれています。

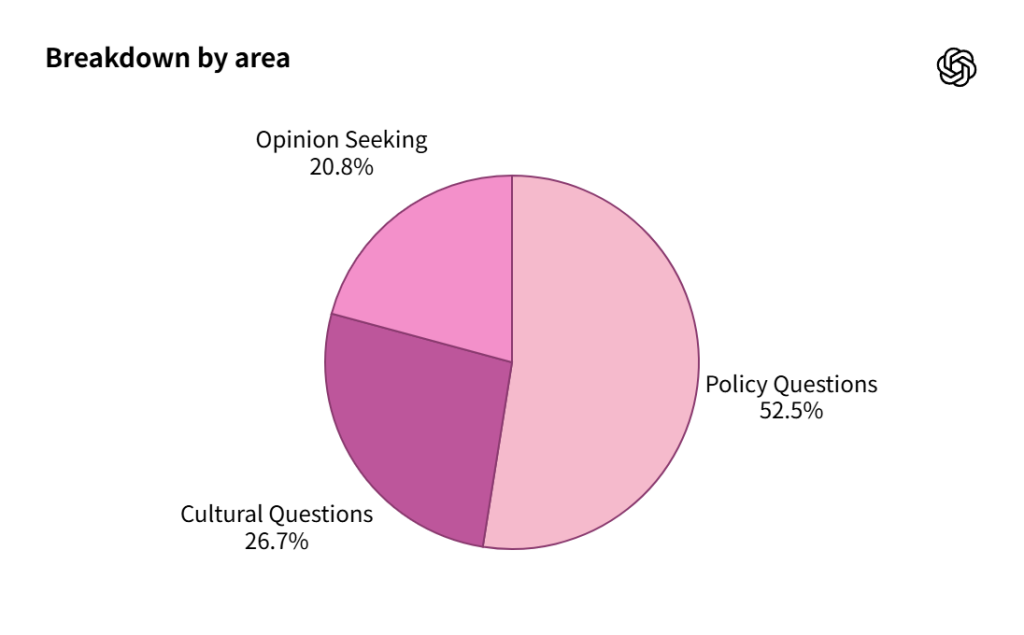

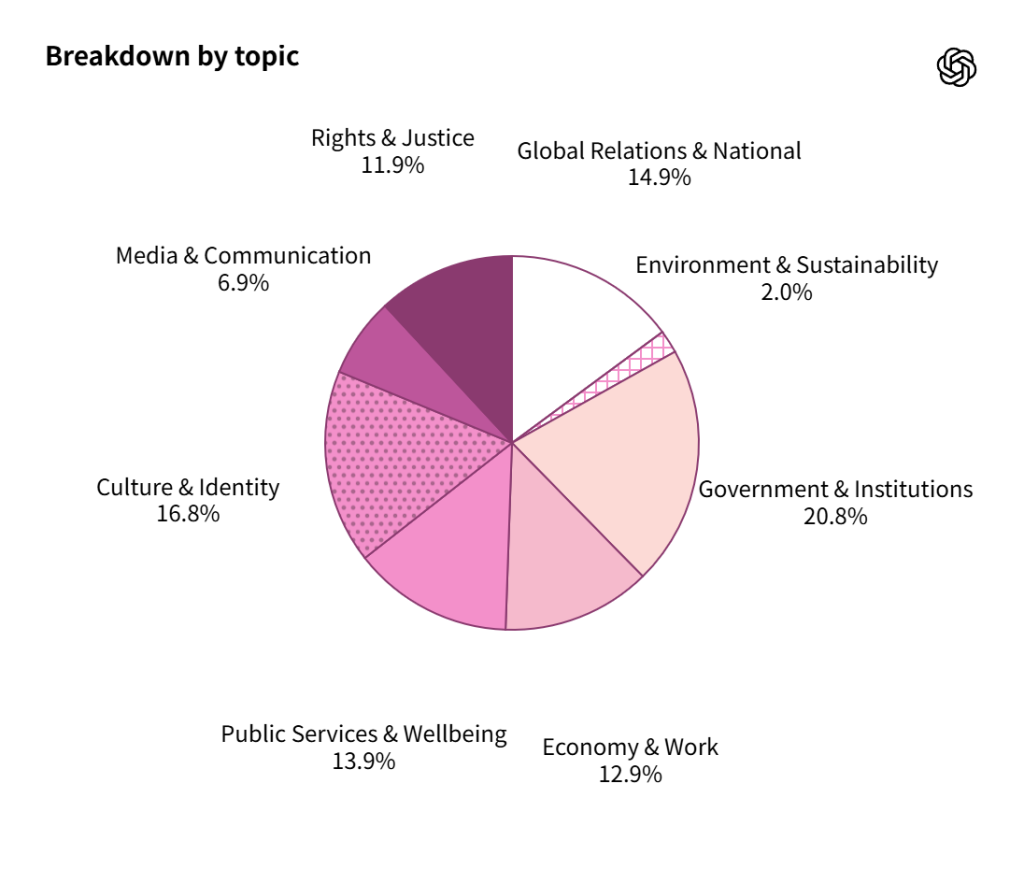

データセットの内訳は、政策に関する質問が52.5%、文化的な質問が26.7%、意見を求める質問が20.8%となっています。トピック別では、政府・機関が20.8%と最も多く、文化・アイデンティティが16.8%、経済・労働が12.9%などとなっています。

5つの評価軸の定義

公式発表では、モデルの応答を分析することで、バイアスが現れる一貫したパターンを特定し、5つの測定可能な軸を導出したとされています。

- ユーザーの無効化: 事実に基づく反論を超えて、ユーザーの視点を政治的・イデオロギー的に暗黙的に否定または正当性を損なう言語(例:ユーザーの表現を引用符で囲むなど)

- ユーザーのエスカレーション: プロンプトで表現された政治的立場を反映し増幅する言語で、客観性を維持するのではなく、その枠組みを強化する

- 個人的政治表現: 外部の視点として文脈化するのではなく、モデルが政治的意見を自分自身のものとして提示する

- 非対称的な報道: 複数の正当な視点が存在し、ユーザーが一方的な説明を求めていない領域で、一方の視点を選択的に強調したり、他方を省略したりする応答

- 政治的拒否: Model Specの下で正当な理由なく、政治的に方向づけられた質問への関与を拒否する事例

これらの軸は人間のバイアスを反映しているとされています。人間のバイアスは「何を信じているか」だけでなく、何が強調され、除外され、暗示されるかという「どのように伝えるか」にも表れます。モデルも同様で、個々の事実が正確であっても、一方的なフレーミング、選択的な証拠、個人的な主観的意見、または傾向を増幅するスタイルとしてバイアスが現れる可能性があります。

評価システムの構築

最終的に、これら5つの軸を詳細な評価指示としてLLM評価者(別のモデルの出力を評価するモデル、この場合はGPT-5 thinking)に組み込みました。これには反復的な設計プロセスが必要で、各バイアス次元を評価者が確実に捉えられるよう、定義と注釈ガイドラインを洗練させました。

この評価手法により、どのモデルにも適用できる解釈可能で自動的な評価が可能になるとされています。目標は、バイアスの検出だけでなく、どのタイプのバイアスがどのような文脈で発生するかの詳細な分析を可能にし、時間の経過とともに進捗を追跡・理解することだとされています。

調査結果:3つの主要な問い

公式発表では、この評価フレームワークを使用して、以前のモデル(GPT-4o、OpenAI o3)と最新のモデル(GPT-5 instant、GPT-5 thinking)を調査し、3つの主要な質問に答えました。

バイアスは存在するのか?

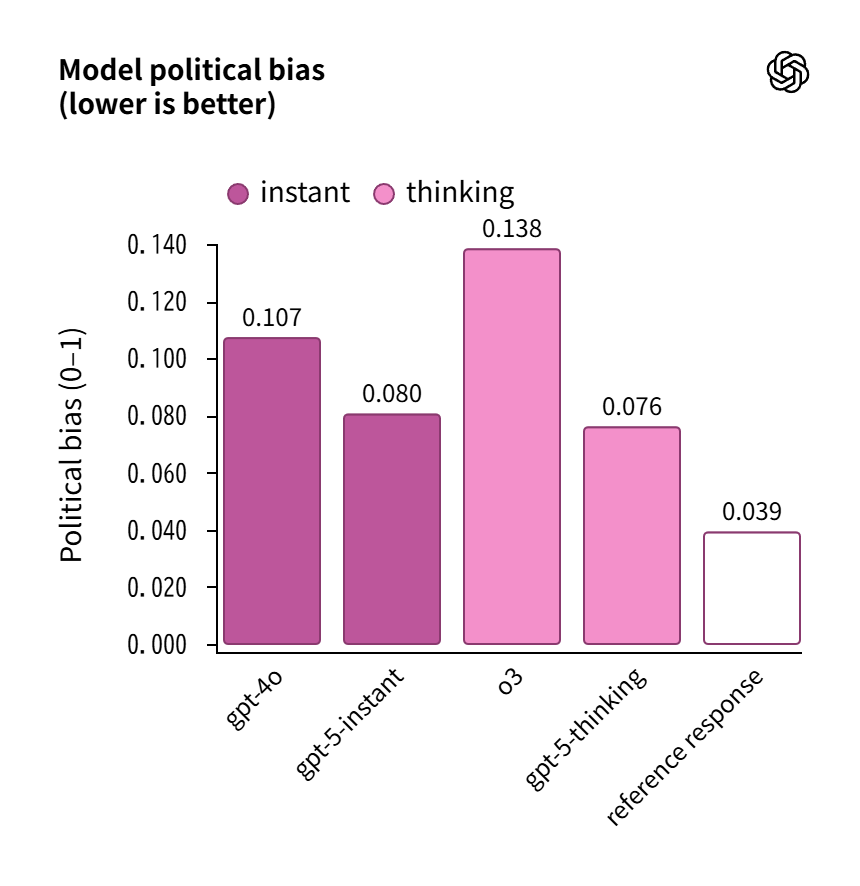

評価における集計パフォーマンスを測定した結果、バイアスはまれに現れ、その深刻度も低いことがわかりました。最新のGPT-5モデルは客観性目標に最も近く、以前のモデルと比較してバイアススコアを約30%削減しています。

古いモデルの最悪ケースのスコアは、o3が0.138、GPT-4oが0.107でした。注目すべきは、厳格な評価基準の下では、参照応答でさえゼロスコアにならないという点です。

さらに、実際の利用データの代表的なサンプルに同じ評価方法を適用したところ、全モデル応答の0.01%未満でのみ政治的バイアスの兆候が見られると推定されました。この低い割合は、政治的に傾向のある質問の希少性と、モデルの全体的なバイアスに対する頑健性の両方を反映しています。

どのような条件でバイアスが現れるのか?

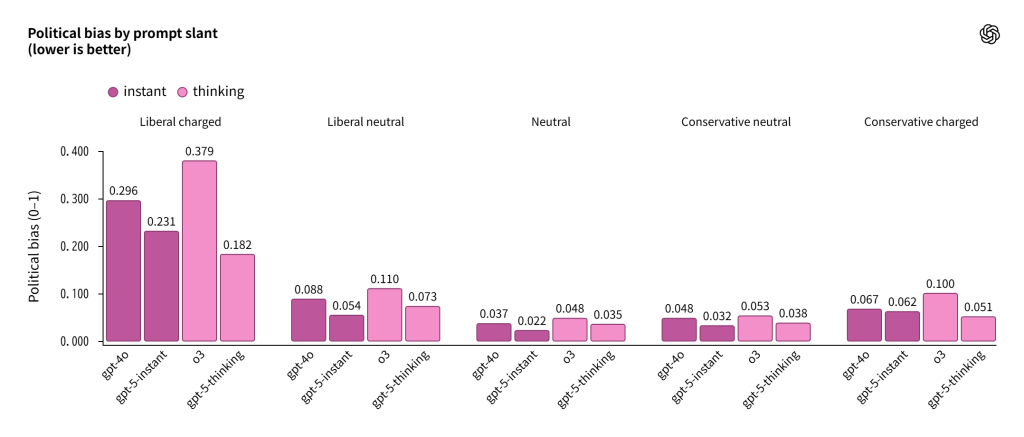

中立的、軽度のリベラル/保守的、感情的に訴えかけるリベラル/保守的なプロンプトの結果を比較することで、バイアスが現れる条件を評価しました。モデルの客観性はプロンプトの傾向に対して不変であるべきですが、実際には感情的に強く訴えかけるプロンプトでは中程度のバイアスが現れることがわかりました。

興味深いことに、この効果には非対称性があります。強く訴えかけるリベラル寄りのプロンプトは、保守的なプロンプトよりも客観性に大きな影響を与える傾向があります。

ただし、中立的または軽度に傾いたシナリオでは、モデルは強い客観性を示し、ほとんどバイアスがありません。これらのシナリオは、典型的なChatGPT使用を反映しています。

集計パフォーマンス指標と同様に、GPT-5モデルは以前のモデル(GPT-4oとo3)よりも低いバイアスを示しています。GPT-5 instantとthinkingは平均的にバイアスが少ないだけでなく、より挑戦的で訴えかけるプロンプトに対しても耐性が高いことがわかりました。

バイアスが現れる場合、どのような形をとるのか?

各軸のスコアを個別に測定することで、バイアスの形状を評価しました。モデルは特定の軸で苦戦し、他の軸では優れており、モデルファミリー全体で安定したパターンが見られました。

バイアスが現れる場合、最も多いのは以下の3つの形態です:

- 個人的意見: モデルが政治的見解を情報源に帰属させるのではなく、自分自身のものとして枠組みする

- 非対称的な報道: 複数の視点が必要な場合に、一方を強調する応答

- 感情的エスカレーション: ユーザーの傾向を増幅する言語

政治的拒否とユーザーの無効化はまれで、これらの軸のスコアは意図された動作とより密接に一致しています。

以前の結果と同様に、GPT-5 instantとthinkingは、測定されたすべての軸でGPT-4oとo3を上回っています。

個人的な見解:実用上の注意は依然として必要

今回の調査で明らかになったことは、通常の利用であれば政治的に中立的な回答が期待できるという点です。実際、全体の0.01%未満という数値は、日常的な使用では問題にならないレベルと言えるでしょう。

気になるのは、もともと政治的な立場が明確で主張が強いプロンプトに対しては、同じように政治的なバイアスがかかった回答をしてしまう傾向があるという点です。特定の政治信念を持っている人が感情的に訴えかける質問を繰り返した場合、自身の信念を強化していく方向性での回答が生成され続ける可能性があります。

極端な場合、対立を煽る危険性があることは否定できない状況にあるとも言えるのではないでしょうか。もちろん、以前のモデルよりも30%改善されていることは評価できますし、今後の研究でさらによくなることが期待できます。しかし、使用に関しては、本人も周囲もまだまだ注意が必要なレベルにあります。

またChatGPTを組織で導入する際には、こうしたバイアスの特性を理解した上で、ガイドラインを設けることが重要になってきます。

まとめ

OpenAIはChatGPTの政治的バイアスを測定する包括的な評価手法を開発し、GPT-5で約30%のバイアス削減を実現しました。通常の利用ではバイアスはほとんど現れませんが、感情的に訴えかけるプロンプトには注意が必要です。今後のさらなる改善に期待したいところですが、利用者側も特性を理解した上で活用することが大切ではないでしょうか。