はじめに

本稿では、ロイターが2025年6月28日に報じた「OpenAI turns to Google’s AI chips to power its products, source says」という記事を基に、生成AI「ChatGPT」を開発したことで知られるOpenAIが、長年のパートナーであるNVIDIAに加えて、競合であるGoogleのAI専用チップの利用を開始したこと、この提携がなぜ重要なのか、その背景にある技術的なポイントや各社の思惑を解説します。

引用元記事

- タイトル: OpenAI turns to Google’s AI chips to power its products, source says

- 発行元: Reuters (ロイター)

- 発行日: 2025年6月28日

- URL: https://www.reuters.com/business/openai-turns-googles-ai-chips-power-its-products-information-reports-2025-06-27/

要点

- OpenAIは、ChatGPTなどのサービスを動かすため、Googleが開発したAI専用チップ「TPU」の利用を開始した。

- これは、これまでAI開発の標準とされてきたNVIDIA製「GPU」への依存から脱却し、供給源を多様化する動きである。

- 最大の目的は、AIがユーザーの質問に答える際にかかる「推論(inference)」の運用コストを削減することにある。

- この提携は、OpenAIが技術的な支援を受けてきたMicrosoftのデータセンターへの依存度を下げ、より自立的なインフラ戦略を進めていることを示唆する。

- AI開発において熾烈な競争を繰り広げるOpenAIとGoogleというライバル同士の協力は、業界の力学に大きな影響を与える可能性を秘めた重要な出来事である。

詳細解説

競合から協力へ:OpenAIとGoogleの驚くべき提携

今回のニュースの核心は、AI業界のトップを走る2社、OpenAIとGoogleがハードウェアの領域で手を組んだという点にあります。これまでOpenAIは、主にNVIDIA社製のGPU(Graphics Processing Unit)という半導体チップを大量に購入し、それを支援者であるMicrosoftのクラウドサービス「Azure」上で動かすことで、ChatGPTなどの高度なAIモデルを開発・運用してきました。

しかし、今回新たにGoogleが自社開発するTPU(Tensor Processing Unit)というAI専用チップを、Googleのクラウドサービスを通じてレンタルし始めたのです。AIモデルの開発でしのぎを削るライバル同士が協力するという、まさに「驚くべきコラボレーション」が実現したことになります。

AIを動かす心臓部:「GPU」と「TPU」は何が違うのか?

このニュースを理解するためには、AIを動かす半導体チップの違いを知ることが重要です。

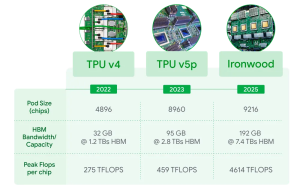

- GPU (Graphics Processing Unit / NVIDIA製など)

元々は、コンピューターゲームなどの高精細な映像を処理するために作られた半導体です。その構造が、単純な計算を同時に、かつ大量に行う「並列計算」に非常に長けていました。この特性が、AI、特にディープラーニング(深層学習)で必要とされる膨大な計算処理と非常に相性が良かったため、AI開発の標準的なチップとして不動の地位を築いています。いわば「万能型のアスリート」のような存在です。 - TPU (Tensor Processing Unit / Google製)

こちらは、GoogleがAIの計算処理(特に自社のAIフレームワークであるTensorFlow)を効率的に行うためだけに開発したAI専用のチップ(ASIC)です。ディープラーニングの計算に特化しているため、特定の処理においては、GPUよりも高速で、かつ消費電力を抑えて実行できる場合があります。こちらは「特定種目に特化したスペシャリスト」と言えるでしょう。

「学習」と「推論」:AI運用のコスト構造

AIの運用には、大きく分けて2つのフェーズがあります。今回のOpenAIの動きは、特に後者のコストを意識したものです。

- 学習(Training)

AIモデルに膨大な量のテキストや画像データを読み込ませ、「知識」や「パターン」を学ばせる段階です。モデルを賢くするための基礎工事であり、莫大な計算能力と時間を必要とします。 - 推論(Inference)

学習済みのモデルが、ユーザーからの質問や指示といった新しい情報に対して、実際に回答を生成したり、判断を下したりする段階です。私たちがChatGPTと対話する際、裏側ではこの「推論」が絶えず行われています。一度の計算負荷は学習より小さいものの、世界中の数え切れないユーザーが利用するため、合計すると膨大な運用コストが発生します。

記事によると、OpenAIがGoogleのTPUを導入した主な目的は、この「推論」のコストを削減することにあるとされています。

なぜ今、Googleのチップなのか?OpenAIの3つの狙い

OpenAIがライバルであるGoogleのチップをあえて採用した背景には、いくつかの戦略的な狙いが見えてきます。

- 徹底したコスト削減

前述の通り、最大の目的は「推論コスト」の削減です。ChatGPTのようなサービスを安定的に提供し、収益性を高めるためには、運用コストの効率化が至上命題です。特定の処理に特化したTPUを利用することで、NVIDIAのGPUを使い続けるよりもコストパフォーマンスを高められるという判断があったと考えられます。 - 供給源の多様化(脱NVIDIA依存)

現在、高性能なAI用GPU市場はNVIDIAの独占状態にあり、世界中の企業がそのチップを奪い合っている状況です。これにより、GPUは非常に高価で、入手が困難になることもあります。単一の供給源に依存することは、ビジネス上の大きなリスクとなります。そこでGoogleのTPUという新たな選択肢を加えることで、より安定的かつ柔軟にコンピューティング資源を確保する狙いがあります。 - インフラの自立性確保(脱Microsoft依存)

OpenAIは創業以来、Microsoftから巨額の出資とインフラ提供を受けてきました。この強力なパートナーシップは今後も続くと考えられますが、企業として成長する上で、特定のプラットフォームに縛られすぎないことも重要です。今回、Google Cloudのサービスを利用することで、自社のニーズに合わせて最適な技術を自由に選択できるという柔軟性を高め、より自立したインフラ戦略へ舵を切ったと見ることができます。

まとめ

本稿では、OpenAIがGoogle製のAIチップ「TPU」の利用を開始したというニュースについて、その背景と意味を解説しました。

この動きは、単に「使うチップの種類を増やした」という単純な話ではありません。これは、①コスト効率の追求、②供給網リスクの分散、③技術的な独立性の確保という、OpenAIの明確な経営戦略の表れです。

AI業界の王者であるNVIDIAの牙城に、GoogleのTPUがどこまで食い込めるのか。そして、ライバルでありながらも実利のために手を組んだOpenAIとGoogleの関係は、今後のAI開発競争の力学をどう変えていくのか。この提携は、AI業界の未来を占う上で、非常に重要な一歩となるでしょう。