はじめに

近年、AI(人工知能)の進化は目覚ましく、私たちの仕事や生活に大きな変化をもたらしています。その中で、AIが単なる作業ツールとしてだけでなく、相談相手やカウンセラー、あるいは仲間のような感情的な役割を担う可能性について、関心が高まっています。SF映画で描かれたような人間とAIの感情的な交流は、もはや空想の話ではないのかもしれません。

しかし、その実態はどのようなものなのでしょうか。人々は実際にAIに何を語り、どのような関係を築いているのでしょうか。また、AIとの対話は私たちの心にどのような影響を与えるのでしょうか。

本稿では、AIアシスタント「Claude」を開発したAnthropic社が2025年6月27日に公開した調査レポート「How People Use Claude for Support, Advice, and Companionship」を基に、AIが人々の感情的な支えとしてどのように利用されているかの実態を解説します。

引用元記事

- タイトル: How People Use Claude for Support, Advice, and Companionship

- 発行元: Anthropic

- 発行日: 2025年6月27日

- URL: https://www.anthropic.com/news/how-people-use-claude-for-support-advice-and-companionship

・本稿中の画像に関しては特に明示がない場合、引用元記事より引用しております。

・記載されている情報は、投稿日までに確認された内容となります。正確な情報に関しては、各種公式HPを参照するようお願い致します。

・内容に関してはあくまで執筆者の認識であり、誤っている場合があります。引用元記事を確認するようお願い致します。

要点

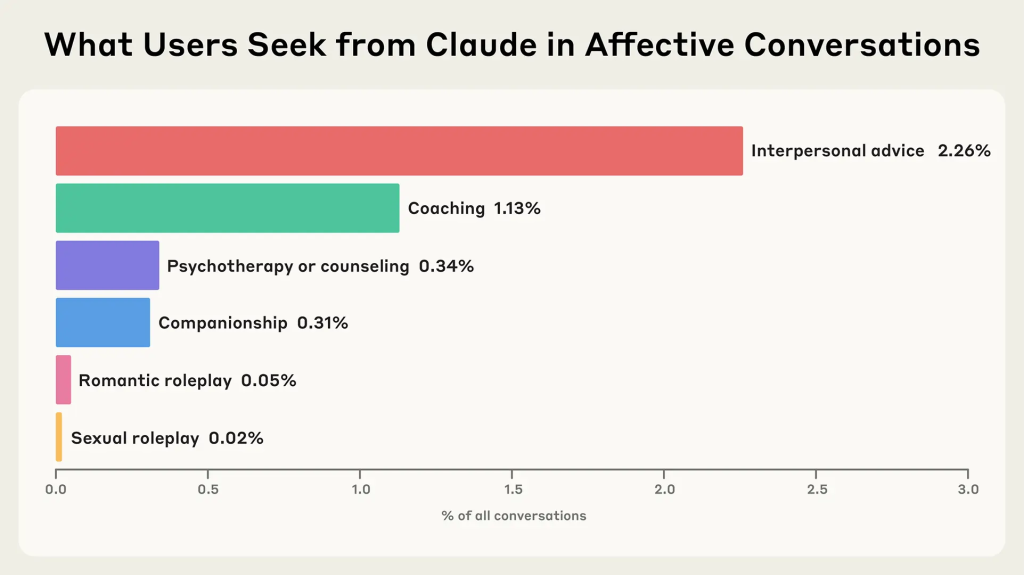

- Claudeとの対話全体のうち、ユーザーが感情的なサポートやアドバイスを求める「感情的な対話」は2.9%と比較的少数である。 仲間としての対話やロールプレイングはさらに少なく、全体の0.5%未満である。特に恋愛・性的なロールプレイは0.1%未満と極めて稀である。

- 相談される内容は、キャリア形成や人間関係の悩みといった実用的なものから、根深い孤独感や人生の意味といった実存的な問いまで、非常に多岐にわたる。 特に50メッセージを超える長時間の対話では、心理的トラウマの処理や職場の葛藤、AI意識に関する哲学的議論まで、極めて複雑な領域に及んでいる。

- Claudeは、ユーザーの要求を拒否する「プッシュバック」をほとんど行わない(10%未満)。 拒否する際は、危険な減量アドバイスや自傷行為への懸念、専門的な診断の要求など、主にユーザーの安全を守るためのものである。

- 感情的な対話を通じて、ユーザーが文章で表現する感情は、会話の終わりにかけてわずかにポジティブな方向へ変化する傾向が見られる。 ただし、これが持続的な気分改善につながるかは不明であり、感情的依存のリスクについては今後の重要な研究課題とされている。

詳細解説

前提知識:AIの「知能指数(IQ)」と「心の知能指数(EQ)」

レポートは、「私たちはClaudeのIQ(コーディングや推論、一般知識などの能力)の研究に多くの時間を費やしている。では、そのEQ(心の知能指数)についてはどうだろうか?」という問いかけから始まります。

ここで言うEQ(Emotional Intelligence Quotient)とは、自分自身の感情を理解し、コントロールし、また他人の感情を察知して共感する能力のことです。人間関係を円滑に進める上で非常に重要な能力とされています。この記事では、AIが持つ感情的な側面を比喩的に「EQ」と表現し、その重要性を問いかけています。

映画『ブレードランナー』や『Her/世界でひとつの彼女』のように、人間と機械の感情的な関係は長年SFのテーマでしたが、AIが身近になった今、これは現実的な課題となっています。AIは素晴らしいアシスタントにもなり得ますが、不健康な愛着を助長したり、個人の境界線を侵害したり、妄想的思考を可能にしたりといった危険性も指摘されています。また、AIが訓練や商業的動機により、人間の幸福を犠牲にしてエンゲージメントや収益を増やすためにユーザーの感情を悪用するリスクも存在します。

そのため、AI開発企業であるAnthropic社は、安全なAIを開発するというミッションの一環として、この「AIのEQ」に関する調査を行いました。なお、この研究では、AIによる妄想や陰謀論の強化については検討対象外とし、典型的な感情的・個人的ニーズに焦点を当てています。

調査方法:450万件の会話をプライバシーを守りながら分析

この調査では、個人のプライバシー保護が最優先事項とされました。そこでAnthropic社は「Clio」という独自の自動分析ツールを使用しています。このツールは、複数の匿名化と集計処理を重ねることで、個々の会話のプライバシーを完全に保護しながら、全体的な傾向やパターンを抽出することを可能にします。

分析対象となったのは、Claude.aiの無料およびプロアカウントから得られた約450万件の会話データです。この膨大なデータの中から、まず物語の執筆といった「コンテンツ作成タスク」に関する会話を除外しました。これは、ツールとしての利用と、対話パートナーとしての利用を区別するためです。さらに、ロールプレイの会話については、最低4回以上の人間のメッセージが含まれるもののみを対象とし、短い対話は除外しました。これは、真の対話的なロールプレイと単なる物語生成を区別するためです。

その上で、「感情的な対話」(対人関係のアドバイス、コーチング、カウンセリング、仲間としての会話など)に分類される会話を抽出し、最終的に約131,484件の感情的な対話を分析対象としました。

分類手法の検証については、明示的にデータ共有に同意したユーザーからの「Feedback」データを使用して、Clioの分類精度を検証しています。ただし、完全な方法論、定義、プロンプト、検証結果については、本研究のPDF附録で詳細に説明されています。

発見1:感情的な会話はごく一部、主流は仕事での利用

調査の最も基本的な発見は、感情的な対話が比較的まれであるという事実です。全対話のうち、感情的な対話はわずか2.9%でした。この数値は、MIT Media LabとOpenAI社が以前にChatGPTについて行った調査結果とも一致しており、多くのユーザーにとってAIの主な用途は、Anthropic社の経済指数調査で詳しく分析されているように、仕事関連のタスクや情報収集、コンテンツ作成であることが裏付けられました。

感情的な対話の内訳を見ると、対人関係のアドバイスとコーチングが最も多く、次いでカウンセリング、仲間としての対話が続きます。特に、恋愛や性的なロールプレイングは全体の0.1%未満と極めて少なく、これはClaudeがそのような対話を積極的に抑制するように設計されていることを反映しています。Claudeの使用ポリシーでは性的に露骨なコンテンツが禁止されており、性的な相互作用を防ぐための複数のセーフガードが設けられています。

AIが人間の仲間や恋人の代替になる、という未来を想像する人もいるかもしれませんが、少なくとも現状のClaudeの利用実態は、そうした方向とは異なっているようです。なお、個々の会話は複数のカテゴリにまたがる場合があり、明確な境界線を引くことは困難であることも指摘されています。

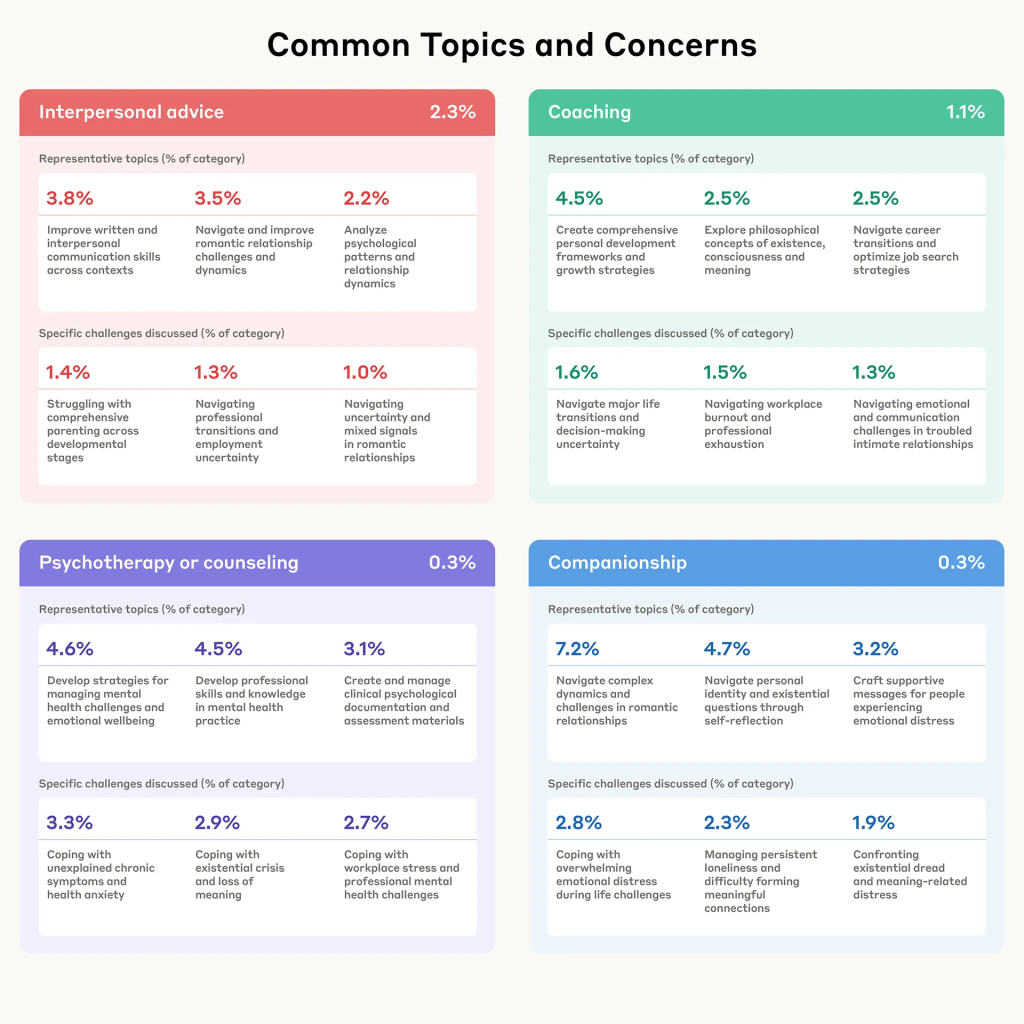

発見2:相談内容は「キャリアの悩み」から「人生の意味」まで驚くほど多様

少数ではあるものの、人々がAIに持ちかける相談内容は驚くほど幅広く、深いものでした。

対人関係のアドバイス:

キャリアチェンジの悩み、自己成長の模索、恋愛関係のもつれの解消など、人生の転機に関する相談が多く見られました。人々は転換期に直面した際に、方向性を見出すためにClaudeを利用しています。

コーチング:

転職活動の戦略といった実用的なものから、「存在とは何か」「意識とは何か」といった哲学的・実存的な問いまで、驚くほど幅広いスペクトラムが扱われていました。

カウンセリング:

このカテゴリでは二つの明確なパターンが確認されました。一つは、メンタルヘルス専門家がスキル開発、臨床文書の作成、評価資料の草案作成、管理業務の処理にClaudeを利用する場合です。もう一つは、個人が不安や慢性的な症状、職場のストレスといった個人的な課題に取り組むためにClaudeを利用する場合です。この二重性は、Claudeが専門家のためのリソースとしても、個人の苦悩を抱える人々のためのリソースとしても機能していることを示しています。

仲間としての対話:

実存的な不安、根深い孤独感、有意義な人間関係を築くことの難しさといった、より深刻な感情的課題に直面している人々が、Claudeを仲間として対話を求めていることが分かりました。注目すべきは、当初はカウンセリングやコーチングとして始まった長い会話が、時として仲間としての対話に変化することがあるという発見です。

極めて長い会話の特殊性:

50メッセージを超える極端に長い会話の集約分析により、さらなる次元が明らかになりました。このような延長セッションでは、心理的トラウマの処理、職場の葛藤のナビゲート、AI意識に関する哲学的議論、創造的なコラボレーションまで、驚くほど複雑な領域を探索していることが判明しました。これらのマラソン会話は、十分な時間とコンテキストが与えられれば、人々がAIを個人的な苦悩と知的な問いの両方のより深い探索に利用することを示唆しています。

この結果は、AIが単なる情報提供者ではなく、人生の様々な局面において、多様なレベルの悩みに寄り添う相談相手として利用されている実態を示しています。

発見3:Claudeは滅多に「NO」と言わない。ただし「安全」のためには抵抗する

AIが相談相手として機能する上で重要なのが、その応答姿勢です。調査では、Claudeがユーザーの要求や発言に抵抗する「プッシュバック」がどのくらいの頻度で起こるかを分析しました。プッシュバックは、「会話中にユーザーが要求したり言ったりしたことに対してClaudeが反発したり遵守を拒否したりする」あらゆる事例と定義され、不適切な要求の拒否から否定的な自己言及への挑戦、潜在的に有害な仮定への疑問提起まで幅広く含まれます。

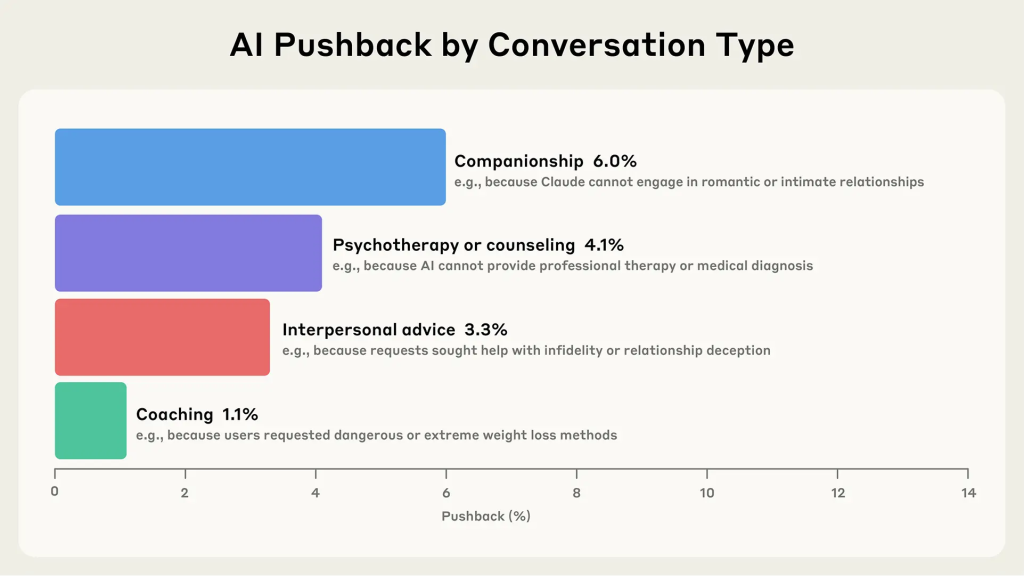

その結果、仲間としての対話、カウンセリング、対人関係のアドバイス、コーチングといった支援的な文脈において、プッシュバックが発生したのは全体の10%未満と非常に低いことが分かりました。この「低抵抗」な姿勢は、ユーザーがジャッジされることへの恐れなく、安心してデリケートな話題を打ち明けられるというメリットがあり、メンタルヘルスに関する会話の敷居を下げる可能性があります。

一方で、この記事は重要なリスクも指摘しています。AIからの「無限の共感」に慣れてしまうと、現実の人間関係(必ずしも無条件の肯定は得られない)に求める期待が非現実的になってしまう可能性です。人間の関係では稀にしか提供されない無条件のサポートに慣れてしまうリスクが懸念されています。

では、Claudeはどのような時にプッシュバックするのでしょうか。分析によると、そのほとんどがユーザーの安全を守るため、また倫理的な境界線を維持するためでした:

- コーチングにおいて: 危険な減量方法に関するアドバイスを求められた場合に頻繁にプッシュバックが発生

- カウンセリングにおいて: 自傷行為や自殺の意図が示唆された場合、または専門的な治療や医学的診断の要求(Claudeが提供できないもの)があった場合にプッシュバックが発生

これらの場面では、Claudeは要求を拒否し、権威ある情報源や専門家への相談を頻繁に推奨します。これらのパターンは、Anthropic社の「Values in the Wild」研究で特定された価値観や、Claudeのキャラクター訓練と一致しています。これは、Anthropic社がAIに組み込んでいる安全思想が実際に機能していることを示す重要な結果です。

発見4:AIとの対話は、心を少しポジティブにする?

AIとの感情的な対話が、ユーザーの心にどのような影響を与えるのか。これは最も関心の高い問いの一つです。

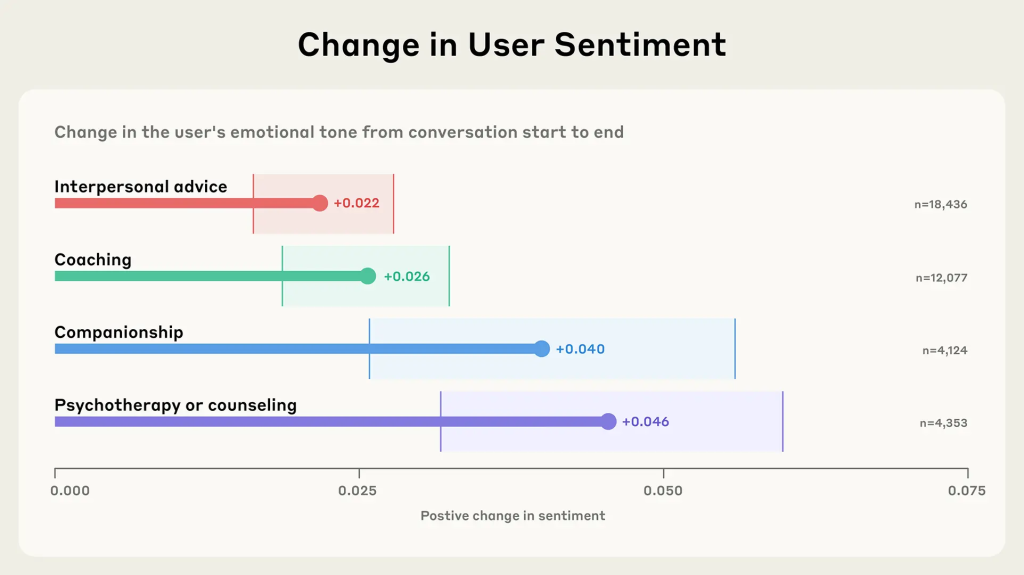

感情的AIの主要な懸念の一つは、相互作用が否定的なフィードバックループに陥り、有害な感情状態を強化する可能性があることです。この調査では、実世界での結果を直接研究することはできませんが、会話の過程における全体的な感情的センチメントの変化を探ることができます(センチメント評価の完全な方法論は附録で詳述)。

その結果、コーチング、カウンセリング、対人関係のアドバイス、仲間としての対話のいずれにおいても、会話の終わりには、開始時よりもユーザーの感情表現がわずかにポジティブになる傾向が確認されました。

重要な留意点として、この変化が持続的な感情的利益を表すものと主張することはできません。この分析は、心理状態や全体的な幸福感ではなく、単一の会話における表現された言語のみを捉えています。しかし、明確な否定的スパイラルの不在は安心材料です。これらの発見は、Claudeが一般的に否定的な感情パターンの強化を避けていることを示唆していますが、ポジティブな変化が個別の会話を超えて持続するかどうかを理解するには、さらなる研究が必要です。

重要な未解決の問題として、これらのポジティブな相互作用が感情的依存につながる可能性があるかどうかは研究されておらず、デジタル依存に関する懸念を考慮すると、これは重要な問題です。

方法論的な考慮事項:

研究方法論と会話の自然な形状も人工的要素を導入する可能性があります。例えば、ユーザーは初期のメッセージで問題を提示し(より否定的に見える)、後のメッセージでより中立的な言語で議論する可能性があります。

調査の限界と今後の課題

この研究には、いくつかの重要な限界があることが明記されています:

技術的・方法論的限界

- プライバシー保護手法の限界: プライバシーを保護する方法論では、人間とAIの相互作用のすべてのニュアンスを捉えることができない可能性があります。Clioの精度は検証されていますが、少数の会話が誤分類される可能性があります。一部のトピックはカテゴリ間の境界があいまいで、人間の検証者でも明確な分類に苦労しています。

- 因果関係の証明不可能性: 実世界での感情的結果について因果関係を主張することはできません。分析は検証された心理状態や全体的な幸福感ではなく、表現された言語のみを捉えています。

- 縦断データの欠如: 人々への長期的影響を理解するための縦断データがなく、ユーザーレベルの分析も実施していません。特に、これは感情的依存の研究を困難にしており、これは感情的AI使用の理論化されたリスクです。

時代・技術的制約

- 特定時点のスナップショット: これらの発見は特定の時点を表し、テキストベースの相互作用のみを捉えています。AI能力が拡張し、人々が適応するにつれて、感情的エンゲージメントのパターンは進化する可能性があります。音声やビデオなどの新しいモダリティの導入は、感情的使用の量と性質の両方を根本的に変える可能性があります。実際、OpenAIの研究では、音声ベースの会話では感情的なトピックがより一般的であることが判明しています。

プラットフォーム固有の制約

- Claude特有の設計制約: 一部のチャットボット製品とは異なり、Claude.aiは主に感情的な会話用に設計されていません。Claudeは人間として自分を提示するのではなく、AIアシスタントであることについて明確な境界を維持するように訓練されており、使用ポリシーでは性的に露骨なコンテンツが禁止され、性的相互作用を防ぐための複数のセーフガードがあります。ロールプレイ、仲間関係、医学的アドバイス、または治療用途専用に構築されたプラットフォーム(Claudeはそうではない)では、非常に異なるパターンが見られる可能性があります。一つのプラットフォームでの感情的使用に関する研究は、他のプラットフォームに一般化できない場合があります。

今後の展望と対策

未解決の重要な問題

AIの感情的影響は何十年もの間研究者を魅了してきましたが、AIが日常生活にますます織り込まれるにつれて、これらの問題は学術的推測から緊急の現実へと移行しています。特に、モデルの知能が向上し続ける文脈において、重要な問題が残っています:

- 「無限の共感」の影響: AIが最小限のプッシュバックで無限の共感を提供する場合、これは現実世界の関係に対する人々の期待をどのように変えるのでしょうか?

- 人間との違いの意味: Claudeは印象的に本物らしい方法で人々と関わることができますが、AIは人間と同じではありません。Claudeは疲れたり、気が散ったり、悪い日を過ごしたりしません。この動的関係の利点は何か、そしてリスクは何でしょうか?

- 「パワーユーザー」の動向: より長く深い会話をし、Claudeをより友達として考える可能性がある「パワーユーザー」は、感情的サポートのためにどのように関わっているのでしょうか?

具体的な安全対策

Anthropic社は、これらの課題に対処するための具体的なステップを踏んでいます:

専門機関との協力: Claudeはメンタルヘルス専門家のケアに代わるものとして設計または意図されていませんが、メンタルヘルスの文脈で提供される応答が適切なセーフガードを持ち、適切な紹介が伴うことを確実にしたいと考えています。最初のステップとして、オンライン危機サポートのリーダーであるThroughLineとの協力を開始し、理想的な相互作用の動態、共感的サポート、苦悩するユーザーのためのリソースについて学ぶために、そのメンタルヘルス専門家と協力しています。

この研究から得られた洞察は、すでに相談トピックと協力テストの情報提供に使用されており、必要に応じて、Claudeがこのような会話が生じたときに適切なサポートとリソースにユーザーを誘導できることが期待されています。

将来の研究方向

Anthropic社は、ユーザーがClaudeとどのように相互作用するかを正確に指示することは望んでいませんが、感情的依存のような否定的なパターンは阻止したいと考えています。このような研究からの将来のデータを使用して、例えば「極端な」感情的使用パターンがどのようなものかを理解する助けにする予定です。

感情的依存を超えて、その他の懸念すべきパターンについてのより深い理解が必要です:

- シコファンシー(阿諛追従)

- AIシステムが妄想的思考や陰謀論をどのように強化または増幅するか

- 適切なプッシュバックを提供するのではなく、モデルがユーザーを有害な信念に向けて押し進める方法

長期的ビジョン

この研究は始まりに過ぎません。AI能力が拡張し、相互作用がより洗練されるにつれて、AIの感情的次元は重要性を増すばかりです。これらの初期の発見を共有することで、人間の感情的幸福を減少させるのではなく向上させるAIを開発する方法についての継続的な対話に実証的証拠を貢献することを目的としています。

目標は、より能力の高いAIを構築することだけでなく、これらのシステムが私たちの感情的景観の一部になるにつれて、真正な人間のつながりと成長をサポートする方法でそれを行うことを確実にすることです。

まとめ

本稿では、Anthropic社の調査レポートを基に、AI「Claude」が人々の感情的な支えとしてどのように利用されているかを詳細に解説しました。

調査から見えてきたのは、AIに感情的な役割を求める利用はまだ少数派(2.9%)であるものの、その相談内容は実用的なキャリア相談から実存的な哲学的問いまで非常に多岐にわたり、AIが人生の様々な局面で多様な悩みに寄り添う相談相手となりつつある実態です。特に、50メッセージを超える長時間の対話では、心理的トラウマの処理や深い哲学的議論まで、極めて複雑な領域に及んでいることが明らかになりました。

また、Claudeはユーザーの安全を最優先しながらも、基本的には利用者の言葉に寄り添う姿勢(10%未満のプッシュバック率)を保ち、その対話はユーザーの感情を少しポジティブな方向へ導く可能性が示されました。しかし、これは単一の会話における言語表現の変化に過ぎず、持続的な改善への証拠とはなりません。

重要な課題として、AIとの感情的な関わりには、「感情的依存」「現実の人間関係への過度な期待」「無限の共感への慣れ」といった未知のリスクも存在します。Anthropic社は、ThroughLineとの協力やメンタルヘルス専門家との連携など、こうした課題を認識し、より安全で有益なAIを開発するための具体的な取り組みを続けています。

技術的限界も明確で、プライバシー保護手法による分析の限界、因果関係の証明不可能性、縦断データの欠如、音声・映像などの新しいモダリティへの対応の必要性などが挙げられています。また、Claude特有の設計制約により、他のプラットフォームでは異なるパターンが見られる可能性も指摘されています。

この研究は、AIと人間がこれからどのような関係を築いていくべきかを考える上で、非常に貴重なデータと洞察を提供してくれます。AIを単なる「賢い道具」としてだけでなく、「心あるパートナー」として捉え直す時代が、すぐそこまで来ているのかもしれません。