はじめに

本稿では、Googleが開催した開発者向けイベント「Google I/O 2025」の基調講演で発表された内容について、Google公式ブログの記事「Google I/O 2025: From research to reality」をもとに解説します。

引用元記事

- タイトル: Google I/O 2025: From research to reality

- 発行元: Google

- 発行日: 2025年5月20日

- URL: https://blog.google/technology/ai/io-2025-keynote/

要点

- AIモデルの急速な進化: Gemini 2.5 ProがLMArenaリーダーボードの全カテゴリでトップを獲得し、Eloスコアが第一世代Gemini Proから300ポイント以上向上した。これはAIの能力が飛躍的に向上していることを示す。

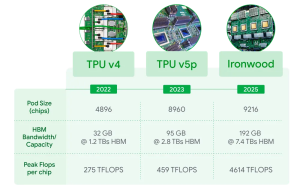

- 新世代TPU「Ironwood」の登場: AIワークロードに特化した第7世代TPU「Ironwood」は、前世代比10倍の性能向上を実現し、AIモデル開発の高速化と低コスト化を推進する。

- AIの社会実装の加速: 月間トークン処理量が9.7兆から480兆へと50倍に増加。Geminiを利用する開発者は700万人を超え、Geminiアプリの月間アクティブユーザーは4億人に達した。

- 研究から現実へ:

- Google Beam: 3Dビデオ会議技術「Project Starline」が進化し、AIを活用して2D映像をリアルな3D体験に変換する「Google Beam」として登場。HPとの協業で年内に初期顧客向けに提供開始。

- Gemini Liveの進化: AIアシスタント研究「Project Astra」のカメラ・画面共有機能がGemini Liveに統合され、Androidで利用可能、iOSにも展開開始。

- Agent Mode: コンピュータ操作を自動化する研究「Project Mariner」の機能が「Agent Mode」としてGemini API経由で開発者に提供され、Geminiアプリにも搭載予定。

- パーソナライゼーションの強化: ユーザーの許可のもと、Googleアプリ間の個人コンテキストをGeminiが活用し、よりパーソナルな体験を提供。Gmailの「パーソナライズドスマートリプライ」などが具体例である。

- Google検索のAI Mode: より複雑な質問に対応できる新しい「AI Mode」がGoogle検索に登場。米国で提供開始され、Gemini 2.5も搭載される。

- Gemini 2.5モデルの進化: 高速・低コストな「2.5 Flash」が性能向上。高性能な「2.5 Pro」には、並列思考技術などを用いた高度な推論モード「Deep Think」が導入される。

- Geminiアプリの機能拡張: Deep Research機能のパーソナライズ強化、Canvasとの連携によるインフォグラフィックやポッドキャスト生成、Gemini Liveのカメラ・画面共有機能の無料化などが行われる。

- 生成AIメディアモデルの進化: 最新動画生成モデル「Veo 3」(音声生成対応)と画像生成モデル「Imagen 4」が登場。映画制作者向けツール「Flow」も発表された。

詳細解説

Google I/O 2025では、AI技術が研究段階から私たちの実生活やビジネスシーンで活用される「現実」へと移行していることが強く示されました。ここでは、特に注目すべき発表内容を詳しく見ていきましょう。

AIモデルの目覚ましい進歩とそれを支えるインフラ

GoogleのAIモデル「Gemini」は、その能力を急速に向上させています。基調講演では、Gemini 2.5 Proが、AIモデルの性能を評価する指標の一つであるEloスコアにおいて、第一世代のGemini Proモデルから300ポイント以上もスコアを伸ばし、AIモデルの性能を競うLMArenaリーダーボードの全カテゴリでトップを獲得したことが発表されました。これは、Geminiがより賢く、より複雑なタスクをこなせるようになったことを意味します。

このAIモデルの進歩を支えているのが、Googleの強力なインフラです。第7世代のTPU(Tensor Processing Unit)「Ironwood」は、AIの「思考」や「推論」といった処理に特化して設計されており、前世代と比較して10倍のパフォーマンス向上を達成しています。1ポッドあたり42.5エクサフロップスという驚異的な計算能力を持つこの新しいTPUにより、Googleはより高性能なAIモデルをより速く、そしてより効率的な価格で提供できるようになりました。Googleは、AIモデルの性能とコスト効率のバランスを示す「パレートフロンティア」において業界をリードするだけでなく、そのフロンティア自体を大きく前進させていると述べています。

AIの普及と社会実装の現状

より高性能なAIが利用可能になるにつれて、その採用は世界中で急速に進んでいます。Googleの製品やAPI全体での月間トークン処理量は、昨年の9.7兆から480兆へと約50倍に増加しました。また、Geminiを使って開発を行う開発者の数は昨年の5倍にあたる700万人以上に、Vertex AIでのGeminiの利用は40倍に増加しています。さらに、Geminiアプリの月間アクティブユーザー数は4億人を超え、特にGemini 2.5 Proを利用しているユーザーの利用時間は45%も増加しているとのことです。これらの数字は、AIが特別なものではなく、多くの人々にとって身近なツールになりつつあることを示しています。

研究プロジェクトの成果が具体的な製品・サービスへ

Google I/Oでは、これまで研究プロジェクトとして進められてきた技術が、具体的な製品やサービスとして結実し始めている様子が紹介されました。

Google Beam:次世代3Dビデオコミュニケーション

数年前に発表された3Dビデオ会議技術「Project Starline」は、「Google Beam」として新たな段階に進みました。Google Beamは、最新のAIビデオモデルを使用し、6台のカメラアレイとAIによって2Dのビデオストリームをリアルな3D体験に変換します。ミリ単位の精度での頭部追跡を毎秒60フレームでリアルタイムに行い、まるで相手が同じ部屋にいるかのような、より自然で没入感のある会話体験を実現します。HPとの協業により、最初のGoogle Beamデバイスは今年後半に初期の顧客向けに提供が開始される予定です。

また、Google Meetにおけるリアルタイム音声翻訳機能も強化され、話者の声色やトーン、さらには表情まで再現することで、言語の壁を超えた自然なコミュニケーションの実現に近づいています。

Gemini Live:ユニバーサルAIアシスタントの片鱗

周囲の世界を理解できる汎用AIアシスタントの将来の可能性を探る研究プロジェクト「Project Astra」の成果が、「Gemini Live」に統合されました。Gemini Liveのカメラ機能や画面共有機能は、面接の準備からマラソンのトレーニングまで、様々な場面で活用され始めています。この機能は既に全てのAndroidユーザーに提供されており、iOSユーザーへも展開が開始されています。

Agent Mode:AIによるタスク自動化

AIモデルの知能とツールへのアクセスを組み合わせ、ユーザーに代わってタスクを実行する「エージェント」という概念。その初期の研究プロトタイプである「Project Mariner」は、ウェブを操作してユーザーのために作業を行うコンピュータ利用能力を持つエージェントとして開発が進められてきました。今回、このProject Marinerのコンピュータ利用能力が、「Agent Mode」としてGemini APIを通じて開発者に提供されることになりました。さらに、GeminiアプリにもAgent Modeが搭載され、例えばアパート探しのような複雑なタスクも、AIがウェブサイトを横断して条件に合う物件を探し、フィルタを調整し、内見の予約まで行うといったことが可能になります。このAgent Modeの実験的バージョンは、間もなくGeminiアプリの有料登録者向けに提供される予定です。

パーソナライゼーションによるAI体験の向上

AIを真に役立つものにするためには、個々のユーザーの状況やニーズに合わせたパーソナライゼーションが不可欠です。Googleは、「パーソナルコンテキスト」という概念を導入し、ユーザーの許可を得た上で、GeminiモデルがGoogleアプリ間の関連性の高い個人情報をプライバシーに配慮した形で活用できるように取り組んでいます。

その一例として、Gmailの新しい「パーソナライズドスマートリプライ」機能が紹介されました。例えば、過去に旅行した場所について友人からアドバイスを求められた場合、Geminiが過去のメールやGoogle Drive内の旅程表などを検索し、具体的な詳細情報を含む返信文案を提案してくれます。この際、ユーザーの典型的な挨拶や口調、スタイル、さらには好んで使う言葉遣いまで再現し、より自然で本人らしい返信を作成できるとしています。この機能は今年後半に有料登録者向けに提供される予定です。

AI ModeによるGoogle検索の進化

Google検索もGeminiモデルによって、よりインテリジェントで、エージェント的、そしてパーソナルなものへと進化しています。昨年導入された「AI Overview(AIによる概要表示)」は、既に15億人以上のユーザーに利用され、200の国と地域で展開されています。

そして今回、エンドツーエンドのAI検索体験を求めるユーザーのために、全く新しい「AI Mode」が発表されました。AI Modeでは、より高度な推論能力により、従来よりも長く複雑な質問を投げかけることができます。初期のテスターは、従来の検索の2〜3倍の長さのクエリを入力しており、さらに深掘りする質問も可能とのことです。このAI Modeは、米国のユーザーを対象に提供が開始され、今週からは最新のGemini 2.5モデルも搭載される予定です。

最先端AIモデル「Gemini 2.5」シリーズの強化

開発者からその速度と低コストで人気を博している「Gemini 2.5 Flash」は、推論、マルチモーダル、コーディング、長文脈処理といった主要なベンチマークで性能が向上し、LMArenaリーダーボードでは2.5 Proに次ぐ性能を達成しました。

さらに高性能な「Gemini 2.5 Pro」には、「Deep Think」と呼ばれる強化された推論モードが導入されます。これは、並列思考技術を含む最新の思考・推論研究を活用したもので、より複雑で深い分析が可能になることが期待されます。

Geminiアプリのパーソナル化と機能拡張

Geminiアプリも大幅なアップデートが行われます。「Deep Research」機能では、ユーザー自身のファイルをアップロードしたり、Google DriveやGmailに接続したりすることで、よりパーソナライズされたカスタムリサーチレポートの生成が可能になります。また、「Canvas」との連携により、ダイナミックなインフォグラフィックやクイズ、さらには多言語でのポッドキャストをワンクリックで作成できるようになります。Geminiとチャットするだけで機能的なアプリを構築できる「vibe coding」もCanvasで注目されているとのことです。

多くのユーザーに支持されている「Gemini Live」のカメラおよび画面共有機能は、iOSユーザーを含むすべての人に無料で提供され、まもなく主要なGoogleアプリと接続して、よりシームレスなアシスタンスを提供できるようになる予定です。

生成AIメディアモデルの新たな地平

クリエイティブな分野でもAIの進化は止まりません。Googleは、ネイティブな音声生成機能を備えた最新の動画生成モデル「Veo 3」と、最新かつ最も高性能な画像生成モデル「Imagen 4」を発表しました。これらはGeminiアプリで利用可能になり、新たな創造性の世界を切り開きます。

さらに、映画制作者向けには「Flow」という新しいツールが導入されます。これにより、映画のようなクリップを作成したり、短いクリップをより長いシーンに拡張したりすることが可能になります。

まとめ

Google I/O 2025で発表された内容は、AIが単なる研究対象から、私たちの生活や仕事を豊かにする実用的なツールへと進化していることを明確に示しています。Geminiを中心としたAIモデルの継続的な進化、それを支える強力なインフラ、そしてGoogle Beam、Agent Mode、AI Mode in Searchといった具体的な製品やサービスへの応用は、AIが社会のあらゆる側面に浸透していく未来を予感させます。特に、パーソナライゼーションとエージェント機能の強化は、AIが個々のユーザーにとってより価値の高い存在になるための重要なステップと言えるでしょう。

本稿で紹介した技術やサービスが、今後どのように私たちの日常を変えていくのか、引き続き注目していく必要があります。