はじめに

Google DeepMindは、軽量かつ高性能なオープンモデルファミリー「Gemma」の最新版である「Gemma 3」を発表しました。Gemma 3は、Googleの最先端モデル「Gemini 2.0」と同じ研究・技術に基づいて構築されており、単一のGPUやTPUでも高速に動作するように設計されています。本稿では、Gemma 3の技術的な詳細、新機能、そしてその可能性について、前提となる知識も補足しながら公式ブログ「Introducing Gemma 3: The most capable model you can run on a single GPU or TPU」をもとに詳しく解説します。

引用元

- タイトル:Introducing Gemma 3: The most capable model you can run on a single GPU or TPU

- URL:https://blog.google/technology/developers/gemma-3/

- 発行日:2025年3月12日

要点

- 高性能と軽量化の両立: Gemma 3は、1B、4B、12B、27Bという複数のサイズで提供され、特に27Bモデルは単一のGPU/TPUで動作可能なモデルとしては世界最高クラスの性能を達成しています(LMArenaのリーダーボードでLlama3-405Bなどを上回る評価)。

- マルチモーダル・多言語対応: テキストに加え、画像や短い動画の解析が可能になり、140以上の言語(うち35言語以上は標準サポート)に対応します。

- 大規模コンテキストウィンドウ: 128kトークンのコンテキストウィンドウに対応し、大量の情報を処理・理解できます。

- 開発者向け機能の強化: 関数呼び出し(Function Calling)や構造化出力に対応し、AIエージェント開発やタスク自動化が容易になりました。

- 量子化モデルの提供: 公式に量子化バージョンが提供され、モデルサイズと計算要件を削減しつつ、高い精度を維持します。

- 安全性への配慮: 厳格な安全性評価とテストを経て開発され、画像安全性チェックツール「ShieldGemma 2」も同時にリリースされました。

- エコシステムの拡大: Hugging Face、Ollama、PyTorch、JAX、Vertex AI、NVIDIA GPUなど、多様なツールやプラットフォームとの連携が可能です。

詳細解説

1. Gemma 3とは? – 軽量オープンモデルの進化

Gemmaは、Googleが開発・提供するオープンモデルのファミリーです。オープンモデルとは、モデルの重み(パラメータ)が公開されており、研究者や開発者が自由に利用、改変、再配布できるAIモデルのことを指します(商用利用等にはライセンス条件の確認が必要です)。これにより、AI技術の民主化とイノベーションの加速が期待されます。

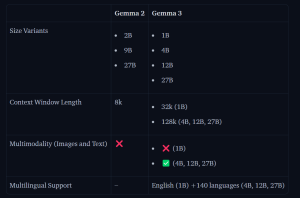

Gemma 3は、このGemmaファミリーの最新世代であり、Gemini 2.0モデル群と同じ基盤技術を用いて開発されました。特筆すべきは、その「軽量性」と「高性能」の両立です。AIモデルは一般的に、パラメータ数が多いほど高性能になる傾向がありますが、同時に計算コスト(必要なGPUメモリや計算時間)も増大します。Gemma 3は、1Bから27Bまでの幅広いパラメータサイズのモデルを提供することで、開発者が利用するハードウェア(スマートフォン、ラップトップ、ワークステーション等)や要求性能に応じて最適なモデルを選択できるようにしています。

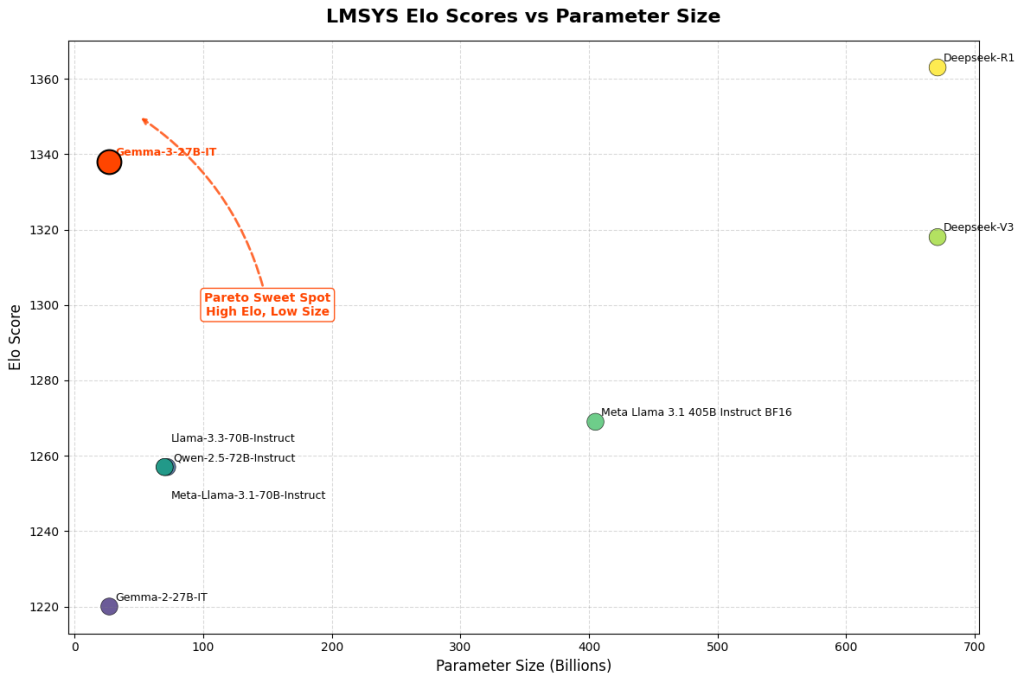

特にGemma 3 27Bモデルは、LMArenaの人間による評価において、より大規模なモデルであるLlama3-405BやDeepSeek-V3などを上回る性能を示しつつ、単一のNVIDIA H100 GPUまたはGoogle TPUホストで動作可能である点が画期的です。これにより、高性能なAIアプリケーションを、よりアクセスしやすいハードウェア環境で開発・実行できるようになります。

2. 技術的な進化点

- マルチモーダル機能: Gemma 3はテキストだけでなく、画像や短い動画の内容を理解する能力を持ちます。これにより、画像キャプション生成、画像ベースの質問応答、動画要約など、より多様なAIアプリケーションの開発が可能になります。

- 多言語対応の強化: 事前学習段階で140以上の言語に対応し、そのうち35以上の言語についてはファインチューニング等により標準で高い性能を発揮します。これにより、グローバルなユーザーに対応するアプリケーション開発が容易になります。

- 128kトークンのコンテキストウィンドウ: コンテキストウィンドウとは、モデルが一度に処理できる入力情報の長さ(トークン数)を指します。Gemma 3の128kトークンというコンテキストウィンドウは、非常に長い文書の読解、複数文書にまたがる情報の抽出、長時間の対話履歴の維持などを可能にし、より複雑なタスクへの対応能力を高めます。

- 関数呼び出し (Function Calling) と構造化出力: 関数呼び出しは、モデルが外部のAPIやツールを呼び出すことを可能にする機能です。例えば、「今日の東京の天気は?」という質問に対し、モデルが天気情報APIを呼び出して最新情報を取得し、回答を生成するといった連携が可能になります。構造化出力と組み合わせることで、特定のフォーマット(JSONなど)で情報を整理して出力させることができ、AIエージェントの開発や既存システムとの連携を大幅に効率化します。

- 量子化モデル: 量子化とは、モデルのパラメータ(通常は32ビット浮動小数点数)をより少ないビット数(例: 8ビット整数)で表現する技術です。これにより、モデルのファイルサイズとメモリ使用量を大幅に削減し、推論速度を向上させることができます。Gemma 3では公式に量子化バージョンが提供されており、精度への影響を最小限に抑えつつ、リソース制約のある環境(モバイルデバイスなど)での実行を容易にします。

性能評価

Gemma 3は、様々なベンチマークで高い性能を示しています。

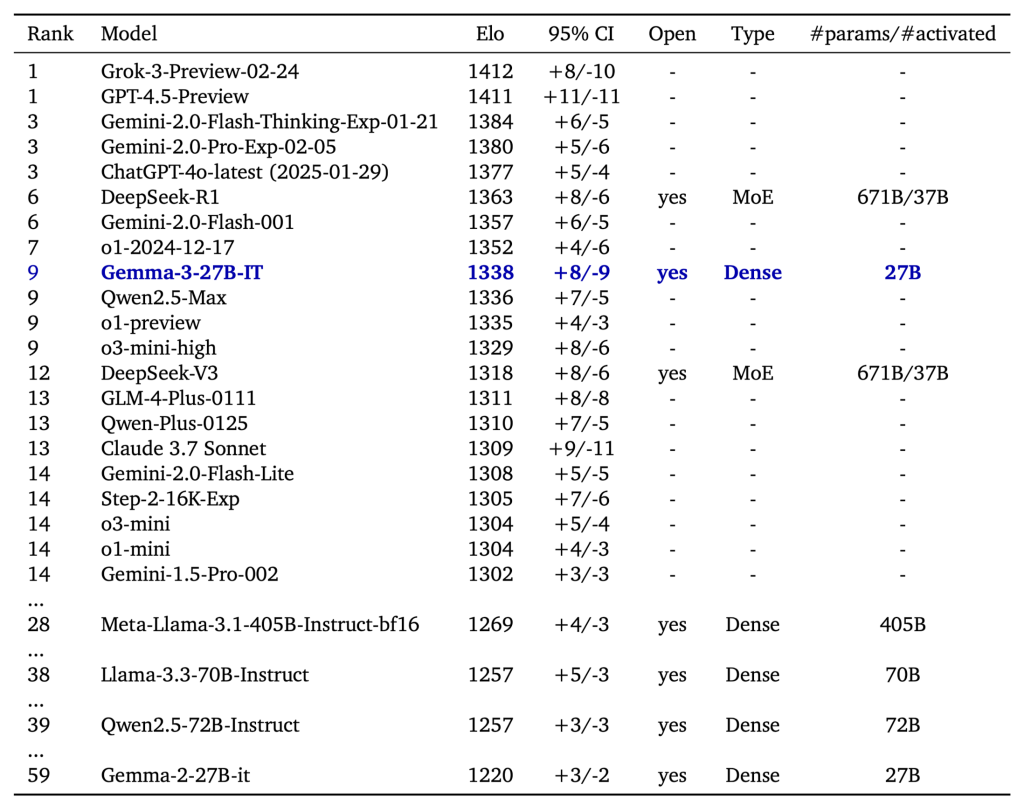

LMSys Chatbot Arena: 人間の評価に基づくランキングでは、Gemma 3 27B ITはEloスコア1339を記録し、主要なクローズドモデルを含むトップ10にランクインしています(2025年3月8日時点)。これは他の「思考プロセス(Chain-of-Thoughtなど)を用いない」オープンモデルを上回るスコアです。

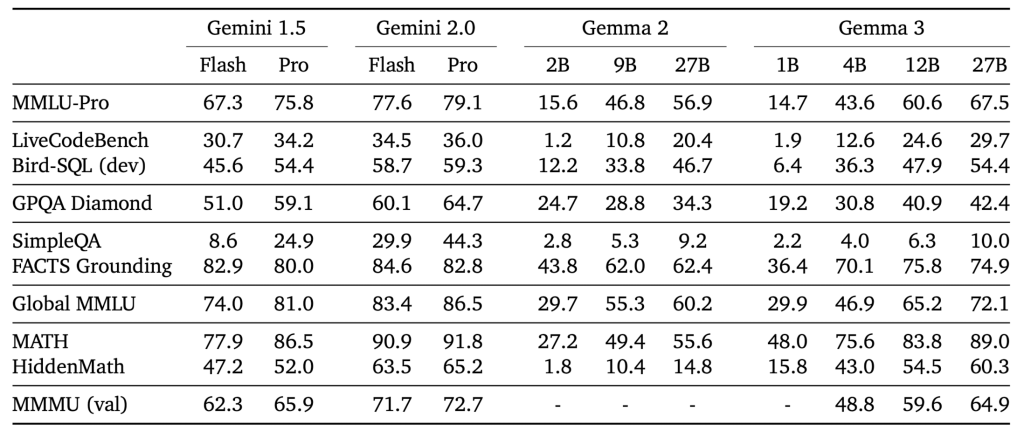

モデル間の比較: 命令チューニング版(IT)において、Gemma-3-4B-ITは前世代のGemma-2-27B-ITを上回る性能を達成しました。さらに、Gemma-3-27B-ITは、クローズドモデルであるGemini 1.5 Proと比較しても、多くのベンチマークで匹敵、あるいはそれを上回る性能を示しており、オープンモデルとして非常に高い競争力を持っています。

主要ベンチマーク結果:

- 推論・数学: MATHベンチマーク(4-shot)で27B PTモデルが50.0、GSM8K(8-shot)で82.6を記録するなど、高い数学的能力を示しています。より複雑な推論能力を測るGPQA Diamond(27B IT)では42.4を達成しています。

- 事実精度・知識: TriviaQA(5-shot)で27B PTモデルが85.5、Natural Questions(5-shot)で36.1を記録。また、FACTS Grounding(27B IT)では74.9と、高い事実精度を示しています。

- マルチモーダル: MMMU(Multimodal Massive Understanding)ベンチマークで27B ITモデルが64.9、DocVQA(val)で27B PTモデルが85.6、VQAv2で72.9を記録するなど、画像とテキストを組み合わせた理解能力も優れています。

- 多言語: MGSM(Multilingual Grade School Math)で27B PTモデルが74.3、FloRes(翻訳)で48.8、XQuAD(多言語質問応答)で76.8を記録し、幅広い言語での対応能力を示しています。

- コーディング: HumanEval(0-shot)で27B PTモデルが48.8、MBPP(3-shot)で65.6を記録しています。

これらの結果は、Gemma 3が多様なタスクにおいて高い性能を発揮することを示しています。特に、比較的小さなモデル(4B)でも前世代の大きなモデルを凌駕する性能を持つ点や、最大の27Bモデルが最先端のクローズドモデルに迫る性能を持つ点は注目に値します。詳細なベンチマークスコアは、モデルカードやテクニカルレポートで確認できます。

3. 安全性への取り組みとShieldGemma 2

Googleは、オープンモデルのリスク評価と安全性の確保を重視しています。Gemma 3の開発においては、広範なデータガバナンス、安全ポリシーに沿ったファインチューニング、堅牢なベンチマーク評価が実施されました。特に、Gemma 3のSTEM(科学・技術・工学・数学)分野における性能向上を考慮し、有害物質生成などの悪用可能性について特定の評価が行われ、そのリスクは低いレベルであると結論付けられています。

さらに、Gemma 3と同時に「ShieldGemma 2」がリリースされました。これはGemma 3 4Bモデルを基盤とした画像安全性チェックツールであり、「危険なコンテンツ」「性的に露骨なコンテンツ」「暴力的なコンテンツ」の3つのカテゴリで安全ラベルを出力します。開発者はこれをカスタマイズして、自身のアプリケーションにおける画像コンテンツの安全性を確保するために利用できます。

4. 開発エコシステムとツール連携

Gemma 3は、既存の開発ワークフローにシームレスに統合できるよう、幅広いツールやプラットフォームに対応しています。

- 主要フレームワーク: Hugging Face Transformers、Ollama、JAX、Keras、PyTorch

- 推論・実行環境: Google AI Edge、UnSloth、vLLM、Gemma.cpp (CPU実行用)

- 開発・実験プラットフォーム: Google AI Studio、Kaggle、Google Colab

- デプロイ・スケーリング: Vertex AI、Cloud Run (Ollama経由)、Google GenAI API

- ハードウェア最適化: NVIDIA GPU (Jetson NanoからBlackwellまで最適化、NVIDIA API Catalogで提供)、Google Cloud TPU、AMD GPU (ROCm™スタック経由)

これらの豊富な選択肢により、開発者は使い慣れたツールや最適なプラットフォームを選択して、Gemma 3の実験、ファインチューニング、デプロイを効率的に行うことができます。

まとめ

本稿では、Googleの最新軽量オープンモデル「Gemma 3」について、その技術的な特徴、安全性への取り組み、開発エコシステムを中心に解説しました。Gemma 3は、単一のGPU/TPUで動作可能なサイズでありながら、最先端の性能、マルチモーダル・多言語対応、大規模コンテキストウィンドウ、関数呼び出しといった高度な機能を提供します。量子化モデルやShieldGemma 2の提供、幅広いツール連携により、AIエンジニアはより少ないリソースで、より多様なAIアプリケーションを、より安全に開発することが可能になります。Gemma 3とそのエコシステム「Gemmaverse」の今後の発展に注目です。